揭秘YOLO数据集加载的陷阱:常见问题及解决方案

发布时间: 2024-08-16 06:22:55 阅读量: 113 订阅数: 22

yolo数据集8:1:1分类

# 1. YOLO数据集简介

YOLO(You Only Look Once)数据集是专为目标检测任务设计的图像数据集。它包含大量带注释的图像,其中每个图像都包含一个或多个目标对象。YOLO数据集的独特之处在于其速度和准确性,使其成为训练和评估目标检测模型的理想选择。

YOLO数据集由多个版本组成,每个版本都包含不同数量的图像和注释。最流行的版本是YOLOv3和YOLOv4,它们分别包含80个和80个以上的目标类别。YOLO数据集中的图像通常是高分辨率的,并且以JPEG或PNG格式存储。每个图像都包含一个相应的XML文件,其中包含目标对象的边界框和类别标签。

# 2. YOLO数据集加载理论基础

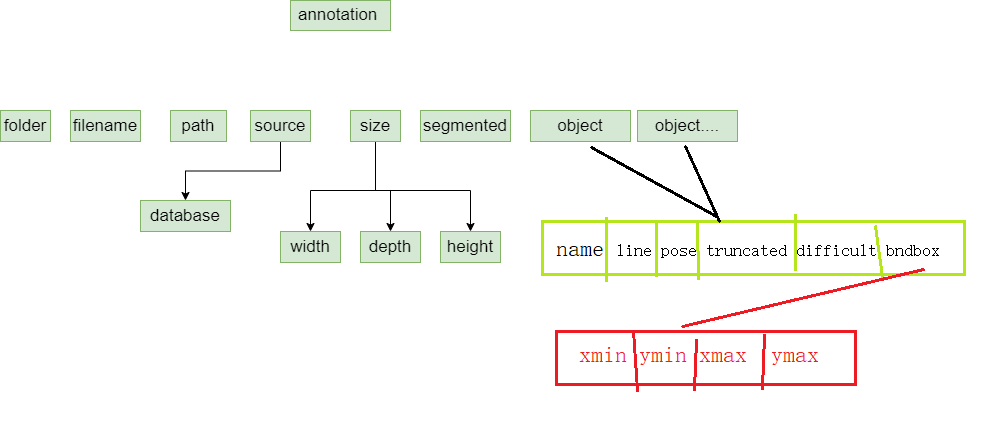

### 2.1 YOLO数据集的结构和格式

YOLO数据集通常采用PASCAL VOC格式,该格式包含以下信息:

- **图像文件:**JPEG或PNG格式的图像文件,存储训练和测试图像。

- **标注文件:**XML格式的文件,存储每个图像中目标的边界框和类别信息。

**XML标注文件示例:**

```xml

<annotation>

<folder>VOC2007</folder>

<filename>000001.jpg</filename>

<source>

<database>The VOC2007 Database</database>

<annotation>PASCAL VOC2007</annotation>

<image>flickr</image>

<flickrid>322409915</flickrid>

</source>

<owner>

<flickrid>null</flickrid>

<name>null</name>

</owner>

<size>

<width>500</width>

<height>375</height>

<depth>3</depth>

</size>

<segmented>0</segmented>

<object>

<name>dog</name>

<pose>Unspecified</pose>

<truncated>0</truncated>

<difficult>0</difficult>

<bndbox>

<xmin>188</xmin>

<ymin>183</ymin>

<xmax>363</xmax>

<ymax>368</ymax>

</bndbox>

</object>

</annotation>

```

### 2.2 数据集加载的原理和流程

数据集加载涉及以下步骤:

1. **读取图像文件:**使用图像处理库(如OpenCV)读取图像文件并将其转换为Numpy数组。

2. **解析标注文件:**使用XML解析库(如xmltodict)解析XML标注文件并提取边界框和类别信息。

3. **数据预处理:**对图像和标注进行预处理,如调整大小、归一化、增强等。

4. **数据加载:**将预处理后的数据加载到内存或磁盘中,以便训练和评估模型。

**数据集加载流程图:**

```mermaid

graph LR

subgraph 数据集加载

A[读取图像文件] --> B[解析标注文件] --> C[数据预处理] --> D[数据加载]

end

```

**代码示例:**

```python

import cv2

import xmltodict

def load_yolo_dataset(image_dir, annotation_dir):

"""加载YOLO数据集

Args:

image_dir (str): 图像目录

annotation_dir (str): 标注目录

Returns:

list: 图像和标注列表

"""

images = []

annotations = []

for image_file in os.listdir(image_dir):

image = cv2.imread(os.path.join(image_dir, image_file))

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

images.append(image)

for annotation_file in os.listdir(annotation_dir):

with open(os.path.join(annotation_dir, annotation_file), "r") as f:

annotation = xmltodict.parse(f.read())

annotations.append(annotation)

return images, annotations

```

# 3. YOLO数据集加载实践技巧

### 3.1 数据集预处理和增强

#### 数据集预处理

数据集预处理是加载数据集之前的重要步骤,它可以提高模型的训练效果和效率。常见的预处理操作包括:

- **数据清洗:**删除损坏或不完整的数据,以及异常值。

- **数据归一化:**将数据值缩放到特定范围内,例如 [0, 1] 或 [-1, 1]。

- **数据标准化:**将数据值减去其均值并除以其标准差,使数据分布更接近正态分布。

#### 数据增强

数据增强是一种通过对原始数据进行变换来创建新数据样本的技术,它可以增加数据集的规模和多样性,从而提高模型的泛化能力。常见的增强操作包括:

- **翻转:**水平或垂直翻转图像。

- **旋转:**以一定角度旋转图像。

- **裁剪:**从图像中随机裁剪出不同大小和宽高比的区域。

- **颜色抖动:**随机改变图像的亮度、对比度和饱和度。

### 3.2 数据集加载的优化和加速

#### 多线程加载

多线程加载可以充分利用多核 CPU 的优势,并行加载数据。在 Python 中,可以使用 `multiprocessing` 模块创建多个进程来加载数据。

#### 内存映射

内存映射是一种将文件映射到内存中的技术,它允许直接访问文件内容,而无需每次读取数据时都从磁盘中读取。在 Python 中,可以使用 `mmap` 模块进行内存映射。

#### 预取加载

预取加载是一种预先将数据加载到内存中的技术,它可以减少后续加载数据的延迟。在 Python 中,可以使用 `numpy.load` 函数进行预取加载。

#### 代码示例:

```python

import multiprocessing

import numpy as np

import mmap

# 多线程加载

def load_data(filename):

with open(filename, "rb") as f:

data = f.read()

return data

def main():

filenames = ["file1.txt", "file2.txt", "file3.txt"]

pool = multiprocessing.Pool(processes=4)

data = pool.map(load_data, filenames)

# 内存映射

with open("file.txt", "rb") as f:

data = mmap.mmap(f.fileno(), 0, access=mmap.ACCESS_READ)

# 预取加载

data = np.load("file.npy")

```

### 逻辑分析:

- **多线程加载:**使用 `multiprocessing` 模块创建多个进程,并行加载数据。

- **内存映射:**使用 `mmap` 模块将文件映射到内存中,直接访问文件内容。

- **预取加载:**使用 `numpy.load` 函数将数据预先加载到内存中。

# 4. YOLO 数据集加载常见问题及解决方案

### 4.1 数据集加载失败或不完整

#### 问题描述

在加载 YOLO 数据集时,可能会遇到数据集加载失败或不完整的问题。这可能是由于以下原因造成的:

- **文件损坏或不完整:**数据集文件在下载或传输过程中可能损坏或不完整。

- **文件路径错误:**加载脚本中指定的 YOLO 数据集文件路径不正确。

- **文件格式不兼容:**YOLO 数据集文件格式与加载脚本不兼容。

- **内存不足:**加载数据集所需的内存不足,导致加载过程失败。

#### 解决方案

- **检查文件完整性:**重新下载或传输 YOLO 数据集文件,确保其完整无损。

- **验证文件路径:**仔细检查加载脚本中指定的数据集文件路径,确保其准确无误。

- **检查文件格式:**确认 YOLO 数据集文件格式与加载脚本兼容。

- **增加内存:**如果内存不足,可以增加计算机的可用内存或使用更小的数据集。

### 4.2 数据集加载速度慢或内存占用高

#### 问题描述

加载 YOLO 数据集时,可能会遇到数据集加载速度慢或内存占用高的现象。这可能是由于以下原因造成的:

- **数据集过大:**YOLO 数据集包含大量图像和标注,加载大型数据集会耗费大量时间和内存。

- **加载过程低效:**加载脚本中使用的加载算法效率低下,导致加载速度慢。

- **内存管理不当:**加载脚本中没有正确管理内存,导致内存占用高。

#### 解决方案

- **使用较小数据集:**如果可能,使用较小的 YOLO 数据集,以减少加载时间和内存占用。

- **优化加载算法:**使用高效的加载算法,例如多线程加载或并行加载。

- **优化内存管理:**使用内存管理技术,例如缓存和内存池,以减少内存占用。

### 代码示例

以下代码示例展示了如何使用多线程加载 YOLO 数据集,以提高加载速度:

```python

import threading

import cv2

class YOLODatasetLoader(threading.Thread):

def __init__(self, dataset_path, batch_size):

super().__init__()

self.dataset_path = dataset_path

self.batch_size = batch_size

self.images = []

self.labels = []

def run(self):

with open(self.dataset_path, 'r') as f:

for line in f:

image_path, label_path = line.strip().split(' ')

image = cv2.imread(image_path)

label = cv2.imread(label_path)

self.images.append(image)

self.labels.append(label)

while True:

batch_images = []

batch_labels = []

for i in range(self.batch_size):

index = np.random.randint(len(self.images))

batch_images.append(self.images[index])

batch_labels.append(self.labels[index])

yield batch_images, batch_labels

# 创建多线程加载器

num_threads = 4

loaders = [YOLODatasetLoader(dataset_path, batch_size) for i in range(num_threads)]

# 启动加载器

for loader in loaders:

loader.start()

# 从加载器中获取批次数据

for batch_images, batch_labels in zip(*loaders):

# 处理批次数据

pass

```

### 参数说明

- `dataset_path`:YOLO 数据集文件路径。

- `batch_size`:每个批次加载的图像数量。

- `images`:加载的图像列表。

- `labels`:加载的标注列表。

- `num_threads`:加载器线程数量。

### 代码逻辑分析

该代码使用多线程加载 YOLO 数据集,以提高加载速度。它创建了多个加载器线程,每个线程负责加载一部分数据集。加载器线程从数据集文件中读取图像和标注,并将其存储在 `images` 和 `labels` 列表中。

主线程从加载器线程中获取批次数据,并对批次数据进行处理。这种多线程加载方式可以并行加载数据集,从而提高加载速度。

# 5. YOLO数据集加载的最佳实践和注意事项

### 5.1 数据集加载的性能评估

为了评估数据集加载的性能,可以考虑以下指标:

- **加载时间:**从开始加载到数据集完全加载到内存中所需的时间。

- **内存占用:**数据集加载后占用的内存量。

- **吞吐量:**每秒加载的数据量。

### 5.2 数据集加载的最佳实践和注意事项

为了优化数据集加载的性能,并避免常见问题,请遵循以下最佳实践和注意事项:

- **使用高效的数据加载器:**选择专为快速和高效的数据加载而设计的库或框架。

- **预处理和增强数据:**在加载数据之前,预处理和增强数据可以提高模型的性能。这可能包括调整图像大小、归一化像素值或应用数据增强技术。

- **并行加载:**如果可能,并行加载数据以提高吞吐量。这可以通过使用多线程或多进程来实现。

- **缓存数据:**如果数据集频繁加载,请考虑将其缓存到内存中以提高后续加载的速度。

- **使用内存映射:**内存映射允许直接访问文件中的数据,而无需将其加载到内存中。这可以减少内存占用并提高加载速度。

- **监视加载性能:**定期监视数据集加载的性能以识别瓶颈并进行优化。

- **避免加载不必要的数据:**仅加载模型训练或推理所需的必要数据。

- **使用适当的数据类型:**选择适当的数据类型以优化内存占用和处理速度。

0

0