【自动化数据清洗】:OpenRefine脚本化处理一步到位

发布时间: 2025-01-10 03:39:59 阅读量: 28 订阅数: 26

# 摘要

自动化数据清洗是提升数据质量、保障数据分析准确性的重要环节。本文首先介绍了自动化数据清洗的概念及其在数据处理中的重要性,继而阐述了数据清洗的基本理论基础和常见方法。通过OpenRefine工具的实际应用,文章展示了自动化数据清洗的操作流程和策略,并深入探讨了脚本化处理技巧。最后,结合案例分析,本文对自动化数据清洗的未来趋势进行了展望,着重讨论了AI技术在其中的应用和数据清洗工具的发展方向。

# 关键字

自动化数据清洗;数据质量;OpenRefine;异常值检测;数据迭代;AI技术应用

参考资源链接:[OpenRefine中文教程:数据清洗与管理](https://wenku.csdn.net/doc/6t2abx98d3?spm=1055.2635.3001.10343)

# 1. 自动化数据清洗简介与OpenRefine概述

在当今数字化时代,数据已经成为了企业和研究机构最为重要的资产之一。然而,这些数据中包含了许多噪声和不一致性,这直接影响了数据的质量和可分析性。为了确保数据分析、挖掘和模型构建的有效性,数据清洗成为了数据预处理的一个关键步骤。自动化数据清洗可以大幅提高工作效率,确保清洗结果的准确性和一致性,从而提升整体的数据质量。

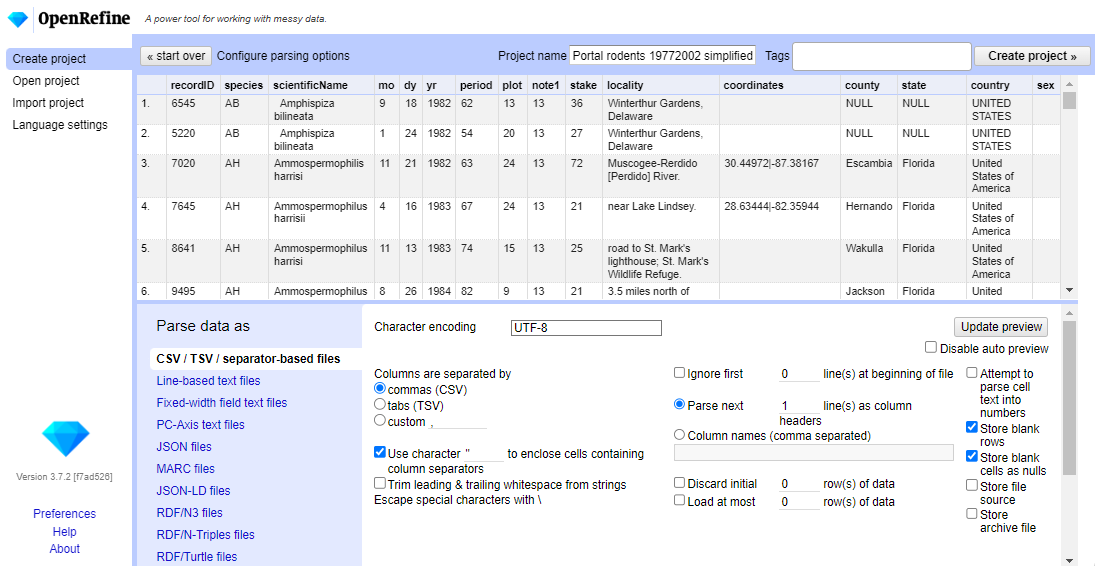

OpenRefine是一款强大的开源数据清洗工具,它为数据分析师和数据科学家提供了一个平台,用以处理大型数据集,进行数据清洗、转换和数据整合等操作。OpenRefine之所以受到广大使用者的青睐,是因为它简单易用,且无需编程知识即可快速上手,同时拥有强大的数据处理能力,特别是在处理非结构化和半结构化数据方面表现出色。

接下来的章节将深入探讨数据清洗的理论基础,以及OpenRefine的具体操作与应用实践。通过对自动化数据清洗的介绍和学习,读者将掌握一系列实用技能,并能够将这些技能应用于实际工作中,提高数据处理的效率和质量。

# 2. 数据清洗的理论基础

在数据科学领域,数据清洗是确保数据分析质量和准确性的关键步骤。数据清洗的理论基础,为我们提供了处理数据污染和错误的方法论支持。它包括理解数据清洗的重要性,掌握基本的数据清洗方法,并制定出一套完整的清洗流程与策略。

## 2.1 数据清洗的重要性

### 2.1.1 数据质量与数据价值

数据质量直接关联到企业或研究中的数据价值。高质量的数据能够提高决策的准确性,增强数据驱动型应用的有效性,从而提高业务收益或研究发现的准确性。数据清洗能够帮助我们提升数据质量,其重要性体现在以下几个方面:

- **减少错误**:通过清洗数据,可以识别并修正数据录入错误、格式不一致等问题,从而提高数据的准确性。

- **避免误导**:准确的数据能够避免在分析过程中出现的误导性结论。

- **提升效率**:清洗后的数据能加快分析过程,因为无需花费时间在错误或无用的数据上。

- **降低成本**:减少后续处理阶段的数据修正工作,从而降低总体的数据处理成本。

### 2.1.2 数据清洗在数据分析中的作用

数据清洗在数据分析中扮演着至关重要的角色。在数据分析的生命周期中,数据清洗通常位于初始阶段,是后续分析工作的基础。以下是数据清洗在数据分析中作用的详细说明:

- **数据整合**:在清洗过程中,通常需要整合来自不同来源的数据。清洗帮助我们统一数据格式,确保信息的完整性。

- **探索性分析**:清洗后的数据能够更准确地反映数据集的特征,辅助于探索性分析,揭示数据背后的故事。

- **提高模型准确性**:在数据建模或机器学习过程中,数据清洗保证了输入数据的质量,从而提高了模型的预测能力和准确性。

## 2.2 数据清洗的基本方法

### 2.2.1 缺失值处理

在实际数据集中,缺失值是一种常见的数据污染形式。缺失值处理的方法有多种,主要包括:

- **删除含有缺失值的记录**:当缺失数据的比例较低时,可以考虑删除这些记录。但是,如果缺失值并非随机分布,那么这种做法可能会导致信息的丢失。

- **填充缺失值**:可以使用平均值、中位数或众数等统计方法来填充缺失值,或者根据已有数据的模式进行估算。高级方法如使用模型预测缺失值也是一种选择。

### 2.2.2 异常值检测与处理

异常值是指那些与数据集中的其他观测值显著不同的数据点。处理异常值的方法可以概括为:

- **统计检验**:使用统计方法如Z分数、IQR等来识别异常值。

- **可视化**:借助箱线图等可视化工具来直观地检测和分析异常值。

- **处理方法**:根据异常值的性质和数据集的需求,可以选择忽略、修正或删除异常值。

### 2.2.3 重复数据的识别与处理

重复数据的出现会干扰数据分析的准确性。识别和处理重复数据的方法有:

- **基于唯一标识符的检测**:通过比较数据的唯一标识符来识别重复记录。

- **基于内容的检测**:使用某些算法如自定义相似度度量方法来检测内容上的重复。

- **删除策略**:一旦发现重复数据,可以采取删除多余副本的策略来清洗数据集。

## 2.3 数据清洗流程与策略

### 2.3.1 清洗前的准备工作

在进行数据清洗前,进行适当的准备工作是必不可少的。准备工作包括:

- **理解数据**:深入理解数据集中的每个字段,包括数据类型、含义、可能的取值等。

- **明确清洗目标**:根据业务需求或研究目标,设定明确的数据清洗目标。

- **备份数据**:在处理数据之前,备份原始数据,以避免不可逆的错误。

### 2.3.2 数据清洗流程图解

数据清洗流程可以按照以下步骤进行:

1. **识别问题**:通过初步的数据分析,识别数据问题,如缺失值、异常值、重复数据等。

2. **清洗准备**:根据识别的问题,准备数据清洗的策略和工具。

3. **执行清洗**:应用策略和工具,逐项处理数据问题。

4. **验证结果**:清洗完成后,重新检验数据,确保问题已被妥善处理。

5. **维护更新**:随着业务或研究的进展,持续更新清洗策略和过程。

### 2.3.3 实施策略与案例分析

为了有效地实施数据清洗策略,以下案例分析提供了实际操作的参考:

- **案例**:一家零售企业准备进行销售分析。在数据清洗过程中,他们发现销售额字段中存在许多缺失值,同时重复的销售记录也会影响分析结果。

- **策略**:对于缺失值,选择填充平均销售额来处理;对于重复数据,则使用了一个基于业务规则的算法进行识别,并通过程序自动删除重复项。

- **结果**:清洗后的数据集更加准确,为销售分析提供了坚实的基础。

通过实际案例,我们能够更好地理解数据清洗的理论应用,并在现实情况中灵活运用。接下来,我们将深入探讨OpenRefine在数据清洗中的应用。

# 3. OpenRefine操作与应用实践

## 3.1 OpenRefine界

0

0