【数据一致性解决高手】:OpenRefine规范化功能深度应用

发布时间: 2025-01-10 03:36:50 阅读量: 5 订阅数: 5

深入解析数据库规范化:提升效率与数据一致性的关键

# 摘要

数据清洗是数据预处理的重要环节,对于提高数据质量、确保分析结果的准确性至关重要。OpenRefine作为一种强大的数据清洗工具,其数据规范化功能能够有效解决数据不一致问题,提升数据处理效率。本文首先介绍了数据清洗的重要性和OpenRefine的基本概念,随后深入探讨了数据一致性的定义、表现及其影响,并详细解析了OpenRefine的架构、界面布局及规范化功能的工作逻辑。在实践操作部分,文章提供了针对字符串和数据结构规范化的具体操作方法,并讨论了数据集整合与去重的技术。此外,本文还探讨了高级规范化技术和案例分析,以及OpenRefine未来发展的趋势和数据一致性面临的挑战。

# 关键字

数据清洗;OpenRefine;数据规范化;数据一致性;自定义脚本;性能优化

参考资源链接:[OpenRefine中文教程:数据清洗与管理](https://wenku.csdn.net/doc/6t2abx98d3?spm=1055.2635.3001.10343)

# 1. 数据清洗的重要性与OpenRefine简介

在数据处理领域,数据清洗是将原始数据转化为准确、一致且可用形式的过程,它占据了数据分析工作的重要部分。高质量的数据清洗工作能够提升数据的准确性和可靠性,进一步增强后续数据分析的深度和广度。

OpenRefine,原名Google Refine,是一款功能强大的开源数据清洗工具,适用于处理不规范的数据集。其特色在于数据的规范化、数据集的整合以及数据转换等方面。

本章将首先概述数据清洗的重要性,并简要介绍OpenRefine的由来以及核心功能。这将为读者提供一个基础框架,以便更深入地理解数据清洗的必要性和OpenRefine在其中扮演的角色。

在下一章中,我们将探讨数据规范化的重要性,并详细介绍OpenRefine的规范化功能,以及如何通过这些功能实现数据的一致性。

# 2. OpenRefine的数据规范化功能理论

## 2.1 数据一致性的概念

### 2.1.1 数据一致性的定义和重要性

数据一致性是指在同一个数据集中,相同的概念或者实体在不同时间、地点、上下文中保持相同的表示方式。简而言之,就是数据的统一性。数据一致性的保持,对于数据分析的准确性、决策的有效性具有决定性作用。数据不一致会带来许多问题,例如数据冗余、数据冲突和数据缺失,这些问题可能在数据分析和决策过程中引入错误,降低数据的可靠性。尤其是在大数据背景下,数据不一致问题可能会被放大,给数据处理和分析带来更大的挑战。

### 2.1.2 数据不一致的常见表现与影响

数据不一致有多种表现形式,比如拼写错误、缩写不统一、不同的数据类型和格式(日期、货币等)、编码问题,以及不一致的单位和度量。这些不一致问题影响数据整合、数据报告的准确性以及数据挖掘模型的性能。例如,不同的日期格式(“YYYY-MM-DD”和“MM/DD/YYYY”)可能导致数据分析时的数据丢失。不一致的数据单位(如“厘米”和“英寸”)可导致用户获得错误的统计结果。因此,保持数据一致性对于保证数据分析质量至关重要。

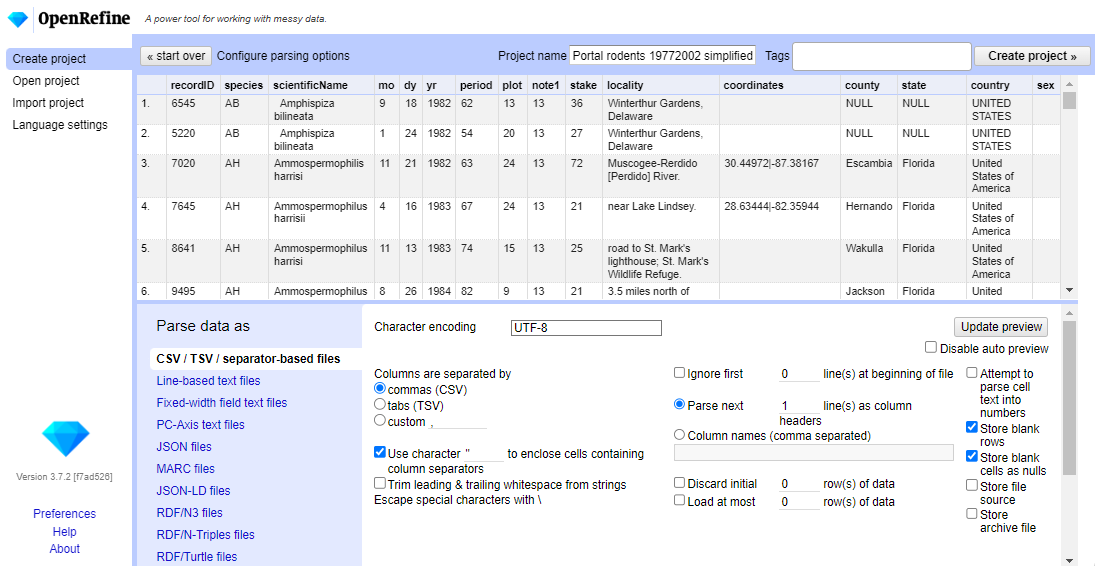

## 2.2 OpenRefine的架构和界面布局

### 2.2.1 OpenRefine的基本架构

OpenRefine是一个开源的数据清洗工具,最初名为Google Refine。它被设计为一个用于处理非结构化数据的独立应用程序。OpenRefine的架构包括前端和后端两部分。前端主要负责用户交互,例如操作界面、数据展示以及导出数据等。后端则专注于数据处理、数据解析和数据清洗逻辑。

OpenRefine采用Web技术构建,用户通过浏览器进行操作,但数据处理在本地执行,不依赖外部服务器。这样的架构设计不仅便于用户访问,而且保证了数据处理的私密性和安全性。OpenRefine通过插件系统支持扩展,用户可以根据需要进行定制开发,增强其功能。

### 2.2.2 用户界面的主要组件

OpenRefine的用户界面直观明了,易于上手。界面主要由以下部分组成:

- **项目面板**:显示当前工作空间中的所有项目,每个项目对应一个数据集。

- **数据表视图**:显示数据集的表格视图,支持各种数据操作和转换。

- **列菜单和操作栏**:对选定列进行操作,如重命名、分割、合并等。

- **数据类型按钮**:显示当前数据列的数据类型,如文本、数字、日期等。

- **工具栏**:提供撤销、重做、数据排序等快捷操作。

这些组件的设计让OpenRefine用户可以快速地识别数据问题,并进行相应的清洗操作。

## 2.3 规范化功能的逻辑和工作原理

### 2.3.1 规范化的定义和目标

规范化,是指将数据标准化的过程,目的是消除数据中的不一致性和冗余,确保数据在系统内各部分之间保持准确和一致。通过规范化,可以改善数据质量,为数据分析和报告提供可靠的基础。规范化操作通常包括统一日期格式、标准化地址、格式化电话号码等。

规范化的目标在于:

1. 提高数据的准确性

2. 简化数据整合过程

3. 增强数据的可用性

4. 提升数据分析的效率和可靠性

### 2.3.2 OpenRefine中规范化的工作流程

在OpenRefine中,规范化数据通常遵循以下工作流程:

1. **识别问题**:首先需要识别数据中的不一致性和重复信息,这可能需要对数据集进行初步的分析和检查。

2. **数据预处理**:使用OpenRefine提供的各种工具,如字符串处理、数值转换、时间解析等进行预处理。

3. **应用规范化操作**:利用“变换”功能对数据进行格式化,使用“拆分”和“合并”等操作来整合数据。

4. **建立规范化规则**:创建和应用自定义脚本(例如使用GREL语言),以实现更复杂的规范化需求。

5. **验证和测试**:检查规范化后的数据是否符合预期,使用过滤器和统

0

0