强化学习中的注意力机制:赋能智能体决策制定的关键

发布时间: 2024-08-20 23:22:04 阅读量: 70 订阅数: 46

大型语言模型赋能Minecraft自适应终身学习智能体VOYAGER研究与应用

# 1. 强化学习中的注意力机制概述**

注意力机制是一种神经网络技术,它允许模型选择性地关注输入数据的特定部分。在强化学习中,注意力机制已被用于提高算法的性能,使其能够更有效地学习和决策。

注意力机制通过计算注意力权重来工作,这些权重表示模型对输入不同部分的相对重要性。然后,这些权重用于加权输入,从而创建更具信息性的表示。这种表示可以用来改进强化学习算法的决策,例如通过更准确地预测奖励或选择更有效的动作。

# 2. 注意力机制的理论基础**

## 2.1 注意力机制的定义和分类

**定义:**

注意力机制是一种机器学习技术,它允许模型专注于输入数据的特定部分,从而提高模型的性能。在强化学习中,注意力机制使代理能够选择性地关注环境中的相关信息,从而做出更好的决策。

**分类:**

注意力机制可分为两大类:

- **软注意力:**使用可微分函数计算注意力权重,允许模型学习注意力分布。

- **硬注意力:**使用离散的注意力权重,通常通过argmax操作选择最相关的输入。

## 2.2 注意力机制的数学原理

### 2.2.1 注意力函数

注意力函数是计算注意力权重的函数。它通常采用以下形式:

```python

f(x, q) = exp(x^T * q) / Σ_i exp(x_i^T * q)

```

其中:

- x 是输入特征向量

- q 是查询向量(通常是模型的隐藏状态)

### 2.2.2 注意力权重

注意力权重是注意力函数的输出,它表示每个输入特征的重要性。这些权重用于加权输入特征,从而创建注意力加权表示:

```python

c = Σ_i w_i * x_i

```

其中:

- w_i 是第 i 个输入特征的注意力权重

- x_i 是第 i 个输入特征

- c 是注意力加权表示

**代码示例:**

```python

import torch

# 输入特征向量

x = torch.randn(10, 100)

# 查询向量

q = torch.randn(100)

# 注意力函数

attn_func = torch.nn.Softmax(dim=-1)

# 计算注意力权重

attn_weights = attn_func(x @ q)

# 计算注意力加权表示

attn_weighted_x = attn_weights @ x

```

**逻辑分析:**

这段代码演示了如何使用软注意力函数计算注意力权重和注意力加权表示。它首先计算输入特征向量和查询向量的点积,然后使用softmax函数计算注意力权重。最后,它使用注意力权重加权输入特征向量,得到注意力加权表示。

# 3. 注意力机制在强化学习中的应用

### 3.1 基于注意力的强化学习算法

注意力机制在强化学习中发挥着至关重要的作用,它使算法能够专注于环境中的相关信息,从而提高决策质量。基于注意力的强化学习算法主要分为两类:Actor-Critic方法和Q-Learning方法。

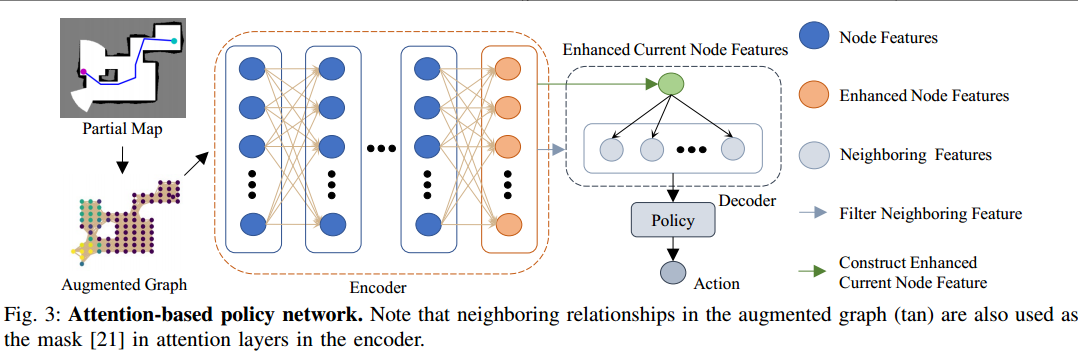

#### 3.1.1 Actor-Critic方法

Actor-Critic方法将强化学习问题分解为两个子问题:actor和critic。actor负责根据当前状态选择动作,而critic负责评估actor的决策并提供反馈。注意力机制可以应用于actor和critic中,以提高其性能。

**Actor网络:**

在基于注意力的actor网络中,注意力机制用于从环境状态中提取相关信息。例如,在图像强化学习中,注意力机制可以聚焦于图像中的特定区域,从而帮助actor选择更有效的动作。

**Critic网络:**

在基于注意力的critic网络中,注意力机制用于识别对价值函数估计有影响的状态特征。通过关注相关特征,critic可以提供更准确的反馈,从而指导actor的决策。

#### 3.1.2 Q-Learning方法

Q-Learning方法是一种无模型的强化学习算法,它直接学习状态-动作价值函数。注意力机制可以应用于Q-Learning算法中,以提高其效率和泛化能力。

**Q网络:**

在基于注意力的Q网络中,注意力机制用于从状态-动作对中提取相关信息。通过关注相关特征,Q网络可以学习更准确的价值函数,从而做出更好的决策。

### 3.2 注意力机制在强化学习中的优势

注意力机制在强化学习中具有以下优势:

* **提高决策质量:**注意力机制使算法能够专注于相关信息,从而提高决策质量。

* **加速学习过程:**通过专注于重要特征,注意力机制可以加速强化学习算法的学习过程。

* **增强泛化能力:**注意力机制有助于算法学习环境中的不变特征,从而增强其泛化能力。

* **提高鲁棒性:**注意力机制使算法对噪声和干扰更具鲁棒性,因为它可以专注于相关信息。

**示例:**

以下是一个基于注意力的强化学习算法的伪代码示例:

```python

import torch

import torch.nn

```

0

0