PyTorch模型可视化:揭秘提升可解释性的5大利器

发布时间: 2024-12-12 04:27:11 阅读量: 24 订阅数: 19

# 1. PyTorch模型可视化的基础与重要性

模型可视化在深度学习中扮演着至关重要的角色,尤其对于研究者和工程师来说,它不仅能够帮助他们直观理解模型的工作原理,还能加速模型的调试和优化过程。在PyTorch这一强大的深度学习框架中,可视化技术的应用使得模型训练过程和内部机制变得更加透明。本章将概述模型可视化的基本概念,阐述其在机器学习领域中的重要性,并探讨为何模型可视化成为了开发高性能深度学习模型不可或缺的一部分。此外,本章还将介绍一些基础的可视化技术,为读者之后深入学习PyTorch中的高级可视化工具打下坚实的基础。

```python

import torch

# 示例代码:创建一个简单的模型并打印其结构

class SimpleModel(torch.nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.layer1 = torch.nn.Linear(in_features=10, out_features=20)

self.layer2 = torch.nn.Linear(in_features=20, out_features=1)

def forward(self, x):

x = torch.relu(self.layer1(x))

x = self.layer2(x)

return x

model = SimpleModel()

print(model)

```

通过上述代码我们可以看到,即使是一个简单的模型,其内部结构也包含着复杂的线性变换和激活函数。这种结构的理解对于模型的训练和优化至关重要。在接下来的章节中,我们将探讨模型可视化如何帮助我们更好地理解这种复杂性。

# 2. 理论篇 - 模型可视化的核心概念

模型可视化是人工智能(AI)领域的一个重要分支,它有助于研究者和开发人员理解模型的工作原理。通过可视化技术,复杂的模型决策过程可以被转换为直观的图像或动画,从而使得非专业人士也能够理解模型的行为。本章节将探讨可解释人工智能的背景与需求,模型可视化的目的与方法论,以及理论模型与实际应用之间的差距。

### 2.1 可解释人工智能的背景与需求

#### 2.1.1 人工智能黑盒问题的挑战

人工智能模型,尤其是深度学习模型,由于其复杂性和庞大的参数数量,往往被认为是一个“黑盒”,难以解释其内部工作机制。这种不可解释性在某些应用场景下可能引发问题,比如在医疗、金融等领域,决策过程的透明度至关重要。当模型输出的预测结果出现问题时,缺乏可解释性会使得问题定位和修复变得异常困难。

#### 2.1.2 可解释性的定义与价值

可解释人工智能(XAI)是指设计、开发和使用AI系统时,能够提供可理解的解释和证据,以增强用户对模型决策的理解。可解释性可以帮助开发者发现和修正模型中的错误,增加用户对模型的信任,同时遵守日益严格的法规要求,例如欧盟的通用数据保护条例(GDPR)中的“解释权”条款。此外,可解释性还能够帮助开发者获取新的见解,进一步改进模型的性能。

### 2.2 模型可视化的目的与方法论

#### 2.2.1 视觉化模型内部机制的重要性

模型可视化技术可以将复杂模型的内部机制,如权重、特征提取、激活模式等,转换为图像或动画,使得模型的工作原理变得可视化和易于理解。这种可视化有助于揭示模型在特定任务上的表现,如识别错误、学习过程中的趋势以及模型对不同输入的响应。

#### 2.2.2 可视化技术的主要分类

可视化技术大致可以分为两类:静态可视化和动态可视化。静态可视化通常展示模型在某一瞬间的状态,例如权重分布图或特定层的激活图。动态可视化则展示模型随时间变化的过程,如梯度下降过程中的权重更新或输入数据经过模型处理的全流程。

#### 2.2.3 可视化技术的选择标准

选择哪种可视化技术取决于多个因素,包括数据的类型、模型的复杂度、可视化的目的等。例如,对于研究人员而言,可能更关注模型内部特征的详细展示;对于开发者来说,可视化可能需要着重于模型性能的展示;而对于业务人员,则可能需要更直观的展示模型的决策过程和结果。

### 2.3 理论模型与实际应用的差距

#### 2.3.1 理论模型的理想与实践中的挑战

理论模型往往在理想化的条件下进行设计和分析,但在实际应用中,会面临数据质量、计算资源限制、环境变化等挑战。这些挑战可能会导致模型的性能下降,甚至产生不符合预期的行为。

#### 2.3.2 解决实际问题的策略

为了弥合理论模型与实际应用之间的差距,开发人员需要采取一些策略,例如:使用合成数据集和噪声数据进行模型训练和验证、采用模型鲁棒性优化技术、实施持续的监控和模型评估机制等。通过这些策略,可以确保模型在面对实际挑战时依然能够保持良好的性能表现。

# 3. 实践篇 - PyTorch中的可视化工具与技术

## 3.1 PyTorch内置的可视化工具介绍

### 3.1.1 TensorBoardX的使用

TensorBoardX 是 PyTorch 生态中非常流行的可视化工具,它提供了一个强大的接口来展示模型的训练过程和结果。作为 TensorBoard 的一个端口,TensorBoardX 能够无缝地与 PyTorch 集成,为开发者提供丰富的可视化选项,如标量值、图像、音频、直方图、投影和模型结构等。

使用 TensorBoardX 可以极大地提高调试模型的效率,同时也能够使模型的训练结果更加直观。安装 TensorBoardX 非常简单,可以通过以下命令完成:

```bash

pip install tensorboardX

```

一旦安装完成,就可以在你的代码中进行相应的导入和使用:

```python

from tensorboardX import SummaryWriter

# 实例化 SummaryWriter 对象

writer = SummaryWriter('runs/experiment_1')

# 在训练过程中添加标量值

for step in range(num_steps):

loss = model.forward(batch_data)

writer.add_scalar('loss', loss, step)

# 关闭 SummaryWriter 对象

writer.close()

```

在上述代码示例中,我们创建了一个 SummaryWriter 实例来记录训练过程中的损失值,并且将这些信息写入到一个名为 'runs/experiment_1' 的文件夹中。之后,我们可以在 TensorBoard 中加载这个文件夹来可视化损失值随训练步骤的变化情况。

### 3.1.2 其他可视化库的选择与对比

除了 TensorBoardX,PyTorch 社区还提供了其他多种可视化工具,每种工具都拥有独特的功能和应用场景。

- Visdom:由 Facebook AI Research (FAIR) 推出的可视化工具,支持实时显示,非常适合需要进行交互式可视化的场景。

- Matplotlib:一个功能强大的绘图库,虽然不如 TensorBoardX 专为深度学习设计,但在某些情况下(如展示模型权重分布)同样适用。

在选择可视化库时,我们需要考虑以下几个方面:

- **易用性**:库的安装和使用是否简单方便。

- **功能性**:库是否提供了足够的功能来满足我们的可视化需求。

- **性能**:在数据量较大时,库是否能够保持良好的性能和响应速度。

- **社区支持**:社区活跃程度如何,是否有足够的资源和文档。

下面是一个使用 Matplotlib 展示数据的例子:

```python

import matplotlib.pyplot as plt

# 假设我们有一组数据

x = [1, 2, 3, 4, 5]

y = [2, 3, 5, 7, 11]

plt.plot(x, y)

plt.title('Data Visualization with Matplotlib')

plt.xlabel('X axis')

plt.ylabel('Y axis')

plt.show()

```

在使用任何一种可视化工具时,确保选择最适合你的项目需求和开发习惯的工具。

## 3.2 高级可视化技巧的实现

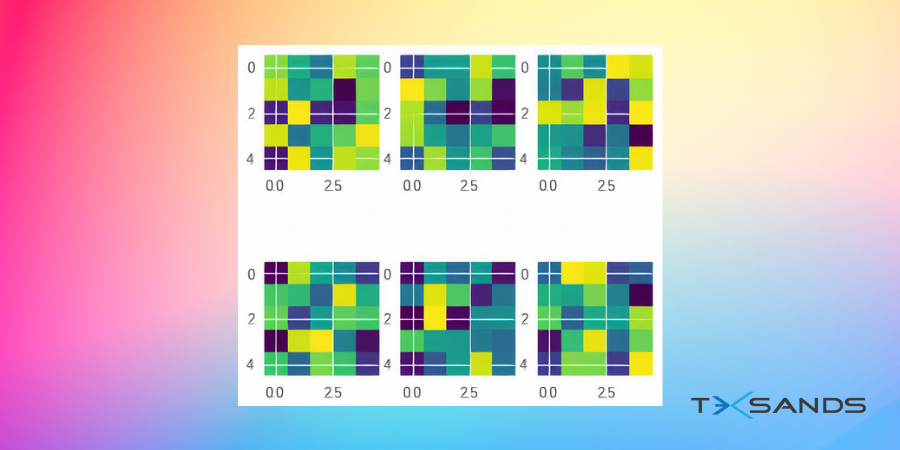

### 3.2.1 神经元激活与权重分布的可视化

在深度学习模型的调试和优化过程中,了解网络内部的激活状态和权重分布是至关重要的。通过可视化这些信息,我们可以更好地理解模型的行为,并据此做出相应的调整。

```python

import torch

from torchvision import models

import matplotlib.pyplot as plt

# 加载预训练模型

model = models.resnet50(pretrained=True)

# 提取某一层的权重

layer_weights = model.conv1.weight.data.numpy()

# 展示权重分布的直方图

plt.hist(layer_weights.flatten(), bins=50, range=(-5,5))

plt.title('Weight Distribution of Convolutional Layer')

plt.xlabel('Weight')

plt.ylabel('Frequency')

plt.show()

```

在此代码中,我们提取了 ResNet50 模型第一层卷积的权重,并通过 Matplotlib 绘制了权重的直方图。通过观察直方图的形状,我们可以得到权重分布是否符合预期的初步判断。

### 3.2.2 特征图与梯度的可视化

特征图能够显示神经网络中各个卷积层提取的特征,而梯度可视化则能帮助我们了解模型在训练过程中学习的动态过程。以下是一个简单的例子,用于展示如何可视化卷积层的特征图:

```python

import torch.nn.functional as F

import torchvision.transforms as transforms

from PIL import Image

# 加载图片并转换为模型输入所需的格式

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

])

image = Image.open("image.jpg")

input_tensor = transform(image).unsqueeze(0)

# 使用预训练模型进行前向传播

model = models.resnet50(pretrained=True)

model.eval() # Set the model to evaluation mode

with torch.no_grad():

output = model(input_tensor)

# 提取特征图

feature_map = output[0, :, :, :].squeeze()

# 展示特征图

plt.figure(figsize=(10, 10))

for i in range(1, 26):

plt.subplot(5, 5, i)

plt.imshow(feature_map[i].cpu().data.numpy())

plt.axis('off')

plt.show()

```

### 3.2.3 梯度回传与反向传播的可视化

理解梯度如何在模型中传播对于理解模型的训练动态和避免梯度消失或梯度爆炸等问题非常重要。以下是如何计算并可视化一个简单神经网络中特定权重参数的梯度:

```python

import torch

# 定义一个简单的线性模型

class SimpleModel(torch.nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.linear = torch.nn.Linear(10, 1)

def forward(self, x):

return self.linear(x)

# 创建模型实例并设置权重

model = SimpleModel()

model.linear.weight.data.fill_(1)

# 定义损失函数和优化器

loss_fn = torch.nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

# 生成输入数据和目标

x = torch.randn(20, 10)

y = torch.randn(20, 1)

# 前向传播、计算损失

pred = model(x)

loss = loss_fn(pred, y)

# 计算梯度

optimizer.zero_grad()

loss.backward()

grad = model.linear.weight.grad.data.numpy()

# 可视化梯度

plt.imshow(grad, cmap='hot', interpolation='nearest')

plt.colorbar()

plt.show(

```

0

0