提升MapReduce性能:小文件合并工具的比较与选择

发布时间: 2024-10-31 08:18:38 阅读量: 27 订阅数: 28

hive数据表-小文件合并代码(java)

# 1. MapReduce性能优化概览

MapReduce是一个广泛应用于大规模数据集处理的编程模型,它允许开发者通过简单的接口来编写分布式应用。然而,MapReduce模型在处理大量小文件时,往往效率不高。性能问题主要表现在任务调度和磁盘I/O上,其中任务调度频繁和小规模的磁盘读写会导致效率低下。

当我们谈论MapReduce性能优化时,我们往往是在寻找减少任务启动开销、降低I/O操作和合理分配资源的方法。通过这些优化,可以显著提升数据处理速度和集群资源利用率。

优化策略多种多样,其中包括小文件合并、调整MapReduce框架的配置参数、优化数据存储格式以及采用更高效的算法。在接下来的章节中,我们将深入探讨这些优化方法,并分析它们如何提升MapReduce处理效率。

# 2. 小文件问题及其对MapReduce的影响

### 2.1 小文件对Hadoop性能的挑战

#### 2.1.1 I/O开销增大

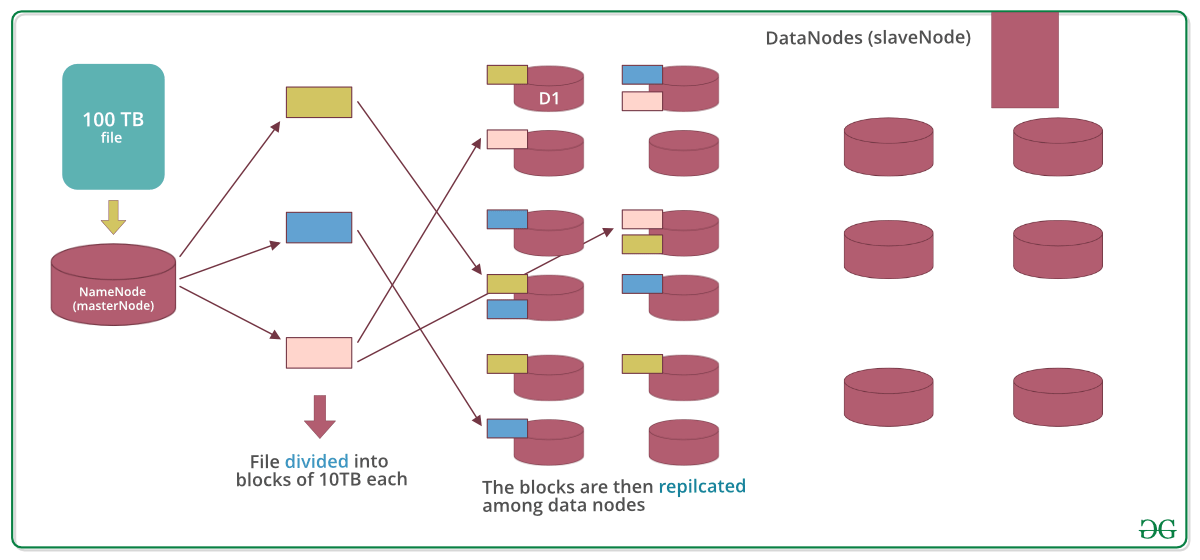

在Hadoop生态系统中,I/O操作的优化至关重要,因为它是影响MapReduce任务执行速度的关键因素之一。小文件的增多会带来显著的I/O开销。相对于大文件,小文件需要更多的元数据信息来存储文件信息,这包括文件名、权限、位置等。当在HDFS中存储大量小文件时,NameNode上的内存需求会急剧增加,因为NameNode需要维护每个文件的所有元数据信息。

例如,假设有一个应用场景,在该场景中,我们需要处理上万个小型日志文件。每个文件平均大小为1MB,那么在没有采取任何优化措施的情况下,存储这些文件将会带来巨大的I/O负担。不仅因为磁盘读写操作频繁,而且也会因为元数据管理而使得NameNode的负载增加,进而影响整个集群的性能。

#### 2.1.2 Map任务管理成本上升

MapReduce在处理数据时,首先需要将数据划分为多个Map任务。对于小文件而言,每个Map任务通常处理一个文件或一小部分数据。这会带来两个问题:

1. **任务创建和调度开销增加**:由于每个小文件都需要一个Map任务来处理,这意味着会生成大量的任务。Hadoop的调度器需要为每个任务分配资源并调度执行,这本身就需要额外的开销。

2. **负载不平衡**:小文件的随机分布可能导致Map任务处理时间差异很大,从而导致集群负载不均衡。一些任务可能迅速完成,而其他任务可能因为数据量较大或数据局部性问题而运行缓慢。

### 2.2 小文件产生的原因与场景分析

#### 2.2.1 多用户环境下的小文件生成

在多用户环境中,例如一个大学的研究团队共享同一个Hadoop集群,每个用户可能都会生成自己的小文件。由于Hadoop文件系统的共享特性,不同的用户在没有良好管理的情况下,很容易产生大量的小文件。在某些情况下,用户为了测试目的,也可能会生成小文件。

例如,研究人员可能为每个实验生成一个单独的小文件,而不考虑整体的存储效率和未来处理的需求。结果是,随着时间推移,这些小文件会积累,导致集群性能下降。

#### 2.2.2 数据采集过程中导致的小文件

数据采集过程是另一个常见生成小文件的场景。例如,一个在线广告系统可能会收集每个点击事件的数据到HDFS中的一个单独文件中。如果系统设计不当,每个点击事件作为一个小文件存储,这将导致大量小文件的产生。

假设该广告系统每秒接收成千上万的点击事件,那么在短时间内就会产生大量小文件。在MapReduce作业执行时,这些小文件将会引起巨大的性能问题,因为Hadoop需要为每一个小文件启动一个单独的Map任务。

为了有效管理并优化小文件问题,我们需要考虑使用小文件合并工具,并且在设计数据存储和处理流程时,预先考虑小文件合并的策略。下一章将详细介绍不同的小文件合并工具以及它们的分类。

# 3. 小文件合并工具介绍与分类

在处理大数据时,小文件问题是一个普遍存在的挑战。小文件过多会显著增加系统的I/O开销,降低数据读写的效率。此外,大量的小文件会使Map任务的管理成本上升,这不仅影响了Hadoop集群的性能,还会增加计算资源的浪费。因此,对小文件进行合并处理,可以大幅度提升存储和计算的效率,这对于MapReduce性能优化是至关重要的。

## 3.1 离线小文件合并工具

在分布式存储系统中,对小文件进行预处理是提高数据读写效率的常用策略之一。这类操作通常在数据加载到Hadoop集群之前完成,目的是尽可能减少数据上传到HDFS后生成的小文件数量。

### 3.1.1 Hadoop Archive (HAR)

Hadoop Archive是Hadoop 0.19版本引入的一个工具,其主要目标是减少HDFS中大量小文件的存在。HAR的工作原理是将多个小文件打包成一个较大的HAR文件,从而减少了HDFS NameNode的元数据数量。使用HAR进行文件合并的基本步骤如下:

1. 准备Hadoop环境并配置好HDFS路径。

2. 使用Hadoop的`archive`命令,把多个小文件归档成一个HAR文件。

3. 在HDFS上创建一个目录用于存放归档文件。

4. 执行归档操作。

```bash

hadoop archive -archiveName name.har -p /input/path /output/path

```

这条命令表示将`/input/path`目录下的小文件打包成一个名为`name.har`的归档文件,并存放在`/output/path`目录下。在参数说明中,`-archiveName`指定了归档文件的名称,`-p`后跟的是原始文件路径,最后是归档后文件存放的路径。

### 3.1.2 CombineFileInputFormat

CombineFileInputFormat是Hadoop中的一个InputFormat类,旨在通过合并小文件来优化Map任务的处理效率。在Map阶段,传统InputFormat为每个小文件创建一个InputSplit,导致大量的Map任务同时运行,增加了调度和管理开销。CombineFileInputFormat通过将多个小文件合并到一个InputSplit中来解决这个问题。其核心思想是将多个小文件合并成一个较大的数据块,从而减少Map任务的数量,并提高处理效率。

CombineFileInputFormat具有良好的可配置性,可以设定最小和最大的文件块大小,以及合并文件的策略。在实际应用中,可以根据数据特点和集群性能,调整参数以获得最佳效果。

## 3.2 在线小文件合并工具

相对于离线合并工具,线上工具更关注如何在数据已经被加载到HDFS后进行合并,以便快速响应数据处理需求。在线小文件合并工具有助于动态优化存储结构,提高系统的实时处理能力。

### 3.2.1 HDFS的小文件合并服务

HDFS提供了对于小文件合并的服务,其工作原理是将多个小文件合并到一个更大的文件中,这通常通过Hadoop的文件操作API实现。HDFS的合并操作主要是通过创建一个新的文件,并将原有多个小文件的内容顺序写入到新文件中,之后删除原有的小文件。

一个简

0

0