栅栏填充算法性能提升:如何有效进行GPU加速(渲染速度翻倍)

发布时间: 2025-01-02 18:06:56 阅读量: 9 订阅数: 8

计算机图形学课件:6 边缘填充算法.ppt

# 摘要

栅栏填充算法作为图形渲染领域的重要组成部分,其效率直接影响渲染速度与质量。本文首先介绍了栅栏填充算法的基础知识,并探讨了GPU加速原理及其在图形处理中的应用。随后,本文深入分析了栅栏填充算法的GPU优化策略,包括算法并行化、内存优化技术以及流水线和同步机制的设计。通过实践案例的分析,文章展示了栅栏填充算法在GPU上的实现及其性能提升效果。此外,本文探讨了栅栏填充算法结合深度学习辅助渲染优化的前景,以及未来GPU技术与栅栏填充算法的发展趋势,特别是量子计算和可持续计算对行业的潜在影响。

# 关键字

栅栏填充算法;GPU加速;并行处理;内存优化;深度学习;渲染技术;量子计算;可持续计算

参考资源链接:[栅栏填充算法详解:区域填充与扫描转换](https://wenku.csdn.net/doc/7mbhsgr2h2?spm=1055.2635.3001.10343)

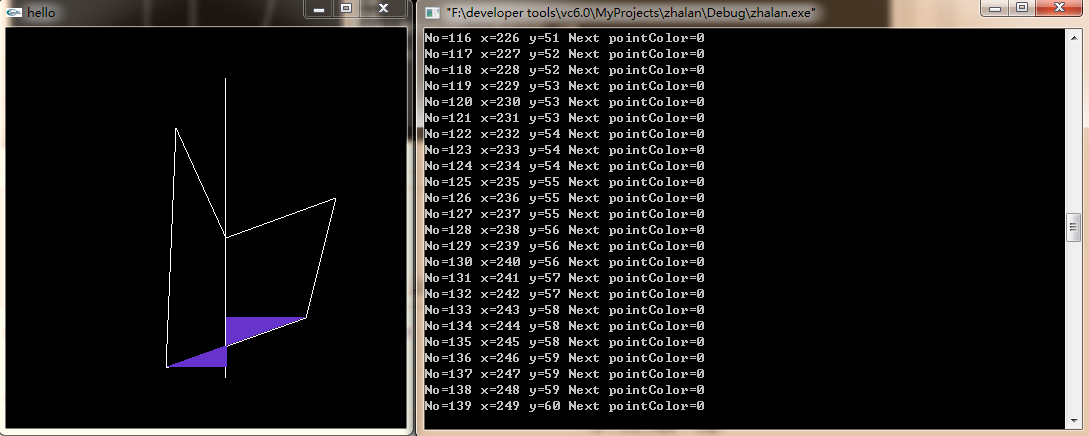

# 1. 栅栏填充算法基础介绍

栅栏填充算法是计算机图形学中一种用于填充多边形内部的算法。它通过在特定区域内生成像素点来实现图形的填充。栅栏填充算法的基础是将多边形边界的交点,也就是栅栏,按照一定的规则排序,然后根据这些交点决定填充的像素点位置。这种方法适用于各种复杂多边形的内部填充,包括凹多边形和具有孔洞的多边形。本章我们将深入探讨栅栏填充算法的工作原理,它如何简化复杂图形的内部点填充问题,以及如何应用这种算法在计算机图形渲染中实现高效的绘制。

# 2. GPU加速原理与应用

## 2.1 GPU架构概述

### 2.1.1 GPU与CPU的比较

GPU(Graphics Processing Unit)与CPU(Central Processing Unit)在设计之初就有不同的使命。CPU擅长处理复杂的逻辑运算和控制任务,具有少量的高性能核心,适合执行一系列复杂的指令序列。相比之下,GPU由成百上千个更简单的核心组成,这些核心可以并行处理大量的数据。GPU的设计专注于高吞吐量的数据处理,因此在图形渲染、科学计算等需要大量并行计算的领域,表现出色。

例如,CPU可能拥有4-8个核心,每个核心具有深度流水线和复杂的控制逻辑,适合处理单个复杂任务;而GPU则可能拥有数百至数千个核心,每个核心执行简单的运算,但它们可以协同完成大规模的并行计算任务。这种架构上的差异导致GPU在处理图形渲染、并行计算等任务时比CPU更加高效。

### 2.1.2 GPU并行处理能力的原理

GPU之所以能够提供强大的并行处理能力,是因为其内部架构经过优化,以支持大量的线程同时执行。这种能力基于几个核心概念:

- **SIMD(Single Instruction, Multiple Data)架构**:GPU使用SIMD模型,允许单个指令控制多个数据流。这意味着同一指令可以同时对多个数据元素执行相同的操作。

- **高吞吐量**:GPU具有成百上千个核心,能够在每个时钟周期内处理大量的数据。

- **专门的处理单元**:GPU内部含有专门用于图形渲染(如顶点着色器、像素着色器)和通用计算(如流处理器)的硬件单元。

- **快速上下文切换**:GPU核心设计能够快速进行上下文切换,从而实现多线程的快速切换和并行处理。

GPU的这些特性使其成为图形渲染和并行计算的理想选择。与CPU相比,GPU在处理并行任务时具有更高的性能和更低的功耗。

## 2.2 GPU编程模型

### 2.2.1 CUDA编程模型

CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种并行计算平台和编程模型,它允许开发者使用C语言为NVIDIA的GPU编写代码。CUDA模型提供了一个抽象层次,让开发者能够直接控制GPU进行数据处理,而无需涉及底层图形API的复杂性。

CUDA编程模型的基本概念包括:

- **线程(Thread)**:CUDA中最小的执行单元,每个线程执行相同的代码,但处理不同的数据。

- **线程块(Block)**:一组线程,它们在同一个GPU上执行。线程块能够实现线程之间的同步。

- **网格(Grid)**:一组线程块,整个CUDA程序由一个或多个网格组成。

CUDA编程模型的优势在于它直接暴露了GPU的并行架构,让开发者能够充分利用GPU的并行能力。例如,当执行一个矩阵乘法操作时,开发者可以将矩阵分为多个子矩阵,每个子矩阵的计算分配给不同的线程块进行处理。这样,大量的线程块可以并行执行,极大地提高了计算速度。

### 2.2.2 OpenCL编程模型

OpenCL(Open Computing Language)是一个开放的跨平台编程标准,它允许开发者编写在不同类型的处理器上运行的代码,包括CPU、GPU和其他类型的处理器(如DSPs)。与CUDA相比,OpenCL提供了更广泛的硬件支持。

OpenCL编程模型中的关键概念包括:

- **平台(Platform)**:一个或多个计算设备(如CPU、GPU)的组合,每个平台提供一个运行时环境。

- **计算设备(Compute Device)**:如GPU或CPU等可以执行计算任务的硬件。

- **上下文(Context)**:用于管理在计算设备上的资源。

- **命令队列(Command Queue)**:用于调度在计算设备上执行的命令。

- **内核(Kernel)**:OpenCL中的一个函数,它在计算设备上执行。

- **工作组(Work-Group)**:在计算设备上执行的线程集合,它们可以彼此协作和同步。

通过使用OpenCL,开发者可以利用标准化的编程模型,编写适用于各种硬件平台的并行程序。这为跨平台开发和优化提供了更大的灵活性和可移植性。

## 2.3 GPU加速渲染技术

### 2.3.1 实时渲染技术要求

实时渲染技术要求图形处理系统能够在有限的时间内,通常为每秒30帧(30 FPS)至每秒60帧(60 FPS)以上,渲染出高质量的图形图像。为了达到实时渲染的要求,GPU必须能够快速地处理和显示复杂场景中的大量数据。

实时渲染的关键要求包括:

- **高速的数据处理能力**:需要在非常短的时间内完成大量的顶点和像素处理。

- **高性能的内存访问**:GPU需要快速读写显存,以支持高速的数据流。

- **高效的并行计算**:为了处理数以百万计的顶点和像素,GPU需要有效地利用并行计算架构。

- **灵活的渲染管线**:需要支持各种渲染技术,包括光照、阴影、纹理映射、后处理效果等。

### 2.3.2 GPU渲染流程分析

GPU渲染流程可以分为几个主要步骤,每个步骤在并行处理能力上都有特定的要求和优化可能:

1. **顶点处理**:这个阶段涉及顶点着色器,它计算图元的顶点位置和其他属性,例如法线、纹理坐标等。在这一阶段,数据可以被高效地并行处理。

2. **光栅化(Rasterization)**:将顶点处理后的图元转化为像素的过程。光栅化是一个数据转换阶段,需要大量的并行处理单元来处理大规模的像素数据。

3. **像素处理**:这一阶段包括像素(片段)着色器,负责为每个像素计算颜色和其他属性。像素着色器的执行通常高度并行,能够充分利用GPU的线程处理能力。

4. **像素后处理**:完成像素着色器的处理后,图像可能会经过进一步的后处理,例如抗锯齿、色彩校正、合成等。这些步骤同样能够利用GPU的并行处理能力。

GPU通过这种并行处理流水线的方式,能够快速生成复杂场景的高质量图像,满足实时渲染的需求。接下来的章节将深入探讨如何利用GPU架构和编程模型优化栅栏填充算法,从而进一步提升渲染性能。

# 3. 栅栏填充算法的GPU优化策略

栅栏填充算法在计算机图形学中是一种常见技术,用于将特定颜色的像素填充到对象的边界内部。随着图形渲染需求的日益增长,如何利用GPU强大的并行计算能力来优化栅栏填充算法的性能,成为了图形开发者关注的重点。

## 3.1 算法分析与并行化

栅栏填充算法通常包括初始化边界的处理,然后在这些边界的约束下对内部像素进行着色。要将此算法优化为可并行处理的形式,关键在于减少串行依赖并增加并行执行的任务数量。

### 3.1.1 栅栏填充算法的步骤解析

传统的栅栏填充算法首先需要确定要填充的区域边界,然后根据这些边界生成一系列像素点坐标,并对每个坐标点进行着色。

```c

void scanLineFloodFill(int x, int y, int fill_color, int boundary_color) {

// 算法伪代码,需要替换为实际的填充逻辑

}

```

在GPU上实现时,我们可以将整个图像区域划分为多个小块,然后并行地对每个小块执行填充操作。

### 3.1.2 栅栏填充算法的并行潜力

为了提高并行效率,可以设计一种基于扫描线的算法,这将允许利用GPU的线程块来处理图像中的每一条扫描线,从而实现较高的并行度。

```c

__global__

```

0

0