【Origin线性拟合数学原理】:深入探索拟合参数的数学基础

发布时间: 2024-12-01 04:32:55 阅读量: 59 订阅数: 21

STM32之光敏电阻模拟路灯自动开关灯代码固件

参考资源链接:[Origin中线性拟合参数详解:截距、斜率与相关分析](https://wenku.csdn.net/doc/6m9qtgz3vd?spm=1055.2635.3001.10343)

# 1. 线性拟合的数学原理概述

在本章中,我们将从基础开始,探讨线性拟合背后的数学原理。线性拟合是数据分析中的一个基本工具,它通过在给定的数据点之间找到最佳的直线,以此来表示这些数据点的趋势或关系。我们将首先介绍线性拟合的核心概念,解释为什么线性模型在某些情况下十分有用,以及如何用数学语言来描述这种模型。

## 1.1 线性拟合的基本概念

线性拟合的基本思想是找到一条直线,该直线在数学上能够最好地代表一组数据点。这条直线称为最佳拟合线,其目标是最小化所有数据点到这条直线的垂直距离的平方和。数学上,这种最小化问题通常通过最小二乘法来解决。

## 1.2 数学表达与推导

线性拟合的数学表达通常采用直线方程 y = ax + b 的形式,其中 a 是斜率,b 是截距。要找到最佳的 a 和 b,我们需要解决一个优化问题,即找到参数 a 和 b,使得所有数据点 (x_i, y_i) 到直线 y = ax + b 的垂直距离的平方和最小。这个过程涉及到的数学推导将在后续章节中详细讨论。

本章为理解线性拟合在更深层次的应用提供了坚实的基础,接下来的章节将深入探讨线性回归理论和实践。

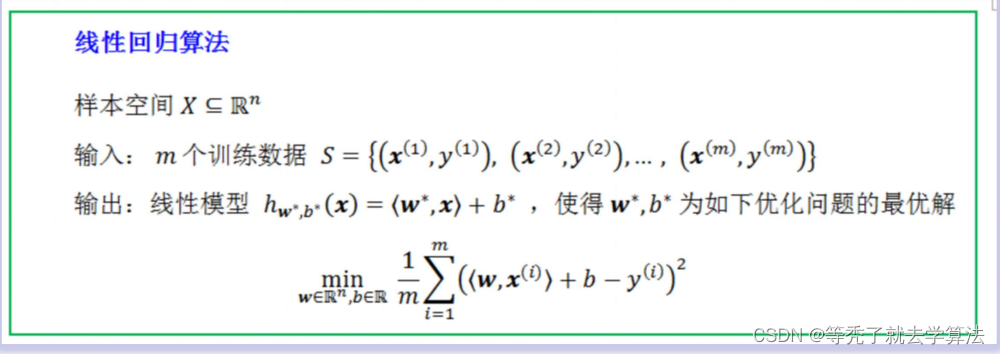

# 2. 线性回归理论基础

## 2.1 线性回归模型的定义

### 2.1.1 回归分析的基本概念

回归分析是统计学中一种分析数据的方法,目的在于了解两种或两种以上变量间是否相关、相关方向与强度,并对具有依存关系的变量之间的统计关系进行估计。在机器学习和数据分析中,回归分析被广泛应用于预测和决策问题。

线性回归是回归分析中的一种模型,它假设自变量和因变量之间存在线性关系,形式上通常表示为:

\[y = \beta_0 + \beta_1x_1 + \beta_2x_2 + ... + \beta_nx_n + \epsilon\]

其中,\(y\)是因变量,\(x_1, x_2, ..., x_n\)是n个自变量,\(\beta_0\)是截距项,\(\beta_1, \beta_2, ..., \beta_n\)是模型的参数,代表自变量的系数,\(\epsilon\)是误差项,表示未能由模型解释的随机变量。

### 2.1.2 线性回归方程的建立

在实际应用中,线性回归方程的建立首先要基于数据进行。以下是建立线性回归方程的基本步骤:

1. 数据收集:收集一组数据,这些数据包含自变量\(X\)和因变量\(Y\)的测量值。

2. 数据探索:使用图表、描述性统计等工具分析数据的基本特征,判断是否存在线性关系。

3. 模型假设:假设\(Y\)与\(X\)之间存在线性关系。

4. 参数估计:利用统计方法估计回归系数\(\beta\)。

5. 模型诊断:对估计出的模型进行诊断,包括残差分析、异常值检测等。

## 2.2 线性回归的参数估计

### 2.2.1 最小二乘法原理

最小二乘法是一种数学优化技术,它通过最小化误差的平方和寻找数据的最佳函数匹配。在线性回归模型中,最小二乘法被用于确定回归线(即线性模型)的参数,使得模型预测值与实际观测值之间的差异尽可能小。

假设有一组观测数据\((x_i, y_i)\),其中\(i = 1, 2, ..., n\),我们要找到一条直线\(y = \beta_0 + \beta_1x\),使得所有的观测点到这条直线的距离的平方和最小。

这个距离的平方和,也被称为残差平方和(RSS),计算公式为:

\[RSS = \sum_{i=1}^{n} (y_i - (\beta_0 + \beta_1x_i))^2\]

最小二乘法的目标是找到\(\beta_0\)和\(\beta_1\)的值,使得RSS最小。

### 2.2.2 参数估计的数学推导

为了找到最小化RSS的参数\(\beta_0\)和\(\beta_1\),我们对RSS分别对这两个参数求偏导数,并将偏导数设为0。求解这个方程组(也称为正规方程)可以得到\(\beta_0\)和\(\beta_1\)的最优估计值。

正规方程如下:

\[

\begin{align*}

\frac{\partial RSS}{\partial \beta_0} &= -2\sum_{i=1}^{n}(y_i - (\beta_0 + \beta_1x_i)) = 0 \\

\frac{\partial RSS}{\partial \beta_1} &= -2\sum_{i=1}^{n}(y_i - (\beta_0 + \beta_1x_i))x_i = 0

\end{align*}

\]

通过对上述方程求解,我们就可以得到参数\(\beta_0\)和\(\beta_1\)的闭式解(closed-form solution)。在实际应用中,常常使用计算机软件包直接计算这些参数,例如在Python的`numpy`或`statsmodels`库中,可以直接调用函数进行线性回归模型的参数估计。

## 2.3 线性回归的统计检验

### 2.3.1 回归系数的假设检验

在线性回归模型中,参数的统计检验是非常重要的环节。这涉及到对每个回归系数进行检验,以确定该系数是否在统计意义上显著不同于0。如果某个回归系数统计上不显著,那么这个自变量可能对模型的预测能力没有显著贡献。

为了检验回归系数的显著性,通常使用t检验(t-test)。t检验的原假设是系数等于0,备择假设是系数不等于0。如果p值小于设定的显著性水平(如0.05),则拒绝原假设,认为该系数是统计显著的。

t值的计算公式为:

\[ t = \frac{\beta - 0}{SE(\beta)} \]

其中,\(\beta\)是回归系数的估计值,\(SE(\beta)\)是该系数的标准误差。

### 2.3.2 模型的拟合优度检验

模型的拟合优度检验主要考察模型对数据拟合的程度。最常用的拟合优度度量是决定系数(R-squared,记作\(R^2\))。\(R^2\)的值介于0和1之间,它表示模型解释的变异占总变异的比例。

计算公式为:

\[ R^2 = 1 - \frac{RSS}{TSS} \]

其中,\(RSS\)是残差平方和,\(TSS\)是总平方和(Total Sum of Squares),\(TSS\)是观测值与因变量均值之差的平方和。

如果\(R^2\)值接近1,表示模型能很好地解释数据的变异性;如果\(R^2\)值接近0,则表明模型的解释力较差。然而,\(R^2\)并不总是越接近1越好,特别是在模型中包含过多的自变量时,模型可能会出现过拟合现象,此时\(R^2\)值可能会被不恰当地高估。

此外,在多元线性回归分析中,为了调整自由度的影响,经常使用调整后的\(R^2\)来评估模型的拟合优度,调整后\(R^2\)考虑了变量的数量,因此对模型的复杂度有一定的惩罚效应。

# 3. 线性拟合算法实践

线性拟合是数据科学中的一项基础且重要的技术,它的核心在于找到一组最佳的线性关系,以最准确地描述两个或多个变量之间的关系。在实际应用中,线性拟合常常涉及到复杂的数学计算以及对模型的优化。本章将深入探讨线性拟合的算法实践,包括数值计算方法、编程语言实现以及案例分析。我们将从理论走向实际,通过具体操作来理解线性拟合。

## 3.1 数值计算方法

### 3.1.1 迭代法求解线性方程组

在线性拟合中,我们经常需要解决形如 `Ax=b` 的线性方程组,其中 `A` 是系数矩阵,`x` 是我们要解的参数向量,`b` 是已知的数据向量。迭代法是一种高效的数值求解方法,它从一个初始估计开始,逐步逼近真实的解。

常见的迭代方法有雅可比迭代(Jacobi Method)、高斯-赛德尔迭代(Gauss-Seidel Method)等。这些方法的核心思想是通过迭代更新解向量 `x` 的每个分量,直到解

0

0