【Origin线性拟合异常值处理】:确保分析结果的准确无误

发布时间: 2024-12-01 04:49:06 阅读量: 62 订阅数: 22

origin数据分析软件剔除实验数据的异常值借鉴.pdf

参考资源链接:[Origin中线性拟合参数详解:截距、斜率与相关分析](https://wenku.csdn.net/doc/6m9qtgz3vd?spm=1055.2635.3001.10343)

# 1. 线性拟合及其在数据分析中的重要性

在数据分析的世界里,线性拟合是一种基本且强大的工具,它能够帮助我们理解数据中的基本趋势并预测未来的值。线性拟合通过找到最佳的直线,以最小化实际数据点与拟合线之间的垂直距离,从而在一组数据点之间建立起数学关系。尽管其模型相对简单,但线性拟合在预测分析、质量控制、科学研究等众多领域都发挥着至关重要的作用。在这一章节中,我们将探讨线性拟合在数据分析中的重要性,并逐步深入了解其在实际应用中如何发挥效用。

# 2. 线性拟合的基础理论

## 2.1 线性回归模型简介

### 2.1.1 线性回归的定义

线性回归是一种统计学方法,用于研究一个或多个自变量(解释变量)和因变量(响应变量)之间的关系。在线性回归模型中,这种关系被假设为线性的,即通过参数(或权重)来表示变量间线性关系的强度和方向。线性回归模型可以是简单线性回归(一个自变量)也可以是多元线性回归(多个自变量)。简单线性回归模型可以表示为:Y = aX + b + ε,其中Y是因变量,X是自变量,a是斜率,b是截距,ε是误差项。

### 2.1.2 线性回归的目标函数

线性回归的目标函数通常是最小化误差项的平方和,这被称为最小二乘法。目标函数的形式如下:

E = ∑(Yi - (aXi + b))^2,其中E是误差平方和,Yi是观测值,Xi是相应的自变量值。最小化该目标函数可以确定最佳的参数a和b,使得线性模型与实际数据点的差异最小化。

## 2.2 线性拟合的数学原理

### 2.2.1 最小二乘法的原理

最小二乘法的基本思想是,通过最小化误差的平方和寻找数据的最佳函数匹配。数学上,这可以表示为寻找一组参数(在线性回归中是斜率和截距),使得所有观测值与模型预测值之差的平方和达到最小。这一过程涉及到偏导数和偏导数为零的求解过程,以确定模型参数的最优值。

### 2.2.2 参数估计的方法

参数估计通常使用解析解(闭式解)或数值优化方法。解析解可以利用线性代数的方法,例如利用矩阵运算直接求得模型参数。在某些复杂情况下,如多元线性回归或含有非线性项的情况,参数的估计则需要借助数值优化算法,如梯度下降法、牛顿法等,来迭代求得最佳参数值。

## 2.3 线性拟合的评估指标

### 2.3.1 决定系数R²的意义

决定系数R²,又称作相关系数的平方,是衡量回归模型拟合优度的一个统计量,其值介于0和1之间。R²的值越接近1,表示模型对数据的解释能力越强,反之则模型拟合程度较差。R²的计算公式为:R² = 1 - (Σ(Yi - Ŷi)² / Σ(Yi - Ȳ)²),其中Yi是实际观测值,Ŷi是模型预测值,Ȳ是观测值的平均值。

### 2.3.2 残差分析在拟合质量评估中的作用

残差分析是对模型拟合后的残差(实际值与预测值之差)进行分析,来检查模型是否合适,数据是否满足线性回归的假设条件。理想情况下,残差应该是随机分布的,没有明显的模式。如果存在模式或趋势,那么模型可能不适合数据,需要进一步的调整或变换。

### 2.3.3 其他评估指标

除了R²外,还有一些其他评估指标可以用于线性拟合的质量评估,如均方误差(MSE)、均方根误差(RMSE)和平均绝对误差(MAE)。这些指标提供了不同角度的拟合质量信息,辅助研究者或数据分析师更全面地评估模型性能。

### 2.3.4 模型泛化能力的考量

在评估模型时,除了拟合度指标外,还应当考虑模型的泛化能力,即模型对未来数据预测的准确性和稳定性。这通常需要通过交叉验证、保留一部分数据作为测试集等方法来评估。通过这些方法,可以避免模型过拟合,确保模型在实际应用中的泛化能力。

### 2.3.5 模型调整与验证的重要性

在实际应用中,线性模型可能需要根据数据的特点进行调整。调整可能包括添加或移除变量,转换变量形式,或引入交互项等。模型验证是通过将数据集分为训练集和测试集,训练模型并验证模型预测性能的过程。这一过程有助于确认模型的适用性和有效性。

以上所述内容构成了线性拟合基础理论的核心部分。通过深入理解线性回归模型、数学原理和评估指标,我们可以更好地掌握线性拟合的技术要领,并将其应用于实际的数据分析中。接下来的章节将会进一步探讨异常值的识别与处理理论,为数据的清洁与准备奠定基础。

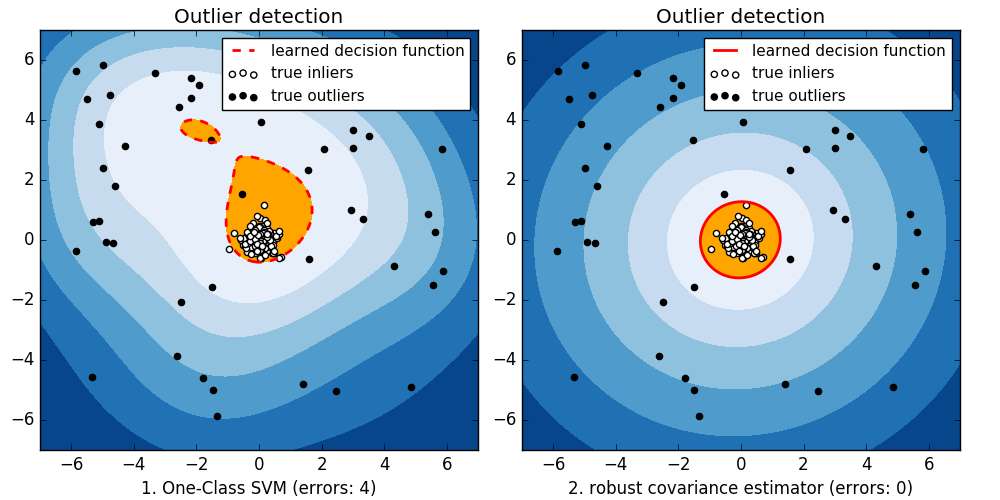

# 3. 异常值的识别与处理理论

### 3.1 异常值的定义与分类

#### 3.1.1 异常值的概念

在数据分析过程中,异常值通常指的是那些与整体数据分布不一致的观测值。这些值可能是由测量错误、数据录入错误、或者数据本身的真实变异造成的。异常值的存在会对数据的分析结果产生显著影响,尤其是在进行线性拟合时,这些值可能会扭曲模型,导致拟合结果不准确。因此,识别并妥善处理异常值是数据预处理的重要步骤。

#### 3.1.2 异常值的常见来源

异常值可以源自多种原因,常见的来源包括:

- 系统误差:由于设备故障、测量方法不当等造成的系统性错误。

- 随机误差:偶然因素导致的偏离,如环境波动、人为操作差异等。

- 数据处理错误:数据录入、处理过程中的失误。

- 新颖性:数据中包含的创新或新现象,尚未被现有模型所预期。

- 数据突变:例如由于外部事件(如自然灾害、市场变动等)导致的数据值突变。

### 3.2 异常值识别方法

#### 3.2.1 箱型图在异常检测中的应用

箱型图(Boxplot)是一种用于展示一组数据分散情况资料的统计图。它显示了数据的最小值、第一四分位数(Q1)、中位数、第三四分位数(Q3)和最大值。通过计算四分位数间距(IQR)并与数据点进行比较,我们可以识别出异常值。一般而言,位于 Q1 - 1.5 * IQR 或 Q3 + 1.5 * IQR 之外的数据点被认为是异常值。

以下是使用Python生成箱型图并识别异常值的代码示例:

```python

import matplotlib.pyplot as plt

# 假设 data 是包含测量值的列表

data = [23, 25, 22, 26, 24, 150, 21, 27, 28, 22, 24]

# 绘制箱型图

plt.boxplot(data)

plt.show()

# 计算并识别异常值

Q1 = np.percentile(data, 25)

Q3 = np.percentile(data, 75)

IQR = Q3 - Q1

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

outliers = [x for x in data if x < lower_bound or x > upper_bound]

print("异常值为:", outliers)

```

在代码中,首先导入了 `matplotlib.pyplot` 库用于绘图,然后创建一个数据列表并计算四分位数。最后,通过比较确定并打印出异常值列表。

#### 3.2.2 统计检验方法介绍

除了箱型图之外,还可以使用统计检验方法来识别异常值。例如,Z-分数(标准分数)法,该方法基于数据的均值和标准差计算每个点的Z-分数。Z-分数越高或越低,表示该数据点离平均值越远,从而可能是一个异常值。

Z-分数的计算公式为:

\[ Z = \frac{(X - \mu)}{\sigma} \]

其中,\(X\) 是数据点,\(\mu\) 是均值,\(\sigma\) 是标准差。

在Python中,可以使用如下代码来实现Z-分数法的异常值检测:

```python

import numpy as np

# 继续使用上面的数据集

data = np.array(data)

mu = np.mean(data)

sigma = np.std(data)

# 计算Z-分数

z_scores = (data - mu) / sigma

# 设置阈值,例如Z-分数大于3或小于-3认为是异常值

outliers = data[np.abs(z_scores) > 3]

print("使用Z-分数法识别的异常值为:", outliers)

```

### 3.3 异常值处理策略

#### 3.3.1 删除异常值

在发现异常值后,最直接的处理方法是将其从数据集中删除。这种做法适用于异常值是由于测量错误或其他非系统性错误造成的。删除异常值可以简化数据集,使得模型更易于训练和解释。然而,删除异常值可能会导致信息的丢失,特别是当这些异常值代表数据的新颖性或重要变化时。

#### 3.3.2 异常值的修正与替换

另一种处理异常值的方法是修正或替换这些值。修正通常需要专业知识,以便找到更准确的值来替换异常值。例如,如果异常值是由于数据录入错误造成的,可以检查原始数据并修正错误。替

0

0