【Python读取txt文件终极指南】:从入门到精通,掌握文件读取技巧

发布时间: 2024-06-22 17:09:38 阅读量: 97 订阅数: 73

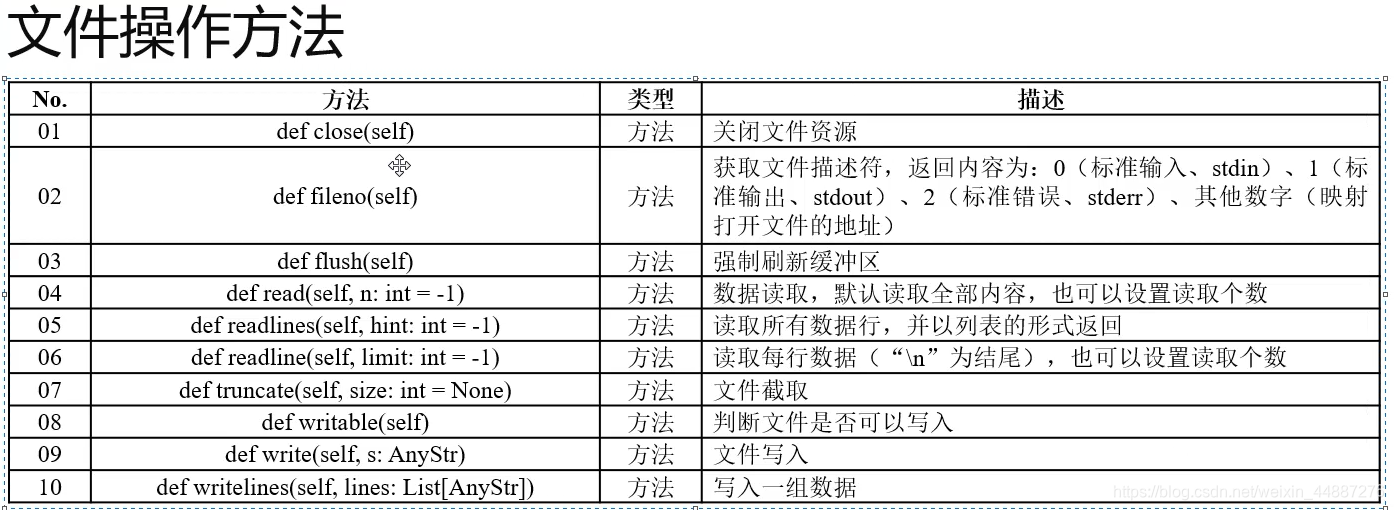

# 1. Python文件读取基础

Python提供了丰富的文件读取功能,可用于处理各种文件格式。文件读取的基本操作包括:

- 打开文件:使用`open()`函数打开文件,并指定读取模式(如`'r'`表示只读)。

- 读取文件:使用`read()`方法读取文件内容,返回字符串或字节对象。

- 关闭文件:使用`close()`方法关闭文件,释放系统资源。

# 2. Python文件读取高级技巧

### 2.1 文件读取模式和编码

#### 2.1.1 不同读取模式的应用场景

Python提供多种文件读取模式,用于指定文件打开方式,包括:

* `r`:只读模式,默认模式,只能读取文件。

* `w`:写入模式,打开文件并清空原有内容,写入新内容。

* `a`:追加模式,打开文件并定位到文件末尾,追加新内容。

* `r+`:读写模式,打开文件并允许读写操作。

* `w+`:读写模式,打开文件并清空原有内容,允许读写操作。

* `a+`:读写模式,打开文件并定位到文件末尾,允许读写操作。

不同读取模式的应用场景如下:

| 模式 | 应用场景 |

|---|---|

| `r` | 读取现有文件 |

| `w` | 创建新文件或覆盖现有文件 |

| `a` | 向现有文件追加内容 |

| `r+` | 读写现有文件 |

| `w+` | 读写新文件或覆盖现有文件 |

| `a+` | 读写现有文件,追加内容 |

#### 2.1.2 常见编码格式和转换方法

文本文件通常使用特定编码格式存储字符,如UTF-8、GBK、ASCII等。在读取文件时,需要指定正确的编码格式,否则可能出现乱码。

Python提供`open()`函数的`encoding`参数指定编码格式,并提供`codecs`模块进行编码转换。常见编码格式和转换方法如下:

| 编码格式 | 转换方法 |

|---|---|

| UTF-8 | `codecs.decode(text, 'utf-8')` |

| GBK | `codecs.decode(text, 'gbk')` |

| ASCII | `codecs.decode(text, 'ascii')` |

### 2.2 文件读取优化技术

#### 2.2.1 缓存机制和缓冲区大小

Python使用缓存机制提高文件读取效率,将文件内容存储在内存中,避免频繁访问磁盘。`open()`函数的`buffering`参数指定缓冲区大小,单位为字节。

* `0`:不使用缓存,每次读取直接从磁盘读取。

* `1`:行缓冲,每次读取一行。

* `其他正整数`:指定缓冲区大小,单位为字节。

缓冲区大小的选择取决于文件大小和读取方式。对于小文件,使用行缓冲或较小缓冲区即可;对于大文件,使用较大缓冲区可以提高效率。

#### 2.2.2 并发读取和异步处理

在多线程或多进程环境中,可以利用并发读取和异步处理技术提高文件读取效率。

* **并发读取:**使用多个线程或进程同时读取文件不同部分。

* **异步处理:**使用非阻塞I/O,在文件读取完成前执行其他任务。

Python提供`concurrent.futures`模块和`asyncio`模块支持并发和异步处理。

```python

import concurrent.futures

def read_file(filename):

with open(filename, 'r') as f:

return f.read()

with concurrent.futures.ThreadPoolExecutor() as executor:

futures = [executor.submit(read_file, filename) for filename in filenames]

results = [future.result() for future in futures]

```

```python

import asyncio

async def read_file(filename):

async with open(filename, 'r') as f:

return await f.read()

async def main():

tasks = [read_file(filename) for filename in filenames]

results = await asyncio.gather(*tasks)

asyncio.run(main())

```

# 3.1 数据清洗和预处理

#### 3.1.1 文本数据的清洗和转换

文本数据清洗是数据预处理的重要步骤,它可以去除文本中的噪声和不一致性,提高后续分析的准确性。常用的文本数据清洗技术包括:

- **去除标点符号和特殊字符:**这些字符通常不包含有价值的信息,可以安全地删除。

- **转换大小写:**为了统一数据格式,可以将所有文本转换为小写或大写。

- **去除重复项:**重复的数据项会影响分析结果,需要将其删除。

- **分词和词干化:**将单词拆分成更小的单元(词干),可以提高文本匹配和分析的效率。

- **同义词替换:**将同义词替换为相同的单词,可以减少数据冗余并提高分析准确性。

#### 代码示例:

```python

import re

# 去除标点符号和特殊字符

def remove_punctuation(text):

return re.sub(r'[^\w\s]', '', text)

# 转换大小写

def convert_to_lowercase(text):

return text.lower()

# 去除重复项

def remove_duplicates(list):

return list(set(list))

# 分词

def tokenize(text):

return text.split()

# 词干化

def stem(word):

from nltk.stem import PorterStemmer

stemmer = PorterStemmer()

return stemmer.stem(word)

# 同义词替换

def replace_synonyms(text):

synonyms = {'good': 'excellent', 'bad': 'terrible'}

for word in text.split():

if word in synonyms:

text = text.replace(word, synonyms[word])

return text

```

#### 3.1.2 数据类型转换和格式化

数据类型转换和格式化是将数据转换为所需格式的过程。这对于确保数据的一致性和兼容性至关重要。常用的数据类型转换和格式化技术包括:

- **字符串到数字:**将字符串转换为数字类型,如整数或浮点数。

- **数字到字符串:**将数字转换为字符串类型,用于输出或存储。

- **日期和时间格式化:**将日期和时间数据转换为标准格式,如 ISO 8601。

- **布尔值转换:**将字符串或数字转换为布尔值(True/False)。

#### 代码示例:

```python

# 字符串到数字

def string_to_number(string):

return int(string) if string.isdigit() else float(string)

# 数字到字符串

def number_to_string(number):

return str(number)

# 日期和时间格式化

def format_datetime(datetime):

return datetime.strftime('%Y-%m-%d %H:%M:%S')

# 布尔值转换

def string_to_boolean(string):

return string.lower() in ['true', '1']

```

# 4. Python文件读取进阶应用

### 4.1 文件读取与数据库交互

#### 4.1.1 数据库连接和操作

**建立数据库连接**

```python

import mysql.connector

# 连接到数据库

connection = mysql.connector.connect(

host="localhost",

user="root",

password="password",

database="my_database"

)

# 创建游标对象

cursor = connection.cursor()

```

**执行SQL查询**

```python

# 执行查询

query = "SELECT * FROM my_table"

cursor.execute(query)

# 获取查询结果

result = cursor.fetchall()

# 打印查询结果

for row in result:

print(row)

```

**关闭连接**

```python

# 关闭游标

cursor.close()

# 关闭连接

connection.close()

```

#### 4.1.2 数据导入导出和处理

**数据导入**

```python

# 从CSV文件导入数据

query = "LOAD DATA INFILE 'data.csv' INTO TABLE my_table"

cursor.execute(query)

# 从文本文件导入数据

query = "LOAD DATA LOCAL INFILE 'data.txt' INTO TABLE my_table"

cursor.execute(query)

```

**数据导出**

```python

# 导出数据到CSV文件

query = "SELECT * FROM my_table INTO OUTFILE 'data.csv'"

cursor.execute(query)

# 导出数据到文本文件

query = "SELECT * FROM my_table INTO OUTFILE 'data.txt'"

cursor.execute(query)

```

**数据处理**

```python

# 更新数据

query = "UPDATE my_table SET name='John' WHERE id=1"

cursor.execute(query)

# 删除数据

query = "DELETE FROM my_table WHERE id=1"

cursor.execute(query)

```

### 4.2 文件读取与机器学习

#### 4.2.1 数据集读取和预处理

**读取数据集**

```python

import pandas as pd

# 从CSV文件读取数据集

df = pd.read_csv("data.csv")

# 从文本文件读取数据集

df = pd.read_csv("data.txt", sep="\t")

```

**数据预处理**

```python

# 缺失值处理

df.fillna(df.mean(), inplace=True)

# 异常值处理

df.replace(to_replace=[np.inf, -np.inf], value=np.nan, inplace=True)

# 数据归一化

df.apply(lambda x: (x - x.min()) / (x.max() - x.min()), axis=0)

```

#### 4.2.2 机器学习模型训练和评估

**模型训练**

```python

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(df.drop("target", axis=1), df["target"], test_size=0.2)

# 训练模型

model = LinearRegression()

model.fit(X_train, y_train)

```

**模型评估**

```python

from sklearn.metrics import mean_squared_error

# 预测测试集

y_pred = model.predict(X_test)

# 计算均方误差

mse = mean_squared_error(y_test, y_pred)

# 打印均方误差

print("均方误差:", mse)

```

# 5.1 性能优化和可扩展性

### 5.1.1 文件读取性能优化策略

**1. 选择合适的读取模式**

根据文件读取场景,选择合适的读取模式,如 `'r'`、`'w'`、`'a'` 等,以避免不必要的IO操作。

**2. 使用缓存机制**

利用缓存机制,将频繁读取的数据存储在内存中,减少对磁盘的访问次数。

**3. 优化缓冲区大小**

调整缓冲区大小,平衡内存占用和IO性能。较大的缓冲区可减少IO次数,但会占用更多内存。

**4. 并发读取和异步处理**

在多核环境中,利用并发读取和异步处理技术,充分利用CPU资源,提高读取效率。

**5. 数据预读**

预读即将要读取的数据块,提前加载到内存中,减少实际读取时的等待时间。

### 5.1.2 可扩展性设计和架构考虑

**1. 分布式文件系统**

对于大规模文件读取,采用分布式文件系统,将文件存储在多个服务器上,实现负载均衡和可扩展性。

**2. 数据分区**

将大文件划分为多个分区,并分配给不同的服务器处理,提高并发性和可扩展性。

**3. 数据压缩**

对文件进行压缩,减少文件大小,降低网络传输和存储成本,提高读取效率。

**4. 云计算平台**

利用云计算平台提供的弹性计算和存储资源,实现按需扩展,满足业务需求的波动。

0

0