数据清洗与预处理:社交网络分析准确性保证手册

发布时间: 2024-09-08 04:56:17 阅读量: 166 订阅数: 67

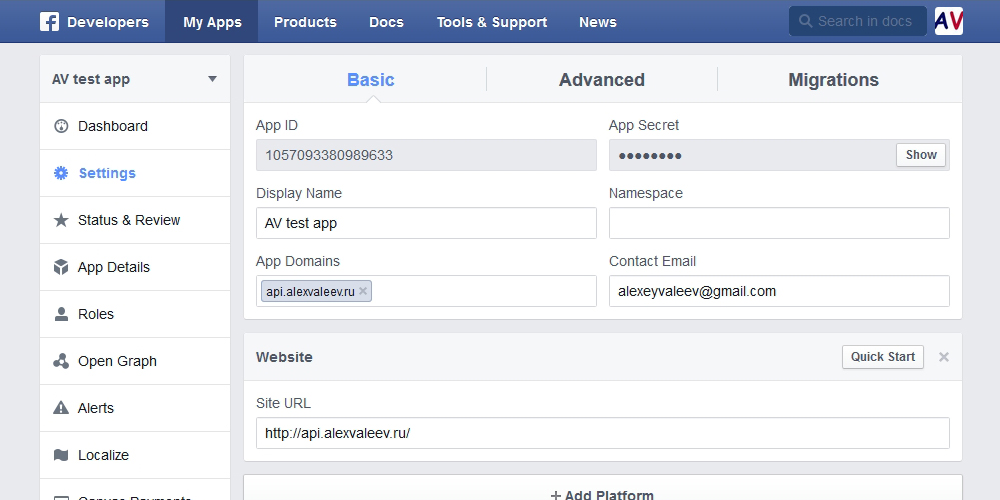

数据手册:用于数据的facebook

# 1. 数据清洗与预处理概述

在现代数据分析的背景下,数据清洗与预处理是构建高效、准确数据模型的关键步骤。数据清洗涉及识别并纠正或删除数据集中的错误和不一致,确保数据的质量和可信度。而数据预处理则是在建模之前,对数据进行转换和规范化的过程,为机器学习模型提供适合的输入。本章将概述数据清洗与预处理的基本概念,并阐述其在数据科学中的重要性,同时为后续章节的深入讨论奠定基础。

# 2. 数据清洗的技术与方法

### 2.1 数据清洗的基本步骤

#### 2.1.1 数据质量评估

在数据清洗的初步阶段,进行数据质量评估是至关重要的一步。有效的数据质量评估能够帮助我们识别数据中潜在的问题,从而采取适当的清洗策略。

- **数据完整性**:检查数据集中是否存在缺失值或不完整记录,这些通常会在记录的某个字段缺失或字段内数据不完整时发生。

- **数据一致性**:确保数据在不同时间或不同来源中保持一致性。例如,日期格式应统一,没有逻辑上的矛盾。

- **数据准确性**:数据应反映真实情况,准确性评估通常需要领域知识,如检查一些极端或异常的值是否合理。

- **数据唯一性**:检查数据集中是否有重复的记录,这些记录可能会对后续分析产生误导。

#### 2.1.2 缺失数据处理

在数据集中,缺失数据是一个普遍的问题,处理缺失数据的方法包括删除、填充或预测缺失值。

- **删除缺失数据**:如果数据缺失并不影响数据集的代表性,可以考虑删除含有缺失值的记录。

- **填充缺失数据**:如果数据缺失值较多,可以考虑用平均值、中位数或众数填充。对于分类变量,可以使用众数填充。

- **预测缺失数据**:使用数据挖掘技术或统计模型来预测缺失值,例如使用K-最近邻(KNN)算法、回归模型等。

### 2.2 数据清洗的常用技术

#### 2.2.1 数据去重

数据去重主要目的是消除重复数据,保持数据的唯一性,防止在后续分析中出现偏误。

- **去重策略**:根据业务需求,选择合适的字段组合进行去重。例如,在社交网络数据中,如果确定一个用户唯一标识(如用户ID)是关键字段,那么以这个字段进行去重将是一个有效的策略。

- **去重方法**:可以使用SQL查询语句进行快速去重,例如,在MySQL中可以使用`DISTINCT`关键字;在Python中,可以利用`pandas`库的`drop_duplicates()`函数。

```python

import pandas as pd

# 读取数据集

data = pd.read_csv('social_network_data.csv')

# 去重操作,以用户ID为例

data_unique = data.drop_duplicates(subset=['user_id'])

# 保存去重后的数据

data_unique.to_csv('social_network_data_unique.csv', index=False)

```

#### 2.2.2 异常值检测与处理

异常值检测和处理是数据清洗过程中不可或缺的一环。异常值可能是由错误、噪声或其他不规则因素引起的。

- **异常值识别**:统计方法如箱形图、标准差和四分位数范围(IQR)是识别异常值的常用技术。

- **异常值处理**:对于确定是噪声的异常值,可以选择删除。对于有意义的异常值,可以尝试使用变换方法(如对数变换)或替换为缺失值后处理。

```python

# 使用Z分数识别异常值

from scipy import stats

import numpy as np

data['Z_score'] = np.abs(stats.zscore(data['feature']))

threshold = 3 # 阈值通常为3

outliers = data[np.abs(stats.zscore(data['feature'])) > threshold]

data_clean = data[data['Z_score'] <= threshold]

```

### 2.3 面向社交网络的数据清洗特点

#### 2.3.1 用户行为数据的清洗

社交网络中的用户行为数据通常包括点赞、评论、转发等。在清洗用户行为数据时,需要考虑的问题包括无效行为的过滤和异常行为的识别。

- **无效行为过滤**:对于一些系统自动生成的行为(如自动赞、机器刷赞),需要予以识别和删除。

- **异常行为识别**:通过分析用户行为的频率和模式,可以识别出可能由机器人或异常账号产生的行为。

#### 2.3.2 关系数据的清洗

社交网络中的关系数据是用户之间互动的体现,例如好友关系、关注关系等。关系数据清洗的关键是识别并处理异常或伪造的关系。

- **关系验证**:确保所记录的关系是真实存在的,例如通过发送验证请求给两个用户,检查他们是否互相确认关系。

- **异常关系处理**:对于不真实或异常的关系(如大规模的双向关注,但互动频率极低),应根据业务规则进行清洗。

```python

# 例子:检查双向关注关系中是否一方未确认,可能为异常关系

data['is_mutual'] = data.apply(lambda row: row['user1_follows_user2'] == row['user2_follows_user1'], axis=1)

# 删除非互相关系

data清洗 = data[data['is_mutual']]

```

通过上述的步骤和策略,我们可以有效地对社交网络数据进行清洗,为后续的分析工作打下坚实的基础。接下来,我们将会深入到数据预处理的实践技术章节,探索如何通过标准化、归一化和编码等技术进一步提升数据质量。

# 3. 数据预处理的实践技术

### 3.1 数据标准化与归一化

#### 3.1.1 数据标准化的原理与应用

数据标准化是将数据按比例缩放,使之落入一个小的特定区间。在实践中,标准化后的数据通常具有均值为0和方差为1的特性。其原理主要基于将数据的原始值转换为距离平均值的标准差的倍数。这个技术在需要比较不同量纲的数据或进行基于距离的算法(如K-均值聚类)时尤其重要。

应用数据标准化,可以避免拥有较大数值范围的特征在模型训练中主导其他特征,从而导致模型难以收敛。在许多机器学习算法中,如支持向量机(SVM)、k最近邻(KNN)或神经网络中,使用标准化的数据可以提高算法的收敛速度和预测的准确性。

#### 3.1.2 数据归一化的策略和方法

数据归一化是指将数据缩放到一个特定的范围,通常是[0,1]区间。这种处理方法特别适用于那些取值范围固定的模型,比如神经网络的输入层

0

0