【深度学习RNN探索之旅】:李宏毅带你一窥循环神经网络的奥秘

发布时间: 2025-01-03 13:08:08 阅读量: 12 订阅数: 15

# 摘要

本文全面概述了深度学习中循环神经网络(RNN)的应用与发展。首先介绍了RNN的基本概念和理论基础,包括其数学模型、关键概念以及训练技巧。随后,详细探讨了RNN在自然语言处理中的主要应用,例如文本生成、机器翻译和情感分析。进一步地,文章拓展了RNN在时间序列预测、视频处理和语音识别等其他领域的应用探索。最后,针对RNN面临的前沿研究挑战,本文分析了RNN与新兴神经网络结构的结合,以及在大数据和边缘计算中的应用前景,同时指出未来研究的方向,包括提高RNN的可解释性和对量子计算技术的适应性。

# 关键字

深度学习;循环神经网络;自然语言处理;时间序列预测;视频处理;语音识别;大数据;边缘计算;前沿研究;量子计算

参考资源链接:[李宏毅深度学习教程:300页PPT详解入门技术](https://wenku.csdn.net/doc/1dqxzs6bvm?spm=1055.2635.3001.10343)

# 1. 深度学习与循环神经网络(RNN)概述

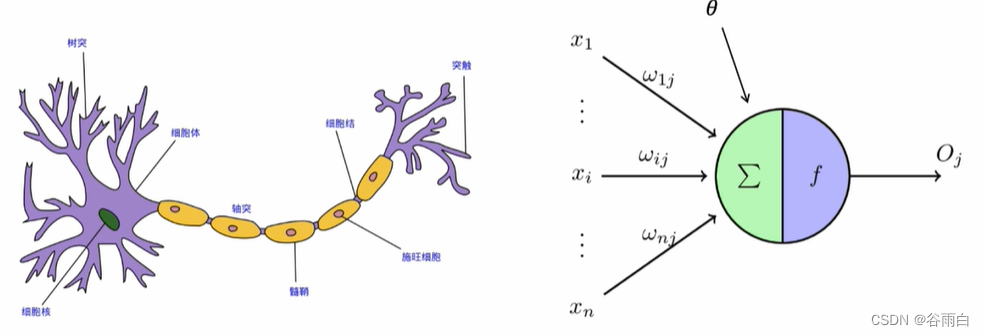

## 1.1 循环神经网络简介

循环神经网络(RNN)是一类用于处理序列数据的神经网络。在深度学习领域,RNN因其能够捕捉时间序列中的时间依赖关系,而广泛应用于语音识别、自然语言处理和时间序列预测等任务。其核心思想在于,网络能够将先前的信息与当前输入相结合,以形成一种记忆机制,这使得RNN在处理序列数据时具有独特的优势。

## 1.2 RNN的工作原理

RNN的工作原理是通过引入时间维度的循环连接,使得网络的输出能够反馈到自身,形成动态的网络状态。这种结构特别适合于处理如文本、音频和视频这样的顺序数据。在处理每个时间步的数据时,RNN会根据当前输入和前一个时间步的状态来更新当前状态,并生成输出。

## 1.3 RNN与深度学习的关系

RNN是深度学习中非常重要的模型之一,与其他深度学习模型如卷积神经网络(CNN)相比,RNN更擅长处理序列数据。尽管近年来长短期记忆网络(LSTM)和门控循环单元(GRU)等改进型RNN结构逐渐成为处理序列数据的主流,但基础的RNN结构依然是理解和应用这些先进模型的基础。

```markdown

在接下来的章节中,我们将深入探讨RNN的理论基础、在自然语言处理中的应用、以及其他领域的探索,以及RNN的前沿研究与挑战。

```

# 2. 循环神经网络的理论基础

### 2.1 循环神经网络的数学模型

#### 2.1.1 RNN的网络结构解析

循环神经网络(Recurrent Neural Network,RNN)是一种用于处理序列数据的深度学习模型。RNN的核心在于它能通过隐藏层状态(也称为隐藏状态)在时间步间传递信息,形成循环机制。与传统的前馈神经网络不同,RNN能够处理不同长度的序列数据,使得它在处理时间序列数据、自然语言、视频和音频信号等领域大显身手。

RNN的基本结构可以简单理解为包含有“记忆”的网络。网络的每一层都接收前一个时间步的隐藏状态作为输入,并输出当前时间步的隐藏状态。在t时刻,RNN的计算过程可以描述为:

h(t) = f(W * x(t) + U * h(t-1) + b)

其中,h(t)代表t时刻的隐藏状态,x(t)代表t时刻的输入数据,W和U是模型参数矩阵,b是偏置项,f是激活函数,如tanh或ReLU。

RNN的这个结构形式允许网络在时间步间传递信息。如果我们将RNN的每个时间步展开,可以观察到它其实是一个有环路连接的前馈网络。每一个时间步的输出不仅仅依赖于当前的输入,还依赖于之前的序列信息,这是RNN处理序列数据的核心优势。

#### 2.1.2 时间序列数据处理

时间序列数据是一系列按时间顺序排列的数值数据点,例如股票价格、天气数据、心跳信号等。在这些数据上应用机器学习模型时,往往需要考虑到数据的时间依赖关系。RNN之所以适合处理时间序列数据,是因为它的隐藏状态能够在时间步之间传递信息。

为了更好地处理时间序列数据,RNN采用了特定的架构设计,这包括:

1. 时序输入:模型的输入是一个时间序列,例如一组连续的股票价格,每一时间步对应一个输入值。

2. 时间步长:RNN会在每个时间步接收一个输入,并根据当前输入和之前时间步的隐藏状态计算当前时间步的隐藏状态。

3. 输出:输出可以是每个时间步的输出,也可以是最后时间步的输出,甚至是中间时刻的输出,具体取决于任务的需求。

一个典型的RNN在处理时间序列数据时的运作流程:

1. 初始化隐藏状态和单元状态,有时还涉及权重的初始化。

2. 对于序列中的每个时间步,RNN接收输入和前一个时间步的隐藏状态。

3. 使用激活函数处理当前输入和前一个隐藏状态,产生新的隐藏状态。

4. 将新的隐藏状态传递到下一个时间步,同时可以产生输出。

5. 这个过程一直持续到序列的结束。

处理时间序列数据时,RNN的关键挑战之一是长期依赖问题,即模型难以捕捉距离当前时刻较远的依赖关系,这正是下一节要讨论的梯度消失与梯度爆炸问题。

### 2.2 循环神经网络的关键概念

#### 2.2.1 隐藏状态和时间步长

隐藏状态是RNN中维持时序信息的核心组件。在每一个时间步,模型都会根据输入和前一个时间步的隐藏状态来更新当前时间步的隐藏状态。隐藏状态可以类比于人的记忆:它包含了之前所有输入的信息,并能够影响当前时刻的决策。

时间步长(time step)指的是序列中的一个时间点。在序列数据处理任务中,RNN按照时间步长逐步处理输入数据。每个时间步可以看作是一个独立的神经网络,这个网络的参数是共享的,但在不同时间步可以有不同状态。

隐藏状态和时间步长是相辅相成的。在时间步t的隐藏状态是模型在处理时间序列数据时,根据时间t-1之前所有信息计算得到的中间结果。这个中间结果对于理解时间序列中每个时间点的数据非常关键。没有隐藏状态,RNN将无法保持序列信息,也就无法解决序列中的长期依赖问题。

#### 2.2.2 梯度消失与梯度爆炸问题

梯度消失和梯度爆炸是RNN在训练过程中常常遇到的两大难题。这两个问题都与反向传播算法有关,是导致RNN难以学习序列中长期依赖关系的主要原因。

1. **梯度消失(Vanishing Gradient)**:

在RNN中,梯度消失问题通常发生在反向传播过程中,由于链式法则,梯度会随着每一步的反向传播而逐层相乘。如果每一层的梯度都小于1,那么相乘的结果会指数级下降,导致深层网络的梯度趋于零。这意味着深层的隐藏层权重无法得到有效更新,模型难以捕捉到长距离的依赖关系。

解决梯度消失的方法包括:

- 使用ReLU等非饱和激活函数来减少梯度消失的风险。

- 采用梯度剪切(Gradient Clipping)来防止梯度过小。

- 使用LSTM或GRU等设计来改善长期依赖性。

2. **梯度爆炸(Exploding Gradient)**:

相反,梯度爆炸问题发生在梯度较大时,反向传播会导致梯度不断增大,最后可能会导致权重更新过大,使得模型训练过程不稳定。梯度爆炸可能导致模型在训练数据上过拟合,或者权重更新过大而发散。

应对梯度爆炸的方法通常包括:

- 正则化技术,如L1和L2正则化来限制权重的增长。

- 梯度剪切,通过设置阈值来限制梯度的大小。

- 使用适当的初始化方法,比如He初始化或者Xavier初始化。

这些梯度问题对RNN的设计和优化提出了挑战,也促使研究人员开发出更加先进的RNN变体,例如LSTM和GRU。

#### 2.2.3 长短期记忆网络(LSTM)和门控循环单元(GRU)

由于传统的RNN在处理长期依赖问题上的局限,研究人员开发了两种新型的RNN结构:长短期记忆网络(LSTM)和门控循环单元(GRU),它们通过引入“门”机制来调节信息的流动,解决了传统RNN难以捕捉长期依赖的问题。

**长短期记忆网络(LSTM)**

LSTM的核心是引入了三个门:遗忘门(forget gate)、输入门(input gate)、输出门(output gate),以及一个单元状态。这些门结构控制信息的流入、保存和流出,从而允许网络在必要时维持长期信息。

- **遗忘门**:决定哪些信息需要从单元状态中丢弃。

- **输入门**:控制新输入数据应该在多大程度上更新单元状态。

- **输出门**:决定下一个隐藏状态输出什么信息。

公式层面,对于第t个时间步,LSTM的隐藏状态和单元状态更新如下:

f(t) = σ(Wf * [h(t-1), x(t)] + b_f)

i(t) = σ(Wi * [h(t-1), x(t)] + b_i)

o(t) = σ(Wo * [h(t-1), x(t)] + b_o)

c̃(t) = tanh(Wc * [h(t-1), x(t)] + b_c)

c(t) = f(t) * c(t-1) + i(t) * c̃(t)

h(t) = o(t) * tanh(c(t))

其中,σ表示sigmoid函数,tanh表示双曲正切函数,W和b分别表示权重和偏置,c̃(t)是候选单元状态,c(t)是单元状态

0

0