深入理解Logistic回归:R语言中的参数估计和模型选择

发布时间: 2024-11-04 03:32:19 阅读量: 70 订阅数: 33

数据回归-儿童抑郁症调查中数据缺失情形下logistic回归模型参数的最大似然估计.pdf

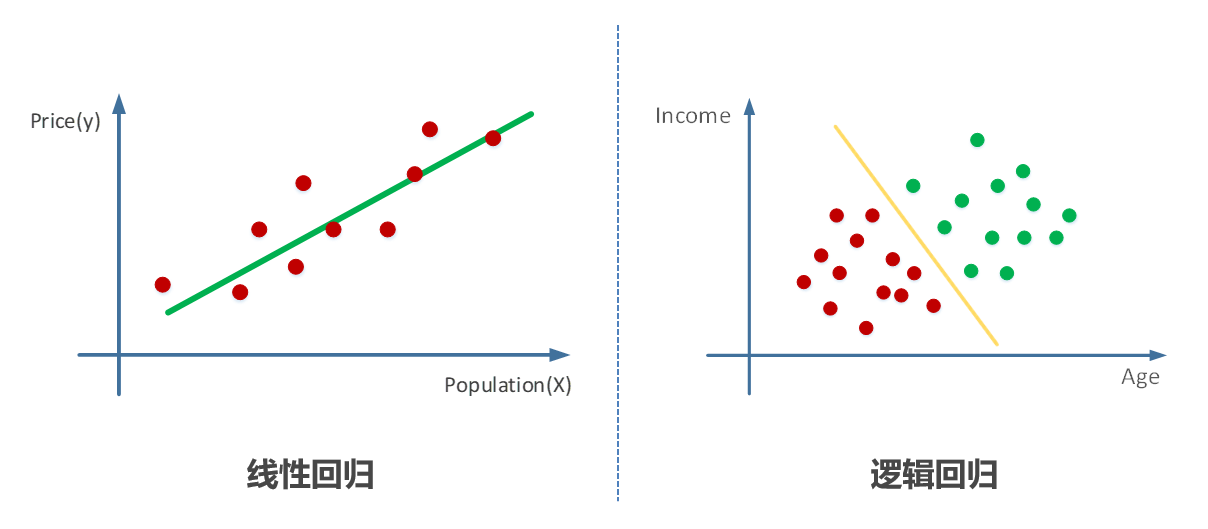

# 1. Logistic回归理论基础

Logistic回归是统计学和机器学习中常用的分类算法,主要用于估计某个事件发生的概率。其核心在于使用Logistic函数将线性回归的输出压缩至0和1之间,形成概率值。

## 1.1 Logistic回归的历史背景与发展

Logistic回归起源于生物学领域,最初用于描述生物种群增长的S型曲线。随后,这一模型被推广到统计领域,特别是在医学和生物统计领域中用于疾病风险因子的分析。

## 1.2 Logistic回归模型的基本原理

Logistic回归通过一个logistic函数,通常表示为sigmoid函数,将线性模型的预测值映射到概率空间。模型的参数可以通过最大似然估计等方法得到,其数学表达式为:

\[ p(X) = \frac{1}{1 + e^{-(\beta_0 + \beta_1 X_1 + \ldots + \beta_n X_n)}} \]

其中,\( p(X) \)表示事件发生的概率,\( \beta_0, \beta_1, \ldots, \beta_n \)是模型参数,\( X_1, \ldots, X_n \)是特征变量。

## 1.3 Logistic回归的应用场景

该模型广泛应用于二分类问题,例如疾病诊断、信用评分、邮件垃圾过滤等领域。随着技术的发展,Logistic回归也逐渐被用于多分类问题和回归问题的近似。

理解Logistic回归的基础理论是进行实际操作和应用的前提。接下来的章节我们将深入探讨如何使用R语言来实现Logistic回归模型,并对其进行评价、优化和应用。

# 2. 使用R语言实现Logistic回归

### 2.1 Logistic回归模型的构建

#### 2.1.1 模型的数学基础

Logistic回归是一种广泛应用于分类问题的统计模型,其模型的核心在于使用Sigmoid函数将线性回归的输出映射到概率空间。对于二分类问题,给定一组观测数据,其中包括自变量 \(X\) 和因变量 \(Y\),其中 \(Y\) 为二项分布,即 \(Y\) 的取值为0或1。Logistic回归模型的数学表达式如下:

\[ P(Y=1|X) = \frac{1}{1 + e^{-(\beta_0 + \beta_1 X_1 + \cdots + \beta_k X_k)}} \]

这里,\(P(Y=1|X)\) 表示给定输入 \(X\) 的条件下,因变量 \(Y\) 取值为1的概率。参数 \(\beta_0, \beta_1, \ldots, \beta_k\) 是模型系数,需要通过数据估计得到。

#### 2.1.2 模型的R语言实现

在R语言中,我们可以使用 `glm()` 函数来实现Logistic回归模型。`glm()` 函数不仅可以拟合广义线性模型,还能自动选择正确的链接函数。下面是使用 `glm()` 函数构建Logistic回归模型的基本代码示例:

```R

# 假设我们有一个数据框df,包含变量Y(因变量)和X1, X2, ..., Xk(自变量)

# Y为二分类响应变量,X1, X2, ..., Xk为预测变量

# 构建Logistic回归模型

logit_model <- glm(Y ~ X1 + X2 + ... + Xk, data = df, family = binomial)

# 输出模型摘要查看结果

summary(logit_model)

```

在模型拟合之后,我们可以通过检查模型摘要来评估系数的显著性、模型的整体拟合优度等。

### 2.2 Logistic回归参数估计

#### 2.2.1 最大似然估计

参数估计是构建Logistic回归模型的关键步骤之一。最常用的方法是最大似然估计(Maximum Likelihood Estimation,MLE)。MLE试图找到一组参数值,这组参数使得观测到的数据出现的概率最大。对于Logistic回归,我们通过迭代优化似然函数来估计模型参数 \(\beta\)。

#### 2.2.2 R语言中的参数估计方法

在R中,参数估计过程是由 `glm()` 函数在拟合模型时自动完成的,但我们可以自定义优化算法和相关参数。下面是使用 `glm()` 函数默认方法估计Logistic回归参数的代码:

```R

# 拟合模型

logit_model <- glm(Y ~ X1 + X2 + ... + Xk, data = df, family = binomial)

# 模型的系数是通过最大似然估计得到的

coefficients(logit_model)

```

### 2.3 Logistic回归模型的评价

#### 2.3.1 模型拟合优度检验

模型拟合优度检验是用来评价Logistic回归模型是否很好地拟合了数据的一种方法。通常,我们可以使用皮尔逊卡方检验、偏差卡方检验和Hosmer-Lemeshow拟合优度检验等。

#### 2.3.2 模型的分类准确性评估

分类准确性评估涉及将预测值与实际值进行比较,以确定模型对新数据的预测能力。常见的评估指标有准确率、召回率、精确度、F1分数和ROC曲线下的面积(AUC)等。

在R中,我们可以使用 `caret` 包来评估分类模型的性能。下面是一个基本的性能评估代码示例:

```R

# 安装并加载caret包

install.packages("caret")

library(caret)

# 使用caret包进行模型性能评估

confusionMatrix(predict(logit_model, newdata = test_data), test_data$Y)

```

请注意,上述代码仅为示例,实际使用时需要根据具体数据集调整。在实际数据分析中,数据预处理、模型构建和评估是一个连续且迭代的过程。通过不同方法的选择和优化,可以显著提高模型的预测能力。

# 3. Logistic回归模型选择与优化

## 特征选择方法

### 单变量特征选择

在处理数据集时,单变量特征选择是一个常用的初步筛选方法。它通过测试每个单独的特征与响应变量之间的关系来选择最重要的特征。单变量特征选择的一个常用方法是卡方检验,该方法主要用于分类变量之间的独立性检验。

#### 单变量特征选择步骤:

1. **卡方检验**:检验特征和目标变量之间的独立性。一个高的卡方值表明特征和目标变量之间有关联。

2. **特征选择**:根据卡方检验的结果,选择与目标变量关联性最强的特征。

3. **特征评分**:为每个特征分配一个评分,评分反映了该特征在预测目标变量方面的重要性。

在R语言中,可以使用`chisq.test()`函数执行卡方检验。以下是一个简单的示例:

```r

# 加载数据集

data <- read.csv("data.csv")

# 单变量特征选择

features <- data[, -which(names(data) == "target")]

# 计算卡方检验

chisq.values <- apply(features, 2, function(x) {

chisq.test(x, data[["target"]])$statistic

})

# 对特征进行排名

ranked.features <- order(-chisq.values)

selected.features <- names(features)[ranked.features]

# 输出选择的特征

print(selected.features)

```

### 多变量特征选择技术

尽管单变量特征选择方法简单且易于实现,但它忽略了一个事实:特征之间可能存在相互关联。因此,多变量特征选择技术应运而生,它考虑了特征之间的相互作用和依赖性。

#### 基于模型的多变量特征选择:

1. **模型拟合**:构建一个包含所有特征的模型。

2. **特征评分**:根据特征的系数或者重要性评分来选择特征。

3. **迭代优化**:通过迭代删除评分最低的特征,并重新拟合模型,直至达到满意的特征集。

在R语言中,可以使用`glmnet`包来实现基于L1正则化的多变量特征选择。以下是如何操作的例子:

```r

# 安装和加载glmnet包

install.packages("glmnet")

library(glmnet)

# 准备数据集

x <- model.matrix(target ~ ., data)[,-1]

y <- data$target

# 使用glmnet包进行模型拟合

cv_fit <- cv.glmnet(x, y, alpha = 1)

# 选择最优lambda值

best_lambda <- cv_fit$lambda.min

# 提取特征的系数

coef(cv_fit, s = best_lambda)

```

0

0