模型复杂度对部署影响:揭秘AI模型上线的关键因素

发布时间: 2024-11-23 14:48:56 阅读量: 29 订阅数: 29

关注AI模型上线、模型部署.rar

# 1. AI模型复杂度概述

在人工智能领域,模型复杂度是衡量模型性能和资源需求的关键因素之一。模型复杂度不仅体现在模型参数的数量上,还涉及到算法的复杂性、训练数据的规模以及模型推理时的计算量。随着深度学习技术的发展,更复杂的模型往往能提供更好的性能,但也带来了更多的计算和存储资源消耗。理解模型复杂度如何影响模型的性能和部署,对于实现高效、可扩展的AI系统至关重要。

在这一章中,我们将从以下几个方面对AI模型的复杂度进行概述:

- **模型参数与复杂度**:介绍模型参数数量与模型复杂度的关系。

- **计算资源需求**:分析不同复杂度模型对计算资源的需求。

- **优化与权衡**:探讨如何在复杂度、性能和资源之间进行有效平衡。

通过深入分析和讨论,我们能够更好地为后续章节中对模型优化与部署策略的探讨奠定基础。接下来的章节将具体探讨复杂度对性能的影响,并详细分析如何在实际应用中对模型进行优化和简化,最终实现高效部署。

# 2. 模型复杂度对性能的影响

## 2.1 模型参数和计算资源的关系

### 2.1.1 参数数量与硬件要求

在人工智能领域,模型的复杂度往往由其参数的数量来衡量。参数数量越多,模型越复杂,需要的计算资源也就越多。对于深度学习模型,参数可以是卷积神经网络中的卷积核大小、层数,或者是全连接神经网络中的节点数。随着参数数量的增加,模型对硬件的要求也随之提高。

硬件资源的瓶颈主要体现在两个方面:计算资源和存储资源。对于计算资源,随着参数的增加,模型需要更多的浮点运算来完成前向传播和反向传播过程。例如,对于一个大型深度学习模型,训练可能需要使用GPU或TPU等硬件加速器,这些硬件可以提供并行计算能力以加速模型训练过程。对于存储资源,模型参数和中间激活值的存储在大型模型中可能会占用大量内存,这限制了模型的规模和批量大小(batch size)。

### 2.1.2 计算资源的优化与分配

为了有效地使用有限的计算资源,我们需要优化和分配资源,以最大化模型训练和推理的效率。优化策略包括但不限于:

1. **模型并行**:将模型的不同部分分配到不同的计算单元上,使得可以同时在多个处理器上运行。

2. **数据并行**:在多个处理器上复制整个模型,并将数据分为多个批次并行处理。

3. **混合并行**:结合模型并行和数据并行的优势,对不同层次的计算资源进行优化。

4. **梯度累积**:当单个GPU内存不足以处理大型批量时,可以在多个小批量上累积梯度,然后执行权重更新。

5. **内存优化**:使用高效的数据格式(如half precision浮点数)来减少内存占用。

对于资源分配,需要根据硬件的特性、网络的结构以及训练任务的需求进行合理的规划。例如,对于具有多GPU节点的集群,可以使用分布式训练框架如Horovod或NCCL来分配计算任务,从而提高整体的训练速度。

## 2.2 模型复杂度与运行效率

### 2.2.1 实时性能与批处理能力

模型的复杂度直接影响其在实际应用中的运行效率,尤其是实时性能和批处理能力。实时性能通常指的是模型在单个数据点上进行推理的速度,而批处理能力则是指模型同时处理多个数据点的能力。在实际应用场景中,例如自动驾驶汽车的实时目标检测,或是在视频流上进行实时物体识别,都需要模型具有较高的实时性能。而批处理能力则在批量处理任务中变得十分重要,如在云服务上进行批量的图像分类。

模型复杂度的增加会导致运行效率降低,因为更多的计算量意味着更长的处理时间。复杂的模型可能需要更多的数据预处理和后处理步骤,以及更复杂的决策逻辑,这些都会影响到整体的运行时间。

### 2.2.2 资源消耗的衡量与比较

衡量资源消耗是评价模型性能的关键部分,这包括计算资源的使用(如FLOPS)、内存消耗、磁盘空间以及能量消耗。衡量这些指标可以帮助我们理解模型是否高效,以及它是否适合在特定硬件上运行。

为了比较不同模型的资源消耗,研究人员通常采用标准化的测试基准或测试套件,通过这些工具来量化模型的资源使用情况。例如,MobileNet和EfficientNet等轻量级网络架构就是为了降低资源消耗而设计的,它们通过各种技术如深度可分离卷积和神经结构搜索(NAS),大大减少了模型参数量和计算量。

## 2.3 模型压缩与加速技术

### 2.3.1 常见的模型压缩方法

模型压缩技术是优化模型性能的重要手段之一,它旨在减少模型的大小和提高推理速度,同时尽量保持模型的准确性。常见的模型压缩方法包括:

- **剪枝(Pruning)**:通过移除神经网络中不重要的权重或神经元来减少模型大小。

- **量化(Quantization)**:将模型中的权重和激活值从浮点数转换为低精度的数据类型,如int8或int16。

- **知识蒸馏(Knowledge Distillation)**:用一个小型网络学习大型网络的知识,这样可以压缩模型大小同时保持性能。

- **参数共享(Parameter Sharing)**:在模型中使用共享权重的机制,比如循环神经网络中的权重循环使用。

### 2.3.2 硬件加速器的应用与选择

随着模型复杂度的增加,仅依靠CPU进行模型训练和推理变得越来越不实际。因此,硬件加速器如GPU、FPGA和TPU在深度学习应用中变得越来越重要。这些加速器针对并行计算进行了优化,能够显著提升模型训练和推理的速度。

在选择合适的硬件加速器时,需要考虑到模型的类型、大小和应用场景。例如,对于大规模的深度学习模型和复杂的神经网络,使用GPU或TPU可能是更佳的选择,因为这些硬件提供了更高的计算能力和更大的内存容量。而对于对延迟敏感的应用,比如实时语音识别,可能会选择FPGA,它可以在保证足够性能的同时提供更低的延迟。

接下来,将介绍具体的模型压缩方法以及硬件加速器的实际应用案例,以展示如何根据不同的需求和场景选择和实施模型压缩与加速技术。

# 3. 模型优化与简化策略

## 3.1 模型剪枝与量化

### 3.1.1 剪枝原理及其对复杂度的影响

模型剪枝是一种有效的模型复杂度简化策略,它通过去除冗余的网络权重或神经元来降低模型的大小,同时尽量保持模型的性能。剪枝通常分为结构化剪枝和非结构化剪枝两种形式。结构化剪枝通常移除整个滤波器或者神经元,这使得剪枝后的模型能够更好地适应现有的深度学习加速器和推理引擎。而非结构化剪枝则移除单独的权重,这种剪枝方式虽然更灵活,但会降低硬件加速的效率。

剪枝过程往往涉及以下几个步骤:

1. 确定剪枝的准则,比如权重的大小、梯度的绝对值等。

2. 应用剪枝准则去除冗余的部分。

3. 重新训练模型以微调剩余的权重。

剪枝对复杂度的影响是直接的,它减少了模型参数的数量,从而减少了模型的存储需求和计算开销。在实际应用中,剪枝能够有效减少内存带宽的压力,并提升推理速度。然而,剪枝可能会降低模型的精度,因此需要在剪枝程度和模型性能之间找到一个平衡点。

### 3.1.2 量化技术概述及其优势

量化是一种将模型参数和激活值从高精度(如32位浮点数)转换为低精度(如8位整数)的技术。它通过减少表示数值所需的比特数来降低模型的存储和计算复杂度。量化技术可以在不显著影响模型性能的前提下大幅度提升运行效率。

量化的优势在于:

1. 减少内存占用:量化后的模型占用更少的内存空间。

2. 加速推理:低精度计算可以被更高效地实现,加速硬件上模型的推理过程。

3. 能耗降低:低精度运算减少了能耗,有利于在移动设备或边缘设备上部署。

在实施量化时,会遇到的挑战包括量化误差导致的精度损失和模型适应性问题。为了解决这些问题,研究人员开发了多种量化策略,例如感知量化(感知不同层对精度影响的量化策略)、权重量化和后训练量化。量化过程可以分为训练后量化和量化感知训练两种类型。训练后量化是在训练好的模型上直接进行量化操作,而量化感知训练则是在训练过程中模拟量化效果,以获得对量化更鲁棒的模型。

在进行量化时,模型转换工具(如TensorFlow Lite)和硬件加速器(如Google的Edge TPU)的支持对于简化部署流程尤为重要。

## 3.2 知识蒸馏与模型融合

### 3.2.1 知识蒸馏的原理与实践

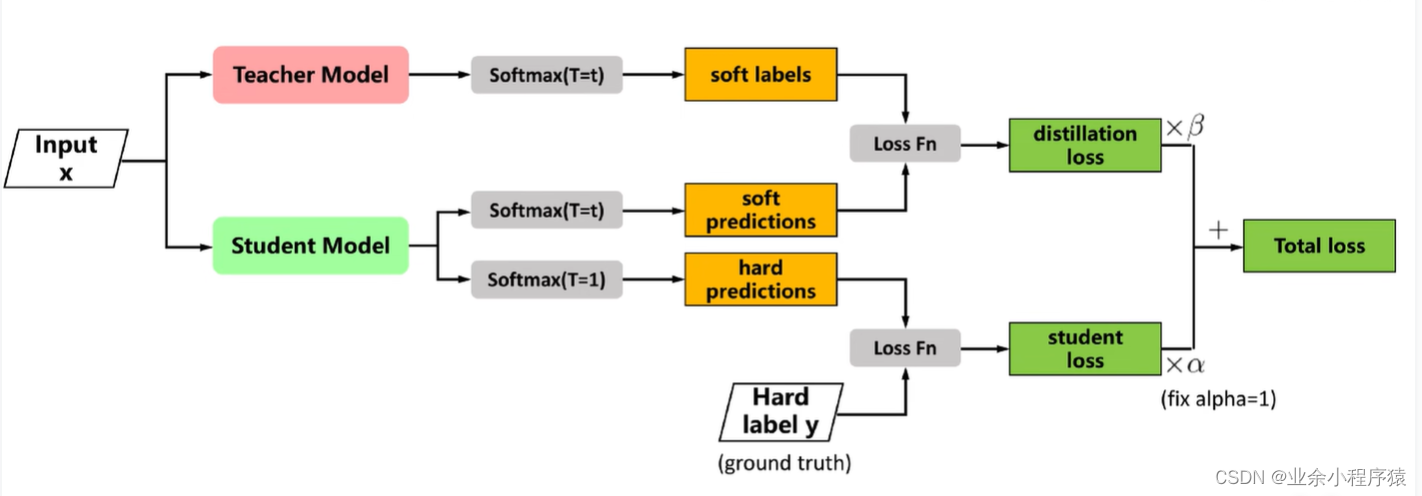

知识蒸馏是一种通过迁移学习提高模型泛化能力的方法,它允许将一个复杂的大模型(教师模型)的知识迁移到一个更小、更简单的模型(学生模型)中。这种技术在简化模型的同时尽可能保留原始模型的性能。

知识蒸馏的核心思想是让学生模型学习教师模型的输出分布,而不仅仅是正确答案。这通常通过最小化学生模型输出的概率分布与教师模型输出的概

0

0