深度学习挑战:神经网络复杂度的控制与优化

发布时间: 2024-11-23 14:27:55 阅读量: 19 订阅数: 29

深度学习基础:神经网络+激活函数+反向传播+优化算法 理解网络结构,运用激活增强非线性,掌握反向调整参数,优化算法提升性能,赋能

# 1. 深度学习与神经网络基础

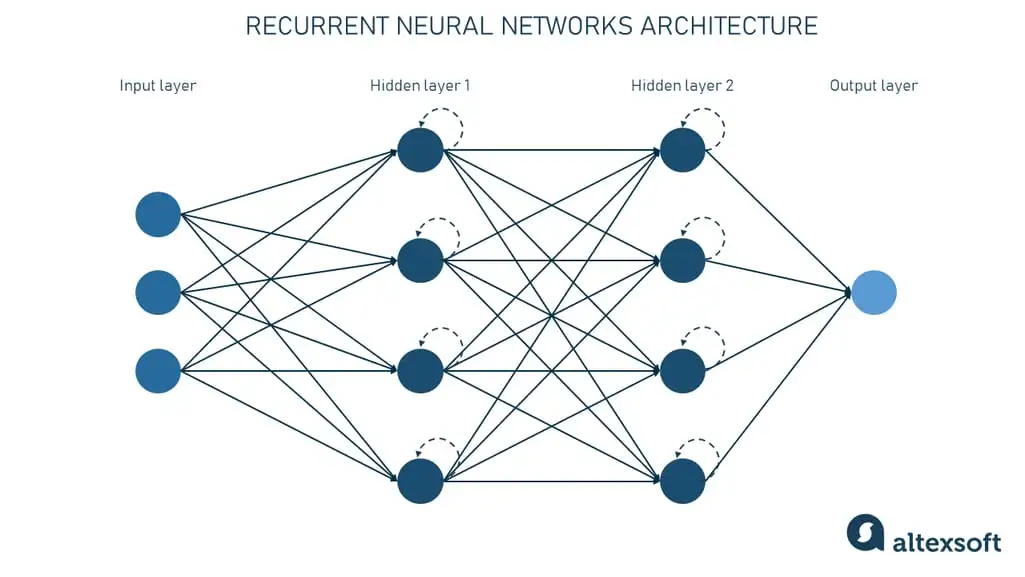

深度学习是机器学习的一个分支,它通过模拟人脑神经网络的结构和功能,使计算机能够自动从数据中学习到有用的特征表示。神经网络,作为深度学习的核心组成部分,由一系列相互连接的节点组成,它们模拟神经元的工作方式,通过权重和偏置来处理和传递信息。在本章中,我们将探讨神经网络的基本结构,包括输入层、隐藏层和输出层,以及这些层之间的连接是如何实现复杂的数据转换和模式识别的。

## 1.1 神经网络的基本组成

神经网络的基本单元是神经元,也被称作节点。每个神经元接收来自上一层的输入,对这些输入进行加权求和,并通过激活函数转换为输出。激活函数的引入是为了在神经元的输出中加入非线性因素,从而使网络能够学习和表示复杂的函数。

## 1.2 前向传播与反向传播

在神经网络中,信息的流动遵循前向传播(Forward Propagation)的路径,即从输入层经过隐藏层到达输出层。如果输出结果与实际目标不符,将通过反向传播(Backpropagation)算法来调整网络中的权重和偏置。这一过程是通过计算损失函数对各个参数的梯度,并利用梯度下降算法更新参数来完成的。

## 1.3 激活函数的选择

选择合适的激活函数对于神经网络的性能至关重要。常见的激活函数包括Sigmoid、Tanh和ReLU等。Sigmoid和Tanh函数在过去较为流行,但它们在实际应用中存在梯度消失的问题,而ReLU及其变体(如Leaky ReLU)由于在训练过程中能缓解梯度消失问题,因此成为了深度网络中更受欢迎的选择。

# 2. 神经网络复杂度的影响因素

### 2.1 模型规模与深度

在构建神经网络时,模型的规模与深度是影响其复杂度的两个重要方面。模型规模通常指的是神经网络中参数的总数,而深度则指的是网络中层数的多少。这两者在很大程度上决定了网络的学习能力和泛化能力。

#### 2.1.1 神经元与层数的影响

神经元的数量决定了网络的宽度,而层数则决定了网络的深度。增加神经元的数量可以提高模型对数据特征的学习能力,但同时会增加模型的参数量,导致过拟合的风险。对于层数,深层网络能学习更复杂的函数映射,但同样也会增加模型的复杂度和训练难度。

#### 2.1.2 参数量与模型容量

参数量是衡量模型复杂度的重要指标,直接影响着模型的容量。模型容量指的是模型能够学习到的数据表示的复杂性。一个高容量的模型可以捕捉数据中更复杂的模式,但同时也更容易过拟合。因此,合理控制模型的参数量对于避免过拟合和提高模型泛化能力至关重要。

### 2.2 过拟合与欠拟合问题

过拟合和欠拟合是训练神经网络时经常遇到的两大问题,它们直接影响着模型的性能。

#### 2.2.1 过拟合的成因与危害

过拟合是指模型在训练数据上表现良好,但在未见过的测试数据上表现差。这通常是由于模型过于复杂,学习到了训练数据中的噪声而非潜在的分布规律。过拟合的危害在于使得模型的泛化能力下降,无法在新的数据上取得好的预测效果。

#### 2.2.2 欠拟合的成因与识别

与过拟合相反,欠拟合是指模型过于简单,无法捕捉数据中的基本规律,这通常由于模型的容量不足或者训练不充分导致。识别欠拟合的简单方法是观察训练集和测试集的误差,如果二者都很高,那么可能就是发生了欠拟合。

### 2.3 网络正则化技术

为了解决过拟合问题,引入了网络正则化技术,其中包括L1和L2正则化,以及Dropout技术。

#### 2.3.1 L1和L2正则化

L1和L2正则化通过在损失函数中加入正则项来约束模型权重的大小。L1正则化倾向于产生稀疏权重矩阵,有助于特征选择;L2正则化则倾向于使权重在数值上更小,从而限制模型复杂度。这两种正则化方式都能在一定程度上防止过拟合。

#### 2.3.2 Dropout正则化方法

Dropout是一种在训练过程中随机丢弃(暂时移除)网络中的部分神经元的方法。这样做可以减少神经元之间的复杂共适应关系,迫使网络学习更加鲁棒的特征。Dropout在防止过拟合方面十分有效,并且在多种模型中得到了广泛的应用。

### 2.4 实际应用案例分析

为了更好地理解这些理论知识,下面给出一个简单的案例分析。这里以一个二分类问题为例,比较在不同正则化技术下模型的表现。

```python

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2, n_redundant=10, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 不使用正则化

model_no_reg = LogisticRegression(solver='lbfgs', max_iter=1000)

model_no_reg.fit(X_train, y_train)

y_pred_no_reg = model_no_reg.predict(X_test)

print(f'Accuracy without regularization: {accuracy_score(y_test, y_pred_no_reg)}')

# L2正则化

model_l2_reg = LogisticRegression(solver='lbfgs', max_iter=1000, penalty='l2', C=1.0)

model_l2_reg.fit(X_train, y_train)

y_pred_l2_reg = model_l2_reg.predict(X_test)

print(f'Accuracy with L2 regularization: {accuracy_score(y_test, y_pred_l2_reg)}')

# Dropout正则化(假设在神经网络中使用)

# 这里模拟Dropout效果,由于这里使用的是LogisticRegression,非神经网络模型,不直接展示Dropout应用代码。

```

通过上述案例,可以观察到在不同正则化技术下模型准确度的变化,并且可以通过比较识别出哪一种技术更适合当前问题。在实际的神经网络应用中,可以使用框架中内置的正则化方法,如TensorFlow或PyTorch中的Dropout层。

在这一章中,我们详细探讨了影响神经网络复杂度的因素,从模型规模与深度的讨论,到过拟合与欠拟合问题的分析,再到网络正则化技术的应用。这些知识点的深入理解对于设计有效的神经网络模型至关重要。

在下一章节中,我们将继续深入探讨如何通过优化算法提升神经网络的性能,以及这些算法是如何在实际中被应用和调整的。

# 3. 神经网络优化算法

## 3.1 梯度下降及其变体

### 3.1.1 基本梯度下降法

梯度下降算法是优化神经网络中最重要的算法之一。它通过迭代地在损失函数的梯度的反方向上更新参数来最小化损失函数。这一过程可以形式化地表达为:

```python

# 假设 θ 是模型参数,J(θ) 是损失函数,η 是学习率。

θ = θ - η * ∇J(θ)

```

在该公式中,η 表示学习率,它决定了每一步更新的步伐大小。学习率过大,可能导致收敛不稳定;过小则收敛速度过慢。

梯度下降的一个主要缺陷是容易陷入局部最小值,并且在非凸优化问题中可能不会收敛到全局最小值。此外,对于某些具有复杂形状的损失函数,梯度下降也可能非常慢。

### 3.1.2 动量法与Nesterov加速梯度

动量法(Momentum)通过引入一个“动量项”来加速梯度下降。这个动量项可以看做是梯度的一个滑动平均值,它帮助网络更快地收敛,减少震荡。Nesterov加速梯度(NAG)是动量法的一个变种,它在计算梯度之前先做一个预测,即先按上一步的梯度方向加速,再根据加速后的点计算梯度。

以下是动量法的伪代码:

`

0

0