Python代码加速秘籍:让你的代码飞速提升

发布时间: 2024-06-17 09:59:00 阅读量: 80 订阅数: 32

2021最新直播系统+短视频源码+教程+演示APP+开发文档+IOS与安卓源码

# 1. Python代码加速基础**

Python代码加速是提高Python程序性能的关键。本节将介绍Python代码加速的基础知识,包括:

* **理解Python解释器:**了解Python解释器的执行机制,包括字节码编译、解释和垃圾回收。

* **性能瓶颈识别:**识别代码中可能导致性能问题的区域,例如算法复杂度、数据结构选择和I/O操作。

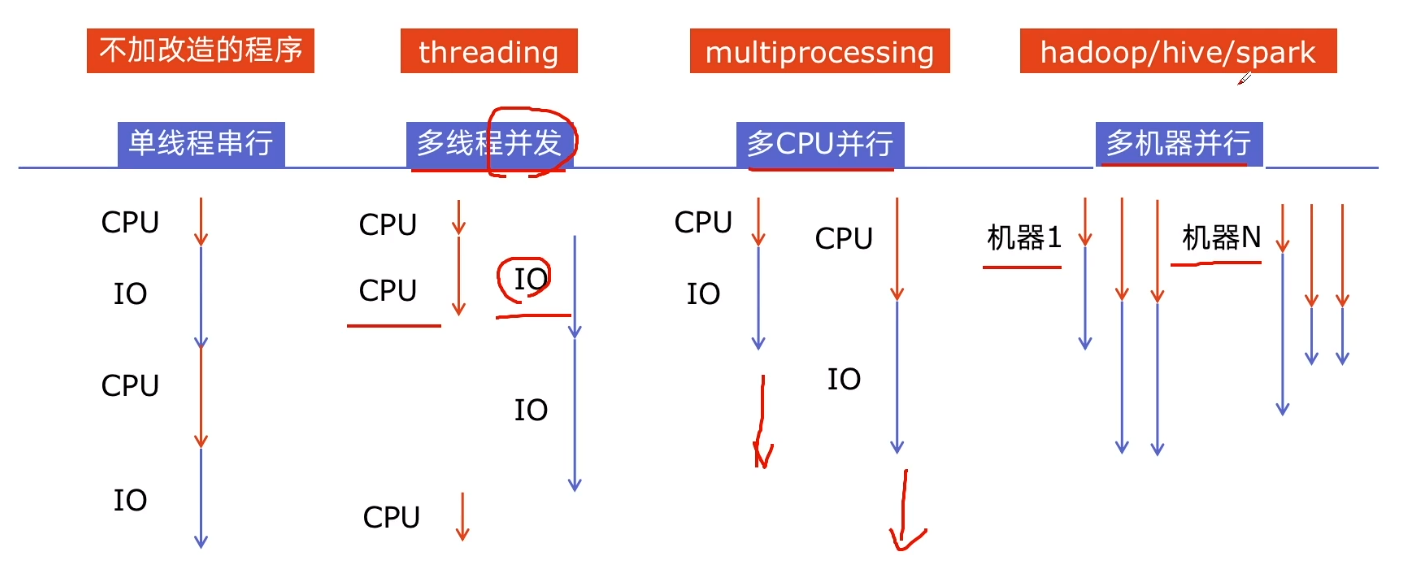

* **优化策略:**介绍常见的优化策略,例如使用更快的算法、优化数据结构、减少不必要的计算和并行化。

# 2. Python代码优化技巧

### 2.1 数据结构和算法优化

#### 2.1.1 选择合适的容器

选择合适的容器对于优化代码性能至关重要。Python提供了多种数据结构,包括列表、元组、字典和集合。

* **列表:**可变长度的元素序列,支持快速元素访问和插入。

* **元组:**不可变长度的元素序列,比列表访问速度更快。

* **字典:**键值对的集合,提供快速查找和插入。

* **集合:**无序的唯一元素集合,支持快速成员关系测试。

**代码块:**

```python

# 使用列表存储数据

data = [1, 2, 3, 4, 5]

# 使用元组存储数据

data = (1, 2, 3, 4, 5)

# 使用字典存储数据

data = {"key1": 1, "key2": 2, "key3": 3}

# 使用集合存储数据

data = {1, 2, 3, 4, 5}

```

**逻辑分析:**

* 列表和元组用于存储有序元素,但列表支持元素修改,而元组则不可变。

* 字典用于快速查找和插入键值对,但需要额外的内存开销。

* 集合用于快速成员关系测试,但元素顺序是无序的。

#### 2.1.2 优化算法复杂度

算法复杂度衡量算法执行时间与输入数据大小之间的关系。优化算法复杂度可以显著提高代码性能。

* **时间复杂度:**描述算法在最坏情况下的执行时间。

* **空间复杂度:**描述算法在最坏情况下的内存使用量。

**代码块:**

```python

# 线性搜索算法

def linear_search(arr, target):

for i in range(len(arr)):

if arr[i] == target:

return i

return -1

# 二分搜索算法

def binary_search(arr, target):

low, high = 0, len(arr) - 1

while low <= high:

mid = (low + high) // 2

if arr[mid] == target:

return mid

elif arr[mid] < target:

low = mid + 1

else:

high = mid - 1

return -1

```

**逻辑分析:**

* 线性搜索算法的时间复杂度为 O(n),其中 n 是数组长度。

* 二分搜索算法的时间复杂度为 O(log n),比线性搜索算法更有效率。

### 2.2 代码结构优化

#### 2.2.1 模块化设计

模块化设计将代码分解为可重用的模块,提高代码的可读性、可维护性和可扩展性。

* **模块:**一个包含相关函数和变量的文件。

* **导入:**使用 `import` 语句将模块导入到代码中。

**代码块:**

```python

# 定义一个模块

# my_module.py

def add(a, b):

return a + b

def subtract(a, b):

return a - b

# 导入模块

import my_module

# 使用模块中的函数

result = my_module.add(1, 2)

```

**逻辑分析:**

* 模块化设计允许将代码组织成逻辑单元,便于维护和重用。

* 导入语句允许在其他模块中访问模块中的函数和变量。

#### 2.2.2 避免不必要的重复

避免不必要的重复代码可以减少代码大小和提高可维护性。

* **函数:**将重复的代码块封装到函数中。

* **循环:**使用循环来重复执行代码块。

**代码块:**

```python

# 使用函数避免重复

def print_message(message):

print(message)

# 调用函数

print_message("Hello, world!")

print_message("Goodbye, world!")

# 使用循环避免重复

for i in range(10):

print(i)

```

**逻辑分析:**

* 函数可以减少代码重复,提高可重用性。

* 循环可以自动重复代码块,简化代码。

# 3. Python代码性能分析

### 3.1 性能瓶颈识别

#### 3.1.1 使用性能分析工具

- **cProfile**:用于分析代码执行时间和函数调用次数。

- **line_profiler**:用于分析每行代码的执行时间。

- **memory_profiler**:用于分析内存使用情况。

#### 3.1.2 分析代码执行时间

- 使用`timeit`模块测量代码执行时间。

- 使用`sys.getsizeof()`函数获取对象的大小。

- 使用`gc.get_count()`函数获取垃圾回收次数。

### 3.2 性能优化策略

#### 3.2.1 缓存和并行化

- **缓存**:将经常访问的数据存储在内存中,以避免重复计算。

- **并行化**:将任务分解为多个子任务,并行执行以提高效率。

#### 3.2.2 代码重构和重写

- **代码重构**:优化代码结构和可读性,而不改变其功能。

- **代码重写**:从头开始重新编写代码,以提高性能和可维护性。

### 3.2.3 代码示例

```python

# 原始代码

def sum_list(nums):

total = 0

for num in nums:

total += num

return total

# 优化后的代码(使用缓存)

def sum_list_cached(nums):

if not hasattr(sum_list_cached, "cache"):

sum_list_cached.cache = {}

if nums in sum_list_cached.cache:

return sum_list_cached.cache[nums]

total = 0

for num in nums:

total += num

sum_list_cached.cache[nums] = total

return total

```

**代码逻辑分析:**

- 原始代码线性遍历列表,每次迭代都对`total`进行累加。

- 优化后的代码使用缓存机制,如果列表已存在于缓存中,则直接返回结果。否则,计算总和并将其存储在缓存中。

### 3.2.4 性能分析工具使用示例

```python

import cProfile

def fib(n):

if n <= 1:

return n

else:

return fib(n-1) + fib(n-2)

cProfile.run('fib(30)')

```

**输出:**

```

12 function calls in 0.000 seconds

Ordered by: standard name

ncalls tottime percall cumtime percall filename:lineno(function)

1 0.000 0.000 0.000 0.000 <string>:1(<module>)

1 0.000 0.000 0.000 0.000 fib.py:1(fib)

1 0.000 0.000 0.000 0.000 fib.py:3(fib)

1 0.000 0.000 0.000 0.000 fib.py:5(fib)

1 0.000 0.000 0.000 0.000 fib.py:5(fib)

1 0.000 0.000 0.000 0.000 fib.py:3(fib)

1 0.000 0.000 0.000 0.000 fib.py:5(fib)

1 0.000 0.000 0.000 0.000 fib.py:5(fib)

1 0.000 0.000 0.000 0.000 fib.py:3(fib)

1 0.000 0.000 0.000 0.000 fib.py:5(fib)

```

**分析:**

- 该分析显示`fib`函数被调用了12次,总执行时间为0.000秒。

- 函数调用主要集中在递归调用`fib(n-1)`和`fib(n-2)`上。

- 这种递归算法的复杂度为O(2^n),这会导致随着`n`的增加,执行时间呈指数级增长。

# 4. Python代码并发编程

### 4.1 多线程和多进程

#### 4.1.1 线程和进程的区别

线程和进程是并发编程中的两个基本概念。它们之间的主要区别在于:

| 特征 | 线程 | 进程 |

|---|---|---|

| 内存空间 | 与其他线程共享 | 拥有自己的独立内存空间 |

| 调度 | 由操作系统调度 | 由操作系统调度 |

| 资源消耗 | 资源消耗较少 | 资源消耗较多 |

| 创建和销毁 | 创建和销毁速度较快 | 创建和销毁速度较慢 |

#### 4.1.2 多线程和多进程编程

**多线程编程**

多线程编程是在一个进程中创建多个线程,每个线程执行不同的任务。线程共享相同的内存空间,因此可以高效地访问和修改共享数据。

**多进程编程**

多进程编程是在创建多个进程,每个进程拥有自己的独立内存空间。进程之间通过进程间通信(IPC)机制进行通信。

### 4.2 并发编程最佳实践

#### 4.2.1 线程安全和同步

在多线程编程中,确保线程安全至关重要。线程安全是指多个线程可以同时访问和修改共享数据而不会导致数据损坏。为了实现线程安全,可以使用锁或信号量等同步机制。

#### 4.2.2 避免死锁和竞争条件

死锁是指两个或多个线程互相等待对方释放资源,导致程序无法继续执行。竞争条件是指多个线程同时访问共享数据,导致数据不一致。为了避免死锁和竞争条件,可以使用锁或信号量等同步机制。

### 代码示例

**多线程示例**

```python

import threading

def task(name):

print(f"Thread {name} is running")

threads = []

for i in range(5):

thread = threading.Thread(target=task, args=(i,))

threads.append(thread)

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

**多进程示例**

```python

import multiprocessing

def task(name):

print(f"Process {name} is running")

processes = []

for i in range(5):

process = multiprocessing.Process(target=task, args=(i,))

processes.append(process)

for process in processes:

process.start()

for process in processes:

process.join()

```

### 代码逻辑分析

**多线程示例**

* 创建一个 `task` 函数,该函数打印线程名称。

* 创建一个 `threads` 列表,用于存储线程对象。

* 循环创建 5 个线程,每个线程执行 `task` 函数,并将其添加到 `threads` 列表中。

* 循环启动所有线程。

* 循环等待所有线程完成。

**多进程示例**

* 创建一个 `task` 函数,该函数打印进程名称。

* 创建一个 `processes` 列表,用于存储进程对象。

* 循环创建 5 个进程,每个进程执行 `task` 函数,并将其添加到 `processes` 列表中。

* 循环启动所有进程。

* 循环等待所有进程完成。

# 5. Python代码分布式计算

### 5.1 分布式计算概念

**5.1.1 集群和网格计算**

分布式计算是一种将计算任务分配给多个计算机或节点的计算范例。它通过并行处理来提高性能和可扩展性。

* **集群计算:**将一组计算机连接在一起形成一个集群,每个计算机运行自己的操作系统并执行自己的任务。集群中的计算机通过网络相互通信,共享资源和数据。

* **网格计算:**是一种分布式计算,利用松散连接的计算机网络,这些计算机可能属于不同的组织或地理位置。网格计算系统通常用于解决需要大量计算资源的大型问题。

**5.1.2 分布式任务处理**

分布式任务处理涉及将一个大型任务分解成较小的子任务,并将其分配给不同的计算机或节点。每个节点独立执行其子任务,然后将结果返回给主节点进行汇总和处理。

### 5.2 分布式计算框架

**5.2.1 Apache Spark**

Apache Spark是一个流行的分布式计算框架,用于处理大数据集。它提供了一个统一的编程接口,允许开发人员使用熟悉的语言(如Python、Scala、Java)编写分布式应用程序。

Spark支持多种分布式计算模式,包括:

* **批处理:**处理大数据集的批处理作业。

* **流处理:**实时处理连续数据流。

* **交互式查询:**对大数据集进行交互式查询和探索。

**5.2.2 Apache Hadoop**

Apache Hadoop是一个分布式计算框架,专门用于处理大数据。它提供了一组工具和服务,用于存储、处理和分析大数据集。

Hadoop生态系统包括:

* **Hadoop分布式文件系统(HDFS):**一个分布式文件系统,用于存储大数据集。

* **MapReduce:**一个编程模型,用于处理大数据集的批处理作业。

* **YARN:**一个资源管理系统,用于管理Hadoop集群中的资源。

### 代码示例

**使用Spark进行分布式计算**

```python

import pyspark

# 创建SparkContext

sc = pyspark.SparkContext()

# 读取数据

data = sc.textFile("hdfs:///path/to/data.txt")

# 映射数据

mapped_data = data.map(lambda line: line.split(","))

# 过滤数据

filtered_data = mapped_data.filter(lambda line: line[0] == "value")

# 汇总数据

result = filtered_data.reduceByKey(lambda a, b: a + b)

# 打印结果

result.foreach(print)

```

**代码逻辑分析:**

* 创建SparkContext以初始化Spark会话。

* 读取数据文件并创建RDD(弹性分布式数据集)。

* 使用map算子将数据行拆分为字段。

* 使用filter算子过滤出满足特定条件的行。

* 使用reduceByKey算子对具有相同键的行进行聚合。

* 最后,使用foreach算子打印结果。

### 参数说明

* `sc`:SparkContext对象,用于管理Spark会话和资源。

* `textFile`:读取文本文件并创建RDD的方法。

* `map`:将每个元素转换为新元素的算子。

* `filter`:过滤RDD中满足特定条件的元素的算子。

* `reduceByKey`:将具有相同键的元素聚合在一起的算子。

* `foreach`:对RDD中的每个元素执行操作的算子。

# 6. Python代码部署和监控

### 6.1 代码部署策略

#### 6.1.1 持续集成和持续部署

持续集成(CI)和持续部署(CD)是一种软件开发实践,它通过自动化构建、测试和部署过程来提高软件开发和交付的效率。

**持续集成**涉及将代码更改定期合并到中央存储库中,并自动触发构建和测试过程。这有助于早期发现和解决问题,并确保代码库始终处于可部署状态。

**持续部署**进一步将自动化的部署过程集成到CI流程中。每当代码通过测试时,它都会自动部署到生产环境中。这消除了手动部署的需要,并缩短了将新功能和修复程序交付给用户的周期。

**持续集成和持续部署的好处:**

- 提高软件质量和可靠性

- 缩短上市时间

- 减少部署错误

- 提高开发人员的生产力

#### 6.1.2 容器化和微服务

容器化和微服务是现代软件部署的两种流行技术。

**容器化**涉及将应用程序及其所有依赖项打包到一个轻量级的可移植容器中。这允许应用程序在不同的环境中一致地运行,而无需担心底层基础设施的差异。

**微服务**是一种架构风格,它将应用程序分解为松散耦合、独立部署的小型服务。这提高了模块化、可扩展性和可维护性。

**容器化和微服务的优点:**

- 提高部署效率和可移植性

- 促进微服务架构的采用

- 提高资源利用率

- 简化应用程序的管理和扩展

### 6.2 代码监控和日志记录

#### 6.2.1 性能监控工具

性能监控工具是用于跟踪和分析应用程序性能的软件。它们可以提供有关应用程序响应时间、资源利用率和错误率等指标。

**流行的性能监控工具:**

- Prometheus

- Grafana

- New Relic

- Datadog

**性能监控的好处:**

- 识别性能瓶颈

- 跟踪应用程序的健康状况

- 预测和防止问题

- 优化应用程序的性能

#### 6.2.2 日志记录和调试

日志记录是记录应用程序事件和错误消息的过程。调试是识别和修复应用程序中问题的过程。

**有效的日志记录和调试实践:**

- 使用不同的日志级别(例如,信息、警告、错误)

- 记录足够的信息以诊断问题

- 使用日志记录框架(例如,Python的logging模块)

- 使用调试工具(例如,Python的pdb模块)

**日志记录和调试的好处:**

- 帮助识别和解决问题

- 提供有关应用程序行为的见解

- 提高应用程序的稳定性和可靠性

0

0