大数据时代背包算法的挑战:分布式处理策略剖析

发布时间: 2024-09-09 18:27:00 阅读量: 148 订阅数: 33

# 1. 背包问题与大数据的交集

背包问题,这个在计算机科学领域中被广泛研究的组合优化问题,近年来在大数据的语境下重新焕发了生机。随着数据量的爆炸性增长,如何在海量数据中找到最优解,已成为了一个关键的挑战。本章将探讨背包问题的基本原理以及其与大数据处理之间的交集,为我们后续章节关于背包问题在分布式计算框架中的实现打下坚实基础。

在大数据的背景下,背包问题不仅仅是理论上的优化难题,它也关乎实际应用,比如云计算中的资源分配、供应链优化、在线广告投放等。这些场景通常涉及大量的物品和动态变化的环境,传统的算法难以直接应用,因此需要新的解决方案。

我们将在接下来的章节中深入分析传统背包算法的局限性,以及大数据环境下对算法的实时性、效率和可扩展性要求,为探索分布式背包问题的处理策略提供必要的理论支撑。

# 2. 传统背包算法及其局限性

### 2.1 背包问题的定义和分类

背包问题是一类组合优化问题,常见的背包问题可以分为三种类型:0/1背包问题、分数背包问题和多重背包问题。每种类型的问题都有其独特的特点和应用场景。

#### 2.1.1 0/1背包问题

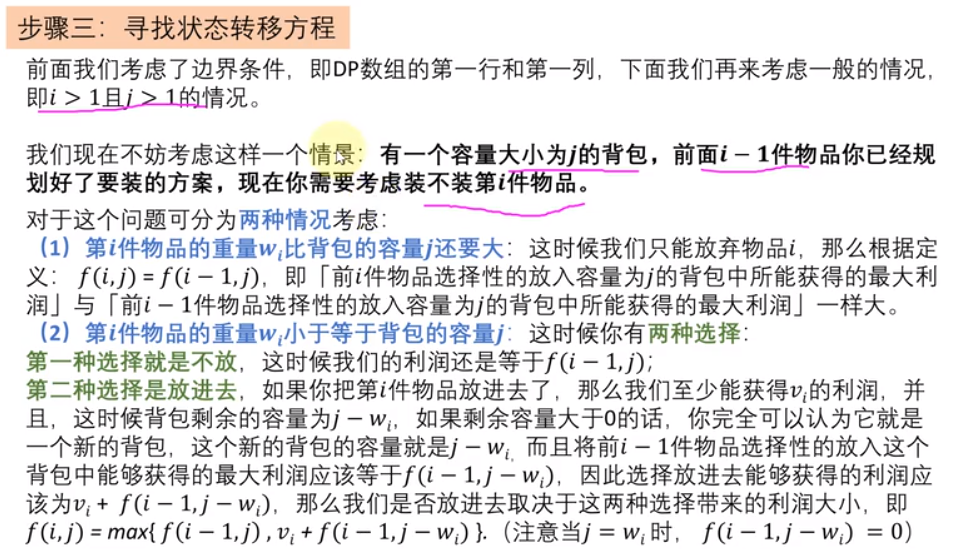

0/1背包问题是指在不超过背包承重的前提下,从一定数量的物品中选择一部分装入背包,每个物品只能选择装入或不装入,不能分割。这种问题的解决方案通常采用动态规划方法,创建一个二维数组来保存每个阶段、每种重量下的最大价值。

```python

def knapsack(values, weights, capacity):

n = len(values)

# 创建一个二维数组DP,初始化为0

dp = [[0 for _ in range(capacity + 1)] for _ in range(n + 1)]

# 填充DP数组

for i in range(1, n + 1):

for w in range(1, capacity + 1):

if weights[i-1] <= w:

# 选择当前物品和不选择当前物品的较大值

dp[i][w] = max(dp[i-1][w], dp[i-1][w-weights[i-1]] + values[i-1])

else:

dp[i][w] = dp[i-1][w]

return dp[n][capacity]

```

#### 2.1.2 分数背包问题

分数背包问题允许物品被分割,可以装入背包的物品重量是0到物品完整重量之间的任何值。分数背包问题的解决一般使用贪心算法,通过物品的单位价值(价值/重量)进行排序,优先选择单位价值最高的物品。

```python

def fractional_knapsack(values, weights, capacity):

n = len(values)

# 按单位价值排序

items = sorted(zip(values, weights), key=lambda x: x[0]/x[1], reverse=True)

total_value = 0

for value, weight in items:

if weight <= capacity:

capacity -= weight

total_value += value

else:

total_value += value * (capacity / weight)

break

return total_value

```

#### 2.1.3 多重背包问题

多重背包问题是指每种物品有多个,需要决定每个物品装入背包的数量。这种问题较为复杂,解决方案通常是将问题分解为多个0/1背包问题,或者通过动态规划加二进制优化来降低时间复杂度。

```python

def multiple_knapsack(values, weights, quantities, capacity):

n = len(values)

# 创建一个二维数组DP,初始化为0

dp = [[0 for _ in range(capacity + 1)] for _ in range(n + 1)]

for i in range(1, n + 1):

for w in range(1, capacity + 1):

for q in range(1, quantities[i-1] + 1):

if weights[i-1] * q <= w:

dp[i][w] = max(dp[i][w], dp[i-1][w-weights[i-1] * q] + values[i-1] * q)

else:

break

return dp[n][capacity]

```

### 2.2 传统背包算法的性能分析

#### 2.2.1 时间复杂度和空间复杂度

背包问题的时间复杂度和空间复杂度很大程度上依赖于所使用的算法。例如,0/1背包问题使用动态规划时,时间复杂度为O(nW),空间复杂度同样为O(nW),其中n为物品数量,W为背包最大容量。

分数背包问题使用贪心算法时,时间复杂度为O(nlogn),主要是在排序上。空间复杂度则为O(n),仅需要存储物品的价值和重量。对于多重背包问题,时间复杂度和空间复杂度都会更高,尤其是使用动态规划时,时间复杂度可能达到O(n^2 * Σlogq_i),空间复杂度为O(nW)。

#### 2.2.2 算法适用范围和限制

背包问题的适用范围非常广泛,例如在资源分配、货物装载、投资组合优化等场景都有应用。然而,传统背包算法有其限制:

1. **数据规模限制**:在数据规模较大时,传统算法的时间复杂度和空间复杂度会导致计算资源的瓶颈。

2. **实时性限制**:在需要实时决策的场景下,传统背包算法可能无法满足实时性要求。

3. **多维度限制**:现实世界的问题往往涉及到多个维度的限制和目标函数,传统的单目标背包算法难以处理。

### 2.3 背包算法在大数据处理中的挑战

#### 2.3.1 数据量激增的影响

随着大数据时代的到来,数据量激增给传统的背包算法带来了挑战。大数据的体积、速度和多样性(3V特性)都对算法的性能和可扩展性提出了更高的要求。

#### 2.3.2 实时性要求对算法的影响

在大数据环境下,往往需要算法能够在极短的时间内做出决策,以满足实时性要求。这对算法的效率和并行化能力提出了挑战,传统算法很难达到这一要求。

请注意,此处所提供的是第二章内容的概要,具体章节内容需根据上一级目录框架详细展开。上述代码示例和性能分析可作为章节中的具体内容。实际章节内容应进一步扩展以满足字数和深度要求。

# 3. 背包问题的分布式处理策略

## 3.1 分布式计算框架概览

### 3.1.1 MapReduce模型简介

MapReduce是大数据领域应用广泛的一种编程模型,由Google提出,并在Hadoop项目中得到了广泛实现。该模型的基本思想是将计算过程分为Map和Reduce两个阶段。

**Map阶段**:数据分割后,每个分割的数据块由Map函数处理,生成键值对(key-value pairs)。

**Reduce阶段**:将具有相同key的键值对合并,并由Reduce函数处理,输出最终结果。

MapReduce框架负责处理任务调度、容错机制、数据分发等工作,开发者仅需关注Map和Reduce函数的实现。

### 3.1.2 Spark处理大数据的优势

Apache Spark是一个开源的分布式计算系统,相比于MapReduce,Spark具有诸多优势,特别是在处理需要迭代算法的场合,如机器学习、图处理和SQL查询等。

- **内存计算**:Spark将数据加载到内存中,大幅度提高了迭代运算的性能。

- **实时计算**:支持实时数据处理,可以构建基于事件流的应用程序。

- **易用性**:Spark提供了一组丰富的API,包括Scala、Java、Python等语言。

- **高级组件**:Spark生态系统包含了Spark SQL、Spark Streaming、MLlib(机器学习库)、GraphX(图处理库)等高级组件。

## 3.2 分布式背包算法的设计思路

### 3.2.1 数据分割与任务分配

为了在分布式系统中高效解决背包问题,首先需要将数据集合理性地分割,并分配到不同的计算节点。数据分割的策略

0

0