【防止过拟合】:掌握决策树剪枝技术,实现最佳模型性能

发布时间: 2024-09-04 17:34:49 阅读量: 51 订阅数: 39

# 1. 决策树剪枝技术概述

在机器学习领域,决策树作为一种常用的预测模型,因其模型直观、易于理解和解释,在各类分类和回归任务中广泛应用。但是,未加控制的决策树可能会过度拟合训练数据,导致泛化能力下降。此时,决策树剪枝技术应运而生,它通过减去决策树中不必要的部分来简化模型结构,提高决策树的泛化能力。

剪枝技术包括预剪枝和后剪枝两大类。预剪枝是在构建决策树的过程中提前停止树的增长,而后剪枝则是在决策树完全构建之后,再进行剪枝。两者各有优缺点,并适用于不同的场景,合理运用可以有效提升模型的稳定性和准确性。

在后续章节中,我们将详细介绍决策树的理论基础,深入探讨不同类型剪枝技术的实现方法,并通过实践操作来展示如何在真实世界问题中应用这些技术。我们还将评估模型性能,探索剪枝技术的高级应用以及未来的发展趋势。

# 2. 理论基础与剪枝方法

## 2.1 决策树的基本理论

### 2.1.1 决策树的构建过程

决策树是一种常见的机器学习算法,主要用于分类和回归问题。其构建过程可以分为三个基本步骤:特征选择、决策树生成以及树剪枝。

首先,特征选择的关键在于找到最佳分割点,即选择一个特征以及这个特征上的一个值来划分数据集,使得划分后各个子数据集中的目标变量尽可能属于同一类别或分布。

在决策树生成阶段,我们从训练数据中递归地选择最佳分割特征,并在每个节点上重复这一过程,直到满足停止条件。停止条件可以是所有实例属于同一类别,或者没有任何剩余特征可以进一步分割节点。

由于决策树倾向于学习到训练数据中的每一个细微之处,这可能导致模型过度拟合数据,降低模型的泛化能力。

### 2.1.2 决策树的分类与评估

决策树模型可以分为两大类:分类决策树和回归决策树。

分类决策树用于处理离散的标签,例如客户流失预测、邮件垃圾分类等,其中每个叶节点代表一种类别。

回归决策树则用于处理连续值输出,如房价预测、气温预测等,每个叶节点代表一个具体的数值。

决策树模型的评估一般使用准确率、精确率和召回率等指标。准确率是正确分类的实例数除以总实例数。精确率强调模型预测为正的样本中,实际为正的样本所占的比例。召回率则表示实际为正的样本中,模型预测为正的比例。

## 2.2 剪枝的必要性

### 2.2.1 过拟合与欠拟合的定义

过拟合(Overfitting)是指模型在训练数据上表现很好,但在未知数据上表现差的现象。它意味着模型学习到了训练数据的噪声和异常值,不能很好地推广到新数据。

欠拟合(Underfitting)则是指模型既不能很好地学习训练数据,也无法适用于未知数据。这通常是由于模型过于简单,无法捕捉数据中的模式和关系。

### 2.2.2 剪枝在防止过拟合中的作用

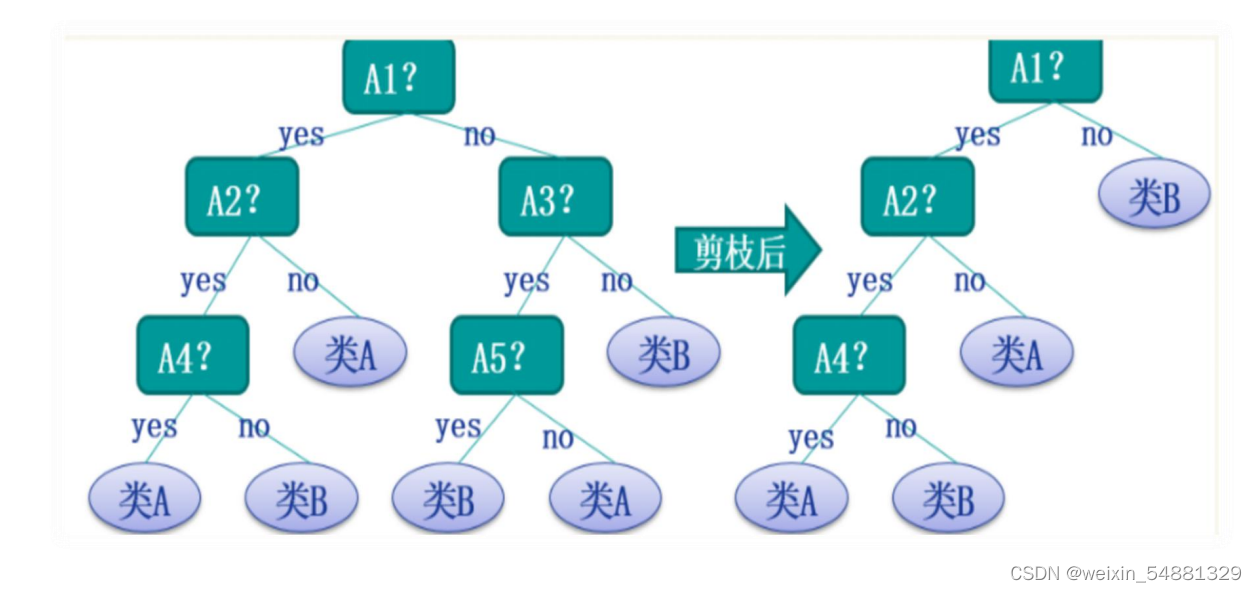

剪枝技术通过对决策树进行简化,去除一些不重要的节点,以减少决策树的复杂度,从而达到防止过拟合的目的。

预剪枝是在树生成过程中直接限制树的大小或深度,而后剪枝则是在树生成完成后,通过剪掉一些分支来减少模型复杂度。

## 2.3 剪枝技术的类型

### 2.3.1 预剪枝(Pre-pruning)

预剪枝通过在树的生成过程中引入限制条件来避免过拟合,这些条件包括但不限于:

- 最小样本分割:在分割一个节点之前,首先检查是否有足够的样本在该节点中。

- 最大深度:限制树的最大深度,防止树过度增长。

- 最小叶节点大小:对叶节点中必须包含的最少样本数设定限制,避免叶节点过小。

预剪枝的一个缺点是很难确定这些限制条件的最佳值,且如果设定的过紧,可能会导致欠拟合。

### 2.3.2 后剪枝(Post-pruning)

与预剪枝不同,后剪枝允许决策树完全生长,然后根据某种标准剪去一些节点。

这种方法的一个优点是可以更准确地评估剪枝后的性能,因为剪枝操作是在整体模型构建完成之后进行的。

### 代码示例与逻辑分析

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 假设 X_train, Y_train 已经是数据集和标签

X_train, X_test, Y_train, Y_test = train_test_split(X, y, test_size=0.2)

# 创建决策树模型实例,这里采用的是CART算法

dtree = DecisionTreeClassifier()

# 训练模型

dtree.fit(X_train, Y_train)

# 进行预测

predictions = dtree.predict(X_test)

# 评估准确率

accuracy = accuracy_score(Y_test, predictions)

print(f"Model Accuracy: {accuracy}")

```

以上代码创建了一个决策树分类器,并在训练集上进行了训练,然后在测试集上进行了预测并计算了准确率。预剪枝和后剪枝的逻辑是在创建`DecisionTreeClassifier`实例时通过设置其参数来实现的。

- `min_samples_split` 参数可以设定为限制节点分割前所需最小样本数。

- `max_depth` 参数可以限制决策树的最大深度。

- `min_samples_leaf` 参数可以限制叶节点的最小样本数。

- `ccp_alpha` 参数则是在后剪枝时,控制成本复杂度剪枝的参数。

在决策树的训练过程中,这些参数共同作用,防止模型过拟合或欠拟合,确保模型具有较好的泛化能力。

接下来,我们将深入探讨剪枝技术的实践操作,实际应用中如何实现预剪枝与后剪枝以及如何调整剪枝参数来优化模型。

# 3. 剪枝技术的实践操作

在前一章中,我们已经详细探讨了决策树剪枝理论基础与不同剪枝方法。在本章中,我们将深入实践操作,细致地介绍如何在实际应用中实施预剪枝和后剪枝,以及如何调整剪枝参数来优化决策树模型。

## 3.1 预剪枝的实现与应用

### 3.1.1 设定停止条件

预剪枝是在构建决策树的过程中进行的,目的是防止树过度生长。一种常见的方法是设定一个停止条件,这可以是树达到一定的深度、节点中的样本数小于某一阈值、或者信息增益小于某个阈值。

例如,通过`scikit-learn`库实现预剪枝的一个简单示例代码如下:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# 加载数据集

data = load_iris()

X_train, X_test, y_train, y_test = train_test_split(data.data, data.target, test_size=0.2, random_state=42)

# 创建决策树分类器,并设置预剪枝参数

clf = DecisionTreeClassifier(max_depth=3, min_samples_split=5, random_state=42)

clf.fit(X_train, y_train)

```

在上述代码中,`max_depth=3`限制了树的最大深度,而`min_samples_split=5`规定了内部节点需要至少有5个样本才能继续分割。

### 3.1.2 设置参数限制

预剪枝的另一个手段是限制决策树的生长。在`scikit-learn`中,我们可以设置`max_depth`、`min_samples_split`、`min_samples_leaf`等参数,这些参数都可以用来控制树的复杂度。

这些参数的设置需要根据具体问题和数据集进行调整。一种常见的实践是使用网格搜索(grid search)方法来寻找最佳的参数组合。

## 3.2 后剪枝的实现与应用

### 3.2.1 成本复杂度剪枝(Cost Complexity Pruning)

后剪枝是指先让树完全生长,然后对树进行剪枝。成本复杂度剪枝是一种常用的后剪枝方法,它通过剪去那些增加复杂度超过一定阈值的节点来实现。

在`scikit-learn`中,`DecisionTreeClassifier`类的`ccp_alpha`参数可以用来实现成本复杂度剪枝。`ccp_alpha`的值越大,剪枝越激进。

```python

from sklearn.datasets import make_classification

from sklearn.tree import DecisionTreeClassifier

# 创建一个合成数据集

X, y = make_classification(n_samples=1000, n_features=20, random_state=42)

# 使用不同的alpha值进行成本复杂度剪枝

clfs = []

for alpha in [0.0, 0.01, 0.1]:

clf = DecisionTreeClassifier(ccp_alpha=alpha)

clf.fit(X, y)

clfs.append(clf)

# 绘制树的结构

for clf in clfs:

tree.plot_tree(clf, filled=True, feature_names=[f'Featu

```

0

0