YOLOv8模型量化实战:资源消耗减半与效率提升的策略

发布时间: 2024-12-12 11:12:50 阅读量: 13 订阅数: 12

# 1. YOLOv8模型量化概述

## 1.1 量化技术的兴起背景

随着深度学习模型在各个领域的广泛部署,模型的大小和计算需求成为限制其实际应用的瓶颈。量化技术应运而生,它通过减少模型中权重和激活的精度来缩小模型体积并提高运行速度,从而解决上述问题。YOLOv8作为目标检测领域的领先模型之一,其量化研究对于推动实时目标检测技术具有重要意义。

## 1.2 量化方法的多样性与挑战

量化方法涵盖了从传统方法如二值化、三值化到更复杂的定点数和浮点数量化。不同的量化策略会对模型的准确度和性能产生不同的影响。选择合适的量化方法是实现高性能模型量化的重要环节。对于YOLOv8模型而言,如何在保持高准确度的同时实现有效的模型压缩和加速,是当前研究和实践的热点。

## 1.3 YOLOv8量化实践的意义

YOLOv8量化不仅有助于降低模型的内存占用,提高推理速度,还有助于减少能耗,这对于边缘计算、嵌入式设备等资源受限的平台尤为重要。通过量化,可以使得YOLOv8模型在各种智能硬件上更容易部署,从而拓展了其应用领域和商业价值。因此,深入理解YOLOv8模型量化的原理和实践方法,对于推动深度学习技术的广泛应用具有重要的意义。

# 2. YOLOv8模型基础与量化理论

## 2.1 YOLOv8模型架构解读

### 2.1.1 YOLOv8的发展与演进

YOLO(You Only Look Once)系列模型是实时目标检测领域中的佼佼者,YOLOv8作为该系列的最新成员,延续了其一贯的快速、准确的设计哲学。在过去的几年中,YOLO系列经历了多次重大迭代,每一次迭代都在速度和精度之间寻求更好的平衡。YOLOv8的推出,标志着深度学习在目标检测任务中的又一重大进步,其不仅在速度上保持了YOLO家族的传统优势,还大幅提升了检测准确度,尤其是在复杂场景下的表现。

从YOLO到YOLOv8,模型架构与技术细节经历了从简单到复杂,再到高度优化的过程。早期的YOLO版本主要基于单一尺度的特征图进行预测,而YOLOv8通过引入多尺度特征融合机制,大幅提升了模型对于小物体和稠密场景的检测能力。同时,YOLOv8还强化了对动态场景的适应性,增加了对于时间维度特征的处理,使得模型更适合处理视频流数据。

### 2.1.2 YOLOv8的网络结构与关键组件

YOLOv8在继承了YOLO系列简洁高效的基础上,引入了一些新颖的网络设计。其网络架构可以分为三个主要部分:骨干网络(Backbone)、特征金字塔网络(FPN)以及输出头(Head)。骨干网络负责提取图像中的基础特征;FPN则将不同尺度的特征信息进行融合,增强了模型在不同尺度下的检测能力;输出头则负责对特征图进行处理,最后输出检测结果。

骨干网络部分,YOLOv8采用了类似CSPNet的结构设计,通过Cross-Stage Partial Network(CSPNet)有效减少了计算量和参数量,同时保证了特征提取的质量。FPN部分,通过自底向上的路径聚合,有效地将深层的语义信息和浅层的细节信息结合起来。输出头部分,YOLOv8采用了多尺度的预测策略,可以同时预测多种尺度的物体,大大提高了模型的灵活性和鲁棒性。

YOLOv8的关键组件还包括了锚点机制、损失函数的设计等。锚点机制用于预测目标边界框的初始位置,而损失函数则是优化过程中用于调整模型权重的主要手段。损失函数的合理设计对于提升模型的检测效果至关重要,YOLOv8在此基础上进行了进一步的优化,使得模型训练更加稳定和高效。

## 2.2 量化技术基础

### 2.2.1 量化概念与重要性

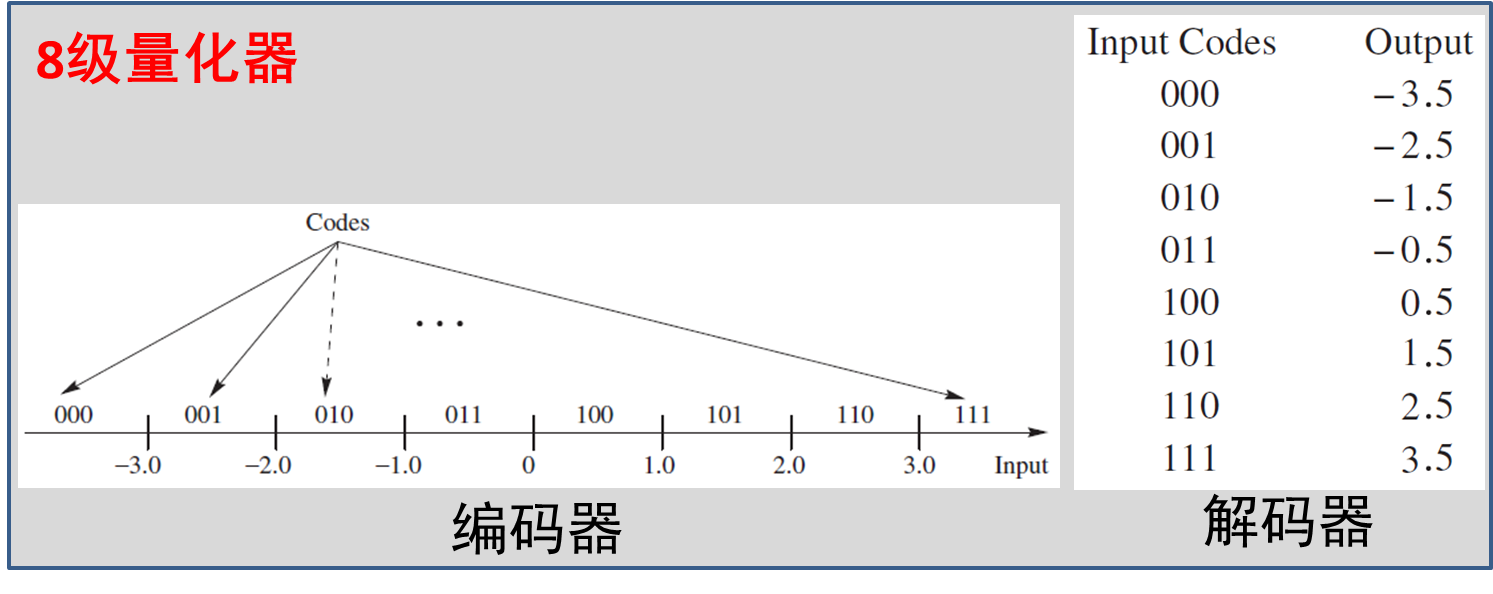

量化技术在深度学习中是一种减少模型大小和提高运算效率的重要手段。所谓量化,是指将模型中的浮点数值参数转换为低精度的表示,通常是从32位浮点数(FP32)转化为低至8位整数(INT8)的过程。这一过程可以极大地减少模型所需的存储空间和计算资源,从而使得模型更适合部署在资源受限的平台上,如移动设备或嵌入式系统。

量化的重要性在于它能够满足实际应用中的性能需求。在许多应用场景中,对模型的响应时间、功耗和存储空间都有严格的要求。量化不仅有助于缩短模型的推理时间,还能够降低能源消耗,延长设备的电池寿命。此外,量化还能提高模型的内存访问效率,因为低精度数据占用的内存更小,带宽需求也更低。

### 2.2.2 量化方法分类与选择

量化技术主要有两大类:静态量化和动态量化。静态量化在模型训练完成后进行,是一种离线的量化过程,它通过分析训练好的模型在一定数据集上的表现来确定量化参数。静态量化具有明确的量化规则,使得模型易于部署。但它的缺点是可能牺牲一定的模型精度。

动态量化则是在模型运行时进行的,它允许模型在不同数据上使用不同的量化参数。动态量化的好处在于能够更好地适应不同的输入数据,但它增加了模型运行时的开销,并且需要硬件的支持来高效运行。

根据应用场景和目标设备的不同,量化方法的选择也会有所不同。在资源受限的设备上部署模型时,通常会优先选择静态量化。而在需要更灵活的模型处理不同输入时,则可能需要考虑动态量化。总体而言,量化方法的选择需要平衡模型性能、精度和设备资源之间的关系。

## 2.3 模型量化对性能的影响

### 2.3.1 资源消耗与效率的关系

模型量化通过降低数值的精度,显著减少了模型参数的数量和运算的复杂性。资源消耗主要包括内存占用和计算资源,而效率则与模型推理的快速性密切相关。经过量化处理后的模型,其内存占用量大幅下降,因为低精度数值所占空间更小,这不仅减少了对内存的需求,也减少了内存带宽的压力。

在计算效率方面,量化对性能的提升主要体现在两个方面:一是降低了每次运算所需的操作数,二是简化了运算单元的逻辑。对于8位整数而言,相比32位浮点数,运算单元能够更快速地完成同样的计算任务,这导致了整体推理速度的提升。此外,更低的精度也意味着更高的运算吞吐量,这对于多任务处理和实时性要求较高的应用场景具有重要意义。

### 2.3.2 量化对模型准确度的影响分析

尽管模型量化能够带来显著的资源节约和效率提升,但它也可能对模型的准确度产生一定的负面影响。低精度表示意味着在量化过程中会丢失一定的信息,尤其是在参数的数值较大的情况下。在某些情况下,这种信息损失会导致模型的检测或分类性能下降,尤其是在数据集多样性和复杂性较高的情况下。

为了缓解量化对准确度的影响,研究人员提出了各种策略,比如量化感知训练(Quantization-Aware Training,QAT)和后训练量化(Post-Training Quantization,PTQ)。QAT通过在训练过程中模拟量化效果来优化模型权重,而PTQ则是在训练完成后通过少量校准数据来调整量化参数。两种方法都旨在最小化量化带来的精度损失,但每种方法都有其特定的应用场景和优劣之处。

总之,量化技术在提升模型运行效率和节约资源方面具有明显优势,但同时需要谨慎考虑对准确度的影响。模型开发者需要根据实际需求,平衡量化带来的性能提升和可能的精度损失,选择合适的量化策略。

# 3. YOLOv8量化实践流程

## 3.1 量化前的准备工作

### 3.1.1 数据集与环境搭建

在进行YOLOv8模型量化之前,准备好适当的数据集和环境搭建是至关重要的。这一步骤包括获取和处理训练与测试所需的数据,配置量化工具以及搭建量化评估的环境。首先,我们需确保数据集的多样性和充分性,以便涵盖模型在实际应用中可能遇到的各类场景。数据集需要按照一定的规则进行划分,通常包括训练集、验证集和测试集。

环境搭建涉及安装必要的深度学习框架(例如TensorFlow或PyTorch)和量化工具(比如TensorRT或Intel nGraph)。此外,安装适当的系统依赖项,如CUDA和cuDNN,对于GPU加速运算至关重要。所有软件的版本需要与YOLOv8模型的训练和量化兼容。

### 3.1.2 模型的预训练与微调

对于YOLOv8模型,预训练阶段通常需要一个大型的标注数据集和强大的计算资源,如多个GPU。在此阶段,可以使用开源的预训练模型来加速训练过程。若资源有限,可以从零开始训练或利用迁移学习技术使用较小的数据集进行微调。

微调过程是量化的关键步骤之一。在这个过程中,可以对模型进行细致的调整,使其适应特定的数据分布或任务需求。微调时必须监控训练过程中的各项指标,确保模型性能的稳定性和准确性。

## 3.2 量化实施步骤

### 3.2.1 选择量化策略与工具

量化策略的选择直接影响着最终模型的性能。YOLOv8模型的量化策略通常包括对权重和激活的量化。根据目标硬件平台的不同,可能会选择对称量化或非对称量化。

选择合适的量化工具同样重要。例如,若在NVIDIA GPU上部署YOLOv8模型,TensorRT是一个不错的选择。其他平台或许需要使用相应的优化工具,如OpenVINO或TVM。量化工具应能够支持模型的导入、转换、优化和输出等功能。

### 3.2.2

0

0