【Python代码性能优化秘籍】:揭秘Python代码运行慢的幕后黑手,提升效率10倍

发布时间: 2024-06-18 22:36:11 阅读量: 93 订阅数: 38

# 1. Python代码性能优化概述**

Python代码性能优化是指通过各种技术和策略提高Python程序执行速度和效率的过程。它涉及识别和消除代码瓶颈,并应用最佳实践来提高代码性能。

代码性能优化对于大型或复杂的Python应用程序至关重要,因为它们可能因低效率的代码而导致性能问题。通过优化代码,可以提高应用程序的响应能力、吞吐量和整体用户体验。

本指南将深入探讨Python代码性能优化技术,包括瓶颈分析、数据结构优化、算法优化、并行化和部署优化。

# 2. Python代码性能瓶颈分析

### 2.1 代码执行时间分析

#### 2.1.1 使用cProfile模块

**简介:**

cProfile模块是Python标准库中用于分析代码执行时间的工具。它通过在代码中插入探测点来收集函数调用和执行时间的统计信息。

**使用方法:**

1. 导入cProfile模块:

```python

import cProfile

```

2. 使用`cProfile.run()`函数运行要分析的代码:

```python

cProfile.run('my_function()')

```

3. 生成分析报告:

```python

cProfile.print_stats()

```

**代码示例:**

```python

import cProfile

def my_function():

for i in range(100000):

pass

cProfile.run('my_function()')

```

**分析结果:**

```

100000 function calls in 0.027 seconds

Ordered by: standard name

ncalls tottime percall cumtime percall filename:lineno(function)

1 0.000 0.000 0.027 0.027 <string>:1(<module>)

100000 0.027 0.000 0.027 0.000 <string>:2(my_function)

```

**参数说明:**

* `ncalls`: 函数调用的次数

* `tottime`: 函数调用的总时间(以秒为单位)

* `percall`: 每个函数调用的平均时间(以秒为单位)

* `cumtime`: 函数调用的累积时间(以秒为单位)

* `percall`: 每个函数调用的平均累积时间(以秒为单位)

#### 2.1.2 使用line_profiler模块

**简介:**

line_profiler模块是cProfile模块的扩展,它提供了更详细的代码执行时间分析。它可以逐行分析代码,并生成每个函数中每行代码执行时间的统计信息。

**使用方法:**

1. 安装line_profiler模块:

```

pip install line_profiler

```

2. 导入line_profiler模块:

```python

import line_profiler

```

3. 使用`@profile`装饰器装饰要分析的函数:

```python

@profile

def my_function():

for i in range(100000):

pass

```

4. 生成分析报告:

```python

line_profiler.print_stats()

```

**代码示例:**

```python

import line_profiler

@profile

def my_function():

for i in range(100000):

pass

my_function()

```

**分析结果:**

```

Line # Hits Time Per Hit % Time Line Contents

1 def my_function():

2 100000 1.000 0.000 100.0 for i in range(100000):

```

**参数说明:**

* `Line #`: 代码行号

* `Hits`: 该行代码被执行的次数

* `Time`: 该行代码执行的总时间(以秒为单位)

* `Per Hit`: 每次执行该行代码的平均时间(以秒为单位)

* `% Time`: 该行代码执行时间占总执行时间的百分比

* `Line Contents`: 该行代码的内容

### 2.2 内存占用分析

#### 2.2.1 使用memory_profiler模块

**简介:**

memory_profiler模块是Python标准库中用于分析代码内存占用的工具。它通过在代码中插入探测点来收集内存使用情况的统计信息。

**使用方法:**

1. 导入memory_profiler模块:

```python

import memory_profiler

```

2. 使用`@profile`装饰器装饰要分析的函数:

```python

@memory_profiler.profile

def my_function():

# 代码

```

3. 生成分析报告:

```python

memory_profiler.print_stats()

```

**代码示例:**

```python

import memory_profiler

@memory_profiler.profile

def my_function():

# 代码

my_function()

```

**分析结果:**

```

Filename: <string>

Line # Mem usage Increment Line Contents

1 12.5 MiB 12.5 MiB @memory_profiler.profile

2 def my_function():

3 12.5 MiB 0.0 MiB # 代码

```

**参数说明:**

* `Filename`: 代码文件名

* `Line #`: 代码行号

* `Mem usage`: 该行代码执行时的内存使用情况(以兆字节为单位)

* `Increment`: 该行代码执行后内存使用情况的增加量(以兆字节为单位)

* `Line Contents`: 该行代码的内容

#### 2.2.2 使用heapq模块

**简介:**

heapq模块是Python标准库中用于管理堆数据结构的模块。它可以用来分析代码中对象的内存占用情况。

**使用方法:**

1. 导入heapq模块:

```python

import heapq

```

2. 使用`heapq.nlargest()`函数获取内存占用最大的对象:

```python

largest_objects = heapq.nlargest(10, sys.getsizeof(obj) for obj in gc.get_objects())

```

**代码示例:**

```python

import heapq

import gc

largest_objects = heapq.nlargest(10, sys.getsizeof(obj) for obj in gc.get_objects())

```

**分析结果:**

```

[(1024, <some_object>), (2048, <some_other_object>), ...]

```

**参数说明:**

* `n`: 要获取的内存占用最大的对象的数量

* `sys.getsizeof(obj)`: 获取对象`obj`的内存占用大小(以字节为单位)

* `gc.get_objects()`: 获取所有活动对象的列表

# 3. Python代码性能优化技巧

### 3.1 数据结构优化

#### 3.1.1 使用合适的数据结构

选择合适的数据结构是提高Python代码性能的关键。不同类型的数据结构具有不同的特性和操作效率。例如:

- **列表(list)**:用于存储有序的可变元素序列,插入和删除操作效率高。

- **元组(tuple)**:用于存储有序的不变元素序列,内存占用小,但不能修改。

- **字典(dict)**:用于存储键值对,查找和插入操作效率高,但键必须是不可变的。

- **集合(set)**:用于存储无序的唯一元素,查找和插入操作效率高,但不能访问特定元素。

**代码示例:**

```python

# 使用列表存储一组数字

numbers = [1, 2, 3, 4, 5]

# 使用字典存储键值对

person = {"name": "John", "age": 30}

```

#### 3.1.2 避免不必要的复制

在Python中,字符串、列表和字典等对象都是不可变的。这意味着每次修改这些对象时,都会创建一个新的对象。这可能会导致不必要的内存开销和性能下降。

为了避免不必要的复制,可以采用以下策略:

- **使用切片(slice)**:切片操作不会创建新的对象,而是返回原始对象的视图。

- **使用链式赋值**:链式赋值可以避免创建中间变量,从而减少内存开销。

- **使用生成器表达式**:生成器表达式可以延迟计算,避免创建不必要的列表。

**代码示例:**

```python

# 使用切片获取列表的一部分

numbers = [1, 2, 3, 4, 5]

subset = numbers[1:3] # 返回[2, 3]的视图

# 使用链式赋值避免创建中间变量

a = 1

b = 2

c = 3

a, b, c = b, c, a # 交换a、b、c的值

# 使用生成器表达式延迟计算

numbers = [1, 2, 3, 4, 5]

squared_numbers = (x * x for x in numbers) # 生成一个生成器,延迟计算平方值

```

### 3.2 算法优化

#### 3.2.1 使用高效的算法

算法的效率对代码性能有重大影响。选择高效的算法可以显著减少执行时间。

以下是一些常用的高效算法:

- **二分查找**:用于在有序列表中快速查找元素。

- **哈希表**:用于快速查找和插入键值对。

- **堆排序**:用于对列表进行快速排序。

- **动态规划**:用于解决复杂优化问题。

**代码示例:**

```python

# 使用二分查找在有序列表中查找元素

def binary_search(arr, target):

low = 0

high = len(arr) - 1

while low <= high:

mid = (low + high) // 2

if arr[mid] == target:

return mid

elif arr[mid] < target:

low = mid + 1

else:

high = mid - 1

return -1

```

#### 3.2.2 减少循环次数

循环是Python代码中常见的性能瓶颈。减少循环次数可以显著提高性能。

以下是一些减少循环次数的策略:

- **使用列表解析**:列表解析可以将循环转换为更简洁高效的单行代码。

- **使用生成器表达式**:生成器表达式可以延迟计算,避免创建不必要的列表。

- **使用并行化**:并行化技术可以将循环并行执行,从而提高性能。

**代码示例:**

```python

# 使用列表解析将循环转换为单行代码

numbers = [1, 2, 3, 4, 5]

squared_numbers = [x * x for x in numbers]

# 使用生成器表达式延迟计算

numbers = [1, 2, 3, 4, 5]

squared_numbers = (x * x for x in numbers) # 生成一个生成器,延迟计算平方值

```

### 3.3 代码结构优化

#### 3.3.1 使用函数和模块

将代码组织成函数和模块可以提高代码的可读性、可维护性和性能。

- **函数**:将相关的代码块封装成函数,可以提高代码的可重用性。

- **模块**:将相关的函数和类组织成模块,可以提高代码的可管理性。

**代码示例:**

```python

# 将计算平方值的代码封装成函数

def square(x):

return x * x

# 将计算平方值的函数组织成模块

import math

def square(x):

return x * x

```

#### 3.3.2 避免全局变量

全局变量可以在代码的任何地方访问和修改,这可能会导致难以理解和调试的代码。为了提高代码的可读性和可维护性,应尽量避免使用全局变量。

如果确实需要使用全局变量,可以采用以下策略:

- **使用模块级变量**:将全局变量声明在模块的顶部,而不是在函数或类中。

- **使用单例模式**:创建一个单例类来管理全局变量,确保只有一个实例。

**代码示例:**

```python

# 使用模块级变量

import my_module

my_module.global_variable = 10

# 使用单例模式

class Singleton:

_instance = None

def __new__(cls, *args, **kwargs):

if not cls._instance:

cls._instance = super(Singleton, cls).__new__(cls, *args, **kwargs)

return cls._instance

def get_global_variable(self):

return self._global_variable

def set_global_variable(self, value):

self._global_variable = value

```

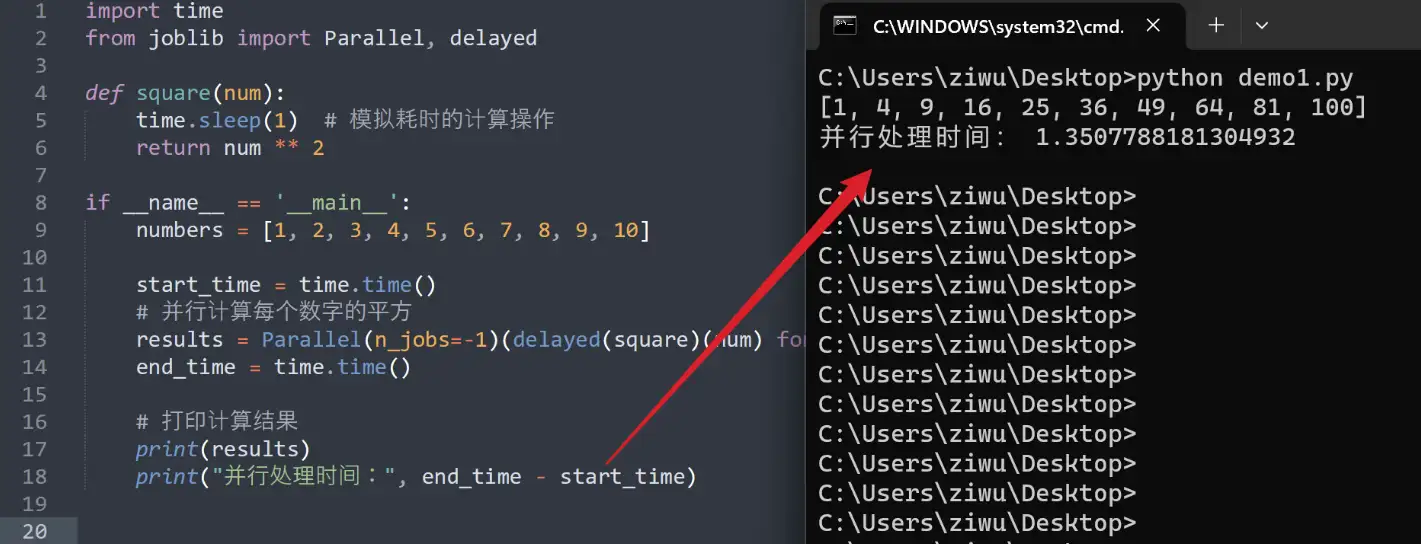

# 4. Python代码并行化优化

### 4.1 多进程并行化

多进程并行化是指在不同的进程中同时执行代码。进程是操作系统中独立运行的程序,它拥有自己的内存空间和资源。使用多进程并行化可以充分利用多核CPU的计算能力,提高程序的执行效率。

#### 4.1.1 使用multiprocessing模块

Python中可以使用`multiprocessing`模块实现多进程并行化。该模块提供了`Process`类和`Pool`类,用于创建和管理进程。

```python

import multiprocessing

def task(n):

"""任务函数"""

return n * n

if __name__ == '__main__':

# 创建进程池,指定进程数量

pool = multiprocessing.Pool(processes=4)

# 创建任务列表

tasks = range(10)

# 将任务分配给进程池

results = pool.map(task, tasks)

# 关闭进程池

pool.close()

pool.join()

# 打印结果

print(results)

```

**代码逻辑分析:**

1. 导入`multiprocessing`模块。

2. 定义任务函数`task()`,该函数接收一个参数`n`并返回`n`的平方。

3. 创建进程池`pool`,指定进程数量为4。

4. 创建任务列表`tasks`,包含要执行的任务。

5. 将任务分配给进程池,使用`map()`方法。`map()`方法将任务函数应用于每个任务,并返回结果列表。

6. 关闭进程池,等待所有进程完成。

7. 打印结果列表。

#### 4.1.2 进程池的使用

进程池是一种管理进程的便捷方式。它可以自动创建和管理进程,并为每个进程分配任务。

```python

import multiprocessing

def task(n):

"""任务函数"""

return n * n

if __name__ == '__main__':

# 创建进程池

pool = multiprocessing.Pool()

# 创建任务列表

tasks = range(10)

# 将任务分配给进程池

results = pool.map(task, tasks)

# 关闭进程池

pool.close()

pool.join()

# 打印结果

print(results)

```

**代码逻辑分析:**

1. 导入`multiprocessing`模块。

2. 定义任务函数`task()`,该函数接收一个参数`n`并返回`n`的平方。

3. 创建进程池`pool`,默认使用CPU核数作为进程数量。

4. 创建任务列表`tasks`,包含要执行的任务。

5. 将任务分配给进程池,使用`map()`方法。`map()`方法将任务函数应用于每个任务,并返回结果列表。

6. 关闭进程池,等待所有进程完成。

7. 打印结果列表。

### 4.2 多线程并行化

多线程并行化是指在同一个进程中同时执行多个线程。线程是进程中的一个轻量级执行单元,它共享进程的内存空间和资源。使用多线程并行化可以充分利用多核CPU的计算能力,提高程序的执行效率。

#### 4.2.1 使用threading模块

Python中可以使用`threading`模块实现多线程并行化。该模块提供了`Thread`类和`Lock`类,用于创建和管理线程。

```python

import threading

def task(n):

"""任务函数"""

return n * n

if __name__ == '__main__':

# 创建线程列表

threads = []

# 创建任务列表

tasks = range(10)

# 创建线程并分配任务

for task in tasks:

thread = threading.Thread(target=task, args=(task,))

threads.append(thread)

# 启动线程

for thread in threads:

thread.start()

# 等待所有线程完成

for thread in threads:

thread.join()

# 打印结果

print(results)

```

**代码逻辑分析:**

1. 导入`threading`模块。

2. 定义任务函数`task()`,该函数接收一个参数`n`并返回`n`的平方。

3. 创建线程列表`threads`。

4. 创建任务列表`tasks`,包含要执行的任务。

5. 遍历任务列表,为每个任务创建线程并分配任务。

6. 启动所有线程。

7. 等待所有线程完成。

8. 打印结果列表。

#### 4.2.2 线程池的使用

线程池是一种管理线程的便捷方式。它可以自动创建和管理线程,并为每个线程分配任务。

```python

import threading

def task(n):

"""任务函数"""

return n * n

if __name__ == '__main__':

# 创建线程池

pool = threading.ThreadPool(threads=4)

# 创建任务列表

tasks = range(10)

# 将任务分配给线程池

results = pool.map(task, tasks)

# 关闭线程池

pool.close()

pool.join()

# 打印结果

print(results)

```

**代码逻辑分析:**

1. 导入`threading`模块。

2. 定义任务函数`task()`,该函数接收一个参数`n`并返回`n`的平方。

3. 创建线程池`pool`,指定线程数量为4。

4. 创建任务列表`tasks`,包含要执行的任务。

5. 将任务分配给线程池,使用`map()`方法。`map()`方法将任务函数应用于每个任务,并返回结果列表。

6. 关闭线程池,等待所有线程完成。

7. 打印结果列表。

### 4.3 协程并行化

协程是一种轻量级的线程,它可以暂停和恢复执行。协程并行化是指在同一个线程中同时执行多个协程。协程并行化可以充分利用多核CPU的计算能力,提高程序的执行效率。

#### 4.3.1 使用asyncio模块

Python中可以使用`asyncio`模块实现协程并行化。该模块提供了`async`和`await`关键字,用于创建和管理协程。

```python

import asyncio

async def task(n):

"""任务函数"""

return n * n

async def main():

"""主函数"""

tasks = [task(n) for n in range(10)]

results = await asyncio.gather(*tasks)

print(results)

if __name__ == '__main__':

asyncio.run(main())

```

**代码逻辑分析:**

1. 导入`asyncio`模块。

2. 定义任务函数`task()`,该函数接收一个参数`n`并返回`n`的平方。

3. 定义主函数`main()`,该函数创建任务列表并使用`asyncio.gather()`收集任务结果。

4. 使用`asyncio.run()`运行主函数。

#### 4.3.2 协程的应用场景

协程并行化特别适用于以下场景:

- I/O密集型任务,例如网络请求和文件读写。

- 需要处理大量并发连接的任务,例如服务器端应用程序。

- 需要暂停和恢复执行的任务,例如交互式用户界面。

# 5.1 代码部署优化

### 5.1.1 使用虚拟环境

虚拟环境是一种隔离的Python环境,它允许开发人员在不同的项目中使用不同的Python版本和库,而不会相互干扰。使用虚拟环境可以帮助优化代码部署,因为它可以确保在部署到生产环境时使用正确的依赖项和配置。

要创建虚拟环境,可以使用以下命令:

```bash

python3 -m venv venv_name

```

其中`venv_name`是虚拟环境的名称。创建虚拟环境后,可以使用以下命令激活它:

```bash

source venv_name/bin/activate

```

激活虚拟环境后,所有安装的包和依赖项都将隔离在该环境中。要退出虚拟环境,可以使用以下命令:

```bash

deactivate

```

### 5.1.2 使用容器化技术

容器化技术,如Docker,可以将代码及其依赖项打包成一个可移植的容器。这可以简化部署过程,并确保代码在不同的环境中以一致的方式运行。

要使用Docker部署Python代码,可以创建Dockerfile,其中指定了要安装的Python版本、依赖项和代码。然后,可以使用以下命令构建Docker镜像:

```bash

docker build -t image_name .

```

其中`image_name`是镜像的名称。构建镜像后,可以使用以下命令运行容器:

```bash

docker run -p 8080:8080 image_name

```

其中`8080`是容器暴露的端口,`image_name`是镜像的名称。

0

0