【PyTorch在PyCharm中的性能优化秘诀】

发布时间: 2024-12-04 11:56:12 阅读量: 20 订阅数: 21

FPGA/数字IC设计的秋招笔试面试经验

参考资源链接:[Pycharm安装torch失败解决指南:处理WinError 126错误](https://wenku.csdn.net/doc/3g2nwwuq1m?spm=1055.2635.3001.10343)

# 1. PyTorch与PyCharm简介

随着人工智能和深度学习的快速发展,PyTorch已经成为研究和开发领域中最受欢迎的深度学习框架之一。它提供了简洁和直观的API,加上强大的社区支持,使得开发者能够更高效地构建和部署复杂的神经网络模型。与此同时,PyCharm作为一款流行的Python集成开发环境(IDE),为PyTorch提供了强大的开发工具支持,从项目设置到调试优化,无所不包。本章将带你入门PyTorch与PyCharm,了解两者的基本概念、功能以及如何安装与配置,为深入学习打下坚实的基础。

# 2. PyTorch基础与PyCharm配置

### 2.1 PyTorch的基本概念与工作原理

#### 2.1.1 张量操作与自动微分机制

PyTorch 是一个基于 Python 的科学计算包,它使用了动态计算图(也称为定义即运行模式)。这一特点使得 PyTorch 在构建复杂神经网络时具有更大的灵活性。

张量是 PyTorch 中的基本数据类型,可以看作一个多维数组。从概念上来说,张量与 NumPy 的 ndarray 类似,但 PyTorch 的张量可以在 GPU 上运行,这为深度学习提供了强大的计算支持。

```python

import torch

# 创建一个4x3的张量

a = torch.tensor([[1, 2, 3], [4, 5, 6], [7, 8, 9], [10, 11, 12]])

print(a)

```

上面的代码创建了一个简单的二维张量。每个张量都是一个节点(Node),而张量操作则是这些节点之间的边(Edge),构成一个有向无环图(DAG)。这个图在我们调用 `loss.backward()` 时会以动态的方式构建,这是 PyTorch 的自动微分机制的核心。

自动微分机制极大地简化了深度学习模型中梯度计算的复杂度。在 PyTorch 中,只需要定义计算图并指定哪个张量需要追踪梯度,然后通过调用 `.backward()` 方法,PyTorch 就可以自动计算图中所有需要梯度的张量的梯度。

#### 2.1.2 构建神经网络基础

构建神经网络的过程本质上是定义一系列层(layer),并设置这些层之间的连接。PyTorch 提供了多个模块来构建各种类型的神经网络。以下是构建一个简单的多层感知机(MLP)示例:

```python

import torch.nn as nn

class SimpleMLP(nn.Module):

def __init__(self):

super(SimpleMLP, self).__init__()

self.layer1 = nn.Linear(in_features=28*28, out_features=500)

self.relu = nn.ReLU()

self.layer2 = nn.Linear(in_features=500, out_features=10)

def forward(self, x):

x = x.view(-1, 28*28) # Flatten the image

x = self.layer1(x)

x = self.relu(x)

x = self.layer2(x)

return x

net = SimpleMLP()

```

在这个例子中,`SimpleMLP` 类继承自 `nn.Module`,是所有 PyTorch 模型的基类。在初始化函数中定义了网络的层,`forward` 方法定义了数据如何通过这些层流动。构建完模型后,可以利用 PyTorch 的优化器和损失函数来进行训练和优化。

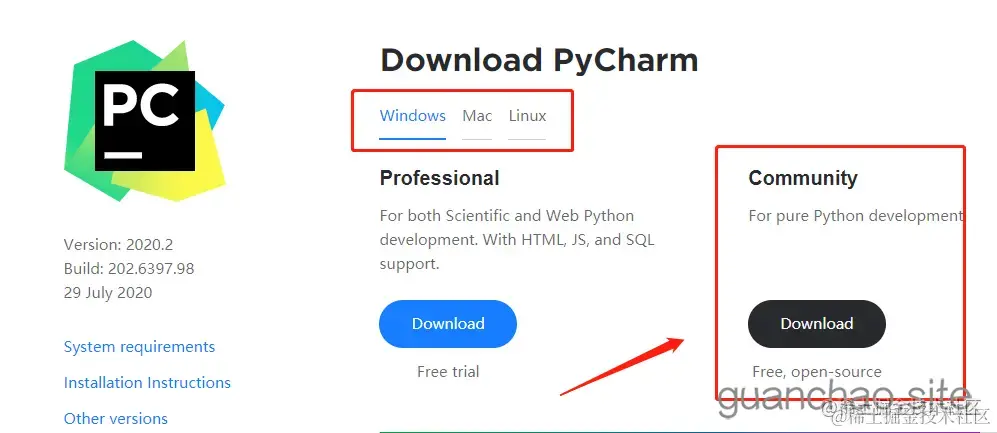

### 2.2 PyCharm项目设置与环境配置

#### 2.2.1 创建和管理PyCharm项目

PyCharm 是一个强大的集成开发环境(IDE),提供代码编辑、代码分析、版本控制等工具。使用 PyCharm 创建项目,可以更好地管理代码和项目依赖。

创建新项目的步骤如下:

1. 打开 PyCharm,选择 "Create New Project"。

2. 选择项目类型,通常选择 "Pure Python"。

3. 指定项目位置和解释器。如果需要,可以创建新的虚拟环境。

4. 完成创建向导。

项目创建后,可以开始添加文件和代码。PyCharm 支持实时代码分析,可以快速识别语法错误和潜在的问题。

#### 2.2.2 配置Python解释器和依赖库

为了确保项目运行环境的一致性,通常会使用虚拟环境来管理项目的依赖。PyCharm 提供了便捷的方式来配置和管理这些环境:

1. 在 PyCharm 中,打开 "File" > "Settings" 或 "PyCharm" > "Preferences"(对于 Mac 用户)。

2. 导航到 "Project: YourProjectName" > "Project Interpreter"。

3. 可以看到当前配置的解释器。如果需要创建新的虚拟环境,点击齿轮图标选择 "Add..."。

4. 选择 "Virtualenv Environment",然后指定环境的位置和解释器。

依赖库可以通过 PyCharm 的界面直接安装和管理。点击右下角的 "Python Interpreter" 图标,然后在弹出的窗口中选择 "+" 来安装新的库。

#### 2.2.3 PyCharm的调试工具和插件安装

PyCharm 内置了强大的调试工具,支持断点、步进、变量查看等基本调试功能。这些工具可以帮助开发者快速定位和解决问题:

1. 设置断点:在代码行左侧的边缘上点击,或者在代码上右键选择 "Toggle Line Breakpoint"。

2. 运行程序:选择 "Run" > "Debug"。程序将会在第一个断点处暂停。

3. 步进调试:使用 "Step Over"、"Step Into"、"Step Out" 等按钮来控制程序的执行流程。

PyCharm 也支持插件的安装,以增强功能。例如,"Mypy" 插件用于类型检查,"Docker" 插件用于容器化应用程序等。

安装插件的步骤:

1. 打开 "File" > "Settings" 或 "PyCharm" > "Preferences"。

2. 导航至 "Plugins"。

3. 使用搜索框查找想要安装的插件。

4. 找到插件后,点击 "Install",然后重启 PyCharm。

通过这些配置,PyCharm 成为了一个全面的开发环境,为 PyTorch 模型的开发和调试提供了极大的便利。

# 3. PyTorch性能优化理论基础

性能优化是机器学习模型开发中一个不可或缺的部分,尤其是在处理大型数据集和复杂模型时。优化可以提升训练速度、加速模型推理以及提高内存使用效率。本章将深入探讨PyTorch中的性能优化方法和理论基础,包括性能瓶颈的识别、内存管理和计算加速等策略。

## 3.1 性能优化的重要性与方法论

### 3.1.1 理解性能瓶颈

在深度学习项目中,性能瓶颈可能出现在不同的层面,包括但不限于数据处理、模型架构、计算资源使用等。理解性能瓶颈是优化的第一步。通常,性能瓶颈会表现为训练速度慢、内存消耗高或显存不足等问题。

针对性能瓶颈,开发者需要具体问题具体分析,常见的方法包括:

- 分析训练日志,查找耗时的操作。

- 使用性能分析工具,如PyTorch的`profiler`,检测计算密集型操作。

- 监控资源使用情况,比如CPU、GPU利用率,内存和显存占用等。

### 3.1.2 常见的性能优化策略

性能优化策略多种多样,以下是一些常见的优化方法:

- **数据流水线优化**:使用`DataLoader`的`pin_memory`参数,将数据预加载到固定内存中,提高GPU的数据读取速度。

- **减少不必要的计算**:简化模型结构或使用更高效的层实现,比如使用`1x1`卷积来减少计算量。

- **优化内存使用**:使用`in-place`操作,避免不必要的内存占用。

- **使用更高效的算法**:例如稀疏矩阵操作、批量矩阵乘法等。

## 3.2 PyTorch中的内存管理和优化技术

### 3.2.1 内存占用分析与减少

在PyTorch中,可以使用`.requires_grad_()`方法来跟踪计算图中的操作。然而,跟踪这些操作会增加内存占用。为了减少内存使用,开发者可以:

- 清除不需要梯度的计算图部分,例如使用`torch.no_grad()`上下文管理器。

- 使用`item()`或`.cpu()`方法将数据移动到CPU内存中。

- 将`model.state_dict()`中的模型参数和优化器状态转移到磁盘上。

### 3.2.2 使用计算图和梯度累积

PyTorch的自动微分机制使开发者能

0

0