F1-Score:推荐系统中的精准度提升指南

发布时间: 2024-11-21 07:29:37 阅读量: 43 订阅数: 47

在keras里面实现计算f1-score的代码

# 1. F1-Score在推荐系统中的重要性

在构建推荐系统时,准确评估模型性能至关重要。F1-Score作为精确度(Precision)和召回率(Recall)的调和平均,提供了一个单一的指标来衡量模型在平衡这两个方面的表现。推荐系统的目标是为用户提供相关和准确的推荐,而F1-Score在此过程中发挥着不可替代的作用,它帮助我们权衡模型在推荐精度和覆盖度上的表现。

精确度和召回率是信息检索和推荐系统领域中的两个核心评估指标。精确度关注的是推荐列表中有多大比例是用户感兴趣的,召回率则关注系统能够成功找出多少用户真正感兴趣的项目。一个系统可能在精确度上表现优秀,但如果遗漏了很多好的推荐,那么它的实际效用是有限的。反之,如果一个系统能够找出所有用户感兴趣的项目,但推荐列表中包含了大量用户不感兴趣的项目,那么它也称不上一个好的推荐系统。F1-Score为精确度和召回率的平衡提供了标准,它是两者关系的直接体现。

在实际应用中,F1-Score优于简单的准确率(Accuracy),尤其是在数据不平衡的情况下更为明显。推荐系统的用户行为数据往往极度不平衡,大多数用户只与少数项目互动,而F1-Score能够更准确地反映模型在这些情况下的性能。在下一章中,我们将进一步探讨F1-Score的计算方法,以及它如何帮助我们评估推荐系统模型。

# 2. F1-Score的基础理论

## 2.1 F1-Score的定义和计算方法

### 2.1.1 精确度和召回率的概念

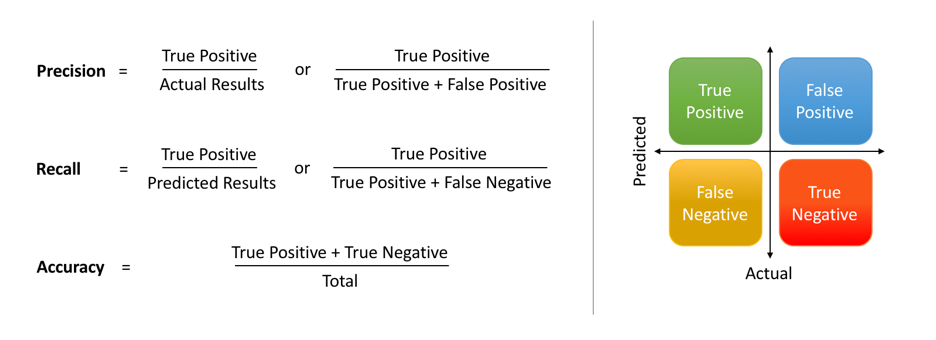

精确度(Precision)和召回率(Recall)是信息检索、分类以及推荐系统等领域的两个基本评估指标,尤其在不平衡数据集上,它们能够提供比准确率(Accuracy)更全面的性能评估。

- **精确度(Precision)**是指在所有被模型预测为正的样本中,实际为正的样本的比例。计算公式为:`Precision = TP / (TP + FP)`,其中TP表示真正例,FP表示假正例。

- **召回率(Recall)**指的是在所有实际为正的样本中,被模型正确识别为正的样本的比例。计算公式为:`Recall = TP / (TP + FN)`,其中FN表示假负例。

### 2.1.2 F1-Score公式的推导

F1-Score是精确度和召回率的调和平均值,旨在找到两者之间的平衡点。它的公式是:

`F1-Score = 2 * (Precision * Recall) / (Precision + Recall)`

从公式可以发现,F1-Score在精确度和召回率都很低时也会很低,只有当两者都高时F1-Score才会高。这使得F1-Score成为一个综合评价指标,适合于那些我们既要准确预测类别,又要覆盖尽可能多的正类别的场合。

### 2.1.3 F1-Score的代码实例

下面是一个简单的Python代码实例,演示如何计算精确度、召回率和F1-Score。

```python

from sklearn.metrics import precision_score, recall_score, f1_score

# 假设y_true是真实的标签,y_pred是模型预测的标签

y_true = [1, 0, 0, 1, 0, 1]

y_pred = [1, 0, 0, 1, 1, 1]

# 计算精确度、召回率和F1-Score

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

print(f"Precision: {precision}")

print(f"Recall: {recall}")

print(f"F1-Score: {f1}")

```

## 2.2 F1-Score与其他评估指标的比较

### 2.2.1 准确率(Precision)与召回率(Recall)

准确率(Accuracy)是指正确预测的样本数占总样本数的比例。虽然准确率是一个直观的评价指标,但在类别不平衡的情况下可能具有误导性。例如,在推荐系统中,如果大部分用户不喜欢某个产品,系统推荐不推荐该产品都是“正确”的,但推荐系统的真实效果无法准确反映出来。

### 2.2.2 F1-Score与精确度、召回率的关系

F1-Score作为精确度和召回率的调和平均,它在两者表现都好的情况下才能得到高分。而精确度和召回率中任何一个单独高并不能保证F1-Score高,这使得F1-Score成为一个更为严格和全面的性能评价指标。

### 2.2.3 F1-Score与AUC、FPR、TPR的对比

AUC(Area Under the ROC Curve)、FPR(False Positive Rate)、TPR(True Positive Rate)是另外一组评估指标,它们主要用于二分类问题中,并且侧重于模型的区分能力。

- AUC是ROC曲线下方的面积,衡量了模型在所有可能的分类阈值下的平均性能。

- FPR是在负类样本中错误地将样本判定为正的比例。

- TPR是在正类样本中正确地将样本判定为正的比例。

F1-Score与它们的不同之处在于,它侧重于精确度和召回率的平衡,而不是模型的整体区分能力。因此,选择哪一种指标取决于评估的目标和场景。

### 2.2.4 F1-Score与其他指标的对比表格

下面是一个表格,对比了F1-Score与其他几种常见评估指标:

| 指标 | 定义 | 适用场景 | 优缺点 |

| --- | --- | --- | --- |

| 准确率 | 正确预测的样本数 / 总样本数 | 类别平衡的数据集 | 简单易懂,但在类别不平衡时可能具有误导性 |

| 精确度 | 真正例 / (真正例 + 假正例) | 重视精确性的场景 | 侧重预测为正的样本的准确性 |

| 召回率 | 真正例 / (真正例 + 假负例) | 重视覆盖性的场景 | 侧重于实际为正样本的覆盖范围 |

| F1-Score | 2 * (精确度 * 召回率) / (精确度 + 召回率) | 需要精确度和召回率平衡的场景 | 综合考虑了精确度和召回率,但牺牲了其他信息 |

通过这个表格,我们可以清晰地看到F1-Score如何在不同评估指标间进行平衡,并在特定场景下成为更适用的评价标准。

# 3. F1-Score在推荐系统中的应用实践

## 3.1 构建推荐系统的模型基础

### 3.1.1 常用的推荐系统算法概述

构建推荐系统的第一步是理解并选择合适的算法。推荐系统算法主要分为两类:协同过滤(Collaborative Filtering)和内容推荐(Content-Based)。

- **协同过滤**算法的核心思想是利用用户间的相似性进行推荐。它又分为用户基和物品基两种,用户基关注相似用户的喜好,而物品基则考虑了相似物品之间的关联。矩阵分解(Matrix Factorization)是协同过滤中常用的方法,比如奇异值分解(SVD)和隐因子模型(Latent Factor Model)。

- **内容推荐**算法则侧重于物品的特征,通过对物品内容的分析,推荐与用户历史偏好相似的新物品。常见的内

0

0