随机森林与决策树对比实战:选哪个?看完就懂!

发布时间: 2024-11-20 09:28:06 阅读量: 5 订阅数: 8

# 1. 机器学习模型概述

在当今数字化时代,机器学习已成为推动各行各业进步的关键力量。机器学习模型是实现这一目标的核心工具,它能够从大量数据中学习并做出预测或决策。本章将带您了解机器学习模型的基本概念、主要类别及其在实际应用中的作用。

首先,我们将探讨什么是机器学习,并简要介绍其历史和重要性。接着,会分析机器学习模型的分类,包括监督学习、无监督学习和强化学习等基本类别,并解释它们各自的应用场景。

机器学习模型的性能如何衡量?本章将引导您了解评估模型的常用指标,如准确率、召回率、精确率和F1分数等,并讨论如何选择适当的指标来评价模型表现。

最后,我们将介绍模型部署的基本流程,以及如何在实际环境中利用这些模型进行预测和决策。我们将强调数据质量和预处理的重要性,并讨论如何处理过拟合和欠拟合问题。

通过本章内容的深入理解,读者将为深入学习更复杂的算法打下坚实的基础,并能够更好地将机器学习模型应用于解决现实世界的问题。

# 2. 决策树算法深度解析

## 2.1 决策树的工作原理

### 2.1.1 构建决策树的算法流程

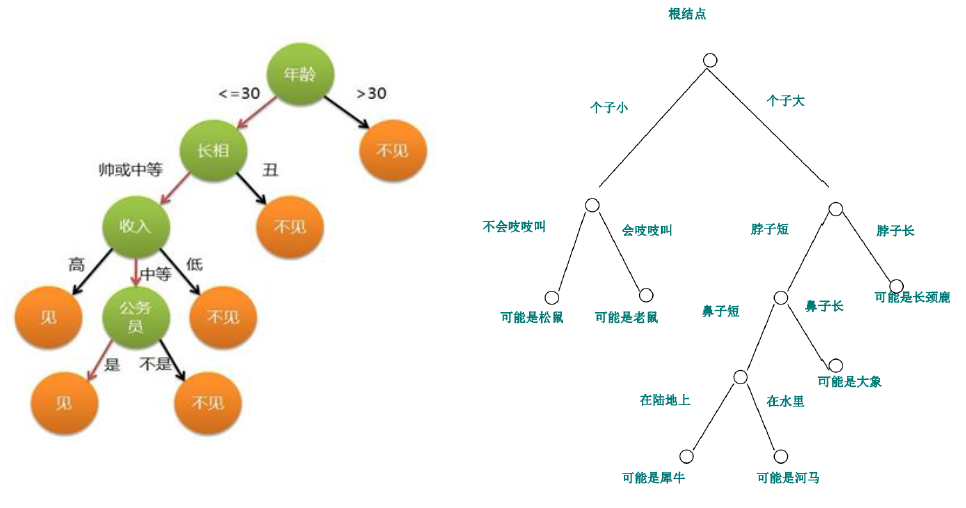

决策树是一种常见的监督学习算法,它通过一系列规则对数据进行分割,以达到分类或回归的目的。构建决策树的过程可以分为以下几个步骤:

- **选择最佳特征**:计算每个特征的信息增益或基尼指数等指标,选择对数据分类最有帮助的特征作为当前节点的分裂标准。

- **创建节点**:根据选定的特征将数据集划分为若干个子集,并在决策树上创建相应的节点。

- **递归分割**:对每个子集递归地应用上述过程,直到满足停止条件,例如子集中的所有实例都属于同一类别,或者节点中的实例数量小于预设阈值。

- **剪枝处理**:为了避免过拟合,可以对生成的决策树进行剪枝,即删除一些子节点或合并节点,以简化模型。

```python

# 示例代码:构建简单的决策树模型

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 初始化决策树模型

dt = DecisionTreeClassifier(random_state=42)

# 训练模型

dt.fit(X_train, y_train)

# 预测

predictions = dt.predict(X_test)

# 评估模型

print(f"Model Accuracy: {accuracy_score(y_test, predictions)}")

```

### 2.1.2 决策树的分裂标准

决策树的分裂标准通常是基于信息论的指标,如信息增益、信息增益比或基尼不纯度等。以信息增益为例,它表示通过分裂一个节点,数据纯度的提升程度。

- **信息增益**:基于熵的概念来衡量数据集的纯度。熵越低,数据集的纯度越高。

- **信息增益比**:信息增益比是对信息增益的改进,考虑了特征的个数对分裂标准的影响,降低了对特征数较多的偏好。

- **基尼不纯度**:用于衡量从数据集中随机选取两个样本,其类别标签不一致的概率。基尼不纯度越低,数据集的纯度越高。

## 2.2 决策树的优点与局限性

### 2.2.1 决策树的模型解释性

决策树的一个显著优点是模型的解释性非常强。它以树状结构展示决策过程,每一步都是基于特征值的简单逻辑判断,这使得模型的决策过程对人类来说易于理解和解释。

### 2.2.2 过拟合与剪枝策略

尽管决策树在训练集上可以达到很高的准确率,但它们有很强的倾向对训练数据过拟合,尤其是在树变得非常深时。为了解决这个问题,可以使用剪枝技术:

- **预剪枝**:在树构建过程中提前停止树的生长。这可以通过设置树的最大深度、最小分裂样本数、最小叶子节点样本数等参数来实现。

- **后剪枝**:先允许树完全生长,然后再通过分析验证集的错误来删除一些节点。这通常会导致更简洁的树结构,并且通常在实践中更有效。

## 2.3 实践:使用Python实现决策树

### 2.3.1 构建简单的决策树模型

在本节中,我们通过Python的`sklearn`库演示了如何构建一个简单的决策树分类模型,并对其进行了训练和评估。

### 2.3.2 模型的评估与优化

评估决策树模型的性能通常使用准确率、召回率、F1分数、ROC曲线等指标。为了优化模型,可以尝试调整剪枝参数、树的最大深度、分裂所需最小样本数等。

```python

# 示例代码:优化决策树模型的参数

from sklearn.model_selection import GridSearchCV

# 定义参数网格

param_grid = {

'max_depth': [2, 4, 6, 8, 10],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4]

}

# 使用网格搜索进行参数优化

grid_search = GridSearchCV(DecisionTreeClassifier(random_state=42), param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳参数和最佳分数

print(f"Best parameters: {grid_search.best_params_}")

print(f"Best score: {grid_search.best_score_}")

# 使用最佳参数构建模型并评估

best_dt = grid_search.best_estimator_

predictions = best_dt.predict(X_test)

print(f"Optimized Model Accuracy: {accuracy_score(y_test, predictions)}")

```

通过这种方式,可以系统地探索不同参数组合下模型性能的变化,找到最适合特定数据集的决策树模型。

# 3. 随机森林算法详解

## 3.1 随机森林的工作机制

随机森林(Random Forest)是集成学习的一种算法,它通过构建多个决策树并进行投票的方式来提高预测的准确性和鲁棒性。随机森林的核心思想在于随机性和多样性,通过引入随机性,使得模型能在保持低偏差的同时减少方差,从而改善过拟合现象。

### 3.1.1 集成学习与bagging策略

集成学习是机器学习的一种范式,它通过构建

0

0