如何选择最佳决策树结构:模型选择的科学方法

发布时间: 2024-11-20 09:39:53 阅读量: 3 订阅数: 8

# 1. 决策树模型简介

决策树是一种简单直观的机器学习算法,它模拟人类决策过程,通过一系列规则对数据进行分类和回归分析。其核心思想是通过学习数据特征及其属性,构建一个树状结构模型,以决策的方式预测目标变量。该模型的优点在于模型易于理解,可视化效果好,因此在实际应用中得到了广泛应用。在本章中,我们将介绍决策树的基本概念,以及它的应用领域和优势。随后,我们将深入探讨决策树的理论基础,为读者揭示其背后的复杂逻辑和构建过程。

# 2. 决策树的理论基础

## 2.1 决策树的工作原理

### 2.1.1 分类树与回归树

在机器学习中,决策树是一种常用的监督学习算法,用于分类和回归任务。分类树(Classification Tree)主要用于处理离散型的目标变量,而回归树(Regression Tree)则用于连续型目标变量的预测。

#### 分类树

分类树是通过将数据集递归地分成子集,并通过一系列的问题(决策规则)来预测类标签。每个节点对应于数据集中的一个属性,而每个分支对应于该属性的一个可能值。最终,叶节点代表类标签。其工作原理类似于现实世界中的决策过程,逐步细化问题,直到能够给出最精确的预测。

#### 回归树

回归树与分类树类似,不同的是,它将输出空间分割为多个矩形区域,并为每个区域分配一个实数值。回归树的输出是连续值,通常用于预测未来趋势或数值。

#### 对比

分类树和回归树的主要区别在于目标变量的类型和预测结果的形式。分类树的预测结果是离散的类别标签,而回归树的预测结果是连续的数值。在实际应用中,选择合适类型的树模型对于提高预测精度至关重要。

### 2.1.2 信息增益与熵

决策树在构建过程中,需要确定如何根据数据特征来分割数据集。信息增益和熵是决策树算法中常用的概念。

#### 熵

熵是度量数据集纯度的一种方式,在决策树算法中用于评估数据集的随机性或杂乱程度。信息熵越大,数据集的不确定性越高,分类的难度也就越大。

计算公式为:

\[ H(S) = -\sum_{i=1}^{n} p_i \log_2(p_i) \]

其中,\( H(S) \) 是数据集的熵,\( p_i \) 是第 \( i \) 类样本在数据集中的比例。

#### 信息增益

信息增益表示了在知道某个属性的信息之后,数据集纯度的提升。通过计算不同属性的信息增益,可以决定哪个属性对于预测结果最为重要。

信息增益的计算公式为:

\[ IG(S, A) = H(S) - \sum_{t \in T} \frac{|S_t|}{|S|}H(S_t) \]

其中,\( IG(S, A) \) 表示属性 \( A \) 对数据集 \( S \) 的信息增益,\( T \) 是划分后 \( S \) 的子集,\( H(S_t) \) 是子集 \( S_t \) 的熵。

在决策树的构建过程中,通常会优先选择信息增益最大的属性进行分割,因为这样可以让数据集变得更“纯净”。

### 2.2 决策树的构建过程

#### 2.2.1 树的生成算法

构建决策树时,常用的方法有 ID3、C4.5 和 CART 等。不同的算法在处理连续属性、缺失值以及树的剪枝上有不同的策略。

以 ID3 算法为例,该算法使用信息增益作为划分数据集的依据。首先,选取信息增益最大的属性作为节点进行分割。然后,对每一个分割后的子集递归地应用相同的过程,直到满足停止条件,如达到最大深度、子集中所有实例均属于同一类或者信息增益为零等。

构建决策树的过程中,需要不断进行特征选择、树的扩展以及判断是否停止扩展的决策。这一过程可以通过递归函数实现,每次递归都会对数据集进行划分,直至生成最终的树模型。

#### 2.2.2 剪枝技术

为了防止过拟合,决策树算法常常采用剪枝技术来简化树模型。剪枝可分为预剪枝(Prepruning)和后剪枝(Postpruning)。

预剪枝是在构建决策树的过程中提前停止树的增长,即在树的节点分裂时就考虑是否应该停止,防止树过度生长。

后剪枝则是先构建一棵完整的树,然后从叶节点开始,评估节点剪枝后对模型性能的影响,如果性能未降低或有提升,则剪枝。这种方式能够在不损失模型精度的情况下尽可能简化树结构。

### 2.3 决策树的评价标准

#### 2.3.1 准确性度量

准确性度量是评价决策树模型性能的重要指标之一。常用的准确性度量标准有:

- 错误率:预测错误的样本数占总样本数的比例。

- 精确率:正确预测为正例的样本数占所有预测为正例的样本数的比例。

- 召回率:正确预测为正例的样本数占实际所有正例样本数的比例。

- F1 分数:精确率和召回率的调和平均数,常用于解决精确率和召回率之间权衡问题。

#### 2.3.2 模型复杂度的考量

决策树的复杂度不仅包括树的深度,还包括节点中样本数量的限制、叶节点中样本数量的限制等。模型复杂度的考量是平衡模型的准确性和泛化能力的关键。

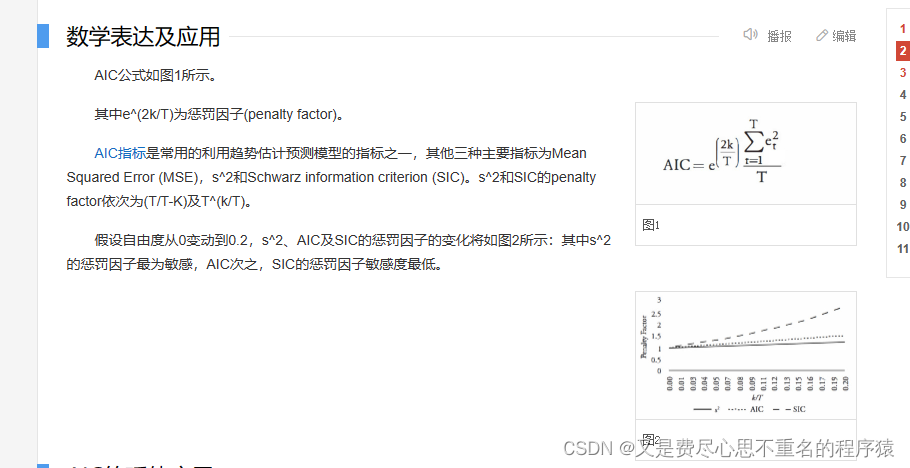

在模型选择和调优过程中,需要综合考虑模型复杂度对模型性能的影响。一般而言,复杂的模型具有较高的方差,而简单模型则可能具有较高的偏差。通过交叉验证和AIC、BIC等信息准则,可以评估和选择适当的模型复杂度。

## 2.2.1 树的生成算法代码示例(CART)

以下是使用 Python 的 `scikit-learn` 库构建分类树的代码示例:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=1)

# 构建决策树模型

clf = DecisionTreeClassifier(criterion='entropy', max_depth=3)

clf.fit(X_train, y_train)

# 进行预测

y_pred = clf.predict(X_test)

# 计算准确性

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy: ", accuracy)

```

在这段代码中,我们使用了 `scikit-learn` 中的 `DecisionTreeClassifier` 来构建一个决策树模型。我们选择了 `entropy` 作为分裂标准,并设置了最大深度 `max_depth` 为 3。构建模型后,我们在测试集上进行预测并计算了准确率。

### 2.3.1 准确性度量代码示例

接着,我们可以使用 `scikit-learn` 提供的其他函数来计算其他性能指标,例如混淆矩阵和 F1 分数:

```python

from sklearn.metrics import confusion_matrix, f1_score

# 计算混淆矩阵

cm = confusion_matrix(y_test, y_pred)

print("Confusion Matrix:\n", cm)

# 计算 F1 分数

f1 = f1_score(y_test, y_pred, average='weighted')

print("F1 Score: ", f1)

```

通过这样的代码块,我们可以直观地看到模型在各种类别上的表现,并结合 F1 分数来评估模型的整体性能。

### 2.3.2 模型复杂度的考量代码示例

为了更深入理解模型复杂度的影响,我们可以使用 `GridSearchCV` 进行参数优化和交叉验证:

```python

from sklearn.model_selection import GridSearchCV

# 设置参数网格

param_grid = {'max_depth': [2, 3, 4, 5], 'min_samples_split': [2, 3, 4]}

# 实例化 GridSearchCV 对象

grid_search = GridSearchCV(DecisionTreeClassifier(criterion='entropy'), param_grid, cv=5)

# 在训练集上运行网格搜索

grid_search.fit(X_train, y_train)

# 输出最佳参数和交叉验证后的最佳准确率

print("Best parameters: ", grid_search.best_params_)

print("Best cross-validated accuracy: ", grid_search.best_score_)

```

以上代码展示了如何在不同的参数下训练模型,并通过交叉验证选出最佳的模型参数。这种方法可以有效地避免过拟合,并找到泛化能力最强的模型。

至此,我们已经深入了解了决策树的基础理论和构建过程,包括树的生成算法、剪枝技术和评价标准。在下一章中,我们将探讨决策树模型选择的实践方法,包括超参数调优、交叉验证技术以及特征选择和数据预处理等内容。

# 3. 决策树模型选择的实践方法

在过去的章节中,我们已经深入理解了决策树模型的理论基础,涵盖了其工作原理、构建过程以及评价标准。本章将探讨如何将这些理论应用于实际问题的解决中,重点介绍决策树模型选择的实践方法。

## 3.1 超参数调优

### 3.1.1 网格搜索法

决策树模型的性能受到其超参数设置的显著影响。网格搜索是一种系统性的参数搜索方法,通过遍历预定义的参数值范围来找到最优组合。

#### 操作步骤

1. 定义要搜索的超参数范围及对应的值。

2. 设置交叉验证的折数,如5折交叉验证。

3. 构建网格搜索的模型并运行。

4. 评估每组超参数下的模型性能。

5. 选出最佳的超参数组合。

#### 代码展示

```python

from sklearn.model_selection import GridSearchCV

from sklearn.tree import DecisionTreeClassifier

# 设置决策树分类器

dtree = DecisionTreeClassifier()

# 设定要搜索的参数范围

param_grid = {

'criterion': ['gini', 'entropy'],

'max_depth': [None, 5, 10, 20],

'min_samples_split': [2, 4, 6]

}

# 构建网格搜索实例

grid_search = GridSearchCV(estimator=dtree, param_grid=param_grid, cv=5)

# 拟合模型并获取最佳参数组合

grid_search.fit(X_train, y_train)

best_params = grid_search.best_params_

print("Best parameters found: ", best_params)

```

### 3.1.2 随机搜索法

随机搜索法与网格搜索类似,但不是遍历所有参数组合,而是从指定的参数分布中随机抽取一定数量的组合进行尝试。这对于参数范围大或计算资源有限的情况更有效率。

#### 操作步骤

1. 定义超参数的分布范围。

2. 选择尝试的组合数量。

3. 运行随机搜索。

4. 筛选出表现最好的组合。

#### 代码展示

```python

from sklearn.model_selection import RandomizedSearchCV

from sklearn.tree import DecisionTreeClassifier

import numpy as np

# 设置决策树分类器

dtree = DecisionTreeClassifier()

# 定义超参数的分布范围

param_dist = {

'criterion': ['gini', 'entropy'],

'max_depth': [None] + list(np.arange(

```

0

0