【Python集合去重手册】:轻松实现数据自动去重

发布时间: 2024-09-18 17:28:09 阅读量: 109 订阅数: 47

# 1. Python集合去重的基本原理

Python集合是一种无序的、不重复的数据类型集合,其去重的基本原理基于集合的特性:不允许存储重复的元素。集合中的每个元素都是唯一的,当尝试添加一个已经存在于集合中的元素时,该操作将不会产生任何效果。通过这一特性,我们可以轻易地实现数据的去重操作。

集合是通过哈希表(hash table)来实现的,这种数据结构允许在平均情况下实现快速的查找、添加和删除操作。Python在内部使用一个高效的算法来确保每个元素在集合中只出现一次。理解集合的这种实现机制,有助于我们更好地掌握其去重功能,并在实际应用中作出适当的选择。

当涉及到集合去重时,通常我们会考虑时间复杂度和空间复杂度。Python集合去重操作的时间复杂度为O(n),空间复杂度为O(n),其中n是元素的个数。这种效率使得集合去重成为处理大量数据时的常用手段。

# 2. Python集合去重的实践操作

在了解了Python集合去重的基本原理后,我们将进入实践操作阶段。这章将探讨多种实用的去重方法,以及一些更高级的技巧,以满足不同场景下的去重需求。我们将重点介绍使用集合的性质去重、使用字典去重、使用循环去重,以及利用Pandas、NumPy库和正则表达式进行去重的高级技巧。

## 2.1 Python集合去重的常见方法

### 2.1.1 使用集合的性质去重

Python中的集合(set)是一个无序的不重复元素序列。我们可以利用集合的这一性质来去除重复的数据。这种方法简单且执行效率高,适合基本的去重需求。

#### 示例代码:

```python

def remove_duplicates_by_set(data):

return list(set(data))

# 示例使用

original_list = [1, 2, 2, 3, 4, 4, 5]

unique_list = remove_duplicates_by_set(original_list)

print(unique_list)

```

#### 代码逻辑解读:

- 首先定义一个函数 `remove_duplicates_by_set` 接受一个列表 `data` 作为输入。

- 将列表转换为集合,自动去除其中的重复项。

- 将结果集合转换回列表并返回。

使用集合去重的优点是代码简洁且效率较高,因为集合是使用哈希表实现的。但需要注意的是,这种方法会丢失原始列表的顺序,并且不适用于包含可哈希对象的列表去重。

### 2.1.2 使用字典去重

当需要保持元素的顺序时,可以使用字典的键来去重。字典的键是唯一的,这样可以在保持顺序的同时实现去重。

#### 示例代码:

```python

def remove_duplicates_by_dict(data):

seen = {}

result = []

for item in data:

if item not in seen:

seen[item] = True

result.append(item)

return result

# 示例使用

original_list = [1, 2, 2, 3, 4, 4, 5]

unique_list = remove_duplicates_by_dict(original_list)

print(unique_list)

```

#### 代码逻辑解读:

- 定义函数 `remove_duplicates_by_dict` 接收列表 `data`。

- 创建一个空字典 `seen` 用于记录已经遍历过的元素。

- 遍历列表,将未见过的元素添加到结果列表 `result` 中,并在字典 `seen` 中记录。

- 返回结果列表,它现在是去重后的有序列表。

这种方法适合列表中元素为可哈希对象的情况。保持了元素插入的顺序,并且相比集合去重有更明确的返回类型。

### 2.1.3 使用循环去重

如果需要对一个列表进行去重,并且需要对元素进行某些额外的处理,那么可以使用循环来手动实现去重。

#### 示例代码:

```python

def remove_duplicates_by_loop(data):

result = []

for item in data:

if item not in result:

result.append(item)

return result

# 示例使用

original_list = [1, 2, 2, 3, 4, 4, 5]

unique_list = remove_duplicates_by_loop(original_list)

print(unique_list)

```

#### 代码逻辑解读:

- 定义函数 `remove_duplicates_by_loop` 接收列表 `data`。

- 创建一个空列表 `result` 用于存放去重后的结果。

- 遍历原列表,每次检查当前元素是否已在 `result` 中。

- 如果不在,则添加到 `result`。

- 返回去重后的结果列表。

这种方法非常灵活,可以适用于所有类型的元素,包括不可哈希的元素,并且可以进行更复杂的元素处理逻辑。

## 2.2 Python集合去重的高级技巧

### 2.2.1 使用Pandas库去重

在数据分析和科学计算中,Pandas库是非常常用的工具。它提供了非常强大的数据处理能力,包括去重。

#### 示例代码:

```python

import pandas as pd

def remove_duplicates_by_pandas(data):

df = pd.DataFrame(data)

return df.drop_duplicates().values.flatten().tolist()

# 示例使用

original_list = [1, 2, 2, 3, 4, 4, 5]

unique_list = remove_duplicates_by_pandas(original_list)

print(unique_list)

```

#### 代码逻辑解读:

- 导入Pandas库,并定义 `remove_duplicates_by_pandas` 函数接收列表 `data`。

- 将列表转换为Pandas的DataFrame对象。

- 使用 `drop_duplicates()` 方法去除DataFrame中的重复行。

- 将结果转换为列表。

这种方法适用于需要对数据进行预处理的场景,特别是在数据清洗和分析前的准备工作中。

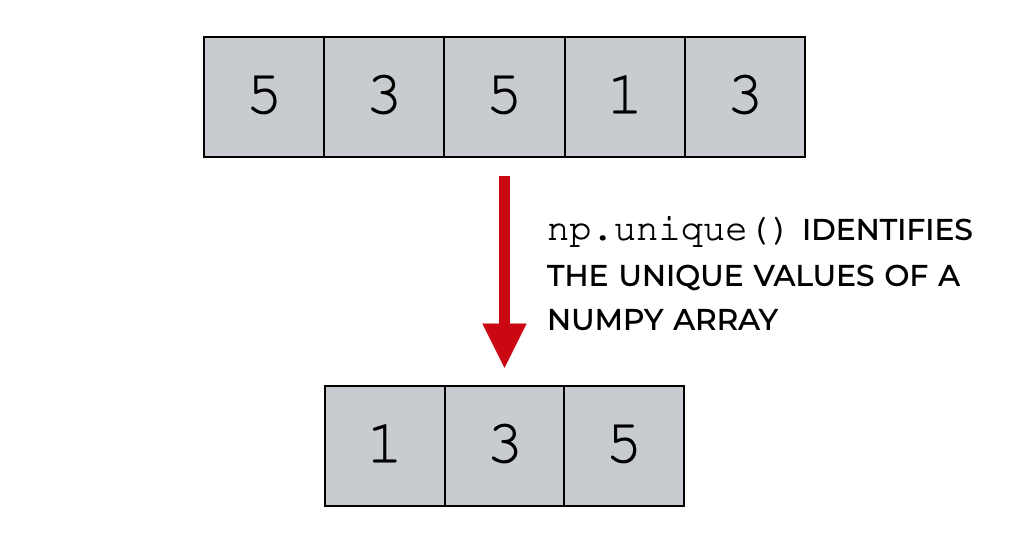

### 2.2.2 使用NumPy库去重

NumPy是一个强大的科学计算库,其中的数组对象非常适合处理数值型数据。NumPy同样提供了去重功能。

#### 示例代码:

```python

import numpy as np

def remove_duplicates_by_numpy(data):

unique_array = np.unique(data)

return unique_array.tolist()

# 示例使用

original_array = np.array([1, 2, 2, 3, 4, 4, 5])

unique_array = remove_duplicates_by_numpy(original_array)

print(unique_array)

```

#### 代码逻辑解读:

- 导入NumPy库,并定义 `remove_duplicates_by_numpy` 函数接收列表 `data`。

- 使用 `np.unique()` 方法得到去重后的数组。

- 将NumPy数组转换为Python列表。

NumPy去重特别适合于数值计算和大规模数据处理,因为它的数组操作通常比纯Python更快。

### 2.2.3 使用正则表达式去重

正则表达

0

0