Darknet YOLO图像检测:打造你的专属训练数据集,释放算法潜力

发布时间: 2024-08-18 03:45:56 阅读量: 29 订阅数: 46

# 1. Darknet YOLO图像检测概述**

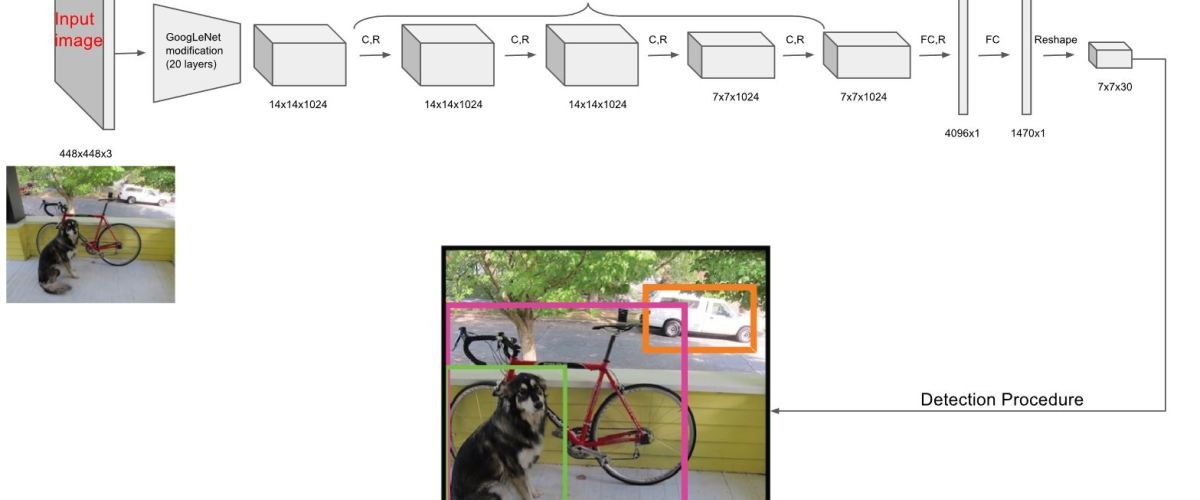

Darknet YOLO(You Only Look Once)是一种实时对象检测算法,以其快速、准确的性能而闻名。它采用单次卷积神经网络(CNN)来处理整个图像,并直接预测边界框和类概率。

YOLO算法的优势在于其速度和效率。它可以在实时处理视频流,每秒处理数百帧。此外,它具有较高的准确性,在PASCAL VOC和COCO等图像检测基准测试中表现出色。

Darknet YOLO算法由Joseph Redmon和Ali Farhadi于2015年提出,自此以来已成为图像检测领域最流行的算法之一。它广泛应用于各种领域,包括安全监控、自动驾驶和医疗诊断。

# 2. 打造专属训练数据集

### 2.1 数据收集和标注

#### 2.1.1 数据源的获取

训练数据集是训练深度学习模型的关键因素。对于图像检测任务,需要收集大量包含目标对象的图像。这些图像可以从以下来源获取:

- **公共数据集:** COCO、Pascal VOC、ImageNet 等公共数据集提供了大量标注好的图像,可直接用于训练。

- **网络爬取:** 使用网络爬虫从互联网上抓取相关图像,但需要进行筛选和标注。

- **自有数据:** 收集与目标任务相关的自有图像,确保数据与实际应用场景匹配。

#### 2.1.2 图像标注工具和方法

图像标注是将目标对象在图像中框选并标记的过程。常用的图像标注工具有:

- **LabelImg:** 一款开源的图像标注工具,支持矩形框、多边形框和关键点标注。

- **VGG Image Annotator:** 一款在线图像标注工具,提供直观的用户界面和多种标注方式。

- **CVAT:** 一款开源的计算机视觉标注工具,支持图像、视频和点云标注。

标注方法包括:

- **矩形框标注:** 使用矩形框框选目标对象。

- **多边形框标注:** 使用多边形框更精确地框选不规则形状的目标对象。

- **关键点标注:** 标注目标对象的特定关键点,如眼睛、鼻子和嘴巴。

### 2.2 数据预处理和增强

#### 2.2.1 图像尺寸调整和归一化

图像尺寸调整和归一化是数据预处理的重要步骤。

- **图像尺寸调整:** 将所有图像调整为统一的尺寸,以满足模型输入要求。

- **归一化:** 将图像像素值归一化到特定范围内(如 0-1 或 -1 到 1),以减少不同图像之间的差异。

#### 2.2.2 数据增强技术

数据增强技术通过对原始图像进行随机变换,生成更多训练数据,提高模型的泛化能力。常用的数据增强技术包括:

- **随机裁剪:** 从原始图像中随机裁剪出不同大小和位置的子图像。

- **随机翻转:** 水平或垂直翻转图像,增加模型对不同视角的鲁棒性。

- **随机旋转:** 随机旋转图像一定角度,增强模型对旋转不变性的学习。

- **颜色抖动:** 随机改变图像的亮度、对比度和饱和度,增强模型对光照条件变化的适应性。

**代码块:**

```python

import cv2

import numpy as np

def preprocess_image(image, target_size=(416, 416)):

"""

对图像进行预处理,包括尺寸调整和归一化。

参数:

image: 输入图像。

target_size: 目标图像尺寸。

返回:

预处理后的图像。

"""

# 尺寸调整

image = cv2.resize(image, target_size)

# 归一化

image = image / 255.0

image = (image - np.mean(image)) / np.std(image)

return image

```

**代码逻辑分析:**

该代码块实现了图像预处理函数,包括尺寸调整和归一化。

- `cv2.resize(image, target_size)`:将图像调整为指定尺寸。

- `image = image / 255.0`:将像素值归一化到 0-1 范围内。

- `image = (image - np.mean(image)) / np.std(image)`:将图像进行中心化和标准化,减去均值并除以标准差。

**表格:**

| 数据增强技术 | 描述 |

|---|---|

| 随机裁剪 | 从原始图像中随机裁剪出不同大小和位置的子图像 |

| 随机翻转 | 水平或垂直翻转图像 |

| 随机旋转 | 随机旋转图像一定角度 |

| 颜色抖动 | 随机改变图像的亮度、对比度和饱和度 |

**Mermaid流程图:**

```mermaid

graph LR

subgraph 数据收集

A[获取数据源] --> B[标注图像]

end

subgraph 数据预处理

C[调整尺寸] --> D[归一化]

end

subgraph 数据增强

E[随机裁剪] --> F[随机翻转]

E[随机裁剪] --> G[随机旋转]

E[随机裁剪] --> H[颜色抖动]

end

```

# 3. Darknet YOLO训练与评估

### 3.1 模型训练

#### 3.1.1 训练参数设置

训练Darknet YOLO模型需要设置一系列训练参数,包括:

- **batch_size:**每个训练批次中图像的数量。较大的batch_size可以提高训练速度,但可能会导致过拟合。

- **subdivisions:**将batch_size划分为更小的子batch进行训练。这可以减少内存消耗,并提高训练稳定性。

- **learning_rate:**优化器用于更新模型权重的学习率。较高的学习率可以加快训练,但可能会导致不稳定。

- **max_batches:**训练的总批次数量。

- **steps:**在训练过程中调整学习率的批次号。

- **scales:**图像缩放比例的范围。

- **jitter:**图像随机缩放和裁剪的程度。

- **hue:**图像色调的随机扰动。

- **saturation:**图像饱和度的随机扰动。

- **exposure:**图像曝光的随机扰动。

#### 3.1.2 训练过程监控

训练过程中,需要密切监控以下指标:

- **训练损失:**模型在训练集上的损失函数值。

- **验证损失:**模型在验证集上的损失函数值。

- **平均精度(mAP):**模型在验证集上的平均精度,衡量其检测准确性和召回率。

- **训练时间:**每次训练迭代的平均时间。

通过监控这些指标,可以评估模型的训练进度,并根据需要调整训练参数。

### 3.2 模型评估

#### 3.2.1 评估指标

评估Darknet YOLO模型的性能时,可以使用以下指标:

- **平均精度(mAP):**模型在不同置信度阈值下的平均精度,综合考虑了检测准确性和召回率。

- **精确率:**模型正确检测目标的比例。

- **召回率:**模型检测到的目标中正确目标的比例。

- **F1得分:**精确率和召回率的加权平均值。

- **平均IoU:**模型预测边界框与真实边界框的平均交并比。

#### 3.2.2 评估结果分析

评估结果可以帮助确定模型的性能,并指导进一步的优化。

- **高mAP值:**表明模型具有良好的检测准确性和召回率。

- **高精确率:**表明模型很少产生误报。

- **高召回率:**表明模型可以检测到大多数目标。

- **高F1得分:**表明模型在精确率和召回率之间取得了良好的平衡。

- **高平均IoU:**表明模型的边界框预测与真实边界框高度重叠。

通过分析评估结果,可以确定模型的优势和劣势,并针对性地进行优化。

# 4. Darknet YOLO实战应用

### 4.1 图像检测与结果展示

#### 4.1.1 检测算法实现

**代码块 1:图像检测算法实现**

```python

import cv2

import darknet

# 加载 Darknet 模型

net = darknet.load_net("yolov3.cfg", "yolov3.weights")

meta = darknet.load_meta("coco.data")

# 读取图像

image = cv2.imread("image.jpg")

# 执行检测

detections = darknet.detect(net, meta, image)

# 输出检测结果

for detection in detections:

print(f"类别:{detection[0]},置信度:{detection[1]},边界框:{detection[2]}")

```

**逻辑分析:**

* 加载 Darknet 模型,包括网络配置和权重文件。

* 读取待检测图像。

* 调用 `darknet.detect()` 函数执行检测,返回检测结果。

* 遍历检测结果,输出类别、置信度和边界框信息。

#### 4.1.2 检测结果可视化

**代码块 2:检测结果可视化**

```python

# 导入必要的库

import cv2

import darknet

# 加载 Darknet 模型

net = darknet.load_net("yolov3.cfg", "yolov3.weights")

meta = darknet.load_meta("coco.data")

# 读取图像

image = cv2.imread("image.jpg")

# 执行检测

detections = darknet.detect(net, meta, image)

# 绘制检测结果

for detection in detections:

x, y, w, h = detection[2]

cv2.rectangle(image, (x, y), (x + w, y + h), (0, 255, 0), 2)

# 显示检测结果

cv2.imshow("Detection Result", image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**逻辑分析:**

* 加载 Darknet 模型和读取图像。

* 执行检测并获取检测结果。

* 遍历检测结果,提取边界框信息。

* 在原图像上绘制边界框。

* 显示检测结果图像。

### 4.2 算法优化与性能提升

#### 4.2.1 模型微调和超参数优化

* **模型微调:**使用自定义数据集对预训练模型进行微调,以提高在特定任务上的性能。

* **超参数优化:**调整训练超参数(如学习率、批次大小)以提高训练效率和模型精度。

#### 4.2.2 硬件加速和并行计算

* **硬件加速:**使用 GPU 或 TPU 等硬件加速器来提高训练和推理速度。

* **并行计算:**利用多核 CPU 或多 GPU 进行并行计算,进一步提升性能。

# 5.1 模型迁移学习

### 5.1.1 预训练模型的选取

在进行模型迁移学习时,选择合适的预训练模型至关重要。一般来说,选择与目标任务相似的预训练模型可以获得更好的迁移效果。对于图像检测任务,可以考虑使用在 ImageNet 等大型图像数据集上预训练的模型,例如 ResNet、VGGNet 等。

### 5.1.2 模型迁移和微调

迁移学习的过程主要包括两个步骤:

1. **模型加载和初始化:**将预训练模型加载到目标网络中,并将其作为初始化权重。

2. **微调:**在目标数据集上对加载的预训练模型进行微调,以适应特定任务的需求。

微调过程通常涉及调整网络中部分层的权重,同时保持其他层的权重不变。这有助于模型保留预训练模型中学习到的通用特征,同时针对目标任务进行优化。

**代码示例:**

```python

import darknet

# 加载预训练模型

network = darknet.load_network("yolov3.cfg", "yolov3.weights")

# 初始化目标网络

target_network = darknet.network()

target_network.set_weights(network.weights)

# 微调目标网络

darknet.train_network(target_network, "train.txt", "backup/")

```

0

0