【智能模型构建】:MATLAB神经网络在地基沉降预测中的应用

发布时间: 2024-11-16 16:44:09 阅读量: 23 订阅数: 27

FS.rar_matlab 预测_模糊 神经网络_模糊神经 预测_沉降 预测_预测沉降

# 1. MATLAB神经网络基础

MATLAB作为一款强大的数学计算软件,在神经网络的研究与应用领域同样占有举足轻重的地位。本章节旨在为读者构建起神经网络的初步认识框架,以及它在MATLAB环境中的基础应用,为后续章节的深入探讨打下坚实基础。

## 1.1 MATLAB与神经网络的结合

MATLAB不仅提供了直观的编程环境,还配备了专门针对神经网络设计与训练的工具箱——Neural Network Toolbox。这一工具箱通过封装了各种算法和函数,使得工程师和科研人员能够更加便捷地构建和训练复杂的神经网络模型。

## 1.2 神经网络简介

神经网络是一种受生物神经网络启发的计算模型,通过大量简单计算单元(神经元)的集合,模拟人脑处理信息的方式,解决分类、预测、识别等复杂问题。在MATLAB中,可以利用Neural Network Toolbox中的函数和类,方便地设计网络结构、初始化参数、进行训练和测试。

## 1.3 使用MATLAB进行神经网络开发的优势

在MATLAB中开发神经网络具有以下优势:

- **高效的矩阵运算**:MATLAB的矩阵运算能力是其一大特色,使得神经网络算法的实现更加高效。

- **丰富的算法资源**:MATLAB集成了多种神经网络算法,用户无需从零开始编写复杂代码。

- **友好的用户界面**:通过图形界面可以直观地设计网络结构,调参和分析结果。

- **良好的扩展性**:可以与其他工具箱无缝集成,如统计工具箱、优化工具箱等。

本章为神经网络和MATLAB环境的基本介绍,后续章节将深入讨论神经网络的设计原理与优化方法,并结合MATLAB工具箱具体实现地基沉降预测模型。

# 2. 神经网络理论与设计

## 2.1 神经网络的基本概念

### 2.1.1 神经元模型和网络结构

神经网络是由大量简单的计算单元——神经元(Neuron)互连而成的复杂网络系统。每个神经元可以看作是一个简单的处理器,它接收来自其他神经元的输入信号,通过加权求和以及激活函数处理这些信号,并产生输出信号传递给其他神经元。数学上,一个神经元的输出可以表示为:

\[ y = f\left(\sum_{i=1}^{n}{w_i x_i + b}\right) \]

其中,\( x_1, x_2, ..., x_n \) 是输入信号,\( w_1, w_2, ..., w_n \) 是与输入信号相连接的权重,\( b \) 是偏置项,而 \( f \) 是激活函数。

神经网络的基本结构单元是层(Layer),包括输入层(Input Layer)、隐藏层(Hidden Layer)和输出层(Output Layer)。输入层负责接收外部输入信息,隐藏层负责从输入层接收数据并进行处理,输出层负责生成网络的最终输出。隐藏层可以有多个,不同层之间的神经元通过连接权重相连。

### 2.1.2 激活函数的作用和选择

激活函数是神经网络中引入非线性的关键因素。如果没有激活函数,无论网络有多少层,最终都只能表示线性关系。激活函数的选择对网络的学习能力和预测性能有直接影响。常见的激活函数包括Sigmoid、Tanh、ReLU(Rectified Linear Unit)等。

Sigmoid函数因其在0附近导数最大,输出范围在(0,1)之间,适用于二分类问题,但存在梯度消失问题,且计算量较大。

ReLU函数的输出为0或输入本身,它在正区间内保持线性,在0处不可导。ReLU能缓解梯度消失问题,但在训练过程中可能会导致神经元“死亡”,即输出一直为0。

在选择激活函数时,需要考虑网络的深度、问题的类型以及性能的需求。对于深度学习,ReLU及其变体(如Leaky ReLU、PReLU)通常会是较好的选择。

## 2.2 神经网络的设计方法

### 2.2.1 网络初始化技巧

网络初始化是神经网络设计中极为重要的一环,它关系到网络训练的效率和结果的优劣。合适的初始化方法可以加快网络的收敛速度,避免梯度消失或爆炸。

对于权重的初始化,常用的策略包括随机初始化(如使用高斯分布、均匀分布初始化权重)以及启发式初始化(如He初始化、Xavier初始化)。He初始化和Xavier初始化方法考虑了输入输出神经元数量的影响,分别在ReLU和tanh激活函数下表现较好。

### 2.2.2 权值和偏置的调整策略

在神经网络中,权值和偏置是通过反向传播算法结合梯度下降(或其变体,如Adam、RMSprop)来优化的。调整策略包括学习率的选择、动量项的使用以及权重衰减(正则化)等。

学习率决定了在参数空间中每一步的步长,太大可能导致模型不收敛,太小则可能导致训练过慢。动量项可以加速训练,帮助模型快速穿越局部最小值。权重衰减则通过惩罚大权重值,防止模型过度依赖于某些参数而过拟合。

### 2.2.3 训练、验证和测试数据的划分

为了评估模型的泛化能力,数据集通常被划分为训练集、验证集和测试集。这种划分是通过交叉验证或随机分配的方式实现的,以保证数据的多样性和代表性。

训练集用于模型的学习过程,验证集用于模型训练过程中的调参和早停(Early Stopping)策略,以防止过拟合。测试集则用于最终评估模型性能,不受模型训练过程的影响。

## 2.3 神经网络的学习算法

### 2.3.1 前向传播与误差反向传播

前向传播是神经网络中输入数据通过网络从输入层到输出层的流动过程。在每一层中,输入信号会与权重相乘并加上偏置,然后通过激活函数产生输出信号。

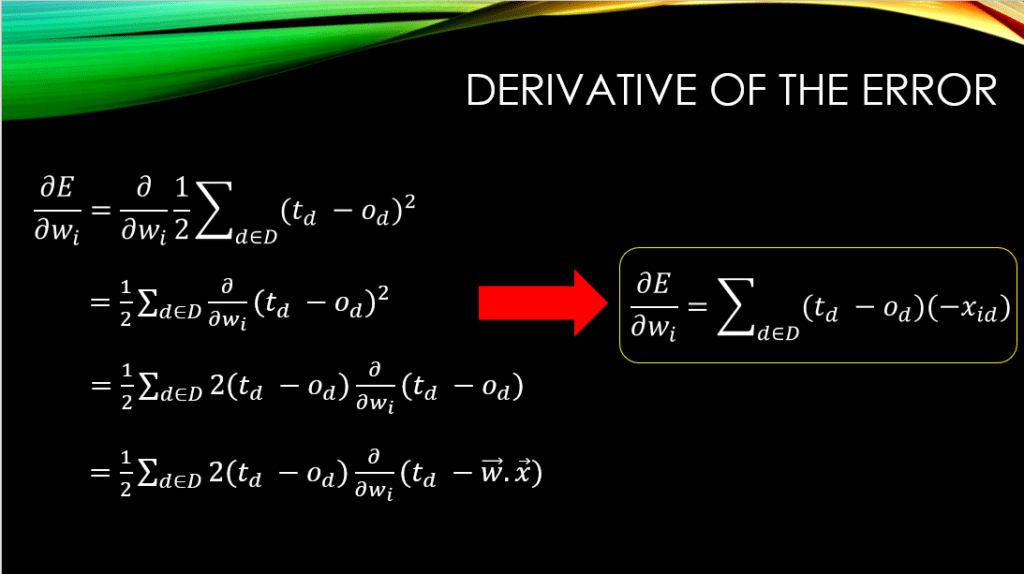

误差反向传播算法(Backpropagation)用于计算输出误差对网络权重和偏置的梯度。通过链式法则,可以高效地计算每层权重的梯度,并进行权重更新。这个过程从输出层开始,一直递归到输入层。

### 2.3.2 动量法和自适应学习率算法

动量法在梯度下降的基础上引入了动量项,其核心思想是模拟物理中的动量概念,以加速学习过程,减少震荡。自适应学习率算法,如Adam算法,结合了RMSprop和Momentum的优点,能够自适应地调整每个参数的学习率。

这些算法的主要优势在于它们能够通过动态调整学习率来加速训练过程,并且在一定程度上解决学习过程中的局部最小值问题。

### 2.3.3 批量归一化和正则化技术

批量归一化(Batch Normalization)是一种在深度学习中广泛应用的技术,能够加快模型的收敛速度并减轻内部协变量偏移。通过对每个批次数据进行归一化处理,批量归一化使得学习过程更加稳定,并且允许使用较高的学习率。

正则化技术(如L1、L2正则化)则是通过在损失函数中添加一个惩罚项来限制模型的复杂度,从而预防过拟合现象。通过惩罚大权重值,正则化能够鼓励模型学习更简洁的表示,有助于提高模型的泛化能力。

以上内容涵盖了神经网络理论与设计的核心概念、设计方法和学习算法。在接下来的章节中,我们将深入了解如何使用MATLAB神经网络工具箱实现这些理论,并探索在地基沉降预测中的应用。

# 3. MATLAB神经网络工具箱应用

在现代工程领域,尤其是在地基沉降预测模型的构建中,MATLAB神经网络工具箱提供了强大的支持。本章节旨在详细介绍如何在MATLAB环境下应用该工具箱进行神经网络的设计、训练与仿真。我们将从工具箱的基本介绍开始,深入探讨数据预处理、网络创建、训练监控等关键环节,使读者能够获得对MATLAB神经网络工具箱全面而深入的理解。

## 3.1 MATLAB神经网络工具箱介绍

### 3.1.1 工具箱的主要功能和界面

MATLAB神经网络工具箱是MATLAB软件家族中的一个重要组件,它集成了一系列专门用于构建、训练和仿真神经网络的函数和工具。该工具箱广泛应用于模式识别、预测分析、信号处理等多个领域。它的主要功能包括但不限于以下几点:

- 神经网络的创建与配置

- 网络的训练与测试

- 网络性能的分析与优化

- 网络的仿真与部署

工具箱的界面直观易用,用户可以通过图形用户界面(GUI)快速访问大部分功能。它提供了直观的网络编辑器、性能评估图、仿真结果可视化等组件,极大地简化了神经网络的设计和应用过程。

### 3.1.2 创建和配置神经网络

使用MATLAB神经网络工具箱创建和配置神经网络涉及以下几个步骤:

1. **选择网络类型**:根据实际问题的需求,选择合适的网络类型。常见的网络类型包括前馈网络、径向基网络、自编码器等。

2. **定义网络结构**:包括输入层、隐藏层、输出层的神经元数量和连接方式。

3. **配置网络参数**:设

0

0