模型验证新方法:MAE在交叉验证中的应用与案例

发布时间: 2024-11-21 13:21:51 阅读量: 38 订阅数: 38

MATLAB 神经网络案例:初始SVM分类与回归.zip

# 1. 模型验证基础

在机器学习领域,模型验证是确保模型性能和可靠性的关键步骤。准确评估模型的泛化能力,可以有效预防模型过拟合或欠拟合,提升模型在实际应用场景中的表现。

## 1.1 模型验证的重要性

模型验证的核心目标是评估模型对于未知数据的预测能力。没有经过验证的模型,其预测结果缺乏可信度,无法在生产环境中稳定工作。验证步骤能够揭示模型在不同数据分布上的表现,是模型迭代和优化的重要依据。

## 1.2 常用的模型验证方法

常用的模型验证方法包括:留出法、K折交叉验证和自助法。留出法是最直观的一种方式,将数据集划分为训练集和测试集,通过测试集对模型性能进行评估。K折交叉验证则通过多次分割数据集进行训练和评估,以获得更稳定的性能指标。

## 1.3 模型泛化能力的评估

模型泛化能力指的是模型对未见样本的预测准确性。评估泛化能力的方法通常涉及到计算模型在验证集上的误差或准确度指标。这些指标可以帮助我们理解模型在面对新数据时的表现,从而对模型做出客观的评价。

在接下来的章节中,我们将具体探讨平均绝对误差(MAE)这一重要的评估指标,并分析其在交叉验证中的应用。

# 2. MAE(平均绝对误差)概述

## 2.1 MAE的定义和计算方法

MAE(Mean Absolute Error),即平均绝对误差,是一种衡量预测值与实际值差异的常用统计量。MAE的计算方法相对直观:首先计算出预测值与真实值之间的每个观测点的绝对误差,然后求得这些绝对误差的平均值。其数学表达式为:

\[ MAE = \frac{1}{n} \sum_{i=1}^{n} |y_i - \hat{y}_i| \]

其中,\( y_i \) 表示第i个观测点的真实值,\( \hat{y}_i \) 表示对应的预测值,n是观测点的总数。

### 计算步骤

1. 对于每个观测点,计算其绝对误差 \( |y_i - \hat{y}_i| \)。

2. 将所有观测点的绝对误差求和。

3. 将求和的结果除以观测点的总数 n。

### 代码示例

以下是一个使用Python计算MAE的简单示例代码:

```python

import numpy as np

# 假设真实值和预测值如下:

true_values = np.array([10, 12, 13, 14, 15])

predicted_values = np.array([9, 13, 12, 14, 16])

# 计算MAE

mae = np.mean(np.abs(true_values - predicted_values))

print("The MAE is:", mae)

```

### 参数解释

- `np.array()` 是NumPy库中的数组创建函数,用于存储真实值和预测值。

- `np.abs()` 函数用于计算绝对值。

- `np.mean()` 函数用于计算平均值。

### 逻辑分析

在上述代码中,通过创建NumPy数组来存储真实值和预测值。接着,使用 `np.abs()` 函数计算每个观测点的绝对误差,并使用 `np.mean()` 计算所有绝对误差的平均值,最终得到MAE的值。

## 2.2 MAE的特点和适用场景

MAE作为一个衡量预测性能的指标,具有其独特的特点。MAE的直观性使它在某些特定的场景下更受欢迎。

### 特点

- **直观性**: MAE直接度量了预测值与实际值之间的平均距离,因此在解释上非常直观。

- **鲁棒性**: MAE对异常值(outliers)不敏感,因为它是基于绝对误差的平均值,不像均方误差(MSE)那样对异常值敏感。

- **简便性**: MAE的计算和理解都非常简单,这使得它在快速分析或初步模型评估时非常方便。

### 适用场景

- **平稳数据**: 当数据波动不大,没有极端的异常值时,MAE是一个很好的选择。

- **预测任务**: 在需要一个简单指标来表示预测准确性时,MAE可以作为一种直接和明确的性能度量。

- **商业决策**: 在商业环境中的某些决策支持系统中,管理者可能更喜欢使用MAE,因为它更加易于理解和解释。

### 代码示例

考虑到MAE对异常值不敏感的特性,在以下代码中,我们引入了一个异常值来观察MAE的变化情况:

```python

import numpy as np

# 假设有几个真实值,其中一个为异常值

true_values = np.array([10, 12, 13, 14, 150])

predicted_values = np.array([9, 13, 12, 14, 16])

# 计算MAE

mae_with_outlier = np.mean(np.abs(true_values - predicted_values))

print("The MAE with an outlier is:", mae_with_outlier)

```

### 逻辑分析

从逻辑分析的角度来看,引入异常值后,MAE的变化较小,说明其对异常值不敏感。这在处理含有离群点的数据集时非常有用,特别是在数据集中异常值具有实际意义且不应该被过度惩罚时。

## 2.3 MAE与其它误差指标的比较

除了MAE之外,还有其他多种衡量预测模型误差的方法,比如均方误差(MSE)和均方根误差(RMSE)。每种误差指标都有其独特的优缺点,适合不同的应用场景。

### 均方误差(MSE)

MSE是预测误差平方的平均值,计算公式为:

\[ MSE = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 \]

MSE的一个主要缺点是对异常值高度敏感,因为误差平方会放大较大的误差值。

### 均方根误差(RMSE)

RMSE是MSE的平方根,计算公式为:

\[ RMSE = \sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2} \]

RMSE与MSE类似,但它的优点在于量纲与被预测的量一致,便于解释,同时也对异常值敏感。

### 比较

MAE相对于MSE和RMSE具有以下优势:

- **鲁棒性**: MAE对异常值不敏感,因为它使用的是误差的绝对值而不是平方。

- **适用性**: 对于那些异常值具有重要业务意义且不希望被过分惩罚的场景,MAE是一个更好的选择。

然而,MAE也有其局限性:

- **无偏性**: MAE不惩罚大的预测误差,这可能导致模型优化不充分。

- **信息损失**: 使用绝对值可能导致信息的损失,因为它忽略了误差的方向性。

### 表格对比

下面是一个误差指标比较的表格:

| 指标 | 计算方式 | 对异常值的敏感度 | 适用场景 |

| --- | --- | --- | --- |

| MAE | 平均绝对误差 | 较低 | 数据相对平稳,异常值重要 |

| MSE | 平均平方误差 | 高 | 数据波动较大,异常值不重要 |

| RMSE | 均方根误差 | 较高 | 数据波动较大,需要与原单位比较 |

通过以上的分析和比较,我们可以根据实际问题的需要选择最适合的误差指标。在第三章中,我们将深入探讨交叉验证的基本理论,并在后续的章节中分析MAE在交叉验证中的应用及其在不同模型中的效果对比。

# 3. 交叉验证的基本理论

## 3.1 交叉验证的概念

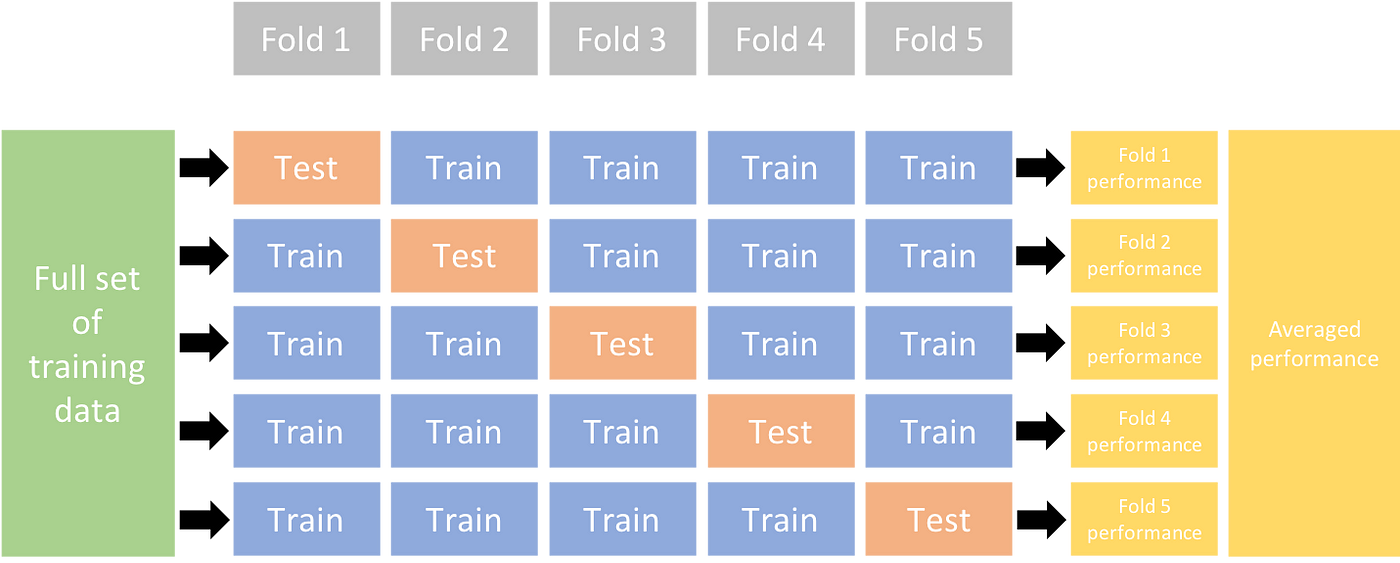

交叉验证(Cross-Validation)是一种评估模型泛化性能的方法,通过将数据集分成互补的子集,并用其中一些子集来训练模型,其余的子集用于测试模型。这种方法尤其适用于数据量较少的情况,可以充分利用有限的数据资源。最常用的交叉验证类型是K折交叉验证。

### 3.1.1 交叉验证的目标

交叉验证的目标是减少模型评估的方差,从而得到一个更稳定和更准确的性能估计。在一个数据集上进行单次分割可能导致测试集具有特殊的性质,这可能导致对模型性能的不准确估计。

### 3.1.2 交叉验证的基本步骤

1. 将数据集随机分为K个大小相同的子集。

2. 选择其中一个子集作为测试集,其余的子集合并作为训练集。

3. 在训练集上训练模型,并在测试集上进行评估。

4. 重复步骤2和3,直到每个子集都作为一次测试集使用过。

5. 计算K次测试结果的平均值作为最终评估指标。

### 3.1.3 交叉验证的重要性

交叉验证可以帮助我们了解模型对未知数据的泛化能力。通过重复的训练和测试过程,我们可以得到对模型性能更加全面和准确的评估。

## 3.2 交叉验证的类型和选择

根据不同的分割方式,交叉验证有不同的类型,每种类型适用于不同的场景。

### 3.2.1 K折交叉验证

K折交叉验证是最常见的一种方式,其中K是一个预先设定的值。数据被分成K个子集,每次使用一个子集作为测试集,其他作为训练集。这种方法平衡了计算成本和模型性能评估的可靠性。

### 3.2.2 留一交叉验证(LOOCV)

留一交叉验证是一种极端形式的K折交叉验证,其中K等于样本数。每次使用一个样本作为测

0

0