Python大数据处理:使用Hadoop和Spark处理海量数据,挖掘数据价值

发布时间: 2024-06-20 10:30:06 阅读量: 77 订阅数: 29

数据算法:Hadoop/Spark大数据处理技巧

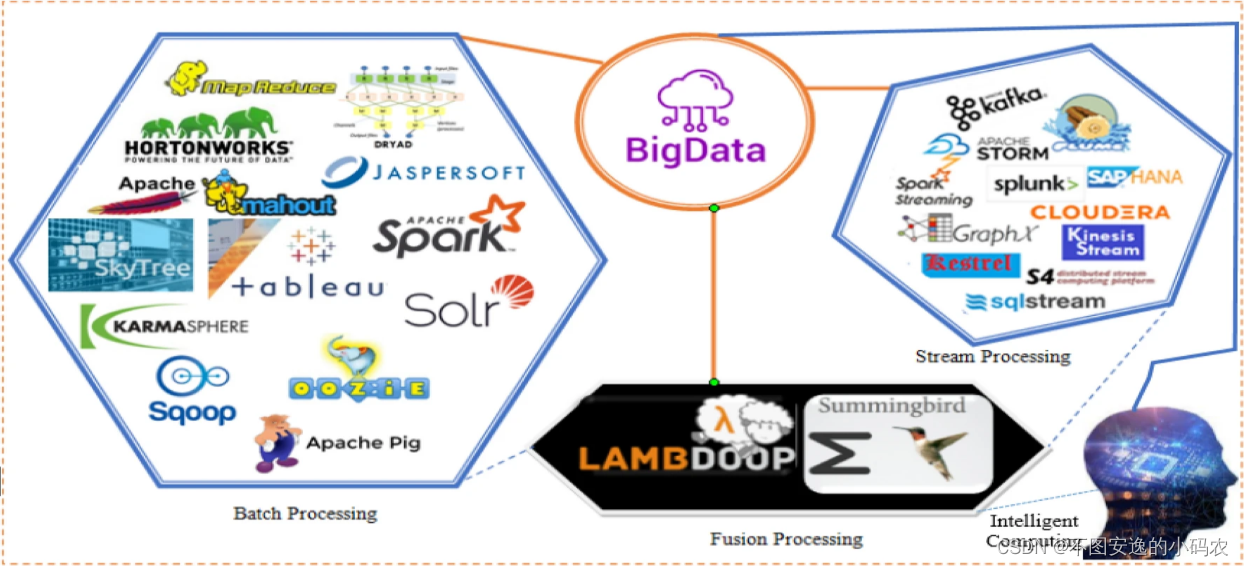

# 1. 大数据处理概述**

大数据处理是指处理海量、多样化、高速增长的数据,这些数据传统数据处理工具难以处理。大数据处理的目的是从这些数据中提取有价值的见解和信息,以支持决策制定和业务运营。

大数据处理涉及以下关键技术:

* **分布式计算:**将数据分布在多个服务器上,并行处理以提高效率。

* **数据存储:**使用专门设计的分布式文件系统,如 Hadoop 分布式文件系统 (HDFS),来存储和管理海量数据。

* **数据分析:**使用各种工具和技术,如 MapReduce 和 Spark,分析和处理数据以提取有价值的信息。

# 2. Hadoop基础

### 2.1 Hadoop分布式文件系统(HDFS)

#### 2.1.1 HDFS架构和原理

HDFS是一个分布式文件系统,它将文件存储在集群中的多个节点上。HDFS采用主从架构,由一个NameNode和多个DataNode组成。

NameNode是HDFS的元数据服务器,它负责管理文件系统的命名空间和文件块的位置信息。DataNode是HDFS的数据存储节点,它们存储文件块并负责数据的可靠性。

HDFS将文件划分为大小为128MB的数据块,并将其存储在DataNode上。每个数据块都有多个副本,以确保数据的可靠性。NameNode负责管理数据块的副本放置,以优化数据访问和容错能力。

#### 2.1.2 HDFS数据块管理

HDFS的数据块管理机制包括:

* **数据块复制:**HDFS将每个数据块复制到多个DataNode上,默认情况下是3个副本。这确保了数据的可靠性,即使某个DataNode发生故障,数据仍然可用。

* **数据块放置:**NameNode负责决定将数据块放置在哪些DataNode上。它考虑了数据块的副本数、DataNode的可用性、网络拓扑等因素,以优化数据访问和容错能力。

* **数据块故障处理:**如果某个DataNode发生故障,NameNode会检测到并启动数据块恢复过程。它会从其他DataNode上获取数据块的副本,并将其复制到新的DataNode上。

### 2.2 MapReduce编程模型

#### 2.2.1 MapReduce工作流程

MapReduce是一个分布式编程模型,它用于处理大规模数据集。MapReduce工作流程包括两个阶段:

* **Map阶段:**Map函数将输入数据集划分为更小的块,并对每个块应用用户定义的映射函数。映射函数输出键值对。

* **Reduce阶段:**Reduce函数对Map阶段输出的键值对进行聚合或处理。Reduce函数输出最终结果。

#### 2.2.2 MapReduce作业配置

MapReduce作业的配置包括:

* **输入格式:**指定输入数据集的格式,例如文本文件、SequenceFile等。

* **Map函数:**用户定义的映射函数,它将输入数据集划分为更小的块并应用映射逻辑。

* **Reduce函数:**用户定义的聚合或处理函数,它对Map阶段输出的键值对进行处理。

* **输出格式:**指定输出数据集的格式,例如文本文件、SequenceFile等。

**代码块:**

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class Map extends Mapper<Object, Text, Text, IntWritable> {

@Override

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split(" ");

for (String word : words) {

context.write(new Text(word), new IntWritable(1));

}

}

}

public static class Reduce extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException

```

0

0