Hadoop分布式文件系统HDFS:分块存储的深度探讨

发布时间: 2024-10-27 01:06:14 阅读量: 17 订阅数: 23

# 1. Hadoop分布式文件系统(HDFS)概述

## 1.1 HDFS的定义与用途

Hadoop分布式文件系统(HDFS)是Hadoop大数据处理框架的核心组件之一,用于存储大规模数据集。它专为在廉价硬件上运行而设计,能够处理超大数据量,并提供高吞吐量的数据访问。HDFS支持应用数据的高容错性,适合运行在商业硬件集群上。

## 1.2 HDFS的基本特性

HDFS具备高容错性、高吞吐量、大数据处理能力等特性。它通过在多个节点之间自动管理数据副本,保证了数据的可靠性,即使某些节点失败,也不会影响数据的存取。

## 1.3 HDFS在企业中的应用场景

在企业中,HDFS广泛用于日志分析、数据仓库、机器学习等场景。其设计目标是能够存储PB级别的数据,并为这些数据的快速处理和分析提供支持,使得企业能够从海量数据中提取有价值的信息。

通过本章的概述,我们将建立起对HDFS作为一个可靠、高效的分布式存储解决方案的初步认识,并为进一步深入探讨其架构细节和优化策略打下基础。

# 2. HDFS的理论基础与架构分析

## 2.1 HDFS的核心概念

### 2.1.1 分布式存储的基本原理

分布式存储系统是在多个物理位置上分散存储数据的系统,通过网络连接的多台计算机共同参与数据的存储工作。在分布式存储系统中,数据被切分成块(chunks)或分片(shards),并以副本的形式分布在集群的多个节点上。分布式存储系统的设计目标是通过提供冗余、并行处理和高容错性来提高系统的可靠性、可扩展性和性能。

**冗余**确保了当某个节点发生故障时,数据仍然可以从其它节点获得。为了实现冗余,存储系统会创建数据的多个副本,并将它们放置在不同的节点上。

**并行处理**允许同时从多个节点读写数据,这有助于提升大数据处理速度,是分布式存储系统处理大量数据的关键所在。

**高容错性**是通过分布式架构和数据冗余实现的,即使部分节点失效,系统依然能继续运行,不丢失数据。

分布式存储系统通常依赖于一套复杂的分布式算法来管理数据的分布、备份、恢复和负载均衡等。

### 2.1.2 HDFS的设计目标和特点

Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件之一,专为在廉价的硬件上运行而设计,具备以下设计目标和特点:

- **高容错性**:HDFS可以运行在商业硬件上,通过数据块的复制实现容错。

- **流式数据访问模式**:HDFS设计用于批处理作业,适合于大规模数据集的高吞吐量访问。

- **简单的一致性模型**:HDFS提供了一个宽松的一致性模型,适合于大规模数据集的分析任务。

- **硬件的可伸缩性**:HDFS可以通过增加节点来水平扩展,其性能随着节点数量的增加而提高。

- **大数据处理能力**:HDFS适合于处理大量数据,允许应用程序运行在数据所在位置,减少网络I/O。

HDFS的独特之处在于它在设计时考虑了失败的常态化。HDFS假设节点故障是常态而非异常情况,因此系统不断地检查节点健康状态,并在检测到故障时自动进行数据复制和故障转移。

## 2.2 HDFS的架构组件

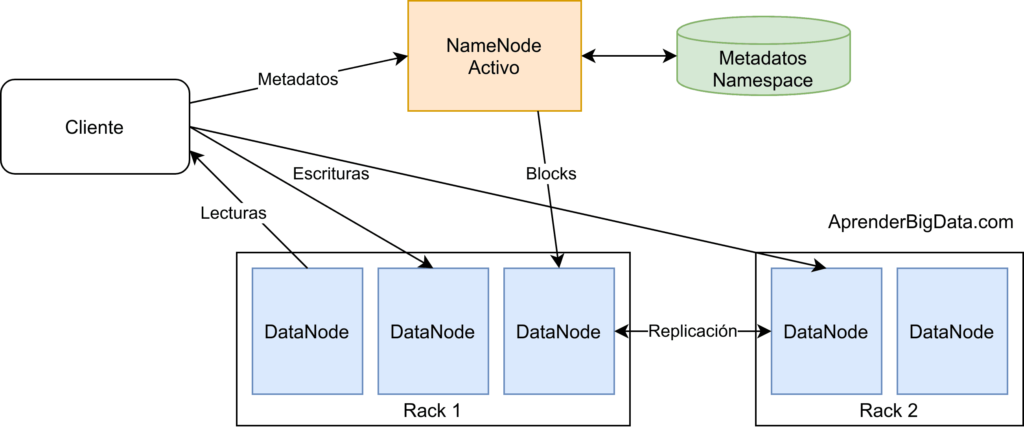

### 2.2.1 NameNode的角色与功能

NameNode是HDFS的主服务器,负责管理文件系统的命名空间和客户端对文件的访问。它记录了每个文件中各个块所在的DataNode信息。NameNode的角色非常关键,是整个HDFS集群的核心。

**核心功能包括:**

- **管理命名空间**:维护文件系统树及整个树内所有的文件和目录。这些信息以元数据形式存储在NameNode的内存中。

- **处理客户端请求**:处理客户端对文件系统的读写请求。对文件进行创建、删除、重命名等操作时,客户端首先与NameNode交互。

- **元数据管理**:存储文件系统元数据,如文件权限、访问时间、块映射信息等。

### 2.2.2 DataNode的工作机制

DataNode是HDFS中的工作节点,实际存储数据。DataNode负责存储和检索块数据,以及执行数据块的创建、删除和复制等操作。

**工作原理包括:**

- **数据存储**:每个DataNode节点存储一部分数据块。客户端可以与任意一个DataNode进行数据交换。

- **状态汇报**:DataNode周期性地向NameNode发送心跳信号,以及它们存储的数据块的列表。

- **故障恢复**:当DataNode节点失效时,NameNode会从其他节点中找到副本,并指挥数据的恢复。

### 2.2.3 客户端与HDFS的交互流程

客户端与HDFS进行交互的流程涉及以下几个关键步骤:

- **文件系统元数据操作**:客户端首先与NameNode交互,获取文件或目录的元数据,例如块的位置信息。

- **数据读写操作**:客户端根据NameNode提供的信息,直接与DataNode进行数据的读写操作。

- **数据缓存**:HDFS客户端实现了一个数据缓存机制,可以提高读写性能。对于读操作,客户端首先尝试从缓存中读取数据,如果缓存中没有,则从DataNode读取,并缓存到本地。

- **命名空间操作**:客户端可以创建、删除、重命名文件或目录,并与NameNode交互执行这些命名空间级别的操作。

## 2.3 HDFS的数据一致性模型

### 2.3.1 原子性与持久性保证

在HDFS中,原子性保证了文件操作的完整性和可靠性,例如创建文件时,操作要么完全成功,要么完全不发生。当一个文件被写入时,它首先被写入到临时位置,成功之后再被命名。如果操作失败,那么临时文件会被删除,用户不会看到不完整的文件。

持久性保证数据一旦被写入HDFS,就不会因为系统故障而丢失。HDFS通过冗余存储来实现持久性,每个文件块会被自动复制到多个DataNode上。如果NameNode发生故障,由于元数据的持久化存储和DataNode的副本策略,数据依然可以被恢复。

### 2.3.2 读写操作的数据一致性策略

HDFS通过写前日志(Write-Ahead Log, WAL)机制保证数据一致性。当客户端写入数据时,首先会在WAL中记录这次操作。数据块本身也会被写入到DataNode上。写操作只有在WAL和DataNode上都成功完成后才算完成。这确保了即使在系统

0

0