【Python性能提升秘籍】:多线程与多进程的并发处理艺术

发布时间: 2025-01-03 12:24:54 阅读量: 10 订阅数: 10

Python并发编程详解:多线程与多进程及其应用场景

# 摘要

本文详细探讨了Python中的并发编程技术,包括多线程和多进程编程的概念、高级应用以及性能优化。首先概述了并发编程的基本概念,随后深入理解多线程编程的基础与高级应用,并通过实战演练展示了其在不同场景下的应用。接着,本文转向多进程编程,探讨了进程间通信和管理,同时提供了多进程实战应用案例。在此基础上,文章对比了多线程与多进程的优劣,并探讨了如何在实际应用中选择合适的并发模型。最后,本文介绍了性能优化和调试并发程序的方法,包括性能分析工具的使用、性能瓶颈的优化策略,以及并发编程的调试技巧,旨在帮助开发者提升并发程序的性能和稳定性。

# 关键字

Python;并发编程;多线程;多进程;性能优化;调试技巧

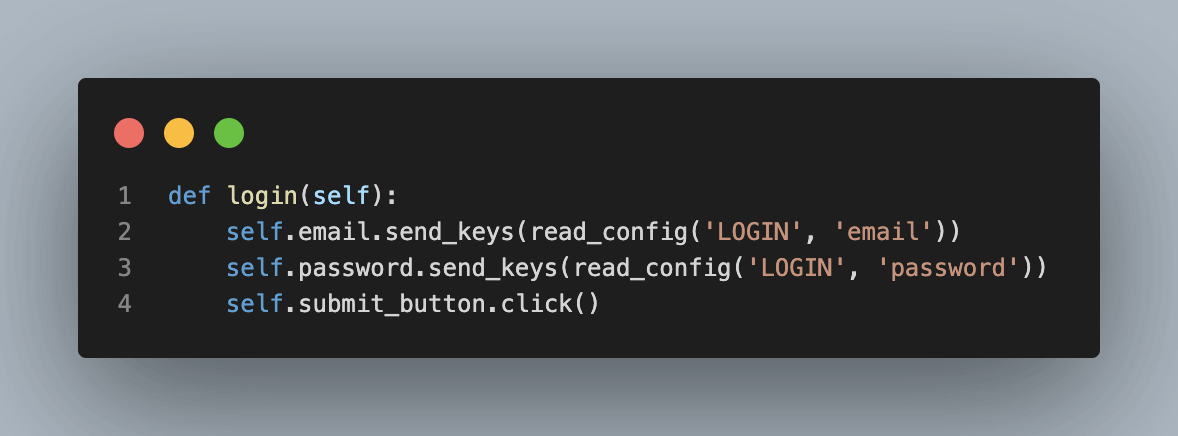

参考资源链接:[Python自动化抢座脚本:登录与定时预约](https://wenku.csdn.net/doc/6401ad34cce7214c316eeab9?spm=1055.2635.3001.10343)

# 1. Python并发编程概述

在当今计算密集型与数据密集型任务日益增长的背景下,高效利用系统资源,提升程序性能,是每个软件开发者都需要关注的问题。**Python并发编程**,作为一个能够显著提高程序执行效率的编程范式,在IT领域显得尤为重要。它包括多线程、多进程和异步编程等技术,旨在利用现代计算机的多核处理器能力,使得程序在执行任务时,能够在不同的处理单元上同时运行多个任务,从而达到加速处理过程的目的。

## 1.1 并发编程的需求背景

随着业务需求的不断增长,传统的串行编程模式越来越难以满足高效、快速响应用户需求的目标。**并发编程**能够实现同时执行多个任务,对用户请求进行快速响应,提高程序的整体效率和用户体验。

## 1.2 并发编程的基本概念

**并发**指的是同时拥有两个或多个序列的执行能力,可以是真实的同时,也可以是表面上的同时。而**并行**则是指真正的同时执行。在计算机科学中,多线程和多进程是实现并发编程的两种主要方式,它们各有优缺点,适用于不同的场景。

## 1.3 Python中的并发选择

Python由于其简洁的语法和丰富的库支持,使得并发编程变得相对容易。它提供了多种并发编程的实现方式,包括但不限于`threading`模块实现多线程,`multiprocessing`模块实现多进程,以及`asyncio`模块实现异步编程。掌握这些并发编程工具,是提高Python程序性能的关键。

# 2. 深入理解多线程编程

## 2.1 Python中的线程基础

### 2.1.1 线程的概念和线程创建

在操作系统中,线程是CPU调度和分派的基本单位,也是程序执行流的最小单元。线程的存在可以让我们实现并行计算,提高程序运行效率。Python中,线程的创建相对简单,主要通过`threading`模块来实现。一个线程的生命周期通常包括创建、就绪、运行、阻塞和终止五个状态。

创建线程最基本的类是`threading.Thread`,它继承自`threading._Thread`类。通过继承`Thread`类,并重写其`run()`方法,我们可以定义线程执行的操作。一个简单的线程创建示例如下:

```python

import threading

def print_numbers():

for i in range(1, 6):

print(i)

# 创建线程实例

t = threading.Thread(target=print_numbers)

# 启动线程

t.start()

# 等待线程结束

t.join()

```

### 2.1.2 线程的同步机制

由于多个线程可以同时运行,在并发执行时,可能会遇到资源竞争和数据不一致的问题。Python提供了多种同步机制来解决这一问题,其中最常用的是锁(Lock)、信号量(Semaphore)和事件(Event)。

**锁(Lock)**是最基本的同步机制。它有两个状态:锁定和未锁定。如果一个线程获取了一个锁,那么其他尝试获取这个锁的线程将会阻塞,直到锁被释放。

```python

import threading

lock = threading.Lock()

def my_thread():

lock.acquire() # 尝试获取锁

print("This is my thread.")

lock.release() # 释放锁

threads = [threading.Thread(target=my_thread) for _ in range(5)]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

在上面的代码中,我们创建了五个线程,并且让它们共享同一个锁。这个锁保证了打印操作的线程安全,避免了输出的混乱。

**信号量(Semaphore)**是一种更高级的同步机制。它可以允许多个线程访问资源,限制访问的最大数量。

**事件(Event)**用来阻塞一组线程,直到某个条件成立。其他线程设置事件,被阻塞的线程检测到事件被设置后,可以继续执行。

## 2.2 高级线程应用

### 2.2.1 线程池的使用

线程池是一种多线程处理形式,它预先创建若干个可执行的线程放入池中,需要时直接运行。线程池可以有效控制最大并发数,提高资源的使用效率,减少因为线程创建和销毁带来的性能开销。

在Python中,我们可以使用`concurrent.futures`模块的`ThreadPoolExecutor`来方便地创建线程池。下面是一个线程池使用的基本示例:

```python

from concurrent.futures import ThreadPoolExecutor

def task(n):

print(f"Processing {n}")

with ThreadPoolExecutor(max_workers=3) as executor:

# 通过map方法提交任务到线程池

for number in range(5):

executor.map(task, [number])

```

在上述代码中,我们创建了一个最大工作者数为3的线程池,并通过`map`方法将任务分配给线程池中的线程执行。

### 2.2.2 线程安全和锁的高级用法

在多线程编程中,线程安全是一个重要议题。线程安全意味着多个线程可以同时访问数据或者修改数据,但数据的完整性和一致性不会受到影响。Python的锁机制提供了保障线程安全的一种方式,但锁的不当使用也会导致死锁等问题。因此,了解锁的高级用法是实现高效线程同步的关键。

**递归锁(RLock)**是一种可重入的锁。它允许同一个线程在不释放锁的情况下重复获取该锁,这对于递归函数中的线程安全特别有用。

```python

import threading

lock = threading.RLock()

def recursive_task(n):

with lock:

print(f"Processing {n}")

if n > 0:

recursive_task(n - 1)

recursive_task(5)

```

在上述代码中,我们使用`RLock`来保证`recursive_task`函数在递归调用时的安全。

## 2.3 多线程实战演练

### 2.3.1 多线程在I/O密集型任务中的应用

I/O密集型任务通常指的是程序的运行过程中大部分时间都在等待外部设备完成输入输出操作。这类任务的CPU利用率通常不高,因为大部分时间都在等待。对于这类应用,使用多线程可以显著提高程序的效率。

在Python中,可以使用`threading`模块来实现多线程。下面是一个使用多线程处理I/O密集型任务的例子:

```python

import requests

import threading

def fetch_url(url):

response = requests.get(url)

print(f"Fetched {url} with status code {response.status_code}")

urls_to_fetch = [

"http://example.com",

"http://example.org",

"http://example.net",

# 更多URLs...

]

threads = [threading.Thread(target=fetch_url, args=(url,)) for url in urls_to_fetch]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

在这个例子中,我们创建了多个线程来并行地获取不同的网站数据,从而提高了整体的下载效率。

### 2.3.2 多线程在CPU密集型任务中的应用

CPU密集型任务通常是指程序的运行过程中大部分时间都在进行CPU运算。这类任务的I/O操作较少,对CPU的利用率较高。对于这类应用,使用多线程也可以提高程序的效率,但由于Python中的全局解释器锁(GIL)的存在,多线程对CPU密集型任务的性能提升有限。

然而,我们可以通过一些技巧来突破GIL的限制,例如使用`multiprocessing`模块或者第三方库`pytorch`进行并行计算。下面是一个使用多线程处理CPU密集型任务的例子:

```python

import threading

import time

def cpu_bound_task(n):

result = 0

for i in range(1, n):

result += i

print(f"Task {n} result: {result}")

threads = [threading.Thread(target=cpu_bound_task, args=(i * 1000000,)) for i in range(10)]

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

在这个例子中,我们创建了多个线程来并行地执行CPU密集型的计算任务。需要注意的是,由于GIL的影响,实际上这些线程并不会真的并行执行,而是会轮流占用CPU。在处理CPU密集型任务时,可能需要考虑使用多进程或考虑其他语言的实现,比如Cython或者使用C扩展模块。

# 3. 全面掌握多进程编程

多进程编程是现代软件开发中应对并行计算需求的关键技术之一。在CPU密集型任务处理上,多进程编程提供了比多线程更大的优势,特别是在多核处理器上。在本章中,我们将深入了解Python中的进程基础、高级进程应用以及多进程实战演练。

## 3.1 Python中的进程基础

### 3.1.1 进程的概念和进程创建

进程是操作系统中运行的一个独立的执行单元,它包含了程序代码及代码运行时所需的所有资源。进程创建在Python中通常使用`multiprocessing`模块来完成。模块中的`Process`类允许我们创建新的进程实例。

```python

import multiprocessing

import time

def worker(name):

print(f"Process {name}: starting")

time.sleep(2)

print(f"Process {name}: finishing")

if __name__ == '__main__':

processes = []

for i in range(5):

p = multiprocessing.Process(target=worker, args=(i,))

processes.append(p)

p.start()

for p in processes:

p.join()

```

上述代码创建了5个子进程,每个子进程运行`worker`函数。`multiprocessing`模块的`Process`类负责创建进程,并通过`start()`方法启动。`join()`方法确保主进程等待所有子进程执行完成。

### 3.1.2 进程间的通信(IPC)

在多进程环境中,进程间通信(IPC)是实现数据共享和同步的关键。Python中的`multiprocessing`模块提供了多种IPC机制,如`Queue`, `Pipe`, `Value`和`Array`。

以下是一个使用`Queue`的例子,它演示了如何在进程间安全地传递数据:

```python

from multiprocessing import Process, Queue

def f(q):

q.put([42, None, 'hello'])

if __name__ == '__main__':

q = Queue()

p = Process(target=f, args=(q,))

p.start()

print(q.get()) # 输出: [42, None, 'hello']

p.join()

```

该例子展示了如何使用队列(`Queue`)在进程间传递一个包含列表的消息。`Queue`是线程和进程安全的,因此它在并发编程中非常有用。

## 3.2 高级进程应用

### 3.2.1 进程池的使用

进程池是一种管理多个进程的高级机制,它通过复用一组预创建的进程来优化资源利用。进程池适用于那些需要执行大量相似任务的情况,能够提高执行效率。

```python

from multiprocessing import Pool

def f(x):

return x*x

if __name__ == '__main__':

with Pool(5) as p:

results = p.map(f, range(10))

print(results)

```

在这个例子中,我们使用`Pool`创建了一个有5个进程的进程池,并使用`map`方法将函数`f`应用于一系列输入上。这与Python内置的`map`函数类似,不同之处在于它是并行执行的。

### 3.2.2 进程安全和管理

进程安全是指在多进程环境中,资源的使用不会导致竞争条件或不一致的状态。Python中的`multiprocessing`模块提供了锁(`Lock`)、事件(`Event`)、信号量(`Semaphore`)等多种同步机制。

以下示例使用锁来保证进程间的同步:

```python

from multiprocessing import Process, Lock

def f(l, i):

l.acquire()

try:

print('hello world', i)

finally:

l.release()

if __name__ == '__main__':

lock = Lock()

processes = []

for i in range(10):

p = Process(target=f, args=(lock, i))

processes.append(p)

p.start()

for p in processes:

p.join()

```

在这个例子中,所有进程共享同一个锁对象。每次执行`f`函数时,先尝试获取锁,保证同一时间只有一个进程能执行打印语句。

## 3.3 多进程实战演练

### 3.3.1 多进程在并行计算中的应用

并行计算是多进程应用中最常见的场景之一。当我们有多个CPU密集型任务时,可以利用多进程实现真正的并行执行,从而加速计算过程。

```python

from multiprocessing import Process

import numpy as np

def calculate_pi(n_terms):

total = 0

for i in range(n_terms):

total += ((-1)**i) / (2*i + 1)

return total * 4

if __name__ == '__main__':

n_terms = 1000000

processes = []

for i in range(4):

p = Process(target=calculate_pi, args=(n_terms,))

processes.append(p)

p.start()

results = [p.join() for p in processes]

pi_approx = sum(results) / len(results)

print(f'Approximated Pi value: {pi_approx}')

```

在这个例子中,我们通过4个进程计算π的近似值。每个进程计算一部分项的累加值,最终结果是各进程累加值的平均值。

### 3.3.2 多进程在服务端程序中的应用

服务端程序常常需要处理多个并发的客户端连接。多进程模型可以通过为每个客户端创建一个单独的进程来处理并发,这对于CPU密集型任务尤其有效。

```python

from multiprocessing import Process

import socket

def handle_client(conn, addr):

print(f"Connected by {addr}")

while True:

data = conn.recv(1024)

if not data:

break

conn.sendall(data)

conn.close()

if __name__ == '__main__':

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

server_socket.bind(('localhost', 5000))

server_socket.listen()

while True:

conn, addr = server_socket.accept()

p = Process(target=handle_client, args=(conn, addr))

p.start()

```

该代码片段创建了一个简单的TCP服务器,每当有新的客户端连接,就为它创建一个新的进程。这样,服务器可以同时处理多个连接,每个连接在单独的进程中运行。

在本章节中,我们深入讨论了多进程编程的核心概念、高级用法以及实战演练,展示了如何在不同应用场景下高效地利用多进程来实现并行计算和服务端程序的并发处理。多进程编程提供了强大的并行处理能力,适用于CPU密集型任务和需要处理大量并发连接的场景。

# 4. 多线程与多进程的混合使用

## 4.1 多线程与多进程的对比和选择

### 4.1.1 各自的优势与局限性

多线程和多进程是并发编程中的两种主要技术,它们各有优势和局限性。

线程是最小的执行单元,线程之间共享内存空间,线程间的通信成本较低,适用于频繁交互的场景。在I/O密集型任务中,线程的切换成本低,因此效率较高。然而,线程的并发限制通常由全局解释器锁(GIL)引起,在执行CPU密集型任务时,GIL可能会成为瓶颈。

进程是操作系统分配资源的基本单位,每个进程有独立的内存空间,相互间隔离,不存在GIL限制。这使得进程更适合CPU密集型计算,因为它们可以充分利用多核CPU的优势。进程间的通信(IPC)成本高于线程间通信,因为需要通过进程间通信机制来交换数据。

### 4.1.2 实际场景的选择策略

在实际应用中,选择多线程还是多进程,需要根据应用场景来定。I/O密集型任务中,如网络服务器、文件服务器,建议优先使用多线程。CPU密集型任务中,如科学计算、图像处理,推荐使用多进程。

混合使用多线程和多进程可以结合两者的优点。例如,可以使用多进程来执行CPU密集型任务,同时使用多线程来处理I/O操作,从而提高整体性能。

## 4.2 混合并发模型的实现

### 4.2.1 多线程与多进程协作的策略

混合并发模型的实现需要合理安排多线程和多进程之间的协作。一种策略是使用进程作为主执行单元,负责资源密集型的任务,同时利用线程处理I/O密集型的辅助任务。

这种策略下,可以创建一个进程池来管理CPU密集型的任务,每个进程执行特定的计算任务。在进程内部,可以创建多个线程来处理与外部的I/O通信,例如读取文件、接收网络请求等。

### 4.2.2 混合模型的性能考量

在设计混合模型时,需要考虑进程和线程的创建和销毁开销。频繁地创建和销毁进程或线程可能会导致性能下降,因此应当合理地控制它们的数量。

此外,混合模型的性能优化还需要考虑到进程和线程间的通信效率。例如,可以减少进程间通信的次数,或者采用更高效的消息传递机制来减少延迟。

## 4.3 混合并发模型的实战应用

### 4.3.1 混合模型在Web服务器中的应用

在Web服务器中,混合模型可以有效地处理并发请求。可以使用多个进程来处理计算密集型的任务,如处理复杂的查询或渲染动态内容。同时,使用线程来处理I/O操作,如读写数据库或文件系统,以及响应用户的HTTP请求。

例如,可以使用一个主进程来监听网络请求,每当接收到请求时,主进程创建一个新的线程来处理该请求。对于需要大量计算的任务,主线程可以将任务提交给工作进程池处理,然后将结果返回给用户。

### 4.3.2 混合模型在大数据处理中的应用

在大数据处理中,混合并发模型可以用于处理数据的预处理和分析。数据预处理往往涉及到文件的读写操作和数据转换,这些操作适合用多线程来完成,因为它们通常是I/O密集型的。

一旦数据被加载到内存中,就可以使用多进程来执行数据分析和计算密集型的算法。例如,在机器学习中,数据预处理后的模型训练可以通过进程池来并行化,以加速整个训练过程。

在实际应用中,混合并发模型可以灵活地应用于各种场景,具体实现需要根据任务特点和硬件资源来定制。

在下一章节,我们将深入探讨性能优化与调试技巧,这将是完成并发程序的重要环节。

# 5. 性能优化与调试技巧

## 5.1 性能分析工具的使用

在优化并发程序性能之前,了解程序的瓶颈所在至关重要。性能分析工具可以帮助我们定位到代码中效率低下的部分。在Python中,我们有几个强大的工具可以使用。

### 5.1.1 Python内置的性能分析工具

Python提供了内置的模块`cProfile`来分析代码的性能。它是一个非常方便的工具,可以让我们了解程序运行的时间都花在了哪里。使用`cProfile`非常简单,可以直接在命令行中运行,也可以在Python代码中集成。

```python

import cProfile

def some_function():

# 这里是一些计算密集型的操作

pass

cProfile.run('some_function()')

```

上面的代码会执行`some_function`函数,并输出该函数的性能统计信息。

### 5.1.2 第三方性能分析工具的介绍和使用

除了内置工具之外,还有一些第三方工具可以提供更详细的性能分析。比如`line_profiler`可以分析具体代码行的性能,而`memory_profiler`可以分析内存使用情况。使用这些工具时,通常需要在代码中进行一些设置,然后运行它们来获得性能报告。

安装`line_profiler`可以通过`pip`进行:

```bash

pip install line_profiler

```

之后,你可以使用`kernprof`命令来运行你的程序,并通过`-l`参数来开启行级分析:

```bash

kernprof -l -v my_script.py

```

这样,你就可以得到一个关于你的脚本每行代码执行时间的详细报告。

## 5.2 常见性能瓶颈与优化方案

### 5.2.1 GIL全局解释器锁对性能的影响

Python中的全局解释器锁(GIL)是众所周知的性能瓶颈,它限制了线程在同一时刻只允许有一个线程执行字节码。这意味着即使多核处理器也无法同时运行多个线程。

优化策略通常包括以下几点:

- 使用多进程代替多线程,从而绕开GIL的限制。

- 利用Python的`multiprocessing`模块,可以轻松实现进程级并发。

- 如果仍然需要使用多线程,确保I/O密集型任务成为瓶颈,而非CPU密集型任务。

### 5.2.2 I/O和内存使用优化

优化I/O和内存使用可以显著提高程序的响应速度和吞吐量。针对I/O密集型任务,可以使用异步I/O或者线程池来提高效率。针对内存使用,可以分析程序的内存占用,并采取以下措施:

- 清理不再使用的对象,减少内存泄漏。

- 使用生成器来处理大数据集,避免一次性加载过多数据到内存。

- 使用内存分析工具如`objgraph`或`memory_profiler`来诊断内存使用情况。

## 5.3 并发编程的调试方法

### 5.3.1 多线程和多进程的调试技巧

调试并发程序要比单线程程序复杂得多,因为涉及到线程或进程的同步问题。以下是一些调试并发程序的技巧:

- 使用日志记录来跟踪并发任务的执行流程。

- 使用断点调试时,确保你理解调试器如何处理并发环境中的中断。

- 利用`threading`和`multiprocessing`模块提供的条件变量和事件,来控制特定的调试状态。

- 使用Python的`pdb`模块来进行交互式调试,它也支持多线程。

### 5.3.2 并发程序的常见错误及预防

并发编程中常见的错误包括死锁、竞态条件和资源冲突等。预防这些错误,可以采取以下措施:

- 避免无限等待资源的情况,合理使用超时。

- 确保资源锁定后及时释放,避免死锁。

- 在设计时使用合适的同步机制,如锁、信号量和条件变量。

- 进行彻底的测试,包括压力测试和并发测试,确保程序的健壮性。

通过这些技巧和方法,我们能够更好地理解和优化并发程序,提高其性能和稳定性。

0

0