Scipy.optimize参数调优技巧:2大策略,提升优化效率和准确性

发布时间: 2024-10-13 20:33:19 阅读量: 121 订阅数: 23

python科学计算之scipy——optimize用法

# 1. Scipy.optimize参数调优概述

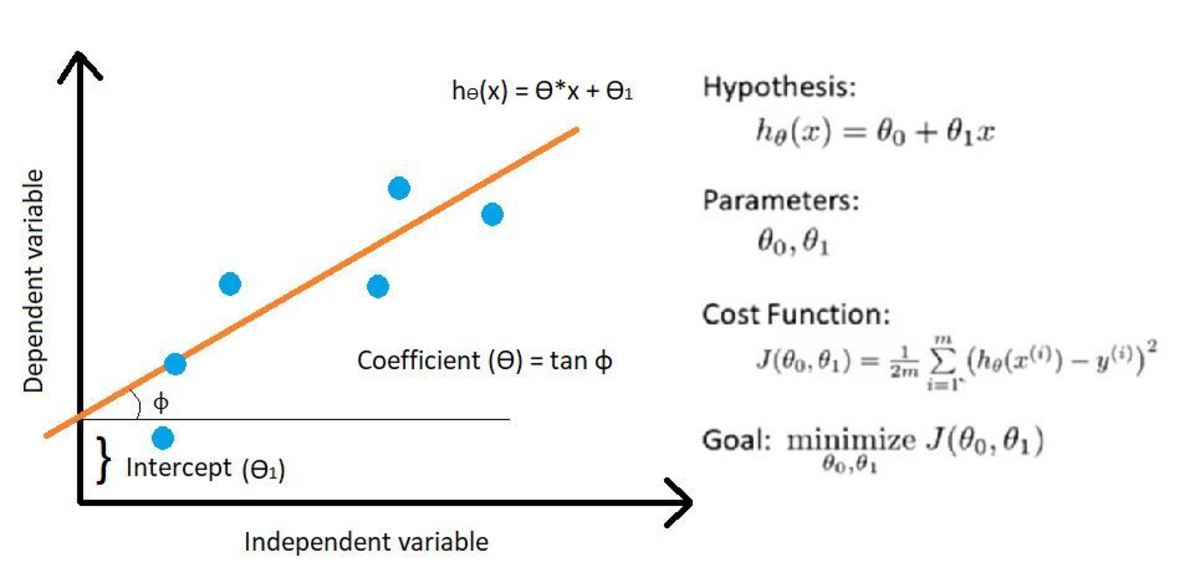

在科学计算和工程领域,优化问题无处不在,它们旨在找到函数的最大值或最小值,这些函数通常代表了成本、误差或其他性能指标。Scipy.optimize是SciPy库中的一个模块,它提供了一系列强大的工具来解决这些问题。本章节将概述Scipy.optimize在参数调优方面的应用,为后续章节的深入探讨奠定基础。

参数调优,也称为优化,在数学上通常指的是寻找一个或多个变量的最优值,以便于最大化或最小化某个目标函数。在实际应用中,参数调优可以应用于各种场景,比如机器学习模型的超参数优化、工程设计中的结构优化、经济学中的资源分配优化等。

## 参数调优的必要性

参数调优对于提高模型性能、降低成本、增强系统的稳定性和可靠性至关重要。例如,在机器学习中,通过参数调优可以找到最佳的模型参数,从而提高模型的预测准确性和泛化能力。

## Scipy.optimize的优势

Scipy.optimize模块提供了广泛的优化算法,包括但不限于线性和非线性最小化、多变量函数优化、全局优化等。这些算法大多基于梯度下降、遗传算法、模拟退火等原理,它们可以处理有约束和无约束的优化问题。

在接下来的章节中,我们将详细介绍Scipy.optimize的基本使用方法、参数调优的策略以及实践应用。让我们开始探索Scipy.optimize的世界,解锁参数调优的无限可能。

# 2. Scipy.optimize的基本使用方法

在本章节中,我们将深入探讨Scipy.optimize的基本使用方法,包括其核心函数和类的概述、参数调优的基本步骤以及优化算法的选择和比较。本章节将为读者提供一个全面的理解,以便在实际应用中能够熟练地使用Scipy.optimize进行参数调优。

## 2.1 Scipy.optimize的函数和类

### 2.1.1 Scipy.optimize的函数概述

Scipy.optimize模块提供了多种函数,用于解决优化问题,包括局部和全局优化算法。这些函数可以分为几类,包括无约束优化、有约束优化、最小化函数值以及求解方程组等。

#### 示例代码

```python

from scipy.optimize import minimize

import numpy as np

# 定义一个简单的二次函数

def func(x):

return x[0]**2 + x[1]**2

# 初始猜测

x0 = [1, 1]

# 调用minimize函数进行优化

res = minimize(func, x0)

# 输出结果

print(res)

```

#### 参数说明

- `func`: 被优化的函数。

- `x0`: 优化变量的初始猜测值。

- `args`: 传递给目标函数的额外参数。

#### 代码逻辑说明

上述代码中,我们首先从Scipy.optimize模块导入了`minimize`函数,并定义了一个简单的二次函数`func`。然后,我们提供了一个初始猜测值`x0`,并调用`minimize`函数来找到函数的最小值。最后,我们打印出优化的结果。

### 2.1.2 Scipy.optimize的类概述

Scipy.optimize还提供了一些类,用于更复杂的优化问题,例如线性规划、非线性规划等。

#### 示例代码

```python

from scipy.optimize import LinearProgramming

# 定义线性规划问题

c = [-1, -2] # 目标函数系数

A_ub = [[-1, -1], [-2, -1], [-1, 0]] # 不等式约束系数

b_ub = [-1, -2, 0] # 不等式约束边界值

# 调用LinearProgramming类求解

res = LinearProgramming(c, A_ub=A_ub, b_ub=b_ub)

# 输出结果

print(res)

```

#### 参数说明

- `c`: 目标函数系数。

- `A_ub`, `b_ub`: 不等式约束的系数和边界值。

#### 代码逻辑说明

上述代码中,我们定义了一个线性规划问题,其中`c`是目标函数的系数,`A_ub`和`b_ub`是不等式约束的系数和边界值。然后,我们使用`LinearProgramming`类求解这个问题,并打印出结果。

## 2.2 Scipy.optimize的参数调优过程

### 2.2.1 参数调优的基本步骤

Scipy.optimize进行参数调优通常遵循以下基本步骤:

1. 定义目标函数。

2. 选择合适的优化函数或类。

3. 设置初始猜测值和其他参数。

4. 调用优化函数进行计算。

5. 分析优化结果。

### 2.2.2 参数调优的实例演示

#### 示例代码

```python

from scipy.optimize import curve_fit

# 定义拟合函数

def model(x, a, b, c):

return a * np.exp(-b * x) + c

# 创建一些数据

xdata = np.linspace(0, 4, 50)

ydata = model(xdata, 2.5, 1, 0.5) + 0.2 * np.random.normal(size=xdata.size)

# 调用curve_fit函数进行参数拟合

popt, pcov = curve_fit(model, xdata, ydata)

# 输出拟合参数

print(popt)

```

#### 参数说明

- `model`: 拟合模型的函数。

- `xdata`, `ydata`: 实验数据的自变量和因变量。

- `popt`: 最优拟合参数。

- `pcov`: 参数协方差矩阵。

#### 代码逻辑说明

上述代码中,我们首先定义了一个模型函数`model`,然后创建了一些实验数据`xdata`和`ydata`。接着,我们使用`curve_fit`函数来进行参数拟合,并输出拟合得到的最优参数。

## 2.3 Scipy.optimize的优化算法

### 2.3.1 算法的基本原理和特点

Scipy.optimize提供了多种优化算法,包括梯度下降法、牛顿法、拟牛顿法等。每种算法都有其独特的原理和特点,适用于不同的优化问题。

### 2.3.2 算法的选择和比较

在选择优化算法时,需要考虑问题的类型、目标函数的性质以及计算资源的限制等因素。例如,对于有解析梯度的函数,牛顿法或拟牛顿法通常是较好的选择,而对于无解析梯度的复杂问题,梯度下降法或其变种可能更适用。

在本章节中,我们介绍了Scipy.optimize的基本使用方法,包括函数和类的概述、参数调优的基本步骤以及优化算法的选择和比较。在接下来的章节中,我们将进一步探讨参数调优的策略,包括初始值选择、边界限制和优化目标等,并通过实例演示这些策略的具体应用。此外,我们还将探讨Scipy.optimize在实际应用中的实践应用,包括数学问题、工程问题以及机器学习中的应用。最后,我们将讨论Scipy.optimize的高级应用,例如并行计算、自适应算法和多目标优化。

# 3. Scipy.optimize参数调优的策略

在本章节中,我们将深入探讨Scipy.optimize参数调优的不同策略。这些策略对于提高优化效果至关重要,尤其是在处理复杂问题时。我们将从初始值选择、边界限制以及优化目标三个方面进行分析。

## 3.1 参数调优的初始值选择

### 3.1.1 初始值的选择策略

在使用Scipy.optimize进行参数调优时,初始值的选择对于优化算法的收敛速度和最终结果有着决定性的影响。初始值是算法开始搜索最优解的起点,合适的初始值可以帮助算法更快地找到全局最优解或者较好的局部最优解。

选择初始值的策略通常有以下几种:

1. **经验法**:根据问题的经验或者类似问题的解来选择初始值。这种方法依赖于专家的知识和经验,不具有普适性,但在某些情况下可能非常有效。

2. **随机法**:随机生成一组初始值。这种方法简单易行,但在面对复杂问题时可能效率较低,且难以保证找到全局最优解。

3. **网格搜索法**:在参数的可能范围内进行网格化搜索,选择网格中的点作为初始值。这种方法可以系统地探索参数空间,但当参数维度增加时,计算量会指数级增长。

### 3.1.2 初始值的影响分析

初始值的选择直接影响到优化算法的性能。为了更深入地理解这一点,我们可以通过一个简单的例子来展示不同初始值选择对优化结果的影响。

假设我们有一个简单的优化问题,目标函数为 `f(x) = x^2`,我们希望找到函数的最小值。我们可以使用Scipy.optimize中的`minimize`函数来进行求解。

```python

from scipy.optimize import minimize

import numpy as np

# 目标函数

def func(x):

return x**2

# 初始值列表

initial_values = [0, 1, -1, 10, -10, 100, -100]

# 进行优化并存储结果

results = []

for val in initial_values:

res = minimize(func, val)

results.append(res)

# 输出结果

for i, res in enumerate(results):

print(f"初始值: {initial_values[i]}, 优化结果: {res.x}, 最小值: {res.fun}")

```

在这个例子中,我们使用了不同的初始值来优化同一个目标函数。我们可以观察到,当初始值较小时(例如0或1),算法能够快速收敛到全局最小值0。然而,当初始值较大(例如10或100)时,算法可能需要更多的迭代次数才能收敛,甚至可能在局部最小值处收敛(如-100)。这说明初始值的选择对于算法的收敛速度和解的质量都有显著影响。

## 3.2 参数调优的边界限制

### 3.2.1 边界限制的设置方法

在许多优化问题中,参数的取值范围是有限制的。例如,在工程问题中,某些物理量(如压力、温度)必须在一定的范围内才能保证系统的稳定性。边界限制是参数调优中的一个重要方面,它可以帮助算法避免搜索到不合理的解。

设置边界限制的方法通常有两种:

1. **硬性限制**:直接在优化算法的调用中设置参数的边界。例如,在Scipy.optimize中,我们可以使用`bounds`参数来指定每个参数的上下界。

2. **软性限制**:在目标函数中添加惩罚项,使得违反边界限制的解的函数值变得非常差。这种方法允许算法暂时超出边界,但在整个优化过程中会自动“纠正”这些解。

### 3.2.2 边界限制的影响分析

边界限制对于优化算法的性能也有重要影响。通过设置合理的边界限制,可以确保得到的解是有意义的,并且符合实际问题的约束条件。

为了说明边界限制的影响,我们可以使用Scipy.optimize中的`minimize`函数来进行一个带边界限制的优化问题。假设我们的目标函数是 `f(x) = (x-2)^2`,我们希望找到最小值,但 `x` 的取值范围限制在0到3之间。

```python

from scipy.optimize import minimize

import numpy as np

# 目标函数

def func(x):

return (x-2)**2

# 设置参数的边界限制

bounds = [(0, 3)]

# 使用minimize函数进行优化

res = minimize(func, x0=0, bounds=bounds)

# 输出优化结果

print(f"优化结果: {res.x}, 最小值: {res.fun}")

```

在这个例子中,我们设置了参数 `x` 的边界限制为0到3。由于目标函数 `f(x)` 在 `x=2` 处达到最小值,且该值位于边界限制内,因此算法成功找到了全局最小值。如果没有设置边界限制,算法可能会得到一个没有物理意义的解(例如负数或大于3的数),这在实际应用中可能是不可接受的。

## 3.3 参数调优的优化目标

### 3.3.1 优化目标的设定方法

优化目标是指我们需要最小化或最大化的函数。在Scipy.optimize中,优化目标可以是单目标函数,也可以是多目标函数。单目标优化是最常见的优化问题,其中需要找到一组参数值,使得目标函数达到最小值或最大值。多目标优化则涉及到多个目标函数,需要在这些目标之间进行权衡。

设定优化目标的方法通常有以下几种:

1. **明确指定**:直接在代码中定义目标函数,并将其传递给优化算法。

2. **间接定义**:通过目标函数的返回值来间接定义优化目标。例如,可以通过将多个目标函数组合成一个复合函数来实现多目标优化。

### 3.3.2 优化目标的影响分析

优化目标的选择对于最终的优化结果有着决定性的影响。一个明确且合理的优化目标可以有效地指导优化过程,帮助我们找到满意的解。

为了分析优化目标的影响,我们可以考虑一个多目标优化的例子。假设我们有两个目标函数,分别是 `f1(x) = (x-1)^2` 和 `f2(x) = (x-3)^2`,我们希望找到一个 `x` 的值,使得这两个函数的值尽可能小。

```python

from scipy.optimize import minimize

import numpy as np

# 目标函数

def func(x):

return [(x-1)**2, (x-3)**2]

# 优化方法

method = 'SLSQP'

# 初始值

x0 = [2]

# 优化约束条件

constraints = ()

# 调用minimize函数进行优化

res = minimize(func, x0, method=method, bounds=[(0, 4)], constraints=constraints)

# 输出优化结果

print(f"优化结果: {res.x}, 目标函数值: {res.fun}")

```

在这个例子中,我们使用了Scipy.optimize的`minimize`函数来进行多目标优化。由于 `f1(x)` 和 `f2(x)` 都是关于 `x` 的二次函数,且它们的最小值分别在 `x=1` 和 `x=3` 处,因此没有一个单一的 `x` 值可以同时使两个函数都达到最小值。这就需要我们在优化过程中进行权衡,找到一个折中的解。

通过以上三个小节的分析,我们可以看到参数调优的不同策略对于Scipy.optimize优化效果的重要性。初始值的选择、边界限制的设置以及优化目标的设定都会对优化过程产生显著的影响。理解这些策略并合理应用,可以大大提高优化效率和结果的质量。

# 4. Scipy.optimize参数调优的实践应用

在本章节中,我们将深入探讨Scipy.optimize参数调优的实际应用,包括在数学问题、工程问题以及机器学习中的应用。我们将通过具体的实例,展示如何将Scipy.optimize应用于不同领域的问题解决中,并分析参数调优的实现过程和结果。

## 4.1 参数调优在数学问题中的应用

### 4.1.1 数学问题的定义和建模

数学问题通常可以抽象为寻找一组参数,使得某个数学模型能够最好地描述或预测现实世界中的现象。例如,拟合一条曲线,最小化误差函数,或者在约束条件下求解最优解。

### 4.1.2 参数调优的实现和结果分析

在数学问题中,Scipy.optimize提供了一系列的函数,如`minimize`,`curve_fit`等,用于寻找最优的参数。这些函数通常需要一个目标函数,即我们需要最小化或最大化的函数,以及一个初始参数值。

#### 示例代码:

```python

from scipy.optimize import minimize

import numpy as np

# 目标函数

def objective_function(params):

x, y = params

return x**2 + y**2 # 寻找最小值

# 初始参数值

initial_params = [1, 1]

# 调用minimize函数进行优化

result = minimize(objective_function, initial_params)

# 输出结果

print("Optimal parameters:", result.x)

print("Minimum value:", result.fun)

```

#### 参数解释:

- `objective_function`:定义了我们想要最小化的目标函数。

- `initial_params`:提供了初始参数值。

- `minimize`:Scipy.optimize中的函数,用于寻找最小值。

#### 代码逻辑分析:

1. 定义了一个二次函数作为目标函数。

2. 提供了一个初始参数列表。

3. 调用`minimize`函数进行参数优化。

4. 输出优化后的参数和函数的最小值。

#### 结果分析:

通过上述代码,我们可以得到一组最优的参数值,使得目标函数达到最小值。这个过程可以帮助我们理解Scipy.optimize在数学问题中的应用,并且通过实际操作加深理解。

## 4.2 参数调优在工程问题中的应用

### 4.2.1 工程问题的定义和建模

工程问题中的参数调优通常涉及到系统性能的最优化。例如,在土木工程中,可能需要优化桥梁的设计参数以承受最大的负载;在机械工程中,可能需要找到最佳的材料强度和形状以提高效率。

### 4.2.2 参数调优的实现和结果分析

在工程领域,参数调优往往需要结合专业的知识和经验。Scipy.optimize可以用来寻找最优的设计参数,以达到预定的性能指标。

#### 示例代码:

```python

from scipy.optimize import differential_evolution

# 工程问题的目标函数

def engineering_problem(params):

# 这里是一个示例函数,实际情况需要根据工程问题定义

return sum((params - 0.5)**2)

# 参数的边界

bounds = [(0, 1), (0, 1)]

# 调用differential_evolution函数进行全局优化

result = differential_evolution(engineering_problem, bounds)

# 输出结果

print("Optimal parameters:", result.x)

print("Minimum value:", result.fun)

```

#### 参数解释:

- `engineering_problem`:定义了工程问题的目标函数。

- `bounds`:定义了参数的取值范围。

- `differential_evolution`:Scipy.optimize中的全局优化算法。

#### 代码逻辑分析:

1. 定义了一个示例工程问题的目标函数。

2. 定义了参数的取值范围。

3. 使用`differential_evolution`函数进行全局优化。

4. 输出最优参数和目标函数的最小值。

#### 结果分析:

通过上述代码,我们可以得到一组最优的工程设计参数,使得目标函数达到最小值。这个例子展示了Scipy.optimize在工程问题中的应用,以及如何利用全局优化算法来处理复杂的工程问题。

## 4.3 参数调优在机器学习中的应用

### 4.3.1 机器学习的优化目标和算法

在机器学习中,参数调优通常指的是超参数优化。超参数是控制学习过程本身的参数,例如学习率、网络结构和正则化项等。

### 4.3.2 参数调优的实现和结果分析

机器学习模型的性能很大程度上依赖于超参数的选择。Scipy.optimize可以用来优化这些超参数,从而提高模型的性能。

#### 示例代码:

```python

from scipy.optimize import minimize

from sklearn.datasets import make_classification

from sklearn.svm import SVC

from sklearn.model_selection import cross_val_score

# 生成模拟数据集

X, y = make_classification(n_samples=100, n_features=4, random_state=0)

# 定义超参数优化的目标函数

def hyperparameter_optimization(params):

# params[0]是正则化项C的值,params[1]是核函数参数gamma的值

clf = SVC(C=params[0], kernel='rbf', gamma=params[1])

return -np.mean(cross_val_score(clf, X, y, cv=5))

# 初始参数值

initial_params = [1, 1]

# 调用minimize函数进行优化

result = minimize(hyperparameter_optimization, initial_params, bounds=[(0.1, 10), (0.001, 10)])

# 输出结果

print("Optimal parameters:", result.x)

print("Maximum cross-validation score:", -result.fun)

```

#### 参数解释:

- `hyperparameter_optimization`:定义了超参数优化的目标函数。

- `SVC`:支持向量分类器。

- `cross_val_score`:交叉验证评分函数。

#### 代码逻辑分析:

1. 生成模拟数据集。

2. 定义了一个目标函数,该函数使用SVC分类器和交叉验证来评估一组超参数。

3. 提供了初始超参数值。

4. 调用`minimize`函数进行优化。

5. 输出最优超参数和最大交叉验证分数。

#### 结果分析:

通过上述代码,我们可以得到一组最优的超参数,使得SVC分类器在交叉验证上的性能达到最佳。这个例子展示了Scipy.optimize在机器学习中超参数优化的应用,以及如何利用优化算法来提高机器学习模型的性能。

在本章节中,我们详细介绍了Scipy.optimize参数调优在数学问题、工程问题和机器学习中的应用。通过具体的实例和代码,我们展示了如何实现参数调优,并分析了结果。这些应用展示了Scipy.optimize在解决实际问题中的强大功能和灵活性。

# 5. Scipy.optimize参数调优的高级应用

## 5.1 参数调优的并行计算

在处理复杂的优化问题时,尤其是那些需要大量迭代和计算资源的任务,使用并行计算可以显著提高效率。Scipy.optimize提供了一些支持并行计算的接口,使得我们可以利用多核CPU的优势来加速参数调优的过程。

### 5.1.1 并行计算的原理和方法

并行计算的原理是将计算任务分割成多个子任务,然后在多个处理器上同时执行,以此减少总的计算时间。在参数调优中,这通常意味着同时运行多个优化实例,每个实例处理参数空间的不同部分。

Scipy.optimize中的`minimize`函数支持`options`参数,其中可以设置`"method": "L-BFGS-B"`等并行优化算法,或者使用`"workers"`参数来指定并行工作的进程数。

### 5.1.2 并行计算的实现和效率分析

为了展示如何使用Scipy.optimize进行并行计算,我们可以通过一个简单的例子来进行说明。

```python

import numpy as np

from scipy.optimize import minimize

from multiprocessing import Pool

# 定义一个示例的优化函数

def rosen(x):

"""The Rosenbrock function"""

return sum(100.0*(x[1:]-x[:-1]**2.0)**2.0 + (1-x[:-1])**2.0)

# 并行计算的参数

num_workers = 4 # 并行工作的进程数

# 使用进程池来进行并行优化

with Pool(num_workers) as pool:

# 使用字典来传递参数,这样可以避免修改全局变量

res = minimize(rosen, [1, 1], method='L-BFGS-B', options={'workers': pool})

print(res)

```

在这个例子中,我们使用了Python的`multiprocessing.Pool`来创建一个进程池,并将其传递给`minimize`函数的`options`参数中的`"workers"`。这样,优化过程中的每次迭代都会尝试利用所有的核心进行并行计算。

在实际应用中,我们需要根据优化问题的特性和计算资源的可用性来选择合适的并行方法。例如,对于某些算法,使用并行计算可以将计算时间减半,但对于其他算法,可能不会带来显著的加速效果。

## 5.2 参数调优的自适应算法

自适应算法是指在优化过程中能够根据搜索历史自动调整搜索策略的算法。这类算法特别适用于参数空间复杂或者难以手动设定算法参数的情况。

### 5.2.1 自适应算法的原理和特点

自适应算法的原理是在优化过程中不断学习参数之间的相互作用,并根据这些信息来调整搜索方向和步长。例如,自适应的梯度下降算法可以根据参数空间的曲率来调整学习率。

Scipy.optimize中并没有直接提供自适应算法的实现,但是我们可以根据算法的原理,手动实现或使用第三方库来进行自适应优化。

### 5.2.2 自适应算法的实现和效率分析

以下是一个使用自适应梯度下降算法(Adagrad)的简单示例。

```python

import numpy as np

from scipy.optimize import line_search

def adagrad(f, gradf, x0, lr=0.01, epsilon=1e-8, niter=100):

"""Adagrad Optimizer"""

x = x0

cache = np.zeros_like(x)

for i in range(niter):

grad = gradf(x)

cache += grad ** 2

x = x - lr * grad / (np.sqrt(cache) + epsilon)

return x

# 示例优化函数

def quadratic(x):

return x[0]**2 + x[1]**2

def grad_quadratic(x):

return np.array([2*x[0], 2*x[1]])

# 初始参数

x0 = np.array([1.0, 1.0])

# 使用自适应梯度下降算法进行优化

x_opt = adagrad(quadratic, grad_quadratic, x0)

print("Optimized Parameters:", x_opt)

```

在这个例子中,我们定义了一个简单的二维二次函数及其梯度,并使用Adagrad算法进行优化。Adagrad算法自动调整学习率,以便在迭代过程中对每个参数的学习速度进行自适应调整。

在实际应用中,自适应算法通常比传统算法更加鲁棒,能够更好地处理各种优化问题。然而,它们也可能更加复杂,并且需要更多的计算资源。

## 5.3 参数调优的多目标优化

多目标优化是指同时优化多个相互冲突的目标函数。在许多实际问题中,往往需要在多个性能指标之间进行权衡。

### 5.3.1 多目标优化的原理和方法

多目标优化的原理是找到一个解的集合,这些解被称为Pareto最优解。在Pareto最优解集中,不存在另一个解能够在不恶化任何一个目标的情况下改进其他目标。

Scipy.optimize并没有直接提供多目标优化的功能,但是我们可以使用一些启发式算法来进行多目标优化,如非支配排序遗传算法(NSGA-II)。

### 5.3.2 多目标优化的实现和结果分析

以下是一个使用NSGA-II算法进行多目标优化的简单示例。

```python

import numpy as np

from scipy.optimize import minimize

from pymoo.algorithms.moo.nsga2 import NSGA2

from pymoo.factory import get_reference_directions

from pymoo.core.problem import ElementwiseProblem

from pymoo.util.nds.non_dominated_sorting import fast_non_dominated_sorting

class MyProblem(ElementwiseProblem):

def __init__(self):

super().__init__(n_var=2,

n_obj=2,

n_constr=0,

xl=np.array([-2, -2]),

xu=np.array([2, 2]))

def _evaluate(self, x, out, *args, **kwargs):

f1 = np.sum((x - 1) ** 2, axis=1)

f2 = np.sum((x + 1) ** 2, axis=1)

out["F"] = np.column_stack([f1, f2])

problem = MyProblem()

algorithm = NSGA2(pop_size=92)

res = minimize(problem,

algorithm,

('n_gen', 200),

verbose=True,

seed=1)

print("Optimized Pareto Front:")

print(res.F)

```

在这个例子中,我们使用了`pymoo`库中的NSGA-II算法来进行多目标优化。我们定义了一个简单的二维问题,其中包含两个目标函数,并使用NSGA-II算法来寻找Pareto最优解集。

在实际应用中,多目标优化通常用于解决工程设计、经济决策和机器学习模型选择等问题。多目标优化的结果是一组解的集合,而不是单一的解。这些解通常需要进一步分析,以确定哪个解最适合给定的应用场景。

0

0