深入Scipy.optimize:揭秘算法原理与实际应用,提升数据科学实战能力

发布时间: 2024-10-13 20:29:54 阅读量: 67 订阅数: 23

# 1. Scipy.optimize库概述

## Scipy.optimize简介

Scipy.optimize是Python科学计算库Scipy中的一个子模块,专门用于解决优化问题。该库提供了一系列的优化算法,可以处理无约束和有约束的优化问题,包括局部和全局优化算法。对于数据科学、机器学习、工程计算等领域,Scipy.optimize是一个强大的工具,可以帮助我们快速找到问题的最优解。

## Scipy.optimize的功能特点

Scipy.optimize支持不同类型的目标函数,包括但不限于连续、可微、多峰等,并提供了丰富的接口函数来定义和处理优化问题。它的使用简单直观,通过调用不同的函数,我们可以轻松地实现各种优化需求。此外,Scipy.optimize还支持多目标优化,为更复杂的优化任务提供了便利。

## Scipy.optimize的应用场景

在实际应用中,Scipy.optimize可以用于机器学习模型的参数调优、工程设计中的成本最小化问题、科学研究中的模型拟合等多种场景。由于其高效的计算性能和广泛的功能覆盖,Scipy.optimize成为了许多Python程序员优化问题解决方案的首选工具。

```python

from scipy import optimize

from numpy import array, exp

# 定义一个简单的优化目标函数

def objective_function(x):

return exp(-sum((x - array([1, 2]))**2))

# 使用optimize中的minimize函数寻找最小值

result = optimize.minimize(objective_function, x0=[0, 0])

print(result)

```

以上代码展示了如何使用Scipy.optimize的minimize函数来寻找一个简单的二维目标函数的最小值。通过定义目标函数和初始化变量,我们可以快速获得优化结果。

# 2. 优化算法的理论基础

### 2.1 无约束优化问题

无约束优化问题是指在没有任何约束条件的情况下,寻找目标函数的最优解的问题。这类问题在数学、工程和经济学等领域有着广泛的应用。

#### 问题定义与应用场景

无约束优化问题通常定义为找到一个向量 \( \mathbf{x} \),使得目标函数 \( f(\mathbf{x}) \) 达到最小值或最大值。形式上可以表示为:

\[ \min_{\mathbf{x}} f(\mathbf{x}) \]

或者

\[ \max_{\mathbf{x}} f(\mathbf{x}) \]

其中,\( \mathbf{x} \) 是一个 \( n \)-维向量,\( f(\mathbf{x}) \) 是一个可微分的实值函数。

应用场景包括但不限于:

- 机器学习模型的参数优化

- 工程设计中的成本最小化问题

- 经济学中的收益最大化问题

#### 常用算法原理

##### 梯度下降

梯度下降是一种最常用的无约束优化算法。它的基本思想是迭代地沿着目标函数梯度的反方向更新参数,以期望达到局部最小值。算法的基本步骤如下:

1. 初始化参数 \( \mathbf{x}_0 \)

2. 计算目标函数的梯度 \( \nabla f(\mathbf{x}_k) \)

3. 更新参数 \( \mathbf{x}_{k+1} = \mathbf{x}_k - \alpha \nabla f(\mathbf{x}_k) \)

4. 检查收敛性,如果满足停止条件则退出,否则回到步骤2

其中,\( \alpha \) 是学习率,一个正的常数。

```python

import numpy as np

def gradient_descent(f, grad_f, x0, alpha, tol=1e-6):

x = x0

while True:

grad = grad_f(x)

x_new = x - alpha * grad

if np.linalg.norm(x_new - x) < tol:

break

x = x_new

return x

```

在上述代码中,`f` 是目标函数,`grad_f` 是目标函数的梯度,`x0` 是初始参数,`alpha` 是学习率,`tol` 是容忍度,用于判断算法是否收敛。

##### 牛顿法

牛顿法是一种基于二阶导数的优化算法,它利用函数的Hessian矩阵(如果函数是二次可微的)来寻找最优解。算法的基本步骤如下:

1. 初始化参数 \( \mathbf{x}_0 \)

2. 计算目标函数的梯度和Hessian矩阵 \( \nabla f(\mathbf{x}_k) \) 和 \( H(\mathbf{x}_k) \)

3. 更新参数 \( \mathbf{x}_{k+1} = \mathbf{x}_k - \alpha H(\mathbf{x}_k)^{-1} \nabla f(\mathbf{x}_k) \)

4. 检查收敛性,如果满足停止条件则退出,否则回到步骤2

牛顿法的收敛速度比梯度下降快,但它需要计算Hessian矩阵及其逆矩阵,计算成本较高。

### 2.2 有约束优化问题

有约束优化问题是指在一定的约束条件下,寻找目标函数的最优解的问题。这类问题在资源优化、控制系统等领域有着广泛的应用。

#### 问题定义与应用场景

有约束优化问题可以定义为:

\[ \min_{\mathbf{x}} f(\mathbf{x}) \]

受限于约束条件:

\[ g_i(\mathbf{x}) \leq 0, \quad i = 1, \ldots, m \]

\[ h_j(\mathbf{x}) = 0, \quad j = 1, \ldots, p \]

其中,\( \mathbf{x} \) 是一个 \( n \)-维向量,\( f(\mathbf{x}) \) 是目标函数,\( g_i(\mathbf{x}) \) 是不等式约束,\( h_j(\mathbf{x}) \) 是等式约束。

应用场景包括但不限于:

- 生产计划中的资源分配问题

- 控制系统中的状态优化问题

- 金融投资中的风险最小化问题

#### 约束条件的分类及其处理方法

有约束优化问题中的约束条件可以分为等式约束和不等式约束。处理这些约束的方法通常包括:

- 拉格朗日乘数法

- 罚函数法

- 序列二次规划法(SQP)

##### 拉格朗日乘数法

拉格朗日乘数法是一种将有约束问题转化为无约束问题的方法。它通过引入拉格朗日乘子将约束条件与目标函数结合,形成拉格朗日函数:

\[ \mathcal{L}(\mathbf{x}, \lambda, \mu) = f(\mathbf{x}) + \sum_{i=1}^{m} \lambda_i g_i(\mathbf{x}) + \sum_{j=1}^{p} \mu_j h_j(\mathbf{x}) \]

然后通过求解无约束的拉格朗日函数的极值来找到原问题的最优解。

##### 罚函数法

罚函数法通过对不满足约束条件的解施加一个惩罚项,将有约束问题转化为一系列无约束问题。惩罚项通常是约束违反量的函数,如:

\[ P(\mathbf{x}) = \sum_{i=1}^{m} \max(0, g_i(\mathbf{x}))^2 + \sum_{j=1}^{p} h_j(\mathbf{x})^2 \]

在每一步迭代中,通过求解无约束问题:

\[ \min_{\mathbf{x}} f(\mathbf{x}) + r P(\mathbf{x}) \]

其中,\( r \) 是一个逐渐增大的正参数。

##### 序列二次规划法(SQP)

序列二次规划法是一种迭代求解有约束优化问题的方法。在每一步迭代中,它求解一个二次规划子问题,该子问题近似原问题的局部行为。SQP方法通常能够快速收敛,并且适用于大规模问题。

### 2.3 全局优化算法

全局优化问题是指寻找全局最优解的问题,而不是局部最优解。这类问题在工程设计、科学实验等领域有着重要的应用。

#### 全局优化问题的特点

全局优化问题通常具有以下特点:

- 目标函数可能存在多个局部最优解

- 目标函数可能非常复杂,难以找到梯度信息

- 约束条件可能是非线性的,难以处理

#### 常见全局优化算法原理

##### 遗传算法

遗传算法是一种模拟自然进化过程的搜索算法。它通过模拟自然选择、遗传、突变等机制,迭代地改进种群中的个体,以期望找到全局最优解。算法的基本步骤如下:

1. 初始化种群

2. 评估种群中个体的适应度

3. 选择适应度高的个体进行繁殖

4. 应用交叉和突变操作生成新的个体

5. 替换种群中适应度低的个体

6. 检查终止条件,如果满足则退出,否则回到步骤2

##### 模拟退火

模拟退火算法是一种基于物理退火过程的随机搜索算法。它通过逐步降低“温度”参数来控制搜索过程,以期望找到全局最优解。算法的基本步骤如下:

1. 初始化参数 \( \mathbf{x}_0 \) 和初始温度 \( T \)

2. 在温度 \( T \) 下进行多次随机搜索

3. 如果找到更好的解,则接受该解

4. 降低温度 \( T \)

5. 检查终止条件,如果满足则退出,否则回到步骤2

```python

import numpy as np

def simulated_annealing(f, x0, T, alpha, tol=1e-6):

x = x0

while T > tol:

x_new = x + np.random.randn(len(x)) * alpha

delta_f = f(x_new) - f(x)

if delta_f < 0 or np.random.rand() < np.exp(-delta_f / T):

x = x_new

T *= alpha

return x

```

在上述代码中,`f` 是目标函数,`x0` 是初始参数,`T` 是初始温度,`alpha` 是温度衰减系数,`tol` 是容忍度。

通过本章节的介绍,我们可以了解到无约束优化问题、有约束优化问题以及全局优化问题的基本定义和应用场景。同时,我们也了解了几种常用的优化算法原理,包括梯度下降、牛顿法、遗传算法和模拟退火算法。这些算法在实际应用中各有优势,需要根据具体问题的特点选择合适的算法。

# 3. Scipy.optimize的实践应用

## 3.1 无约束优化问题的解决方案

在本章节中,我们将深入探讨Scipy.optimize库在解决无约束优化问题方面的应用。无约束优化问题是指在没有任何限制条件下寻找函数的最小值或最大值的问题。这类问题在科学研究和工程领域中非常常见,例如在统计学中寻找最佳拟合参数,或者在机器学习中最小化损失函数。

### 3.1.1 Scipy.optimize中的函数介绍

Scipy.optimize库提供了一系列用于解决无约束优化问题的函数,其中最常用的是`minimize`函数。该函数是一个通用的优化器,可以调用不同的算法来寻找最优解。以下是一些常用的算法选项:

- `'Nelder-Mead'`: Nelder-Mead单纯形法,适用于无梯度信息的情况。

- `'Powell'`: Powell共轭方向法,同样适用于无梯度信息的情况。

- `'CG'`: 共轭梯度法,适用于连续可微的函数。

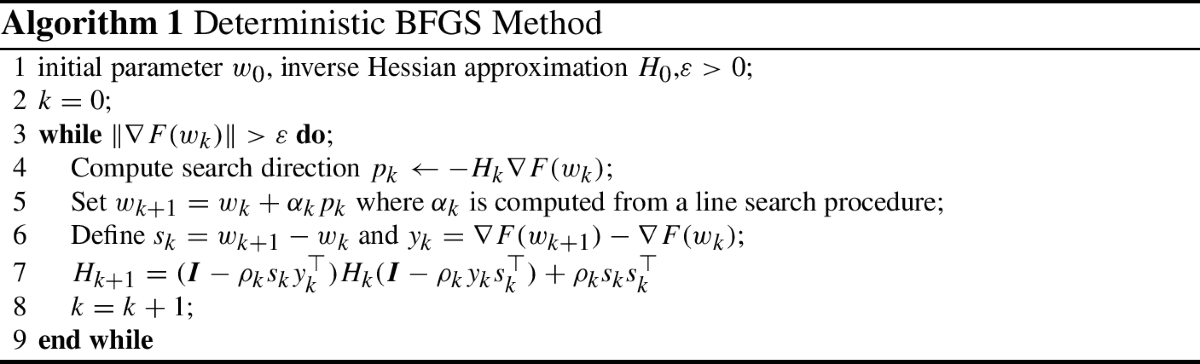

- `'BFGS'`: Broyden-Fletcher-Goldfarb-Shanno (BFGS) 算法,一种迭代方法,适用于大规模问题。

- `'Newton-CG'`: 基于牛顿法的共轭梯度法。

- `'L-BFGS-B'`: 适用于有边界约束的问题。

- `'TNC'`: Truncated Newton 方法,适用于大型问题。

### 3.1.2 实际案例分析:函数最小化问题

为了更好地理解这些函数的使用,我们将通过一个简单的函数最小化问题来展示如何使用Scipy.optimize进行无约束优化。假设我们有一个二次函数:

```python

def objective(x):

return x[0]**2 + x[1]**2

initial_guess = [0.5, 0.5]

result = minimize(objective, initial_guess, method='Nelder-Mead')

```

在上述代码中,我们定义了一个目标函数`objective`,它接受一个参数`x`,并返回其平方和。我们使用`minimize`函数,并指定了初始猜测值`initial_guess`和方法`Nelder-Mead`。`minimize`函数将返回一个OptimizeResult对象,其中包含了优化的结果信息。

```python

print("最小值点:", result.x)

print("最小值:", result.fun)

```

执行上述代码后,我们可以得到最优解`result.x`和目标函数在该点的值`result.fun`。这种简单直观的使用方式使得Scipy.optimize非常适合快速解决无约束优化问题。

### 3.1.3 代码逻辑解读

在这个例子中,我们首先定义了一个名为`objective`的Python函数,它计算输入向量`x`的平方和。然后,我们使用`minimize`函数尝试找到这个函数的最小值。`minimize`函数需要至少两个参数:一个是目标函数`objective`,另一个是初始猜测值`initial_guess`。我们还指定了优化方法`method='Nelder-Mead'`。

执行`minimize`函数后,我们打印出最小值点`result.x`和目标函数的最小值`result.fun`。这个例子演示了Scipy.optimize库在解决无约束优化问题时的简洁和高效。

## 3.2 有约束优化问题的解决方案

有约束优化问题是指在一些约束条件下寻找最优解的问题。这些约束条件可以是变量的上下界,也可以是等式或不等式约束。Scipy.optimize库提供了一些函数来处理这些类型的优化问题。

### 3.2.1 Scipy.optimize中的约束处理方法

Scipy.optimize库中的`minimize`函数同样可以处理有约束的优化问题。它可以接受以下类型的约束:

- 线性等式约束:`{'type': 'eq', 'fun': g, 'jac': J}`,其中`g`是一个返回等式约束值的函数,`J`是其雅可比矩阵。

- 线性不等式约束:`{'type': 'ineq', 'fun': g, 'jac': J}`,其中`g`是一个返回不等式约束值的函数,`J`是其雅可比矩阵。

- 线性边界约束:`lb <= x <= ub`,其中`lb`和`ub`分别是变量的下界和上界。

### 3.2.2 实际案例分析:线性与非线性约束问题

为了说明有约束优化问题的解决方案,我们考虑一个带有线性和非线性约束的示例。假设我们有以下优化问题:

目标函数:

$$ f(x) = x_1^2 + x_2^2 $$

约束条件:

$$ x_1 + x_2 \geq 1 $$

$$ x_1^2 + x_2^2 \leq 2 $$

$$ x_2 \leq 1 $$

我们可以使用Scipy.optimize库来解决这个问题:

```python

from scipy.optimize import minimize

import numpy as np

def objective(x):

return x[0]**2 + x[1]**2

def constraint1(x):

return 1 - (x[0] + x[1])

def constraint2(x):

return x[0]**2 + x[1]**2 - 2

cons = [{'type': 'ineq', 'fun': constraint1},

{'type': 'ineq', 'fun': constraint2},

{'type': 'ineq', 'fun': lambda x: 1 - x[1]}]

initial_guess = [0.5, 0.5]

result = minimize(objective, initial_guess, constraints=cons)

print("最优解:", result.x)

print("最优值:", result.fun)

```

在这个例子中,我们定义了目标函数`objective`和两个约束函数`constraint1`和`constraint2`。然后,我们创建了一个约束列表`cons`,并将其传递给`minimize`函数。最后,我们打印出最优解和目标函数在该点的值。

通过本章节的介绍,我们展示了如何使用Scipy.optimize库来解决无约束和有约束的优化问题。在接下来的章节中,我们将进一步探讨如何应用Scipy.optimize进行全局优化问题的解决方案。

# 4. 高级应用与自定义优化算法

## 4.1 自定义优化目标函数

在实际应用中,我们常常会遇到需要优化的目标函数比标准库提供的函数更加复杂的情况。这要求我们能够根据具体问题构建自定义的优化目标函数,并使用Scipy.optimize库中的工具进行求解。

### 4.1.1 如何构建复杂的优化目标

构建复杂的优化目标通常涉及以下几个步骤:

1. **问题定义**:首先需要明确优化问题的具体目标和约束条件。

2. **数学建模**:将实际问题转化为数学模型,定义目标函数和约束条件的数学表达式。

3. **编写函数**:使用Python编写目标函数和约束函数,并确保它们能够被优化算法正确调用。

4. **验证模型**:通过一些测试用例验证函数的正确性。

### 4.1.2 自定义函数的优化实例

假设我们需要优化一个包含多个峰值的复杂函数。这个函数可能代表了一个工程问题中的成本函数,我们需要找到成本最低的参数组合。

```python

import numpy as np

from scipy.optimize import minimize

# 定义目标函数

def complex_function(x):

# 这里我们使用一个简单的二次函数来模拟复杂的目标函数

return x[0]**2 + x[1]**2 + x[2]**2 + np.sin(x[0]) + np.sin(x[1]) + np.sin(x[2])

# 初始猜测值

x0 = np.array([0.5, 0.5, 0.5])

# 使用minimize函数进行优化

result = minimize(complex_function, x0)

print("Optimized result:", result.x)

```

#### 代码逻辑解读分析

- `complex_function`是我们自定义的目标函数,接收一个包含参数的数组`x`,返回函数的值。

- `minimize`函数是Scipy.optimize库中用于求解无约束优化问题的函数,我们使用它来找到目标函数的最小值。

- `x0`是优化算法的初始猜测值。

#### 参数说明

- `x0`:初始猜测值,需要根据实际问题进行合理选择。

通过本章节的介绍,我们可以了解到如何构建自定义的优化目标函数,并使用Scipy.optimize库进行求解。这个过程对于解决实际中的复杂优化问题是至关重要的。

## 4.2 多目标优化

多目标优化问题是实际应用中的另一类常见问题。它涉及到多个目标函数的优化,并且这些目标函数之间可能存在冲突。

### 4.2.1 多目标优化问题的定义与挑战

多目标优化问题通常可以表示为:

```

minimize f(x)

minimize g(x)

subject to h(x) = 0

l(x) <= 0

```

其中,`f(x)`和`g(x)`是需要最小化的多个目标函数,`h(x)`是等式约束,`l(x)`是不等式约束。这些目标函数之间可能存在冲突,即在优化一个目标的同时可能会影响其他目标的性能。

### 4.2.2 Scipy.optimize在多目标优化中的应用

Scipy.optimize库提供了一些工具来处理多目标优化问题,但它们通常需要通过一定的方法将其转化为单目标优化问题。

#### *.*.*.* 应用实例:帕累托前沿

在多目标优化中,一个常见的概念是帕累托前沿,即所有最优解的集合。我们可以使用Scipy.optimize找到多个目标函数的帕累托最优解。

```python

import numpy as np

from scipy.optimize import minimize

# 定义目标函数

def objective(x):

return np.array([x[0]**2 + x[1]**2, (x[0]-1)**2 + (x[1]-1)**2])

# 初始猜测值

x0 = np.array([0.5, 0.5])

# 优化函数设置

cons = ({'type': 'eq', 'fun': lambda x: x[0]**2 + x[1]**2 - 1})

bnds = ((0, 1), (0, 1))

# 使用minimize函数进行优化

result = minimize(objective, x0, method='SLSQP', constraints=cons, bounds=bnds)

print("Optimized result:", result.x)

```

#### 代码逻辑解读分析

- `objective`函数返回一个数组,包含两个目标函数的值。

- `cons`定义了等式约束,用于确保解位于某个圆上。

- `bnds`定义了变量的边界,限制搜索空间。

#### 参数说明

- `cons`:约束条件,用于确保解满足特定条件。

- `bnds`:变量的边界,限制搜索空间。

通过本章节的介绍,我们了解了多目标优化问题的定义和挑战,并展示了如何使用Scipy.optimize库来找到帕累托最优解。

## 4.3 Scipy.optimize的局限性与替代方案

虽然Scipy.optimize库功能强大,但它也有一些局限性。了解这些局限性以及替代方案对于优化算法的正确使用至关重要。

### 4.3.1 Scipy.optimize的限制因素

Scipy.optimize的主要限制因素包括:

- **只能处理数值问题**:Scipy.optimize只能处理数值优化问题,对于符号计算或非数值问题无能为力。

- **依赖于初始猜测值**:很多优化算法对初始猜测值非常敏感,可能会陷入局部最小值。

- **计算资源限制**:对于大规模问题,Scipy.optimize可能会消耗大量计算资源。

### 4.3.2 其他库的比较与选择(如PyTorch、TensorFlow等)

对于一些特定类型的问题,如深度学习模型的超参数优化,Scipy.optimize可能不是最佳选择。其他库如PyTorch和TensorFlow提供了专门的工具来进行高效的数值优化。

#### *.*.*.* PyTorch优化器

PyTorch提供了一系列的优化器,这些优化器专门为深度学习模型的训练过程设计,可以处理大规模的参数优化问题。

```python

import torch

# 定义一个简单的神经网络模型

class SimpleNet(torch.nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc = torch.nn.Linear(10, 1)

def forward(self, x):

return self.fc(x)

# 初始化模型和优化器

model = SimpleNet()

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

# 优化过程

for data in data_loader:

inputs, targets = data

optimizer.zero_grad()

outputs = model(inputs)

loss = torch.nn.functional.mse_loss(outputs, targets)

loss.backward()

optimizer.step()

```

#### 代码逻辑解读分析

- `SimpleNet`是一个简单的神经网络模型。

- `optimizer`是PyTorch中的优化器,用于优化模型参数。

- 在训练循环中,我们通过反向传播计算损失,并使用优化器更新模型参数。

#### 参数说明

- `lr`:学习率,控制优化过程中的步长。

通过本章节的介绍,我们了解了Scipy.optimize库的局限性以及一些替代方案。这有助于我们在面对不同类型的问题时选择合适的工具进行优化。

# 5. 优化算法在数据科学中的实战案例

在数据科学领域,优化算法扮演着至关重要的角色。无论是机器学习模型的超参数调整,还是解决复杂的工程问题,甚至是科研创新,优化算法都提供了强大的工具和方法。本章将深入探讨Scipy.optimize在数据科学中的实战应用案例。

## 5.1 机器学习中的超参数优化

在机器学习中,模型的性能往往依赖于超参数的设置。超参数优化是一个寻找最优超参数组合以提升模型性能的过程。

### 5.1.1 超参数优化的重要性

超参数是控制学习过程的参数,它们不像模型参数那样通过训练数据学习得到,而是需要在训练之前设定。超参数优化的目的是找到一组超参数,使得模型在未见数据上的表现最佳。

### 5.1.2 Scipy.optimize在超参数搜索中的应用实例

Scipy.optimize库可以用来执行网格搜索(Grid Search)和随机搜索(Random Search),以寻找最佳超参数。例如,使用`scipy.optimize.differential_evolution`进行随机搜索:

```python

from scipy.optimize import differential_evolution

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 定义目标函数,即要最小化的验证分数

def objective(params):

n_estimators, max_features = params

clf = RandomForestClassifier(n_estimators=int(n_estimators),

max_features=int(max_features),

random_state=0)

return -np.mean(cross_val_score(clf, X, y, cv=5))

# 设置超参数搜索空间

bounds = [(10, 100), (2, 4)]

# 执行优化

result = differential_evolution(objective, bounds)

# 输出最优超参数

print('最优超参数:', result.x)

print('最低验证分数:', -result.fun)

```

## 5.2 工程问题的优化解决方案

在工程领域,优化问题通常更为复杂,可能涉及非线性、多目标和多约束条件。

### 5.2.1 工程问题优化的挑战

工程问题的优化往往需要考虑多种因素,如成本、效率、安全性等。这些问题的求解通常需要高级的算法和复杂的数学模型。

### 5.2.2 Scipy.optimize在工程优化中的案例分析

Scipy.optimize库在工程优化中可以用于求解非线性规划问题。例如,使用`scipy.optimize.minimize`求解一个简单的优化问题:

```python

from scipy.optimize import minimize

# 定义目标函数

def objective(x):

return x[0]**2 + x[1]**2

# 初始猜测

x0 = [1, 1]

# 执行优化

result = minimize(objective, x0, method='SLSQP')

# 输出最优解

print('最优解:', result.x)

print('最小值:', result.fun)

```

## 5.3 研究与创新应用

优化算法在科研和创新领域有着广泛的应用前景。

### 5.3.1 Scipy.optimize在科研中的应用前景

在科研领域,优化算法可以帮助研究人员解决复杂的计算问题,如分子动力学模拟、数据分析等。

### 5.3.2 创新应用案例分享

Scipy.optimize不仅限于数据科学和工程问题,它还可以用于创新领域的应用。例如,在生物信息学中,Scipy.optimize可以用于基因序列的优化,以寻找最可能的基因表达模型。

通过上述案例分析,我们可以看到Scipy.optimize在数据科学中的广泛应用。这些案例展示了Scipy.optimize如何帮助研究人员和工程师解决实际问题,提高模型性能和工程效率。

0

0