【TiDB分布式架构】:揭秘高可用与水平扩展的秘密武器

发布时间: 2024-12-28 22:22:22 阅读量: 6 订阅数: 12

高可用与一致性:构建强一致性分布式数据库 TiDB-沈泰宁.pdf

# 摘要

TiDB作为一个分布式数据库系统,以其独特的架构设计和组件优势,在处理大规模数据方面表现出高可用性和良好的扩展性。本文首先概述了TiDB的分布式数据库架构及其关键组件TiKV和PD的基础架构设计。随后,本文深入分析了TiDB的高可用机制,包括架构设计原则、故障转移机制和数据副本一致性策略。接着,探讨了TiDB的水平扩展能力,从扩展的基本原理到实际应用案例,以及负载均衡策略和性能调优。最后,展望了TiDB的未来发展方向,包括社区创新、新特性的引入,以及面临的挑战和机遇。本文旨在全面展示TiDB的技术特点和应用潜力,为数据库技术的发展提供参考。

# 关键字

TiDB;分布式数据库;高可用;水平扩展;负载均衡;社区驱动

参考资源链接:[TiDB、MySQL与Oracle:功能对比与选择指南](https://wenku.csdn.net/doc/644b77cdea0840391e55960a?spm=1055.2635.3001.10343)

# 1. TiDB分布式数据库概述

随着数据量的指数级增长和业务需求的日益复杂化,传统的单机数据库难以满足现代应用对高可用性、扩展性和一致性的高要求。TiDB,作为一个开源的分布式数据库,旨在解决这些问题并为现代数据平台提供一个可靠的数据存储解决方案。

本章将首先介绍TiDB的基本概念,并对其进行整体的概述,为读者提供对TiDB分布式数据库核心优势和应用场景的初步认识。接下来的章节将深入探讨TiDB的基础架构和组件,高可用机制,以及其在实际业务中如何实现水平扩展。最后,本章还会概述TiDB的未来发展方向,包括社区驱动的创新与演进,以及面向未来的特性与展望。

通过本章的学习,读者将获得对TiDB分布式数据库的全面理解,并能够明确TiDB在当下和未来IT行业中的重要地位。

# 2. TiDB的基础架构和组件

## 2.1 TiDB的分布式架构设计

### 2.1.1 架构概览

TiDB 是一个开源的分布式关系型数据库,其设计初衷是为了解决传统单机数据库面临的扩展性、可靠性和兼容性的问题。TiDB 采用了分布式架构,支持弹性伸缩,具备强一致性和高可用性。其架构主要分为三个核心组件:TiDB Server、TiKV 和 Placement Driver (PD)。TiDB Server 负责 SQL 层的处理和优化,TiKV 是分布式键值存储引擎,PD 负责整个集群的元信息管理以及负载均衡和调度。

在该架构中,TiDB 支持跨多个数据中心的地理分布式部署,每个数据中心内部支持多副本以保证数据的可靠性。TiDB 通过 Raft 协议实现数据复制和一致性保证。客户端与 TiDB Server 通信,由 TiDB Server 解析 SQL 并生成分布式执行计划,然后通过 PD 获取数据位置信息,并直接与 TiKV 进行数据的读写。

### 2.1.2 关键组件解析

为了深入理解 TiDB 的分布式架构,我们需要详细分析其关键组件的工作原理。

#### TiDB Server

TiDB Server 是 SQL 层的组件,它使用 Google 的 gRPC 协议与客户端和其他组件通信。它在收到 SQL 请求后,进行 SQL 解析、优化,并生成分布式执行计划。TiDB Server 能够横向扩展,多个 TiDB Server 实例可以同时运行,通过负载均衡分摊查询压力。

#### TiKV

TiKV 是 TiDB 的分布式存储引擎。它是一个分布式事务键值存储系统,负责存储实际的数据。TiKV 使用 Raft 协议保证数据的一致性和复制,从而实现高可用。每个 TiKV 节点都是一个无状态的服务,它们通过 Raft 进行数据同步,保证数据副本的强一致性。

#### Placement Driver (PD)

PD 是集群的管理组件,负责存储整个集群的元信息,并为 TiDB Server 和 TiKV 提供数据分布和调度的决策支持。PD 通过定期的心跳来监控集群内各个节点的状态,并使用 Raft 协议来保证自己的高可用性。PD 决定数据在 TiKV 中的分布策略,实施负载均衡,并在节点发生故障时进行自动的数据迁移。

## 2.2 TiKV:分布式键值存储

### 2.2.1 TiKV的核心概念

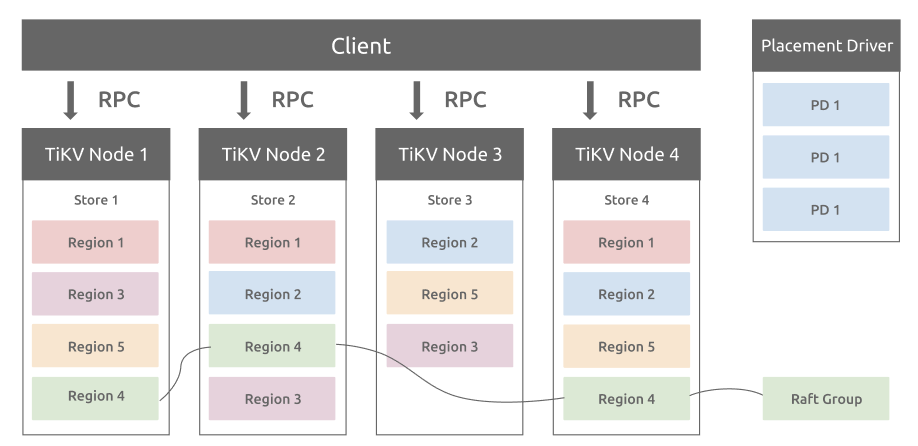

TiKV 的核心概念包括 Region、Store 和 Peer。TiKV 将数据水平切分成多个 Region,每个 Region 负责存储一部分数据,并有一个 Leader 和多个 Follower。TiKV 中的 Store 表示运行 TiKV 实例的物理节点,而 Peer 代表某一个 Region 在 Store 中的一个副本。

TiKV 的数据是按 Region 切分的,每个 Region 都由一个 Raft Group 来保证数据的一致性。TiKV 通过这种设计来保证数据的高可用性、水平扩展性以及故障的自动恢复。

### 2.2.2 数据分布与副本策略

TiKV 的数据分布和副本策略基于 Region 来设计。Region 是按照键值范围划分的,每个 Region 默认 96M 大小,并且会自动分裂或合并。通过 Region 的分裂和合并,TiKV 能够保持数据分布的均衡。

副本策略则是基于 PD 的调度策略实现的。PD 会自动将 Region 的副本均匀地分布在不同的 Store 中,同时监控副本的状态,自动进行副本的迁移和故障恢复。

TiKV 中的数据副本与 Raft 协议紧密结合,确保了数据的高可用性和一致性。TiKV 还实现了基于 Region 的负载均衡机制,能够自动调整数据分布,使得整体的读写性能得到优化。

## 2.3 PD:Placement Driver的作用

### 2.3.1 负载均衡与调度

PD 是 TiDB 集群的脑部,它负责集群的全局管理任务,包括数据的均衡调度、集群的监控和报警、存储容量管理、故障自动转移以及 Region 调度。PD 在收到 TiKV 的心跳报告后,会根据心跳信息来了解整个集群的状态,然后做出决策进行负载均衡。

#### 负载均衡策略

PD 的负载均衡策略主要基于 Region 的大小和读写负载。PD 会监控每个 TiKV 节点上的负载情况,如果发现某个节点的负载过高,PD 会将部分 Region 迁移到其他负载较低的节点上,以此实现负载均衡。迁移操作是通过将 Region 的 Leader 或 Follower 在不同 Store 之间进行切换来完成的。

负载均

0

0