【PyTorch模型验证与测试】:正确评估模型性能的终极指南

发布时间: 2024-12-12 11:35:52 阅读量: 39 订阅数: 14

PyTorch模型评估全指南:技巧与最佳实践

# 1. PyTorch模型验证与测试概述

在本章中,我们将对PyTorch中的模型验证与测试进行基础性介绍。首先,我们将从模型验证的必要性谈起,解释为什么模型验证是机器学习项目中不可或缺的环节。之后,将介绍模型测试的重要性,强调如何通过测试来确保模型在未知数据上的表现。最后,本章会对PyTorch框架中用于验证与测试的相关工具和API做一个简单的概述,为后续章节详细介绍每个工具和方法提供一个铺垫。模型验证与测试是机器学习工程师工作流程的关键部分,涉及到模型的可靠性与健壮性评价,这不仅关系到模型是否能够在生产环境中稳定运行,也影响到模型的实际应用效果。

```markdown

## 1.1 模型验证的必要性

- **确保模型可靠性**:验证过程通过在未参与训练的数据上测试模型,确保模型没有过拟合。

- **发现模型问题**:及时发现并纠正模型的错误,比如对数据集的不适当假设或模型结构选择不当。

## 1.2 模型测试的重要性

- **评价模型性能**:通过在独立的测试集上评估模型,获得模型在实际应用中的性能指标。

- **预测模型泛化能力**:测试结果是判断模型泛化能力的重要依据,它直接关系到模型在生产环境中的表现。

## 1.3 PyTorch中的验证与测试工具

- **torch.utils.data**:用于创建数据加载器,简化了数据集划分和批处理的过程。

- **torch.nn.Module**:定义了模型的前向传播函数,包含了各种常见的层和激活函数。

- **torch.nn.CrossEntropyLoss**:为分类任务提供了损失函数,是模型训练中的关键部分。

```

以上内容概述了模型验证与测试的基本概念,解释了为什么它们对于机器学习项目至关重要,并指出了在PyTorch中使用的一些基础工具。在后续章节中,我们将深入探讨具体的性能评估指标、验证策略和高级技术,以及如何在实际案例中应用这些知识。

# 2. 理解模型性能评估指标

在机器学习和深度学习领域,模型性能的评估至关重要。准确地理解并选择适当的评估指标是优化模型并确保其在真实世界应用中表现良好的基础。本章节将重点探讨模型准确性度量、损失函数的选择与应用,以及如何评估模型的泛化能力。

### 模型准确性的度量

在机器学习任务中,通常我们需要对模型的预测进行评估。评估准确性最直观的方法之一是看模型在分类任务中对多少样本作出了正确的预测,这一指标称为“准确率”。

#### 准确率、召回率和F1分数

准确率(Accuracy)衡量了模型正确预测的比例,是测试集中正确分类样本数除以总样本数的结果。尽管它是一个易于理解的指标,但在不平衡数据集中可能具有误导性。例如,在一个正负样本比例极不平衡的分类问题中,即使模型总是预测为最常见的类别,准确率仍然可以看起来相当不错。

为了应对这种情况,召回率(Recall)和精确率(Precision)被提出来更全面地评估模型。召回率关注于模型正确识别正类的能力,而精确率关注于模型预测为正类的样本中有多少是真正正类的。在某些情况下,我们可能需要同时关注精确率和召回率,这时可以采用F1分数,它是精确率和召回率的调和平均值,用来在两者之间取得平衡。

#### 混淆矩阵和ROC曲线

混淆矩阵(Confusion Matrix)提供了一种更详细的方法来评估分类模型的性能,它将预测结果按类别细分,提供了真正类(TP)、假正类(FP)、真负类(TN)和假负类(FN)的具体数目。

ROC曲线(Receiver Operating Characteristic curve)和它的面积(AUC)是一种强大的评估指标,尤其是在处理二分类问题时。ROC曲线通过不同的阈值设置来展示模型在不同情况下的真正类率(TPR)和假正类率(FPR)之间的关系。AUC是曲线下面积的度量,值域从0到1,一个完美的分类器的AUC是1,而随机分类器的AUC是0.5。

```mermaid

graph LR

A[开始] --> B{是否理解准确率、召回率、F1分数?}

B -- 是 --> C[继续深入学习混淆矩阵和ROC曲线]

B -- 否 --> D[回顾基础概念]

C --> E[将知识应用于实际问题]

D --> B

E --> F[评估性能的最终阶段]

```

### 损失函数的选择与应用

损失函数在模型训练过程中起到非常重要的作用。它衡量了模型预测值与真实值之间的差异,是优化算法的“指南针”,指引模型朝减少错误的方向前进。

#### 常见损失函数的介绍

不同类型的机器学习问题对应着不同的损失函数。例如,在分类问题中,交叉熵损失(Cross-Entropy Loss)是最常用的损失函数之一,特别是在多类分类问题中。它衡量了模型预测的概率分布与真实标签的概率分布之间的差异。对于回归任务,均方误差损失(Mean Squared Error, MSE)和平均绝对误差损失(Mean Absolute Error, MAE)是常见的选择,它们分别衡量预测值与实际值之间的平方误差和绝对误差。

#### 损失函数在模型训练中的作用

选择正确的损失函数对于模型训练至关重要。损失函数不仅决定了模型学习的方向,还影响模型的泛化能力。在实际应用中,我们可能会通过修改损失函数来实现特定的目的,比如添加正则项来减少模型的复杂度,防止过拟合现象的发生。

### 模型泛化能力的评估

在监督学习中,模型的泛化能力是指模型在未见过的数据上的表现能力。模型过拟合和欠拟合是影响泛化能力的主要问题。

#### 过拟合与欠拟合的概念

过拟合(Overfitting)是指模型在训练数据上表现良好,但在新的、未见过的数据上表现较差的现象。这通常发生在模型过于复杂,以至于它学习到了训练数据中的噪声和细节,而不是潜在的数据分布。与之相对的是欠拟合(Underfitting),这种情况是指模型过于简单,无法捕捉数据中的模式,因此在训练和测试数据上都表现不佳。

#### 如何通过交叉验证测试泛化能力

交叉验证是一种评估模型泛化能力的常用技术。在k折交叉验证中,数据集被分成k个子集,模型在k-1个子集上进行训练,并在一个子集上进行测试。这一过程重复k次,每次使用不同的测试集,最后汇总模型在所有测试集上的性能,得到一个泛化能力的总体评估。

```markdown

| 模型性能指标 | 描述 |

| ------------ | ---- |

| 准确率 | 模型正确预测的样本数与总样本数的比例 |

| 召回率 | 模型正确识别为正类的样本数占真实正类总数的比例 |

| 精确率 | 模型预测为正类的样本中,真正为正类的比例 |

| F1分数 | 精确率与召回率的调和平均值 |

| AUC | ROC曲线下的面积,衡量模型分类性能的指标 |

| 过拟合 | 模型在训练数据上表现良好,在新数据上表现差 |

| 欠拟合 | 模型在训练和新数据上都表现不佳 |

| 交叉验证 | 通过多个训练/测试循环来评估模型泛化能力的方法 |

```

通过深入分析这些性能评估指标,我们可以更全面地理解模型的表现,并采取相应的优化措施。下一章节,我们将探讨PyTorch模型验证的实践技巧,包括数据集的划分、超参数调整和模型的保存与加载机制。

# 3. PyTorch模型验证的实践技巧

在前两章中,我们已经介绍了模型性能评估的重要指标,以及这些指标如何帮助我们理解模型在训练集和验证集上的表现。然而,知道这些理论知识还不足以使我们能够有效地验证模型。在第三章,我们将深入探讨实践技巧,以便在实际应用中进行高效的模型验证。

## 3.1 数据集划分与预处理

模型的性能在很大程度上取决于输入数据的质量。因此,在模型验证之前,数据集的合理划分和预处理是至关重要的。

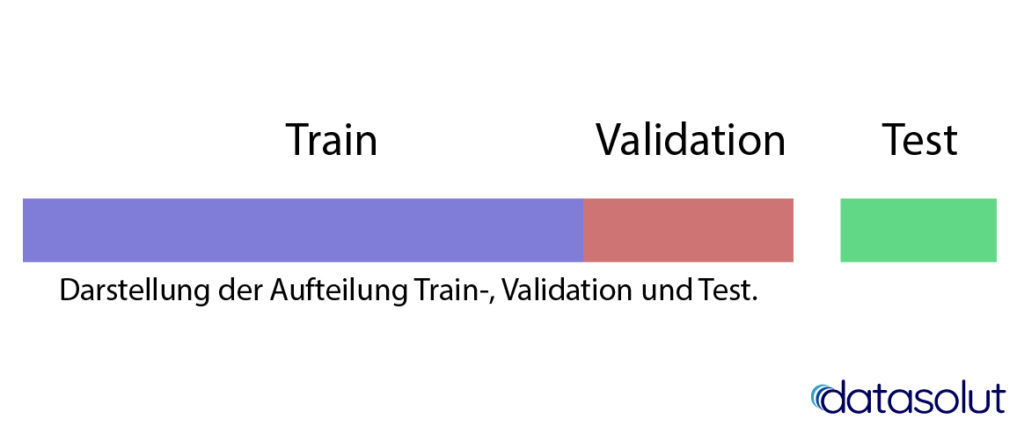

### 3.1.1 训练集、验证集和测试集的划分方法

划分数据集为训练集、验证集和测试集是机器学习实验中的标准实践。这可以防止模型过度拟合训练数据,并允许我们评估模型在未知数据上的泛化能力。

在PyTorch中,通常使用`torch.utils.data.random_split`来随机划分数据集。在划分数据集时,我们应确保所有数据集的分布是均衡的,这可以通过保留每个类别相同比例的样本在每个子集中来实现。下面是一个划分数据集的示例代码:

```python

from torch.utils.data import random_split, DataLoader, Dataset

# 假设data是包含所有样本的数据集

# 假设target是每个样本对应的标签列表

total_size = len(data)

train_size = int(0.6 * total_size) # 60%用于训练

val_size = int(0.2 * total_size) # 20%用于验证

test_size = total_size - train_size - val_size

train_dataset, val_dataset, test_dataset = random_split(

data, [train_size, val_size, test_size]

)

# 接下来可以创建DataLoader来批量加载数据

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

val_loader = DataLoader(val_dataset, batch_size=64)

test_loader = DataLoader(test_dataset, batch_size=64)

```

在上述代码中,我们首先将数据集随机地划分为训练集、验证集和测试集。然后,我们创建了`DataLoader`对象,这些对象可以高效地批量加载数据,并且在训练时可以打乱数据顺序以提高模型的泛化能力。

### 3.1.2 数据增强和标准化

数据增强是一种通过增加数据集的变化来提高模型鲁棒性的技术。在图像识别任务中,这可以包括旋转、缩放、裁剪、颜色抖动等操作。在文本处理中,它可能包括同义词替换、随机删除单词等技术。数据增强可以帮助模型对输入的微小变化具有不变性,从而提高其泛化能力。

标准化是一种将数据缩放至一个标准范围内的技术,例如,通常将图像的像素值缩放到0到1之间。标准化可以加速模型的收敛,因为它为梯度下降提供了更稳定的梯度值。

在PyTorch中,可以在数据集类中实现数据增强和标准化操作。以下是一个简单的图像数据集类,其中包含了标准化的步骤:

```python

import torch

from torchvision import transforms

from torch.utils.data import Dataset

class ImageDataset(Dataset):

def __init__(self, data, transform=None):

self.data = data

self.transform = transform

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

image, target = self.data[idx]

if self.transform:

image = self.transform(image)

return image, target

```

在上述代码中,`ImageDataset`类继承自`Dataset`类。我们可以在`__getitem__`方法中添加所需的数据增强和标准化操作。`transforms`模块提供了丰富的变换方法,如`transforms.Compose`用于组合多个变换,`transforms.Normalize`用于标准化操作等。

## 3.2 验证过程中的超参数调整

超参数是模型训练前设置的参数,它们不会在训练过程中通过数据学习得到。超参数的选择会直接影响模型的训练效果和泛化能力。

### 3.2.1 学习率、批大小和迭代次数的影响

- **学习率**:学习率决定了模型参数更新的幅度。如果学习率太大,模型可能会在最优值附近震荡,甚至发散;如果学习率太小,模型则需要更长的时间来收敛,并且有可能陷入局部最小值。

- **批大小**:批大小决定了每次训练中使用的样本数量。较大的批大小可以加速模型训练,因为可以更有效地利用GPU。但是,太大的批大小可能导致模型不能很好地泛化。

- **迭代次数**:迭代次数(也称为周期或epoch)是训练过程中数据集被完整遍历的次数。过高的迭代次数可能导致模型过拟合。

### 3.2.2 超参数优化策略

超参数优化通常是一个试错的过程,其中涉及手动调整、网格搜索、随机搜索或更高级的优化技术,如贝叶斯优化。在PyTorch中,可以使用`torch.optim`包中的优化器类来控制学习率等参数。

一个有效的策略是使用学习率调度器来动态调整学习率。例如,PyTorch提供了`torch.optim.lr_scheduler`模块,其中包含了多种调度策略,如`StepLR`、`ReduceLROnPlateau`等。

```python

from torch.optim import SGD

from torch.optim.lr_scheduler import StepLR

optimizer = SGD(model.parameters(), lr=0.01, momentum=0.9)

scheduler = StepLR(optimizer, step_size=30, gamma=0.1)

for epoch in range(num_epochs):

# 训练一个epoch

# ...

scheduler.step()

```

在上述代码中,我们首先定义了一个SGD优化器,并设置初始学习率为0.01。接着,我们使用`StepLR`学习率调度器来在每30个epoch后将

0

0