剖析HDF5文件结构:从底层了解HDF5文件组织

发布时间: 2024-07-06 10:32:05 阅读量: 112 订阅数: 39

# 1. HDF5文件基础**

HDF5(分层数据格式5)是一种科学数据存储格式,用于存储和管理大规模、复杂的数据集。它具有高性能、可扩展性和可移植性,广泛应用于科学计算、生物信息学和图像处理等领域。

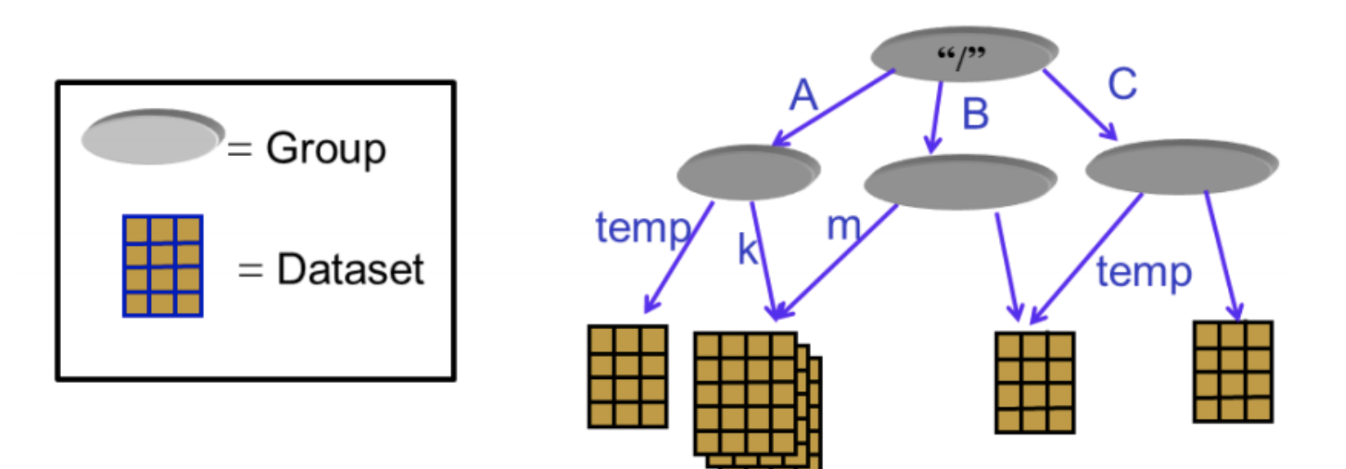

HDF5文件由一个分层结构组成,包括组、数据集和数据类型。组用于组织数据,数据集用于存储实际数据,而数据类型用于定义数据的格式和解释。HDF5还支持元数据,用于描述数据的内容和结构。

# 2. HDF5文件结构剖析

### 2.1 HDF5文件布局

HDF5文件采用分层结构,主要分为三个部分:文件头、超级块和数据块。

**文件头**

文件头位于文件开头,包含文件标识符、版本号和文件大小等基本信息。

**超级块**

超级块紧跟文件头,存储文件布局信息,包括数据块大小、超级块数量和根组地址等。

**数据块**

数据块存储实际数据,大小固定,通常为4KB或8KB。数据块通过B树组织,便于快速查找和访问。

### 2.2 HDF5数据类型

HDF5支持多种数据类型,包括:

**原生数据类型**

| 类型 | 描述 |

|---|---|

| H5T_NATIVE_CHAR | 字符 |

| H5T_NATIVE_INT | 整数 |

| H5T_NATIVE_FLOAT | 浮点数 |

| H5T_NATIVE_DOUBLE | 双精度浮点数 |

**复合数据类型**

复合数据类型由多个原生数据类型组合而成,用于表示复杂结构的数据。

### 2.3 HDF5数据集和组

**数据集**

数据集是HDF5中存储数据的基本单元,类似于关系数据库中的表。数据集具有名称、数据类型、形状和存储空间等属性。

**组**

组是HDF5中组织数据集和子组的容器。组可以嵌套,形成树形结构。

#### 代码块:创建数据集

```python

import h5py

# 创建HDF5文件

f = h5py.File('data.h5', 'w')

# 创建数据集

dset = f.create_dataset('data', (100, 100), dtype='i')

# 关闭文件

f.close()

```

#### 逻辑分析:

该代码块创建了一个名为data.h5的HDF5文件,并在其中创建了一个名为data的数据集。数据集具有100行100列的形状,数据类型为整数。

#### 参数说明:

* `f.create_dataset('data', (100, 100), dtype='i')`:创建名为data的数据集,形状为(100, 100),数据类型为整数。

#### mermaid流程图:HDF5文件布局

```mermaid

graph LR

subgraph 文件头

文件标识符

版本号

文件大小

end

subgraph 超级块

数据块大小

超级块数量

根组地址

end

subgraph 数据块

数据

end

文件头 --> 超级块

超级块 --> 数据块

```

# 3. HDF5文件操作实践

### 3.1 HDF5文件创建和打开

**创建HDF5文件**

```python

import h5py

# 创建一个新的HDF5文件

with h5py.File('my_hdf5_file.h5', 'w') as f:

pass

```

**参数说明:**

* `'my_hdf5_file.h5'`:HDF5文件路径和名称

* `'w'`:打开模式,'w'表示创建或覆盖现有文件

**打开HDF5文件**

```python

import h5py

# 打开一个现有的HDF5文件

with h5py.File('my_hdf5_file.h5', 'r') as f:

pass

```

**参数说明:**

* `'my_hdf5_file.h5'`:HDF5文件路径和名称

* `'r'`:打开模式,'r'表示只读

### 3.2 HDF5数据集读写

**创建数据集**

```python

import h5py

# 在HDF5文件中创建一个数据集

with h5py.File('my_hdf5_file.h5', 'w') as f:

dset = f.create_dataset('my_dataset', (100, 100), dtype='float64')

```

**参数说明:**

* `'my_dataset'`:数据集名称

* `(100, 100)`:数据集形状

* `'float64'`:数据类型

**写入数据集**

```python

import h5py

# 向HDF5数据集写入数据

with h5py.File('my_hdf5_file.h5', 'w') as f:

dset = f['my_dataset']

dset[:] = np.random.rand(100, 100)

```

**参数说明:**

* `dset[:]`:指定要写入数据的整个数据集

* `np.random.rand(100, 100)`:要写入的数据

**读取数据集**

```python

import h5py

# 从HDF5数据集读取数据

with h5py.File('my_hdf5_file.h5', 'r') as f:

dset = f['my_dataset']

data = dset[:]

```

**参数说明:**

* `dset[:]`:指定要读取数据的整个数据集

### 3.3 HDF5组管理

**创建组**

```python

import h5py

# 在HDF5文件中创建一个组

with h5py.File('my_hdf5_file.h5', 'w') as f:

group = f.create_group('my_group')

```

**参数说明:**

* `'my_group'`:组名称

**打开组**

```python

import h5py

# 打开一个HDF5组

with h5py.File('my_hdf5_file.h5', 'r') as f:

group = f['my_group']

```

**参数说明:**

* `'my_group'`:组名称

**删除组**

```python

import h5py

# 从HDF5文件中删除一个组

with h5py.File('my_hdf5_file.h5', 'w') as f:

del f['my_group']

```

**参数说明:**

* `'my_group'`:要删除的组名称

# 4. HDF5文件高级应用

### 4.1 HDF5文件压缩和过滤

HDF5提供了强大的数据压缩和过滤功能,可以显著减少文件大小,提高存储效率和数据传输速度。

**4.1.1 压缩**

HDF5支持多种压缩算法,包括:

- GZIP

- BZIP2

- LZF

- SZIP

选择合适的压缩算法取决于数据类型、压缩率和性能要求。

**4.1.2 过滤**

过滤是一种数据预处理技术,可以在写入数据之前应用,以减少文件大小。HDF5支持多种过滤器,包括:

- Chunking

- FLETCHER32

- NBIT

- SCALE

过滤与压缩结合使用,可以进一步提高文件压缩率。

### 4.2 HDF5文件并行访问

HDF5支持并行文件访问,允许多个进程或线程同时读写文件。这对于大型数据集的处理和分析非常有用。

**4.2.1 并行读写**

HDF5提供了多种并行读写模式,包括:

- 独立模式:每个进程或线程独立访问文件。

-集体模式:所有进程或线程协调访问文件。

选择合适的并行模式取决于应用程序的性能要求。

**4.2.2 并行I/O优化**

为了优化并行I/O性能,可以采用以下策略:

- 使用大块大小

- 避免小I/O操作

- 使用集体I/O模式

### 4.3 HDF5文件扩展属性

HDF5提供了扩展属性功能,允许用户向文件或对象添加自定义元数据。这对于存储应用程序特定的信息或跟踪文件历史记录非常有用。

**4.3.1 扩展属性类型**

HDF5支持多种扩展属性类型,包括:

- 字符串

- 整数

- 浮点数

- 二进制数据

**4.3.2 扩展属性操作**

用户可以使用HDF5 API创建、读取、写入和删除扩展属性。

```python

# 创建扩展属性

h5py.File("file.h5").attrs.create("my_attr", "my_value")

# 读取扩展属性

value = h5py.File("file.h5").attrs["my_attr"]

# 写入扩展属性

h5py.File("file.h5").attrs["my_attr"] = "new_value"

# 删除扩展属性

del h5py.File("file.h5").attrs["my_attr"]

```

# 5.1 HDF5文件性能分析

HDF5文件性能分析对于优化文件访问和提高应用程序效率至关重要。以下是一些常用的性能分析工具和技术:

- **H5Perf**:H5Perf是一个HDF5提供的命令行工具,用于分析HDF5文件的性能。它可以生成有关文件布局、数据类型和访问模式的详细报告。

- **VTune Amplifier**:VTune Amplifier是一个英特尔提供的性能分析工具,可以分析HDF5应用程序的性能。它可以识别瓶颈并提供优化建议。

- **HDF5 Profiler**:HDF5 Profiler是一个HDF5提供的库,可以收集有关HDF5函数调用和数据访问的性能数据。它可以帮助识别性能问题并指导优化工作。

除了这些工具之外,还可以通过以下方法手动分析HDF5文件性能:

- **检查文件布局**:HDF5文件布局会影响访问性能。例如,将数据块分组到较大的块中可以提高顺序访问的性能,而将数据块分散到较小的块中可以提高随机访问的性能。

- **分析数据类型**:HDF5数据类型的大小和复杂性会影响访问性能。例如,使用较小的数据类型可以减少内存消耗并提高访问速度。

- **监控访问模式**:HDF5应用程序的访问模式会影响性能。例如,频繁的随机访问比顺序访问更慢。通过监控访问模式,可以确定性能瓶颈并进行优化。

## 5.2 HDF5文件优化策略

根据性能分析的结果,可以采用以下策略来优化HDF5文件:

- **优化文件布局**:通过将数据块分组到较大的块中或将数据块分散到较小的块中,可以优化文件布局以提高访问性能。

- **优化数据类型**:通过使用较小的数据类型或使用复合数据类型来表示复杂数据,可以优化数据类型以减少内存消耗并提高访问速度。

- **优化访问模式**:通过使用HDF5提供的缓存和预取功能,可以优化访问模式以提高性能。例如,可以通过设置文件读写缓冲区大小或使用HDF5预取器来提高顺序访问性能。

- **使用压缩和过滤**:HDF5提供了一系列压缩和过滤算法,可以减少文件大小并提高访问性能。例如,使用无损压缩算法可以减少文件大小,而使用滤波器可以减少数据访问时间。

- **并行访问**:HDF5支持并行访问,这可以提高大型文件的访问性能。例如,可以通过使用HDF5 MPI接口或HDF5并行库来实现并行访问。

0

0