MapReduce与分布式计算框架:优缺点对比,如何克服挑战

发布时间: 2024-10-30 11:23:23 阅读量: 45 订阅数: 32

并行与分布式计算PPT汇总.rar

# 1. MapReduce的基本原理

## 1.1 简介

MapReduce是一种编程模型,用于处理和生成大数据集。它的基本原理可以概括为“分而治之”:将大规模的数据集分割成小块进行分布式处理,最后汇总计算结果。这个模型由Google提出,并在Hadoop框架中得到了广泛应用。

## 1.2 核心概念

MapReduce的核心概念包括Map(映射)和Reduce(归约)两个过程。Map阶段将输入的数据集分解为独立的元素,并进行处理,生成一系列中间结果。Reduce阶段则对这些中间结果进行汇总,得到最终结果。

```python

# Map过程示例代码

def map_function(value):

# 处理每个输入值,返回中间键值对

key, val = process(value)

emit(key, val)

# Reduce过程示例代码

def reduce_function(key, values):

# 对具有相同键的值进行汇总处理

result = aggregate(values)

emit(key, result)

```

## 1.3 应用场景

MapReduce模型在许多场景下都非常有用,尤其是需要对大量数据进行排序、分组和汇总的情况。例如,它可以用于日志文件分析、数据清洗、索引构建等任务。MapReduce易于编程,并且由于其设计简单,被广泛应用于云计算和大规模数据分析领域。

在下一章,我们将深入探讨MapReduce的优缺点,以及它如何适应和改变当前的大数据处理生态。

# 2. MapReduce的优缺点分析

MapReduce作为分布式计算领域的先驱,自诞生之日起就伴随着一系列核心优势,然而随着技术的发展和应用需求的提升,其局限性和挑战也逐渐显现。本章将深入探讨MapReduce的技术优势、不足之处以及当前面临的挑战。

## 2.1 MapReduce的核心优势

### 2.1.1 高效处理大规模数据集

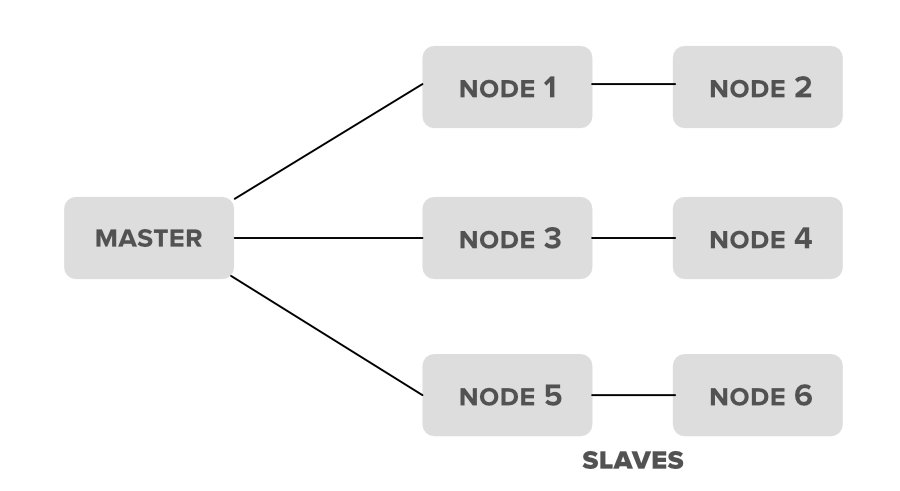

MapReduce的一个核心优势在于其能够高效地处理大规模数据集。Hadoop生态系统中的MapReduce框架通过分割大数据集为较小的数据块,并在集群中的多个节点上并行处理这些数据块,从而实现数据处理的高效率。这一优势在处理PB级别的数据时尤为明显,能够在合理的时间内输出结果。

#### 2.1.2 容错机制和稳定性能

MapReduce通过其内建的容错机制,保证了处理过程的稳定性。其核心在于数据的复制,即MapReduce将输入数据复制为多个副本,并在多个节点上运行,当某个节点失败时,系统可以自动在其他节点上重新启动任务,从而保证整体计算任务的顺利进行。这种容错性使得MapReduce在长时间运行的批处理任务中表现出色。

## 2.2 MapReduce的局限性

### 2.2.1 延迟高与实时性不足

尽管MapReduce在处理大规模数据集方面表现出色,但其在实时性方面存在明显不足。MapReduce的批处理性质导致其对数据的处理延迟较高。对于需要快速响应的应用场景,如在线分析、实时数据处理等,MapReduce并不适合。

#### 2.2.2 可扩展性和资源利用率问题

传统MapReduce模型在资源利用率和可扩展性方面也面临挑战。一方面,MapReduce的任务调度和资源管理相对粗放,可能导致资源浪费;另一方面,当处理数据量急剧增长时,需要增加更多硬件资源,这在成本和管理上都提出了更高的要求。

## 2.3 MapReduce面临的挑战

### 2.3.1 复杂任务处理难度

MapReduce在处理复杂任务时的难度较大,尤其是涉及到多步骤、多阶段的数据处理流程。MapReduce编程模型相对简单,主要针对的是Map和Reduce两个操作,对于需要大量自定义逻辑和复杂数据流的任务,MapReduce无法灵活应对。

#### 2.3.2 兼容性与维护成本

由于MapReduce模型较为古老,它在与其他新兴技术(如Hadoop生态系统之外的组件)的兼容性方面存在问题。对于已有的MapReduce代码库,维护和升级也是一项挑战,需要投入大量人力和时间资源。

## 2.1.1 高效处理大规模数据集的案例分析

为展示MapReduce在高效处理大规模数据集方面的优势,以下是一个具体案例分析:

```java

// MapReduce编程模型示例代码

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

```

### 代码逻辑解读

上述代码是一个MapReduce的Mapper类实现,用于文本数据的分词处理。它将输入的文本(Text)分割为单词,并为每个单词输出一个键值对(Text, IntWritable),其中Text是单词,IntWritable是出现次数(1)。该Mapper类是MapReduce处理大规模数据集的关键组件,其并行处理能力能够显著提高处理效率。

## 2.2.1 延迟高与实时性不足的案例分析

以下是展示MapReduce延迟高和实时性不足方面的案例分析:

| 应用场景 | 实时性要求 | MapReduce适合度 |

|----------|-------------|-----------------|

| 在线广告点击分析 | 高 | 不适合 |

| 日志文件分析 | 中 | 适合 |

| 社交网络数据挖掘 | 中低 | 适合 |

上表显示了MapReduce在不同应用场景下的适用性,可以明显看出MapReduce并不适合需要高实时性的应用。由于MapReduce的批处理特性,它更适合处理周期性或不需即时响应的数据分析任务。

## 2.3.2 兼容性与维护成本的案例分析

MapReduce的兼容性问题和高昂的维护成本可以通过下述案例说明:

| 兼容性挑战 | 维护成本 |

|-------------|----------|

| 集成外部机器学习库 | 高 |

| 优化现有MapReduce作业 | 中 |

| 迁移旧系统到新系统 | 极高 |

以上列出的挑战反映了MapReduce在新技术融合和现有系统维护方面的挑战。尤其是数据处理生态系统逐渐向Spark等新一代技术迁移时,MapReduce系统的兼容性和维护成本问题变得更为明显。

在下一章节中,我们将深入探讨分布式计算框架的新趋势,并对MapReduce与新框架在实际应用中的对比进行分析。

# 3. 分布式计算框架的新趋势

## 3.1 现代分布式框架概述

### 3.1.1 Spark框架的特点

Apache Spark自从2014年发布以来,已经迅速成为分布式计算领域的重要力量。Spark的优势主要体现在以下几个方面:

- **内存计算**:Spark的核心创新之一是其基于内存的计算模式,这使得它在处理迭代算法和交互式查询时,速度比基于磁盘的系统快很多。

- **统一的处理引擎**:Spark提供了一个统一的编程模型,能够支持批处理、流处理、机器学习和图计算等多种类型的应用。

- **易用性**:Spark支持多种编程语言,如Scala、Java、Python和R,同时提供了一个强大的开发库,方便用户进行数据挖掘和分析。

- **容错机制**:利用弹性分布式数据集(RDDs)的不变性和分区特性,Spark能够有效地处理节点失败导致的计算中断。

代码块示例:

```scala

// Spark的简单WordCount程序

val textFile = sc.textFile("hdfs://...")

val counts = textFile.flatMap(line => line.split(" "))

.map(word => (word, 1))

.reduceByKey(_ + _)

counts.saveAsTextFile("hdfs://...")

```

以上代码展示了如何使用Spark进行简单的文本处理。通过创建RDDs,数据被分片存储在多个节点上,然后通过`flatMap`、`map`和`reduceByKey`等操作进行并行处理。

0

0