【sre_parse进阶指南】:优化正则匹配效率,提升文本处理性能的秘诀

发布时间: 2024-10-13 07:59:48 阅读量: 14 订阅数: 12

# 1. sre_parse的基本概念和应用场景

## 1.1 sre_parse的基本概念

sre_parse是一个强大的文本解析工具,它在IT行业中被广泛应用于日志分析、数据清洗等领域。其核心功能是通过正则表达式对文本进行精确匹配和解析,从而实现对信息的快速提取和处理。

## 1.2 sre_parse的工作原理

sre_parse的基本工作原理是利用正则表达式构建一个规则引擎,通过编译正则表达式生成一个高效的匹配模式,然后用这个模式去匹配目标文本。在匹配过程中,sre_parse会按照正则表达式的规则,从左到右扫描文本,查找符合规则的子串。

## 1.3 sre_parse的应用场景

sre_parse的典型应用场景包括但不限于:

- **日志分析**:快速定位日志中的关键信息,如错误信息、性能瓶颈等。

- **数据清洗**:提取和格式化不规则数据,为数据分析和决策提供支持。

- **安全监控**:在网络安全领域,用于检测和识别潜在的威胁和异常行为。

通过上述内容,我们可以看出,sre_parse作为一个文本解析工具,不仅功能强大,而且应用广泛,为IT行业的各种任务提供了极大的便利。接下来的章节将深入探讨正则表达式的基础知识及其在sre_parse中的应用和优化技巧。

# 2. 正则表达式的基础和优化

正则表达式是一种强大的文本处理工具,它允许用户通过定义字符序列模式来搜索、匹配和操作字符串。在IT行业中,正则表达式被广泛应用于数据验证、日志分析、文本提取等领域。本章节将详细介绍正则表达式的基础知识、高级特性以及优化技巧,帮助读者深入理解并有效运用这一工具。

## 2.1 正则表达式的基本语法

### 2.1.1 元字符和特殊符号

元字符是正则表达式中的基本构建块,它们具有特殊的意义。例如,`.` 表示任意单个字符,`*` 表示前面的元素可以出现零次或多次,`+` 表示至少一次,`?` 表示零次或一次。特殊符号如 `\d` 表示数字,`\w` 表示字母或数字,`\s` 表示空白字符。

### 2.1.2 字符类和量词

字符类允许定义一个字符集合,如 `[abc]` 表示匹配 `a`、`b` 或 `c` 中的任意一个。量词则用于指定元素的重复次数,如 `{n}` 表示恰好 `n` 次,`{n,}` 表示至少 `n` 次,`{n,m}` 表示 `n` 到 `m` 次之间。

### 2.1.3 表格:常用元字符和特殊符号

| 元字符 | 含义 |

| -------- | ------------------------------------------------------------ |

| `.` | 任意单个字符 |

| `*` | 前面的元素可以出现零次或多次 |

| `+` | 前面的元素至少出现一次 |

| `?` | 前面的元素零次或一次 |

| `\d` | 任何数字,等同于 `[0-9]` |

| `\w` | 任何字母或数字,等同于 `[a-zA-Z0-9_]` |

| `\s` | 任何空白字符 |

| `[]` | 字符集合 |

| `{n,m}` | 前面的元素出现 `n` 到 `m` 次之间 |

| `\` | 转义符号,用于匹配特殊字符 |

## 2.2 正则表达式的高级特性

### 2.2.1 分组和引用

分组允许将多个元素视为一个单元,使用括号 `()` 实现。引用则可以匹配分组中的内容,使用 `\` 后跟组号来引用,例如 `\1`、`\2`。

### 2.2.2 零宽断言和负向前瞻

零宽断言不消耗任何字符,只是进行位置匹配。正向断言 `(?=...)` 表示某个位置后面紧跟的内容满足模式,负向断言 `(?!...)` 则表示某个位置后面不紧跟某些内容。例如,`(?=\d)` 表示匹配数字前面的位置。

## 2.3 正则表达式的优化技巧

### 2.3.1 避免回溯和贪婪模式

回溯是正则表达式中导致性能下降的主要原因,特别是在处理复杂模式时。贪婪模式会尽可能多地匹配字符,导致不必要的回溯。避免贪婪模式的一种方法是使用懒惰量词 `*?`、`+?`、`??`、`{n,m}?`。

### 2.3.2 使用具体字符集和限定符

使用具体字符集可以减少匹配的可能性,从而提高效率。例如,使用 `[a-zA-Z0-9]` 替代 `\w`。限定符如 `\b` 表示单词边界,可以提高边界匹配的效率。

### 2.3.3 mermaid流程图:正则表达式匹配过程

```mermaid

graph LR

A[开始匹配] --> B[检查当前字符]

B -->|匹配| C[移动到下一个字符]

B -->|不匹配| D[回溯到上一个可能的位置]

C -->|结束| E[匹配成功]

D -->|回溯结束| B

E --> F[结束匹配]

```

## 2.3.4 代码块:正则表达式匹配示例

```python

import re

text = "The quick brown fox jumps over the lazy dog."

pattern = r'\b[a-z]+\b'

# 使用正则表达式进行匹配

matches = re.findall(pattern, text)

# 输出匹配结果

for match in matches:

print(match)

```

在本章节中,我们介绍了正则表达式的基础语法、高级特性和优化技巧。通过具体的应用示例和流程图,我们展示了正则表达式的工作原理和如何有效优化匹配过程。接下来,我们将深入探讨 `sre_parse` 的文本匹配技巧及其在实际应用中的表现。

# 3. sre_parse的实践应用

在本章节中,我们将深入探讨sre_parse的实践应用,包括文本匹配技巧、日志分析以及数据清洗等方面。通过本章节的介绍,您将能够更好地理解如何将sre_parse技术应用于实际场景中,提高工作效率和数据处理的准确性。

## 3.1 sre_parse的文本匹配技巧

### 3.1.1 单行文本匹配

sre_parse技术在单行文本匹配方面的应用非常广泛,它可以快速准确地定位和提取特定的信息。例如,在处理配置文件、日志记录或代码注释时,我们经常需要查找特定的模式或字符串。

下面是一个单行文本匹配的简单示例:

```python

import re

text = "This is a sample text with a number: 12345."

pattern = r"(\b\d+\b)"

matches = re.findall(pattern, text)

for match in matches:

print(match)

```

在这个示例中,我们定义了一个正则表达式`(\b\d+\b)`来匹配一个或多个连续的数字,并确保这些数字是完整的单词。`re.findall()`函数会找到所有匹配的结果并返回一个列表。

### 3.1.2 多行文本匹配

多行文本匹配在处理多行数据时特别有用,比如在分析日志文件或文本文件时。sre_parse提供了`re.MULTILINE`标志,允许我们匹配字符串的开始和结束位置。

```python

text = """This is the first line.

This is the second line.

This is the third line."""

pattern = r"^This is the (\w+) line\.$"

matches = re.findall(pattern, text, re.MULTILINE)

for match in matches:

print(match)

```

在这个示例中,我们使用了`^`和`$`来匹配每一行的开始和结束,`re.MULTILINE`标志确保`^`和`$`匹配每一行的开始和结束,而不仅仅是整个字符串的开始和结束。

### 3.1.3 文本匹配的mermaid流程图

为了更好地理解文本匹配的过程,我们可以使用mermaid流程图来表示:

```mermaid

graph LR

A[Start] --> B[Load Text]

B --> C[Define Pattern]

C --> D[Apply Pattern]

D --> E[Check Matches]

E -->|Has Matches| F[Process Matches]

E -->|No Matches| G[End]

F --> H[Output Results]

H --> G

```

在这个流程图中,我们从开始(Start)加载文本(Load Text),定义匹配模式(Define Pattern),应用模式(Apply Pattern),检查匹配结果(Check Matches),如果有匹配处理匹配(Process Matches),否则结束(End)。如果有匹配结果,输出结果(Output Results),然后结束。

## 3.2 sre_parse在日志分析中的应用

### 3.2.1 日志结构分析

日志文件通常包含大量的结构化和半结构化数据。sre_parse可以帮助我们分析这些日志文件,提取关键信息,如时间戳、IP地址、请求方法等。

```python

import re

log_entry = "2023-03-28 12:34:56 [INFO] User 'admin' logged in from ***.***.*.*"

pattern = r"\[(.*?)\] User '(.*?)' logged in from (.*?)"

match = re.search(pattern, log_entry)

if match:

timestamp, username, ip_address = match.groups()

print(f"Timestamp: {timestamp}, Username: {username}, IP Address: {ip_address}")

else:

print("No match found")

```

在这个示例中,我们定义了一个正则表达式来匹配日志条目的时间戳、用户名和IP地址。`re.search()`函数用于在字符串中搜索第一个与模式匹配的子串。

### 3.2.2 日志内容提取

除了结构化分析,我们还可以使用sre_parse提取日志中的特定内容,例如错误信息、请求路径等。

```python

log_entries = [

"2023-03-28 12:34:56 [ERROR] Unable to process request: /api/login",

"2023-03-28 12:35:56 [INFO] User 'admin' logged in from ***.***.*.*"

]

pattern = r"(?P<timestamp>\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}) \[(?P<level>.*?)\] (?P<msg>.*)"

for log_entry in log_entries:

match = re.search(pattern, log_entry)

if match:

print(match.groupdict())

```

在这个示例中,我们使用命名捕获组(`(?P<name>...)`)来提取日志条目的时间戳、日志级别和消息内容。`re.search()`函数用于在每个日志条目中搜索匹配的模式,并打印出提取的字典。

### 3.2.3 日志内容提取的表格展示

为了更清晰地展示提取的的日志内容,我们可以使用Markdown表格:

| Timestamp | Level | Message |

|-----------------|--------|----------------------------------------|

| 2023-03-28 12:34:56 | ERROR | Unable to process request: /api/login |

| 2023-03-28 12:35:56 | INFO | User 'admin' logged in from ***.***.*.* |

这个表格清晰地展示了从日志条目中提取的时间戳、日志级别和消息内容。

## 3.3 sre_parse在数据清洗中的应用

### 3.3.1 数据格式化

数据清洗是数据处理中的一项重要工作,sre_parse可以帮助我们将非结构化的数据转换为结构化的格式。

```python

import re

raw_data = "name: John Doe; age: 30; email: ***"

pattern = r"name:\s*(.*?)\s*; age:\s*(\d+)\s*; email:\s*(\S+)"

formatted_data = re.sub(pattern, r"\1,\2,\3", raw_data)

print(formatted_data)

```

在这个示例中,我们定义了一个正则表达式来匹配名字、年龄和电子邮件地址,并使用`re.sub()`函数将它们格式化为逗号分隔的值。

### 3.3.2 数据过滤

在数据清洗过程中,我们经常需要过滤掉不符合条件的数据。sre_parse可以用来识别和删除不符合要求的条目。

```python

import re

raw_data = [

"name: John Doe; age: 30; email: ***",

"name: Jane Smith; age: 25; email: ***",

"invalid entry"

]

pattern = r"name:\s*(.*?)\s*; age:\s*(\d+)\s*; email:\s*(\S+)"

filtered_data = [entry for entry in raw_data if re.fullmatch(pattern, entry)]

print(filtered_data)

```

在这个示例中,我们使用`re.fullmatch()`函数来过滤掉不匹配模式的条目。

### 3.3.3 数据过滤的代码逻辑解读

代码逻辑的逐行解读分析:

1. 导入`re`模块,这是Python中用于处理正则表达式的标准库。

2. 定义一个包含原始数据的列表`raw_data`,其中包含有效的条目和一个无效的条目。

3. 定义一个正则表达式`pattern`,用于匹配名字、年龄和电子邮件地址。

4. 使用列表推导式来过滤数据,只保留与模式匹配的条目。

5. 打印过滤后的数据列表`filtered_data`。

参数说明:

- `raw_data`:原始数据列表。

- `pattern`:用于匹配数据的正则表达式模式。

- `filtered_data`:过滤后的数据列表。

在本章节中,我们通过具体的示例展示了sre_parse在文本匹配、日志分析和数据清洗方面的应用。通过这些示例,您可以了解到如何使用sre_parse来解决实际问题,提高数据处理的效率和准确性。接下来的章节将深入探讨sre_parse的性能调优策略,帮助您进一步提升sre_parse的应用效果。

# 4. sre_parse的性能调优

在本章节中,我们将深入探讨sre_parse在性能调优方面的策略和实践,以确保其在文本解析、日志分析和数据清洗等应用场景中能够以最佳性能运行。我们将从性能瓶颈的分析开始,逐步深入到具体的优化策略,并通过实际案例来展示性能优化的效果评估。

## 4.1 sre_parse的性能瓶颈分析

### 4.1.1 性能瓶颈的识别方法

在进行性能调优之前,第一步是要识别出sre_parse在处理文本时可能遇到的性能瓶颈。这通常涉及到对系统资源的监控和分析,比如CPU使用率、内存消耗和I/O操作等。我们可以通过以下几种方法来识别性能瓶颈:

- **资源监控工具**:使用如`top`, `htop`, `iotop`等系统监控工具来观察sre_parse运行时的资源使用情况。

- **代码分析**:通过分析sre_parse的代码,检查是否有不必要的重复计算或者复杂的递归调用。

- **日志分析**:观察sre_parse的运行日志,查找异常行为或长时间的处理延迟。

### 4.1.2 常见的性能瓶颈案例

在实际应用中,我们可能会遇到以下几种常见的性能瓶颈案例:

- **复杂的正则表达式**:过于复杂的正则表达式可能导致大量的回溯操作,从而显著增加处理时间。

- **大数据量处理**:处理大量数据时,如果没有适当的内存管理,可能会导致内存溢出。

- **递归调用**:如果sre_parse中的某些功能是递归实现的,那么在处理深层次的嵌套结构时可能会导致性能下降。

## 4.2 sre_parse的性能优化策略

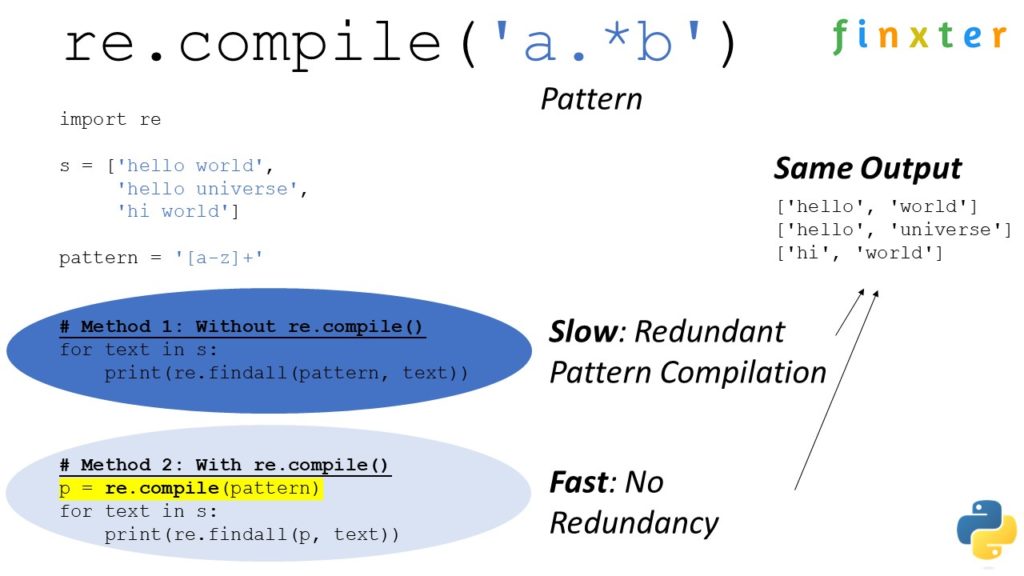

### 4.2.1 编译优化

编译优化主要是在sre_parse编译正则表达式时进行的优化。一些优化策略包括:

- **预编译正则表达式**:将常用的正则表达式预先编译,避免每次匹配时重复编译的开销。

- **使用具体字符集和限定符**:避免使用过于宽泛的字符集和限定符,比如使用`\w`代替`[a-zA-Z0-9_]`。

- **避免使用回溯**:尽量设计不依赖回溯的正则表达式。

### 4.2.2 执行优化

执行优化则是在sre_parse运行时进行的优化,以下是一些常见的执行优化策略:

- **减少数据拷贝**:在处理大量数据时,尽量减少不必要的数据拷贝,以降低内存使用和提高处理速度。

- **并行处理**:对于可以并行处理的任务,使用多线程或多进程来分担工作负载。

- **缓存优化**:对频繁访问的数据或中间结果进行缓存,以减少重复计算的开销。

## 4.3 sre_parse的性能优化实践

### 4.3.1 实际案例分析

在本节中,我们将通过一个实际案例来分析sre_parse的性能瓶颈,并展示如何进行优化。假设我们有一个日志文件分析任务,需要从大量日志中提取特定的信息。在未经优化的情况下,这个任务可能需要数小时才能完成。通过性能分析,我们发现瓶颈主要在于正则表达式的复杂度和数据处理的方式。

### 4.3.2 性能优化的效果评估

在进行了编译优化和执行优化之后,我们需要评估优化的效果。这通常涉及到重新运行优化后的代码,并对比优化前后的性能指标。以下是一个简单的性能评估示例:

```bash

# 优化前的性能指标

time ./sre_parse未经优化的脚本 < 大量日志文件 > 输出文件

# 优化后的性能指标

time ./sre_parse优化后的脚本 < 大量日志文件 > 输出文件

# 性能提升的百分比计算

性能提升百分比 = ((优化前时间 - 优化后时间) / 优化前时间) * 100%

```

通过上述步骤,我们可以量化性能提升的效果,并确保优化工作得到了实际的性能收益。

### 总结

本章节介绍了sre_parse的性能调优策略,包括性能瓶颈的分析、编译优化和执行优化等。通过实际案例分析和性能评估,我们展示了如何对sre_parse进行性能优化,并确保优化措施能够带来实际的效果。在下一章节中,我们将探讨sre_parse的高级功能以及在新兴领域的应用前景。

# 5. sre_parse的高级应用和未来展望

## 5.1 sre_parse的高级功能

sre_parse不仅仅是一个简单的文本解析工具,它还具备一些高级功能,如预编译和缓存,以及并行处理和分布式处理的能力。这些高级功能可以让sre_parse在处理大规模数据和实时数据流时表现得更加出色。

### 5.1.1 预编译和缓存

预编译是指在处理文本之前,先对正则表达式进行编译处理,这样可以提高匹配效率。在sre_parse中,可以通过预编译正则表达式来加速匹配过程,尤其是在需要多次使用同一表达式时,预编译可以显著减少重复编译的时间。

```python

import re

from sre_parse import parse

# 正则表达式预编译

regex = ***pile(r'\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}')

# 模拟大规模数据

data = "2023-04-01T12:00:00" * 100000

# 使用预编译的正则表达式进行匹配

matches = regex.findall(data)

```

缓存则是指在处理过程中,将已经匹配的结果存储起来,以避免重复的匹配工作。这在处理具有重复模式的数据时非常有用。

### 5.1.2 并行处理和分布式处理

随着数据量的增加,单线程的处理方式可能无法满足需求。sre_parse支持并行处理,可以通过多线程或多进程来加速数据处理。

```python

import multiprocessing

# 大规模数据集

data_chunks = ["data_chunk_1", "data_chunk_2", ...]

def process_data(data_chunk):

# 使用sre_parse处理数据

pass

# 创建进程池

pool = multiprocessing.Pool(processes=4)

results = pool.map(process_data, data_chunks)

```

分布式处理则是在多台机器上同时处理数据,这在处理PB级别的数据时尤为重要。sre_parse可以通过集成到分布式计算框架中,如Apache Spark或Hadoop,来实现分布式处理。

```python

# 分布式处理示例

from pyspark import SparkContext

sc = SparkContext()

data_rdd = sc.parallelize(data_chunks)

# 使用sre_parse进行分布式处理

matches_rdd = data_rdd.flatMap(process_data)

```

## 5.2 sre_parse在新兴领域的应用

随着技术的发展,sre_parse的应用领域也在不断扩展。下面将探讨sre_parse在大数据处理以及人工智能和机器学习领域的应用。

### 5.2.1 大数据处理

在大数据领域,sre_parse可以用于日志分析、数据清洗、实时数据流处理等场景。例如,它可以快速解析和过滤海量的日志文件,提取有用信息。

### 5.2.2 人工智能和机器学习

在人工智能和机器学习领域,sre_parse可以帮助处理和分析文本数据,例如,在自然语言处理(NLP)中,它可以用于文本分类、情感分析、实体识别等任务。

## 5.3 sre_parse的未来发展趋势

sre_parse作为一个开源的文本解析库,其未来的发展趋势主要集中在性能提升和功能扩展,以及社区发展和开源贡献方面。

### 5.3.1 性能提升和功能扩展

随着硬件性能的提升和算法的优化,sre_parse未来可能会增加更多的性能优化措施,如支持更多的正则表达式特性,以及提供更高效的缓存机制。功能上,可能会增加对更多编程语言的支持,以及提供更多的内置函数和工具。

### 5.3.2 社区发展和开源贡献

开源社区的力量是巨大的,sre_parse的发展也离不开社区的支持。未来,随着社区的壮大,更多的开发者将参与到sre_parse的贡献中来,为库的完善和功能扩展提供更多的思路和解决方案。此外,社区还可以通过举办研讨会、编写文档、提供教程等方式,帮助更多的开发者了解和使用sre_parse。

通过以上分析,我们可以看到sre_parse在文本处理领域的强大潜力,以及它在新兴领域应用的广阔前景。随着技术的不断进步,sre_parse必将在未来的IT行业中发挥更加重要的作用。

0

0