【SEO优化神器】:爬虫技术在搜索引擎优化中的应用

发布时间: 2024-12-25 20:30:19 阅读量: 4 订阅数: 9

SEO/搜索引擎优化 SEO/搜索引擎优化

# 摘要

本文从爬虫技术与搜索引擎优化的角度出发,系统地探讨了爬虫技术的基础知识、实践应用和优化策略。首先,概述了爬虫技术的定义、作用、组成和类型,以及爬虫的工作原理,包括网页数据抓取流程、数据解析提取方法和存储管理机制。然后,分析了爬虫在搜索引擎优化中的应用,如关键词抓取分析和竞争对手网站监控,以及数据分析处理的流程。此外,本文还讨论了爬虫性能优化的方法、法律法规的遵循问题,以及未来趋势,包括人工智能技术的融合和伦理道德问题的探讨。通过对现有技术的梳理和未来发展的展望,本篇论文旨在为爬虫技术的学习者和从业者提供全面的参考。

# 关键字

爬虫技术;搜索引擎优化;数据分析;性能优化;法律法规;人工智能

参考资源链接:[八爪鱼云采集:零基础轻松爬取网页数据](https://wenku.csdn.net/doc/53yofpk11q?spm=1055.2635.3001.10343)

# 1. 爬虫技术与搜索引擎优化

在当今的信息时代,网络爬虫技术已经成为获取线上数据的关键手段之一。SEO(搜索引擎优化)专家和数据分析师们依赖于爬虫技术来收集网站内容、关键词排名和用户行为等信息,用以优化搜索引擎结果页面(SERP)的显示,并为营销策略提供数据支持。本章我们将简要介绍爬虫技术的基本概念及其在SEO中的应用,以及如何通过爬虫优化搜索引擎的相关策略。

## 1.1 爬虫技术概述

爬虫,亦称为网络蜘蛛(web spider)或网络机器人(web robot),是一种自动化地访问网页并从中提取信息的程序。它们在互联网上不停地浏览,按照既定的规则收集、索引并分析数据。其作用可以归纳为信息收集、监控、自动化查询和数据分析等。

## 1.2 爬虫的工作原理

一个基本的爬虫工作流程通常包括以下步骤:

- 初始化URL队列,存放起始的网页地址。

- 从队列中取出URL,并访问对应的网页。

- 解析网页内容,提取出新的URL和需要的数据。

- 存储数据到文件或数据库中,并将新的URL加入队列继续抓取。

- 检测并遵循robots.txt协议,遵守网站爬取规则。

通过这一流程,爬虫实现了对互联网海量数据的自动化搜集,为搜索引擎优化(SEO)提供了丰富的数据资源。在SEO中,爬虫能够帮助分析竞争对手的网站结构、关键词使用频率以及反向链接策略等,从而制定更加有效的SEO计划。

# 2. 爬虫技术基础

## 2.1 爬虫技术概述

### 2.1.1 爬虫的定义和作用

网络爬虫(Web Crawler),亦称网络蜘蛛(Web Spider)或网络机器人(Web Robot),是一种自动化地从互联网获取信息的程序或脚本。爬虫是搜索引擎、数据挖掘、互联网监控等应用中不可或缺的技术工具。它们的主要作用包括但不限于:

- 自动化收集网页内容,为搜索引擎索引提供原材料;

- 为数据分析提供大量的原始数据集;

- 监测和分析网站更新,适用于新闻网站、博客等;

- 信息监控和抓取,例如价格监控、舆情分析等。

### 2.1.2 爬虫的基本组成和类型

一个基本的网络爬虫通常包含以下几个组成部分:

- **调度器(Scheduler)**:负责存放待抓取的URL,并从中选择URL进行爬取。

- **下载器(Downloader)**:负责下载网页内容。

- **解析器(Parser)**:负责解析下载的网页内容,提取出新的URL加入到调度器中。

- **存储器(Storage)**:负责存储爬取到的数据。

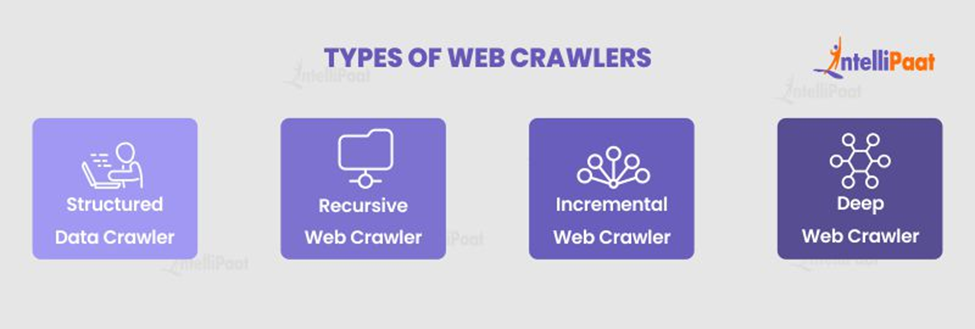

爬虫根据其工作方式和目标可以分为不同的类型:

- **通用爬虫**:广泛收集各类网页,为搜索引擎索引提供支持。

- **垂直爬虫**:专注于某一特定主题或领域的网页信息爬取。

- **增量爬虫**:只抓取上次爬取后新出现或更新过的网页内容。

- **深度爬虫**:深入网站结构,获取深层次的数据。

## 2.2 爬虫的工作原理

### 2.2.1 网页数据的抓取流程

网页数据的抓取流程如下:

1. 调度器从初始URL列表开始,选择一个URL发起请求。

2. 下载器获取该URL对应的网页内容,并将内容传递给解析器。

3. 解析器分析网页内容,提取新的URL地址和需要抓取的数据。

4. 将提取的URL地址加入到待抓取队列,并将数据保存到存储器中。

5. 这个流程不断循环,直到满足停止条件(如达到抓取深度或数量限制)。

### 2.2.2 数据解析和提取方法

数据解析和提取是爬虫技术的核心部分之一,常见的方法包括:

- **使用正则表达式**:适用于简单的文本提取任务。

- **HTML/XML解析器**:如BeautifulSoup(Python)和lxml(Python)可以解析HTML/XML文档,并以树状结构进行数据提取。

- **Xpath查询**:Xpath表达式能够精确定位HTML文档中的数据节点。

- **CSS选择器**:通过CSS选择器快速定位并提取网页中的元素。

示例代码使用Python的requests库和BeautifulSoup库抓取网页并提取标题:

```python

import requests

from bs4 import BeautifulSoup

# 发起请求获取网页内容

response = requests.get('http://example.com')

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页标题

title = soup.find('title').get_text()

print(title)

```

### 2.2.3 数据存储和管理机制

爬虫抓取的数据需要存储和管理,常见的数据存储方法有:

- **文本文件**:如CSV,简单易用,适用于数据量小的情况。

- **关系型数据库**:如MySQL、PostgreSQL等,适用于结构化数据的存储。

- **NoSQL数据库**:如MongoDB,适用于存储大量非结构化或半结构化数据。

- **分布式存储系统**:如Hadoop、Elasticsearch等,适用于大数据场景。

数据管理机制包括数据清洗、去重、格式化等

0

0