【Python爬虫秘籍】:零基础到专家的5大实战技巧

发布时间: 2024-12-25 19:57:15 阅读量: 6 订阅数: 7

Python爬虫高级开发工程师5期-视频教程网盘链接提取码下载.txt

# 摘要

Python爬虫是一种自动化抓取互联网数据的程序,随着大数据的兴起,其重要性日益凸显。本文首先介绍Python爬虫的基础知识和选择合适框架的方法,包括Scrapy、BeautifulSoup和Requests库的使用。接着,探讨了应对网站反爬虫机制的技巧,如伪装技术和数据提取存储方法。文章还涵盖了数据抓取的技巧、实时处理技术,以及爬虫项目的部署、监控和维护。最后,探讨了爬虫的合规性和道德问题,以及机器学习技术在提升爬虫智能方面的应用,并展望了爬虫技术的未来趋势,包括深度学习和大数据技术的整合。本论文为从事数据抓取与处理的专业人士和学者提供了详尽的理论和实践指导。

# 关键字

Python爬虫;框架选择;反反爬虫;数据处理;项目部署;机器学习;合规性考量

参考资源链接:[八爪鱼云采集:零基础轻松爬取网页数据](https://wenku.csdn.net/doc/53yofpk11q?spm=1055.2635.3001.10343)

# 1. Python爬虫基础入门

## 1.1 什么是Python爬虫?

在互联网信息爆炸的时代,Python爬虫扮演着信息采集员的角色。它是一种自动化抓取网络数据的程序或脚本,能够将大量的网页数据收集到本地,便于后续的数据分析和处理。Python爬虫因其简洁易学和强大的库支持,在数据采集领域广受欢迎。

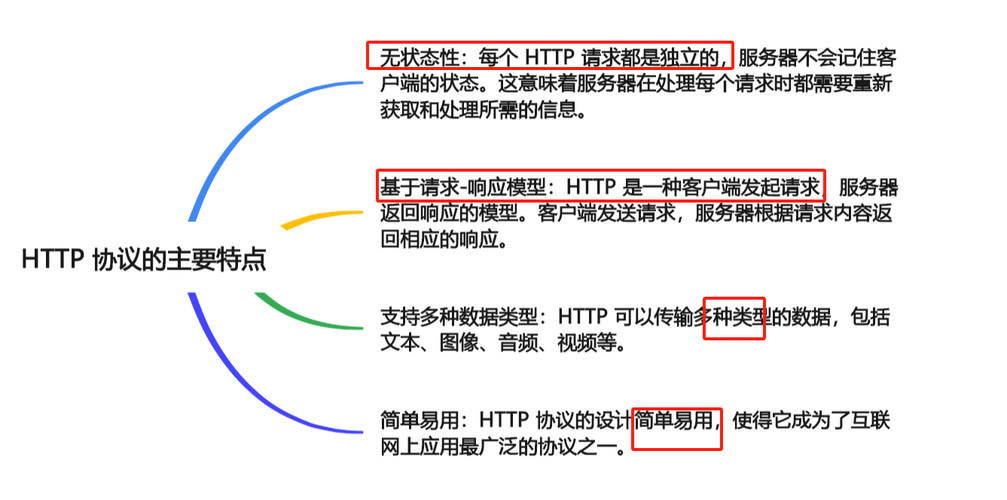

## 1.2 爬虫的基本工作原理

爬虫的工作原理相对简单。首先,它向服务器发送HTTP请求,请求目标网页。服务器收到请求后返回响应,爬虫解析响应的内容,提取出所需的数据。最后,爬虫将这些数据存储起来,供后续使用。这一过程涉及到了网络请求、HTML解析和数据存储等技术点。

## 1.3 入门准备

对于初学者来说,入门Python爬虫需要以下几个步骤:

- 学习Python基础语法。

- 熟悉网络请求库,如`requests`。

- 掌握HTML解析工具,如`BeautifulSoup`。

- 学习数据存储方式,如写入文件或使用数据库。

通过这些准备,你将能够编写简单的爬虫程序,收集并处理网页数据。而本章将带领你从零开始,逐步了解爬虫的工作机制,并实现一个基本的爬虫脚本。

接下来的内容将会详细介绍如何选择合适的Python爬虫框架,并通过实战案例加深理解。

# 2. 选择合适的Python爬虫框架

## 2.1 常见Python爬虫框架概览

### 2.1.1 Scrapy框架简介

Scrapy是一个快速、高层次的屏幕抓取和网络爬取框架,用于抓取网站并从页面中提取结构化的数据。它被广泛用于数据挖掘、信息处理或历史记录存档等场景。Scrapy是用Python编写的,它遵循Twisted异步网络框架,能够处理大量数据。

Scrapy包含了一组完整的工具,用于从网页中抓取数据、处理数据和存储数据。此外,Scrapy还支持扩展插件系统,这使得它具有良好的扩展性和可用性。Scrapy的架构如图1所示,它包括了调度器(Scheduler),下载器(Downloader),中间件(Middleware),以及爬虫(Spider)等核心组件。

Scrapy使用的是命令式编程范式,结合其选择器(Selector),可以方便地通过XPath或CSS选择器来提取数据。Scrapy的项目设置和数据处理都基于Item的概念,使得数据抓取过程变得模块化。

### 2.1.2 BeautifulSoup库使用

BeautifulSoup是一个Python库,用来解析HTML和XML文档,它提供了简单的方法和函数来提取和导航解析树。使用BeautifulSoup,可以轻松地遍历、搜索和修改解析树,这对于从HTML文件中提取信息非常有用。

一个典型的BeautifulSoup使用场景包括以下几个步骤:

1. 解析HTML文档,创建一个BeautifulSoup对象。

2. 使用select或find方法来定位元素。

3. 访问元素的内容或属性。

下面是一个简单的示例代码,展示如何使用BeautifulSoup来提取网页中的所有链接:

```python

from bs4 import BeautifulSoup

import requests

# 发送HTTP请求获取网页

response = requests.get('http://example.com')

# 使用BeautifulSoup解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 提取所有a标签并获取href属性

for link in soup.find_all('a'):

print(link.get('href'))

```

在这段代码中,我们首先导入了`requests`和`BeautifulSoup`库,然后发起一个HTTP GET请求来获取示例网页。之后,我们创建了一个BeautifulSoup对象`soup`,它将HTML内容解析为一个可操作的树状结构。使用`find_all`方法,我们遍历了所有的`<a>`标签并打印出它们的`href`属性。

### 2.1.3 Requests库的网络请求处理

Requests是一个非常简洁、易于使用的HTTP库,它是用于发送网络请求的Python库,它在底层使用了urllib3,但在功能上进行了优化以提供更简单的方法和参数。Requests库让Python发送HTTP/1.1请求变得异常简单。

Requests库允许你发送各种HTTP请求,包括GET、POST、PUT、DELETE等,并且可以方便地添加HTTP头部、表单数据、多部分文件上传以及请求和响应的各种编码处理。

以下是一个使用Requests发送GET请求并解析响应的基本示例:

```python

import requests

# 发送GET请求

response = requests.get('http://example.com')

# 输出响应状态码

print(response.status_code)

# 打印网页内容

print(response.text)

# 获取JSON响应内容

json_response = response.json()

print(json_response)

```

在这个例子中,我们首先导入了`requests`模块,然后使用`get`方法向指定URL发送请求。`response`对象包含了服务器的响应内容。使用`status_code`属性可以查看HTTP响应的状态码。`response.text`属性包含了响应的文本内容,如果服务器返回的是JSON格式的数据,我们可以直接使用`response.json()`方法将文本内容解析为Python字典。

## 2.2 框架对比和选择依据

### 2.2.1 框架性能对比

在选择Python爬虫框架时,性能是需要考虑的一个重要方面。框架的性能主要体现在数据抓取的速度、对异常的处理能力、资源占用以及是否支持异步IO等方面。

- **数据抓取速度**:通常与框架内部实现的网络请求库以及并发处理能力有关。例如,Scrapy自带异步下载器,可以有效提高抓取速度。

- **异常处理**:一个良好的爬虫框架应当能妥善处理网络请求中可能出现的各种异常情况,如连接超时、DNS解析失败等。

- **资源占用**:不同的框架对内存和CPU资源的使用不同。轻量级框架,如Requests,更适合资源受限的环境。

- **异步IO支持**:异步IO可以提升爬虫的吞吐量,提高资源利用效率。Scrapy框架通过twisted库实现异步IO,而Requests本身不支持异步IO。

### 2.2.2 适用场景分析

不同的爬虫框架适用于不同的爬取场景,选择合适的框架可以事半功倍。

- **Scrapy**:适合于大规模数据抓取项目,尤其是需要构建复杂的爬虫逻辑,具有中间件、管道和选择器等高级特性时。

- **BeautifulSoup**:适用于简单或中等规模的HTML页面解析任务,尤其在数据提取方面简单直观。

- **Requests**:适用于简单的HTTP请求任务,经常用于编写测试脚本或者作为其他爬虫库的辅助工具。

### 2.2.3 社区和文档的重要性

一个活跃的社区和详尽的文档对于学习和解决问题至关重要。对于初学者和专业开发人员来说,一个具有丰富文档和良好社区支持的框架能够显著减少学习成本和开发时间。

- **文档**:Scrapy和Requests拥有详尽的官方文档,包括安装指南、教程、API文档以及常见问题解答。

- **社区**:由于Scrapy和Requests库的广泛使用,网络上存在大量的使用教程、代码示例以及问题解决方案。

## 2.3 实战:框架基础应用案例

### 2.3.1 Scrapy框架的第一个爬虫

下面是一个简单的Scrapy爬虫实现,用于抓取quotes.toscrape.com网站上的所有名言,并保存到本地。

```python

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.xpath('span/small/text()').get(),

'tags': quote.css('div.tags a.tag::text').getall(),

}

next_page = response.css('li.next a::attr(href)').get()

if next_page is not None:

yield response.follow(next_page, self.parse)

```

这个爬虫定义了一个`QuotesSpider`类,继承自`scrapy.Spider`。在`start_urls`中设置了爬虫开始的URL地址。`parse`方法用于解析响应,这里使用了CSS选择器和XPath来提取名言、作者和标签信息。通过`response.follow`函数,我们实现了对下一页链接的递归爬取。

### 2.3.2 BeautifulSoup和Requests组合实践

接下来,我们将使用Requests库获取网页内容,并用BeautifulSoup进行解析。

```python

import requests

from bs4 import BeautifulSoup

# 使用Requests获取网页

response = requests.get('http://quotes.toscrape.com/')

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页中的名言、作者和标签

quotes = []

for quote in soup.select('div.quote'):

text = quote.find('span', class_='text').get_text()

author = quote.find('span', class_='author').get_text()

tags = [tag.get_text() for tag in quote.find_all('a', class_='tag')]

quotes.append({'text': text, 'author': author, 'tags': tags})

# 打印结果

for quote in quotes:

print(quote)

```

在这段代码中,我们首先使用`requests.get`获取指定网页的内容。然后创建了一个BeautifulSoup对象`soup`来解析这个内容。接着,我们使用CSS选择器找到页面中所有的`<div class="quote">`元素,并提取了每个名言的文本、作者以及标签,并将它们保存到列表`quotes`中。最后,我们遍历`quotes`列表,打印出每个提取到的名言。

这两节内容介绍了Python中最常用的几种爬虫框架和工具,并通过实际的代码示例,演示了如何快速上手使用这些工具。在下一节中,我们将探索一些高级的爬虫技巧,例如如何应对反爬虫机制和进行数据提取与存储。

# 3. 爬虫的反反爬虫技巧

在互联网数据采集的博弈中,网站管理员为了防止数据被无限制地抓取,会实施各种反爬虫机制。因此,了解和掌握应对反爬虫的策略对于爬虫开发者而言至关重要。本章节将深入探讨反反爬虫技术,帮助开发者在维护数据抓取项目时,能够更加游刃有余。

## 3.1 反爬虫机制概述

### 3.1.1 常见的反爬虫策略

网站实施反爬虫策略,主要目的是为了区分用户和爬虫程序,限制爬虫程序对网站的访问频率,从而保护网站数据不被过度抓取。常见的反爬虫策略包括但不限于以下几点:

- **检查用户代理(User-Agent)**:网站会检查访问者的User-Agent,与常见的爬虫程序的User-Agent进行比对。

- **IP限制**:基于IP的访问频率限制,超过设定的阈值将暂时或永久阻止访问。

- **动态网页**:使用JavaScript动态加载内容,传统的爬虫可能无法解析。

- **登录验证**:有些网站要求用户登录后才可访问特定内容,增加了爬虫获取数据的难度。

- **验证码**:某些网站会要求输入验证码来区分用户和爬虫。

- **行为分析**:通过分析用户行为模式来检测爬虫。

### 3.1.2 反爬虫机制的应对思路

针对上述反爬虫策略,爬虫开发者可以采取以下思路进行应对:

- **使用代理池**:频繁更换代理IP可以有效地绕过IP限制。

- **设置合理的请求间隔**:通过随机请求间隔模拟人类用户行为。

- **模拟浏览器环境**:使用Selenium或者设置请求头部信息,如Referer等,以模拟真实用户的访问。

- **处理动态网页**:使用Selenium、Pyppeteer或浏览器自动化工具来处理JavaScript渲染的网页。

- **验证码识别**:集成OCR技术或者使用第三方验证码识别服务来自动化解决验证码问题。

- **增加行为模拟**:模拟鼠标和键盘操作,尽量模拟真实用户的行为。

## 3.2 高级伪装技术实战

### 3.2.1 使用代理IP绕过IP封锁

使用代理IP是绕过IP封锁的有效手段之一。代理服务器可以帮助我们隐藏真实的IP地址,从而进行更加隐蔽的数据抓取。代码示例:

```python

import requests

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.10:1080',

}

response = requests.get('http://httpbin.org/ip', proxies=proxies)

print(response.text)

```

### 3.2.2 模拟浏览器环境

使用headers模拟浏览器环境是另一种常见的伪装技术。以requests库为例,我们可以通过设置请求头中的User-Agent字段来伪装成浏览器。

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.132 Safari/537.36'

}

response = requests.get('http://httpbin.org/user-agent', headers=headers)

print(response.text)

```

### 3.2.3 Cookie和Session的管理

网站常通过设置Cookie来追踪用户,为防止被追踪,爬虫需要对Cookie进行管理和维护。使用requests库时,可以通过`requests.Session()`对象来维持会话状态。

```python

session = requests.Session()

session.get('http://httpbin.org/cookies/set/sessioncookie/123456789')

response = session.get('http://httpbin.org/cookies')

print(response.text)

```

## 3.3 数据提取与存储

### 3.3.1 数据清洗和转换

在数据提取后,我们通常需要进行清洗和转换,以适应后续的存储和分析需求。这一过程可能包括去除无用字符、格式转换、数据类型统一等。

```python

import re

from bs4 import BeautifulSoup

html = '<div>Temperature: 30°C</div>'

soup = BeautifulSoup(html, 'html.parser')

# 使用正则表达式清洗温度值

temperature = re.search(r'(\d+)', soup.text).group(0)

temperature = int(temperature)

print(temperature)

```

### 3.3.2 数据存储方案选择

数据提取后需要选择合适的存储方案。常见的方式包括关系型数据库如MySQL、PostgreSQL,非关系型数据库如MongoDB,以及简单的文本文件或CSV等。

```python

import csv

# 写入CSV文件

with open('data.csv', 'w', newline='', encoding='utf-8') as csvfile:

fieldnames = ['temperature']

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer.writeheader()

writer.writerow({'temperature': temperature})

```

本章内容至此涵盖了反爬虫机制的基本概念、伪装技术的实战应用,以及数据提取与存储的策略。通过本章节的学习,爬虫开发者应能够具备应对基本反爬虫策略的能力,并能够有效地进行数据的提取和存储。在下一章中,我们将进一步探讨如何部署和维护爬虫项目,确保其长期稳定运行。

# 4. 数据抓取与处理

## 4.1 数据抓取技巧和最佳实践

### 4.1.1 多线程与异步IO的数据抓取

在进行大规模数据抓取时,我们常常会遇到网络延迟和I/O阻塞的问题。使用多线程和异步IO可以显著提升爬虫的抓取效率。Python提供了`threading`和`asyncio`模块来分别实现多线程和异步IO编程。

**多线程数据抓取:**

Python的多线程主要是通过`threading`模块来实现,它可以让程序并发运行多个线程,从而利用多核CPU的优势。需要注意的是,对于I/O密集型任务,多线程可以发挥效果,但是由于GIL(全局解释器锁)的存在,在CPU密集型任务上多线程的优势并不明显。

示例代码:

```python

import threading

import requests

def fetch_url(url):

response = requests.get(url)

print(response.text)

def main():

urls = ['http://example.com/page1', 'http://example.com/page2', ...]

threads = []

for url in urls:

thread = threading.Thread(target=fetch_url, args=(url,))

threads.append(thread)

thread.start()

for thread in threads:

thread.join()

if __name__ == '__main__':

main()

```

在这个例子中,我们创建了多个线程,每个线程负责获取一个页面的内容。通过`start`方法启动线程,然后等待所有线程完成,使用`join`方法。

**异步IO数据抓取:**

异步IO允许在等待I/O操作完成期间执行其他任务。在Python中,`asyncio`模块提供了异步编程的支持。结合`aiohttp`库,我们可以实现异步的数据抓取。

示例代码:

```python

import asyncio

import aiohttp

async def fetch_url(session, url):

async with session.get(url) as response:

return await response.text()

async def main():

urls = ['http://example.com/page1', 'http://example.com/page2', ...]

async with aiohttp.ClientSession() as session:

tasks = [fetch_url(session, url) for url in urls]

responses = await asyncio.gather(*tasks)

# 处理响应内容

for response in responses:

print(response)

if __name__ == '__main__':

asyncio.run(main())

```

在这个异步的例子中,我们首先创建了一个`ClientSession`,然后为每个URL创建了一个异步任务。使用`asyncio.gather`可以并行执行这些任务,并且在所有任务完成后继续执行。`asyncio.run(main())`用于运行主函数。

### 4.1.2 分布式爬虫设计

当数据抓取需求上升到一个较高水平时,单机性能往往成为瓶颈。分布式爬虫架构可以将任务分配到多个节点,提高数据抓取的效率和稳定性的可扩展性。

**分布式爬虫的关键组件:**

- **爬虫节点(Worker)**:负责实际的数据抓取工作,可以是多线程或异步IO。

- **任务队列(Queue)**:存储待抓取的URL,保证爬虫节点可以高效地获取任务。

- **调度器(Scheduler)**:管理任务队列,分配任务给爬虫节点。

- **数据库(Storage)**:存储抓取的数据和元数据。

**分布式爬虫的设计要点:**

1. **任务调度**:需要一个高效的任务调度系统,例如使用Redis作为消息队列。

2. **去重机制**:分布式环境下,任务去重非常关键,以避免重复抓取。

3. **动态IP池**:使用代理IP池,可以有效减少IP被封禁的风险。

4. **容错与恢复**:节点故障时,需要能够自动重新分配任务。

### 4.1.3 分布式爬虫实战案例

**搭建分布式爬虫的步骤:**

1. **环境准备**:配置多个爬虫节点环境。

2. **搭建消息队列**:使用Redis部署消息队列。

3. **编写调度器**:根据业务需求编写调度器逻辑,实现任务的分发。

4. **实施爬虫节点**:编写爬虫节点程序,实现数据的抓取。

5. **结果存储**:确定结果存储方案,如数据库或文件系统。

6. **监控与维护**:设置监控系统,对爬虫性能进行监控,并进行维护。

**实战代码示例:**

```python

import redis

import asyncio

import aiohttp

# 配置Redis连接

r = redis.Redis(host='localhost', port=6379, db=0)

# 分布式爬虫节点

async def fetch_url(session, url):

async with session.get(url) as response:

return await response.text()

async def worker():

while True:

# 从Redis队列中获取任务

url = r.brpop('queue:urls', 0) # 阻塞式等待

if url:

url = url[1].decode('utf-8')

# 这里调用异步的fetch_url函数

await fetch_url()

async def main():

await asyncio.gather(*[worker() for _ in range(5)]) # 创建5个worker

if __name__ == '__main__':

asyncio.run(main())

```

在这个案例中,我们创建了一个基于`asyncio`和`aiohttp`的异步分布式爬虫节点。同时使用Redis消息队列管理URL任务,并创建了多个爬虫节点实例来并行执行抓取任务。

## 4.2 数据预处理和分析

### 4.2.1 数据清洗与正则表达式

数据清洗是数据分析前的重要步骤,目的是将不完整、错误、格式不一致的数据转换为可分析的数据。在Python中,我们可以使用正则表达式来快速匹配和提取数据。

**示例代码:**

```python

import re

text = '''

Mr. John Smith 50 Main St., Panora, IA 50216

Ms. Mary Johnson 123 Maple Ave. #45, Amity, OR 97101

Mr. Mike Brown 89 Elm Street, Milwaukee, WI 53202

pattern = re.compile(r'(\w+)\s+(\w+)\s+(.*)\s+(\d+)\s+(.*)\s+([A-Z]{2})\s+(\d+)')

for match in pattern.finditer(text):

print(match.groups())

```

**参数说明:**

- `pattern`: 定义正则表达式模式。

- `finditer`: 指定在文本中查找与模式匹配的所有实例。

### 4.2.2 数据预处理工具Pandas使用

Pandas是一个强大的Python数据分析工具库,它提供了大量的数据处理功能。使用Pandas进行数据清洗和预处理是Python数据处理的标准做法。

**示例代码:**

```python

import pandas as pd

# 创建一个简单的DataFrame

data = {

'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Location': ['New York', 'Paris', 'Berlin', 'London'],

'Age': [24, 13, 53, 33]

}

df = pd.DataFrame(data)

# 数据清洗

df.dropna(inplace=True) # 删除空值

df['Age'] = df['Age'].apply(lambda x: x + 1) # 年龄加1

# 输出结果

print(df)

```

**参数说明:**

- `dropna`: 删除包含空值的行。

- `apply`: 应用函数到某一列。

- `inplace`: 在原地修改DataFrame,而不是返回一个新副本。

### 4.2.3 数据分析与可视化基础

数据可视化可以直观地展示数据,帮助我们更轻松地理解数据。Pandas与Matplotlib、Seaborn等库可以很好地集成,让我们能够将数据进行可视化展示。

**示例代码:**

```python

import matplotlib.pyplot as plt

# 继续使用上一个代码中的df

df.plot(kind='bar', x='Name', y='Age') # 用条形图展示每个人的年龄

plt.show()

```

**参数说明:**

- `kind`: 指定图表类型,如'bar'、'line'、'scatter'等。

- `x`和`y`: 指定图表的x轴和y轴数据。

## 4.3 数据的实时处理

### 4.3.1 实时数据流的抓取

随着数据量的增大,实时处理越来越重要。实时数据流抓取可以帮助我们快速响应最新的数据变化,例如,通过监听API或使用WebSocket来获取实时信息。

**实时数据流抓取的示例:**

```python

import websockets

async def listen_to_data_stream():

uri = 'wss://example.com/stream' # WebSocket服务器地址

async with websockets.connect(uri) as websocket:

async for message in websocket:

# 处理接收到的消息

print(message)

# 运行WebSocket客户端

asyncio.get_event_loop().run_until_complete(listen_to_data_stream())

```

**参数说明:**

- `uri`: WebSocket服务器地址。

- `websocket`: 使用`websockets`库连接到WebSocket服务器。

- `async for`: 异步循环接收消息。

### 4.3.2 实时数据处理技术栈

实时数据处理需要一套成熟的技术栈来支持。常用的组件包括消息队列、流处理系统、数据存储等。

**技术组件:**

- **消息队列**:如Kafka,用于接收和分发数据流。

- **流处理系统**:如Apache Flink或Apache Storm,用于实时处理和分析数据流。

- **数据存储**:如Cassandra或Elasticsearch,用于存储和索引实时数据。

通过结合这些组件,我们可以构建一个实时数据处理的流水线,从数据获取到处理再到存储和分析,形成一个完整的实时数据处理系统。

# 5. 爬虫项目的部署与维护

随着爬虫项目的开发完成,下一步是将爬虫部署到服务器上,以实现其预定的抓取目标。部署爬虫项目不仅仅是一个技术过程,还是一个需要考虑到日志监控、定期更新和法律法规遵循的持续性活动。

## 5.1 爬虫部署策略

部署爬虫项目是一项需要精心计划的任务,其目的是保证爬虫能够稳定运行,并且能够处理可能遇到的各类问题。

### 5.1.1 云服务器部署流程

云服务为爬虫提供了强大的计算能力和弹性资源,使得部署过程更加灵活和高效。下面是一个部署流程的简要概述:

1. **资源准备:**选择一个合适的云服务提供商,如AWS、阿里云或腾讯云等,并根据项目需求选择合适的计算资源,例如虚拟机、容器服务或无服务器计算平台。

2. **配置环境:**安装操作系统(如Linux),配置必要的软件环境,安装Python解释器、爬虫框架和相关库。

3. **安全设置:**设置安全组规则,仅开放必要的端口,比如HTTP/HTTPS的80和443端口;配置SSH密钥认证,禁用root账户的密码登录。

4. **部署爬虫:**将爬虫代码上传到服务器,使用虚拟环境进行依赖管理,安装项目依赖库,执行爬虫脚本。

5. **监控与日志:**部署监控工具和服务,以便于实时监控爬虫状态和收集日志信息,对可能出现的问题进行及时响应。

6. **备份与恢复:**定期备份爬虫配置文件和关键数据,设计快速恢复方案,以防服务中断。

7. **自动化部署:**通过脚本或使用云平台提供的服务,自动化部署流程,提高部署效率和减少人为错误。

### 代码示例:自动化部署脚本

假设您使用的是AWS的EC2服务,并通过Ansible进行自动化部署,以下是部分基础的Ansible脚本代码示例。

```yaml

- name: Deploy Python Crawler to EC2

hosts: my_server_group

become: yes

tasks:

- name: Update system packages

apt:

update_cache: yes

cache_valid_time: 3600

- name: Install Python3

apt:

name: python3

state: present

- name: Install pip

apt:

name: python3-pip

state: present

- name: Install virtualenv

pip:

name: virtualenv

- name: Create Virtual Environment

command: virtualenv --python=python3 /home/ubuntu/crawler_env

- name: Install dependencies

pip:

requirements: "/path/to/requirements.txt"

virtualenv: "/home/ubuntu/crawler_env"

- name: Copy Crawler Script

copy:

src: "/path/to/crawler.py"

dest: "/home/ubuntu/crawler.py"

- name: Start Crawler

command: "/home/ubuntu/crawler_env/bin/python /home/ubuntu/crawler.py"

```

在该脚本中,我们执行了一系列任务:系统更新、Python安装、pip安装、创建虚拟环境、安装依赖、复制爬虫脚本、启动爬虫等。

## 5.2 爬虫监控与日志分析

爬虫的监控与日志分析是确保爬虫稳定运行的关键环节,它涉及到数据收集、分析以及异常处理。

### 5.2.1 爬虫状态监控系统

部署监控系统能够实时跟踪爬虫的状态,包括任务进度、运行时间、错误率、资源使用等指标。常见的监控工具有:

- **Prometheus + Grafana:**Prometheus用于收集和存储监控数据,Grafana提供可视化界面。

- **Zabbix:**支持告警通知、可视化、数据存储等。

- **Scrapy Monitor:**专门针对Scrapy爬虫的监控工具。

### 5.2.2 日志分析工具和技巧

日志是爬虫运行状态的重要记录,通过对日志的分析,可以发现爬虫的性能瓶颈、错误原因等。常见的日志分析工具有:

- **ELK Stack(Elasticsearch, Logstash, Kibana):**强大的日志收集、处理和可视化工具。

- **Fluentd:**支持多种数据源和数据输出,易于扩展。

- **Logspout:**用于容器化环境的日志收集。

### 表格:日志分析工具对比

| 工具名称 | 功能特点 | 适用场景 |

|--------------|------------------------------|-----------------------------------|

| ELK Stack | 强大的日志分析与可视化能力 | 大型分布式系统日志分析与管理 |

| Fluentd | 高性能数据收集器 | 适用于容器化环境和多数据源集成 |

| Logspout | 集中收集容器日志 | 集中化管理Docker容器日志 |

## 5.3 爬虫的长期维护

爬虫项目开发完成后,还需要定期进行更新和维护,以应对目标网站的反爬虫策略变化和法律法规的更新。

### 5.3.1 定期更新和维护爬虫策略

爬虫项目的维护工作包括:

- **策略更新:**不断优化爬虫策略,以提高抓取效率和稳定性。

- **反反爬虫:**跟进目标网站的反爬虫机制更新,如更换IP、更新User-Agent等。

- **异常处理:**监控爬虫运行情况,对异常情况进行快速定位和处理。

### 5.3.2 法律法规遵循与伦理问题

爬虫开发者在进行爬取操作时,必须遵守相关的法律法规和网站的爬虫协议。以下是维护过程中的法律和伦理考量:

- **遵守robots.txt:**尊重目标网站的爬虫协议,避免抓取禁止爬取的内容。

- **数据隐私保护:**不抓取和存储个人隐私信息,如个人身份证号、电话号码等。

- **合理使用:**确保数据抓取用途合法且不违反道德伦理,例如不用于发送垃圾邮件。

### 案例分析:合规性更新策略

当网站更新了反爬虫措施后,爬虫可能无法继续正常工作,此时需要更新爬虫策略,以下是一个示例性的应对策略更新流程:

1. **日志分析:**通过日志分析,识别爬虫遇到的问题,如被封IP、用户代理被拦截等。

2. **代码调整:**根据分析结果,修改爬虫代码。如果是IP被封,则更换代理IP池;如果是被User-Agent拦截,则更新请求头中的User-Agent。

3. **测试验证:**在开发环境中测试修改后的爬虫,确保其能够正常运行。

4. **正式部署:**在确认爬虫工作正常后,将更新后的爬虫部署到生产环境。

5. **监控增强:**增强监控强度,密切关注爬虫的运行状态,确保爬虫稳定运行。

通过以上措施,爬虫项目可以在长期运行中维持其有效性,并降低违法风险。

至此,第五章的内容结束了。从部署策略到监控与维护,本章深入探讨了爬虫项目从上线到持续运行所需的各个关键环节。爬虫项目的部署和维护是一个动态且持续的过程,需要开发者持续关注和精心管理。

# 6. Python爬虫高级话题

## 6.1 爬虫的合规性与道德考量

在当今的信息时代,爬虫技术的应用日益广泛,然而随之而来的是合规性与道德的问题。企业在开发和使用爬虫时,必须考虑到数据隐私权的保护。

### 6.1.1 爬虫与数据隐私权

当爬虫抓取的数据涉及个人信息时,就不可避免地触碰到数据隐私权这一敏感领域。在多数国家和地区,个人信息的保护法律非常严格,企业必须要遵守相关的法律法规。

**操作指南:**

1. **识别个人信息**:对目标网站内容进行分析,识别个人信息。

2. **避免抓取**:对于明确含有个人信息的部分,应设计爬虫逻辑避免抓取。

3. **数据脱敏**:即使在抓取公开数据时,如果数据中含有可能的个人信息,也应进行脱敏处理。

```python

# 示例:简单的数据脱敏函数,将个人敏感信息替换为占位符

def desensitize_data(text):

desensitized_text = text

desensitized_text = desensitized_text.replace('姓名', '***')

desensitized_text = desensitized_text.replace('手机号', '****')

return desensitized_text

```

### 6.1.2 合规性框架和最佳实践

为确保爬虫开发的合规性,企业可以建立一套专门的合规性框架,并遵循最佳实践。

**最佳实践:**

- **合法授权**:确保爬虫抓取的数据来源是经过合法授权的。

- **透明性**:对被爬取数据的来源、使用目的等信息对外公开。

- **定期审查**:定期对爬虫项目进行合规性审查和风险评估。

## 6.2 机器学习在爬虫中的应用

随着人工智能技术的不断进步,机器学习也开始在爬虫技术中发挥作用,这不仅提高了爬虫效率,还能智能化应对复杂的反爬虫策略。

### 6.2.1 机器学习提升爬虫智能

机器学习算法可以帮助爬虫更好地理解目标网页的结构,提高数据提取的准确率,还能识别和处理各种反爬虫机制。

**技术应用:**

- **模式识别**:使用机器学习对网页内容进行分类识别。

- **异常检测**:通过分析流量模式,机器学习可帮助识别和应对异常检测机制。

- **决策制定**:基于学习到的网站行为模式,爬虫可动态调整抓取策略。

```python

# 示例:简单的人工神经网络,用于网页内容分类

from sklearn.neural_network import MLPClassifier

from sklearn.feature_extraction.text import CountVectorizer

# 假设已有一组预处理过的网页文本数据

texts = [...] # 网页文本列表

labels = [...] # 文本对应的分类标签

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(texts)

mlp = MLPClassifier(hidden_layer_sizes=(100,), max_iter=500)

mlp.fit(X, labels)

```

### 6.2.2 实际案例分析:使用ML优化爬虫

通过机器学习优化爬虫的一个实际案例是,使用机器学习算法对网页进行分类,然后根据分类结果自动调整爬虫的抓取策略。

**案例步骤:**

1. **数据收集**:收集目标网站的数据,并对其标注分类。

2. **模型训练**:使用标注好的数据集训练机器学习模型。

3. **模型集成**:将训练好的模型集成到爬虫中,实时指导爬虫的抓取行为。

## 6.3 爬虫技术的未来趋势

随着技术的不断发展,爬虫技术也在持续进化,以适应新的挑战和机遇。

### 6.3.1 深度学习与自然语言处理

深度学习和自然语言处理(NLP)技术的进步,使得爬虫能够更好地理解网页内容和用户意图。

**技术展望:**

- **语义理解**:深度学习可以帮助爬虫理解网页中的语义信息。

- **结构化提取**:通过NLP技术,可以更精确地从非结构化数据中提取结构化信息。

### 6.3.2 分布式爬虫与大数据技术的融合

随着大数据技术的成熟,分布式爬虫架构将更多地应用于大规模数据抓取任务中。

**架构优势:**

- **可扩展性**:分布式爬虫架构支持在多台机器上扩展,有效提升爬取性能。

- **容错能力**:通过合理的分布式架构设计,可以提高爬虫系统的稳定性和容错能力。

在这个日新月异的领域里,爬虫技术的每一次进步都预示着数据获取方式的革新,使得我们能够更智能、高效、合规地从互联网的海量数据中提取价值。

0

0