Python爬虫数据可视化:从入门到精通(零基础到专家级教程)

发布时间: 2024-07-20 16:44:58 阅读量: 53 订阅数: 23

Python爬虫教程+数据可视化

# 1. Python爬虫入门

Python爬虫是一种强大的工具,用于从网络上提取数据。它广泛应用于各种领域,例如数据分析、数据挖掘和网络安全。本节将介绍Python爬虫的基本概念,并指导您构建自己的第一个爬虫。

### 1.1 爬虫的工作原理

爬虫通过模拟浏览器行为来从网站获取数据。它向网站发送请求,接收响应,然后解析响应以提取所需的信息。常见的爬虫类型包括:

- **广度优先爬虫:**从一个种子URL开始,并逐层抓取所有可访问的URL。

- **深度优先爬虫:**从一个种子URL开始,并深入抓取每个URL,直到达到预定义的深度。

- **目标导向爬虫:**专注于抓取与特定目标相关的URL,例如特定产品或文章。

# 2. Python爬虫实战技巧

### 2.1 爬虫工具与库的选择

#### 2.1.1 常用爬虫库的对比和选择

**| 库 | 特点 | 适用场景 |

|---|---|---|

| BeautifulSoup | HTML/XML解析 | 网页结构化数据提取 |

| Requests | HTTP请求 | 发送HTTP请求获取响应 |

| Scrapy | 爬虫框架 | 复杂爬虫项目管理 |

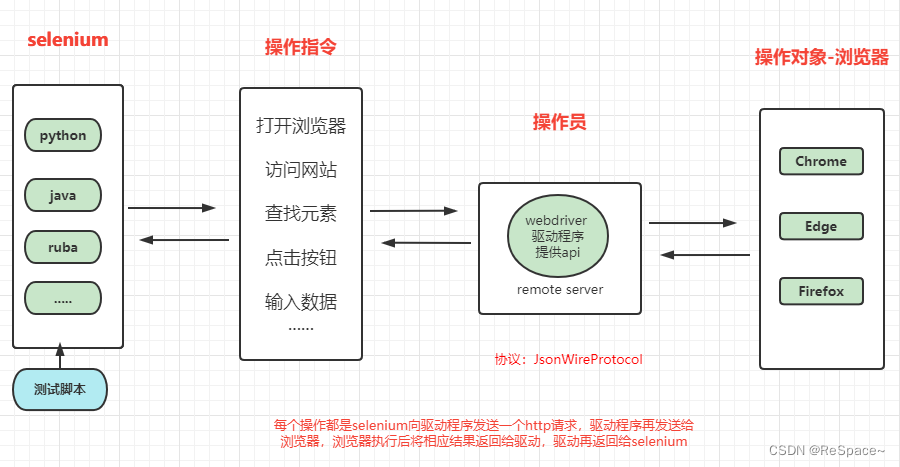

| Selenium | 浏览器自动化 | 模拟浏览器行为进行交互式爬取 |

| lxml | XML解析 | 处理复杂XML结构数据 |

**选择依据:**

* **爬取目标:**网页结构化数据、HTTP请求、复杂爬虫项目、交互式爬取

* **爬取难度:**简单、中等、复杂

* **开发效率:**快速开发、定制化开发

* **维护成本:**低、中、高

#### 2.1.2 爬虫框架的介绍和应用

**Scrapy**是一个功能强大的爬虫框架,提供以下优势:

* **并发爬取:**同时处理多个请求,提高爬取效率

* **管道机制:**数据清洗、存储等操作通过管道进行处理,提高代码可维护性

* **调度器:**管理爬取队列,控制爬取顺序和频率

* **中间件:**自定义请求和响应处理,增强爬虫功能

**应用场景:**

* 复杂爬虫项目,如电商网站、新闻网站

* 需要并发爬取和数据清洗的场景

* 需定制化爬取策略和中间件的场景

**代码示例:**

```python

# 创建一个Scrapy爬虫

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

start_urls = ['https://example.com']

def parse(self, response):

# 解析网页,提取数据

pass

```

**逻辑分析:**

* 创建一个名为ExampleSpider的Scrapy爬虫,并指定其名称和起始URL

* parse方法用于解析网页并提取数据,可以根据需要自定义解析逻辑

### 2.2 爬虫策略与反反爬虫

#### 2.2.1 常见的爬虫策略

* **伪装UA:**模拟不同浏览器或设备的UA,避免被反爬虫机制识别

* **代理IP:**使用代理IP池,隐藏真实IP,绕过IP封禁

* **限速爬取:**控制爬取频率,避免触发反爬虫机制

* **分布式爬取:**将爬取任务分配到多台服务器,提高爬取效率和抗封禁能力

* **验证码破解:**使用OCR或机器学习技术破解验证码,绕过验证码验证

#### 2.2.2 反反爬虫机制和应对措施

**| 反反爬虫机制 | 应对措施 |

|---|---|

| IP封禁 | 使用代理IP池 |

| UA识别 | 伪装UA |

| 验证码验证 | 验证码破解 |

| 限速爬取 | 分布式爬取 |

| 蜜罐陷阱 | 识别并避开蜜罐陷阱 |

**代码示例:**

```python

# 使用Requests库伪装UA

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/108.0.0.0 Safari/537.36'

}

response = requests.get(

```

0

0