虚拟化技术新高度:NVIDIA Ampere架构带你一探究竟

发布时间: 2024-12-15 23:40:19 阅读量: 17 订阅数: 13

nvidia-ampere-architecture-whitepaper.pdf

参考资源链接:[NVIDIA Ampere架构白皮书:A100 Tensor Core GPU详解与优势](https://wenku.csdn.net/doc/1viyeruo73?spm=1055.2635.3001.10343)

# 1. NVIDIA Ampere架构概述

## 1.1 架构的起源与概念

NVIDIA Ampere架构是NVIDIA在2020年推出的GPU架构,相较于前代产品,Ampere代表了从Volta架构到新一代技术的重大飞跃。Ampere架构不仅为数据中心、科学计算、图形渲染和AI研究等领域提供了强大的性能,也标志着NVIDIA在GPU计算领域持续的创新与领导力。

## 1.2 核心组件与创新亮点

Ampere架构包含多项关键技术突破,其核心组件包括第三代Tensor Core和增强型SM(Streaming Multiprocessor)单元。这些组件共同促进了在并行计算能力和机器学习推理方面的显著性能提升。此外,Ampere架构还引入了更高效的缓存结构和更先进的制造工艺,从而在计算密度和能效方面均有所突破。

## 1.3 架构的适用范围

Ampere架构设计之初就考虑了广泛的计算需求,特别适合于深度学习、高性能计算(HPC)和专业图形渲染。它的可扩展性使其能够在单一GPU到数据中心级别的复杂计算环境中灵活应用,满足不同规模和需求的企业计算任务。

通过本章的介绍,我们已经对Ampere架构有了初步了解,并对其在现代计算中的重要性有了认识。接下来的章节将深入探讨虚拟化技术与Ampere架构的关系,以及Ampere在虚拟化领域中的具体应用。

# 2. 虚拟化技术与Ampere架构的关系

### 2.1 虚拟化技术基础

#### 虚拟化技术的定义和原理

虚拟化技术是一种实现资源隔离、复用和抽象化的方法,它通过软件模拟硬件资源,使得单个物理资源可以被分割成多个虚拟资源,同时运行多个操作系统和应用程序。它的核心原理在于在物理硬件和操作系统之间增加一层抽象层,即虚拟机监控器(Hypervisor),来管理虚拟资源的分配与回收。Hypervisor提供了一个平台,使得不同的虚拟机(VM)能够共享物理资源,而彼此之间保持独立。

#### 虚拟化技术的发展历程

虚拟化技术自20世纪60年代起就有其雏形,但直到21世纪初,随着x86服务器的普及和Hypervisor技术的成熟,才开始广泛应用于数据中心。起初,虚拟化技术主要用于服务器整合和数据中心管理,但随着时间的发展,它逐渐拓展到了云服务、桌面虚拟化、存储虚拟化等多个领域。在这一进程中,虚拟化技术经历了从全虚拟化、半虚拟化到硬件辅助虚拟化等多个阶段,每一步的演进都是对效率、性能和兼容性的优化。

### 2.2 Ampere架构的特点

#### Ampere架构的核心创新点

NVIDIA Ampere架构是该公司推出的最新一代GPU架构,旨在为AI、游戏、专业可视化等应用提供强大的性能和能效比。该架构的核心创新点包括第三代Tensor Core的引入,它专为AI和机器学习工作负载设计,能够提供前所未有的计算能力。此外,Ampere架构还引入了更高效的内存技术,改善了片上网络结构,以提供更高的带宽和更低的延迟。其创新还包括支持更高速度的NVLink技术,它增强了GPU之间的通信性能,为大规模并行处理任务提供了有力支持。

#### Ampere架构与前代产品的对比

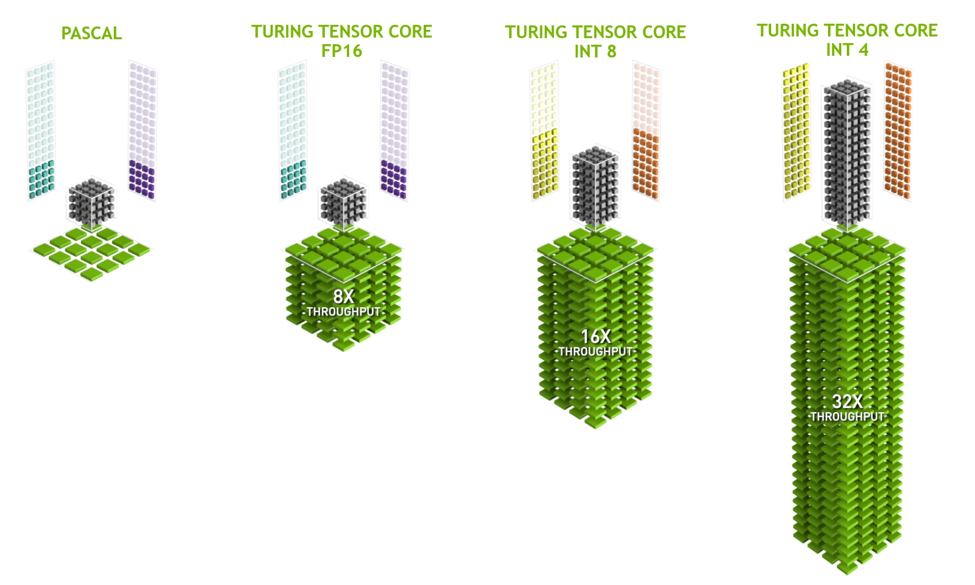

与前代的Turing架构相比,Ampere架构在许多关键性能指标上都有显著提升。Ampere架构的GPU拥有更多的CUDA核心和更高的内存带宽,能够处理更大规模的计算任务。第三代Tensor Core的出现,使得Ampere架构的AI计算性能显著增强。相比于Turing架构,Ampere架构在AI推理和训练上的性能提升多达20倍。此外,Ampere架构还增加了对PCIe Gen 4的支持,并通过新的电源管理功能进一步提高了能效比。

### 2.3 Ampere在虚拟化领域的应用

#### 云服务与数据中心

Ampere架构的GPU在云服务和数据中心领域中,扮演着日益重要的角色。随着云计算的普及,越来越多的租户需要高效、弹性的计算资源。通过在云环境中部署Ampere GPU,服务提供商能够提供强大的虚拟GPU实例给用户。这些实例支持包括深度学习训练和推理、图形渲染、视频转码等多种工作负载,极大地提升了数据中心的多用途性和服务效率。为了适应不同的工作负载,Ampere架构通过其软件定义硬件(SDx)能力,可以针对不同用户需求进行资源的优化配置。

#### AI与机器学习工作负载优化

在AI与机器学习领域,Ampere架构的GPU提供了强大的计算资源,使得复杂模型的训练和推理速度显著提升。这使得研究人员和开发人员可以更快地迭代模型,缩短开发周期,同时降低了实验成本。此外,Ampere架构GPU的高密度特性,使得它们可以在物理服务器上提供更多的虚拟机实例,这对于云服务提供商而言,意味着更高的资源利用率和更好的收益。

通过将虚拟化技术和Ampere架构结合,数据中心可以提供更加灵活和强大的计算服务,企业用户可以根据自身需求,弹性地调整计算资源的配置和使用。这不仅提升了资源利用率,也极大促进了企业IT架构的现代化和云计算的普及。

# 3. Ampere架构的虚拟化优势分析

## 3.1 性能优势分析

### 3.1.1 第三代Tensor Core的性能提升

NVIDIA Ampere架构的Tensor Core是该架构在深度学习和科学计算领域性能提升的关键。第三代Tensor Cores专为AI训练和推理工作负载进行了优化,每秒可进行千万亿次浮点运算(TFLOPs)。

Tensor Core支持自动混合精度计算(如FP32和FP16),大大提高了运算速度和能效。它还支持TF32和BF16两种新的数值格式,让AI工作负载即便在没有显著精度损失的情况下也能获得更快的处理速度。在此基础上,Ampere架构中的Tensor Core在处理速度和精度上都有了显著的提升,这对于需要大规模并行处理能力的AI应用来说,无疑是巨大的进步。

在具体应用中,Tensor Core可以与CUDA并行计算平台紧密配合,这使得开发者能够更轻松地移植和优化他们的深度学习模型。例如,在训练大型神经网络模型时,使用Tensor Core的Ampere架构显卡相较于前代产品可以实现超过两倍的性能提升。

### 3.1.2 新型内存架构的虚拟化性能影响

Ampere架构引入了新一代内存技术,比如第四代NVLink和PCIe Gen4,这些都显著提高了内存带宽和数据传输速度。新型内存架构使得在虚拟化环境中处理大规模数据集变得更加高效,特别是在那些需要极高数据吞吐量的应用场景。

NVLink将GPU和GPU、GPU和CPU之间通过高速互连进行连接,相比PCIe总线,它的数据传输速率提升极大。这使得在虚拟化环境中,多个虚拟机共享数据时,不会因为内存带宽的瓶颈而影响性能。举例来说,在云服务提供商搭建的大型虚拟化环境中,NVLINK可以在不同的物理服务器之间,或者服务器内部的多个虚拟机之间提供更快的数据共享和处理能力。

此外,Ampere架构的

0

0