多任务学习在边缘计算中的应用与潜力:赋能边缘,释放计算新可能

发布时间: 2024-08-22 13:12:43 阅读量: 45 订阅数: 22

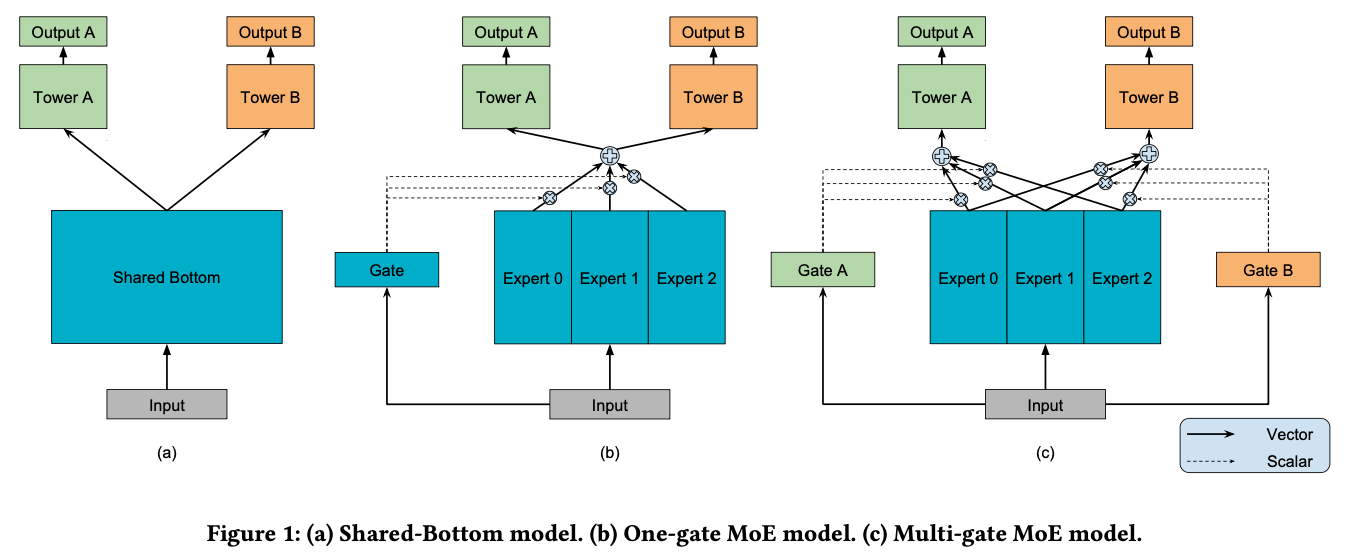

# 1. 多任务学习概述

多任务学习 (MTL) 是一种机器学习范式,它允许模型同时学习多个相关的任务。与传统单任务学习不同,MTL 通过利用任务之间的相关性来提高模型性能。在边缘计算中,MTL 具有巨大的潜力,因为它可以优化资源利用、降低延迟并增强鲁棒性。

# 2. 多任务学习在边缘计算中的优势

多任务学习在边缘计算中具有显著优势,使其成为提高边缘计算性能和效率的理想技术。以下列出了多任务学习在边缘计算中的三个主要优势:

### 2.1 提高资源利用率

边缘计算设备通常具有资源受限的特性,包括有限的计算能力、存储空间和网络带宽。多任务学习通过同时执行多个任务,提高了这些资源的利用率。

**代码块:**

```python

import tensorflow as tf

# 定义两个任务的模型

task1_model = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

task2_model = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 定义多任务模型

multi_task_model = tf.keras.Model(inputs=tf.keras.Input(shape=(784,)),

outputs=[task1_model.output, task2_model.output])

```

**逻辑分析:**

这段代码定义了一个多任务模型,其中包含两个任务的子模型:`task1_model` 和 `task2_model`。`multi_task_model` 接受一个输入,并输出两个任务的预测结果。

**参数说明:**

* `inputs`: 模型的输入,形状为 (784,),表示 28x28 的灰度图像。

* `task1_model.output`: 第一个任务的输出,形状为 (10,),表示图像属于 10 个类别的概率分布。

* `task2_model.output`: 第二个任务的输出,形状为 (10,),表示图像属于 10 个类别的概率分布。

### 2.2 降低延迟和提高响应能力

在边缘计算中,延迟和响应能力至关重要。多任务学习通过并行执行多个任务,减少了任务的执行时间。这对于实时应用,如自动驾驶和工业控制,尤为重要。

**代码块:**

```python

import threading

# 定义多任务处理函数

def multi_task_handler(task):

# 执行任务

result = task.execute()

# 返回结果

return result

# 创建线程池

thread_pool = ThreadPoolExecutor(max_workers=4)

# 提交任务到线程池

tasks = [task1, task2, task3]

results = thread_pool.map(multi_task_hand

```

0

0