知识蒸馏的最新突破:从理论到实践的飞跃

发布时间: 2024-08-22 16:10:19 阅读量: 50 订阅数: 21

MATLAB绘图艺术:从入门到实践案例-markdown.zip

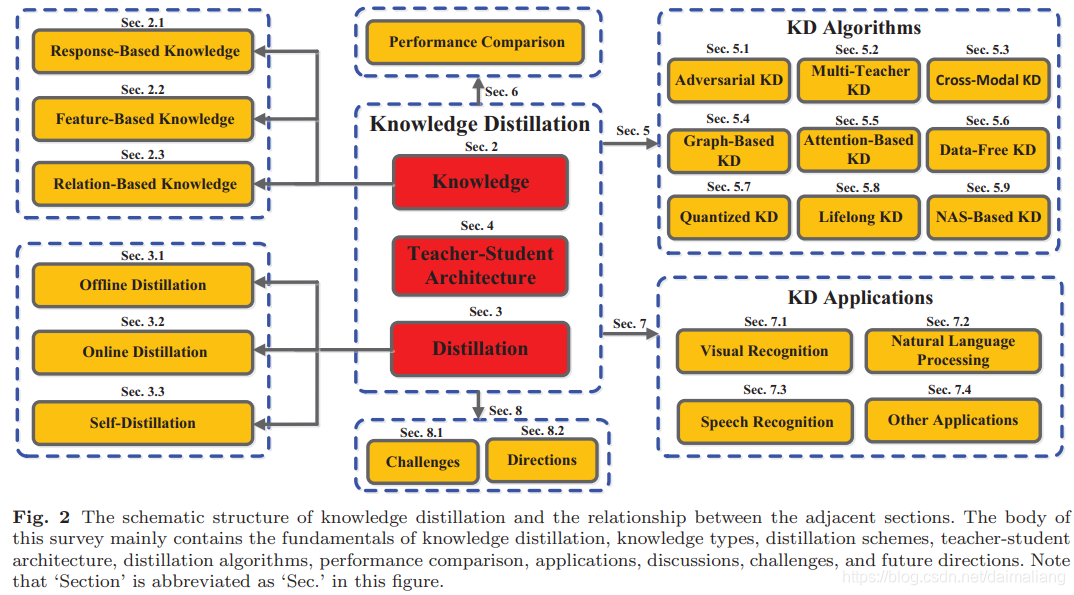

# 1. 知识蒸馏概述**

知识蒸馏是一种机器学习技术,它通过将一个大型且复杂的“教师”模型的知识转移到一个较小且高效的“学生”模型中,来提高学生模型的性能。这种技术在资源受限的环境中特别有用,例如移动设备或边缘设备。

知识蒸馏的过程涉及两个主要步骤:

1. **提取知识:**教师模型通过训练数据集学习复杂的知识和模式。然后,使用各种技术从教师模型中提取这种知识,例如软标签、中间特征或模型参数。

2. **知识转移:**提取的知识被注入学生模型,使其能够学习教师模型的知识和模式。这种转移可以通过修改学生模型的损失函数、添加正则化项或使用特定的蒸馏算法来实现。

# 2. 知识蒸馏理论基础**

**2.1 蒸馏原理和目标**

知识蒸馏是一种机器学习技术,它通过从一个复杂且性能良好的“教师”模型中提取知识,来训练一个更小、更简单的“学生”模型。蒸馏过程的目的是让学生模型获得与教师模型相似的性能,同时具有更小的模型大小和更低的计算成本。

蒸馏原理基于这样一个假设:教师模型已经从数据中学到了丰富的知识和模式,而这些知识和模式可以通过某种方式传递给学生模型。通过最小化教师模型和学生模型之间的知识差异,学生模型可以有效地学习教师模型的知识。

**2.2 蒸馏方法分类**

根据知识传递的方式,知识蒸馏方法可以分为以下三类:

**2.2.1 基于教师-学生模型的方法**

这种方法直接使用教师模型的输出作为学生模型的训练目标。学生模型通过最小化其输出与教师模型输出之间的差异来学习。常用的方法包括:

- **硬蒸馏:**学生模型直接模仿教师模型的输出,即最小化教师模型输出和学生模型输出之间的交叉熵损失。

- **软蒸馏:**学生模型学习教师模型输出的概率分布,而不是具体的输出值。通过最小化教师模型输出和学生模型输出之间的KL散度来实现。

**2.2.2 基于知识迁移的方法**

这种方法将教师模型的知识显式地提取出来,然后将其传递给学生模型。提取的知识可以是教师模型的权重、中间特征图或其他形式。常用的方法包括:

- **知识蒸馏:**将教师模型的中间特征图作为学生模型的训练目标。通过最小化教师模型和学生模型中间特征图之间的均方误差来实现。

- **特征匹配:**将教师模型和学生模型的中间特征图进行匹配,通过最小化特征图之间的距离来实现。

**2.2.3 基于特征匹配的方法**

这种方法通过直接匹配教师模型和学生模型的中间特征图来进行知识传递。常用的方法包括:

- **对抗蒸馏:**将教师模型和学生模型作为对抗网络,通过最小化教师模型对学生模型输出的判别器损失来实现。

- **自适应蒸馏:**动态调整蒸馏损失的权重,以平衡教师模型和学生模型之间的知识差异。

# 3. 知识蒸馏实践应用

### 3.1 自然语言处理

#### 3.1.1 文本分类

文本分类是NLP中的一项基本任务,其目标是将文本输入分配到预定义的类别中。知识蒸馏在文本分类中得到了广泛的应用,它可以有效地将大型预训练模型(如BERT、GPT-3)的知识转移到较小的学生模型中。

**代码示例:**

```python

import torch

from transformers import BertForSequenceClassification, BertTokenizer

# 加载预训练的BERT模型

teacher_model = BertForSequenceClassification.from_pretrained("bert-base-uncased")

# 加载学生模型

student_model = BertForSequenceClassification.from_pretrained("bert-base-uncased")

# 准备文本分类数据集

train_dataset = ... # 加载训练数据集

test_dataset = ... # 加载测试数据集

# 定义损失函数

loss_fn = torch.nn.CrossEntropyLoss()

distill_loss_fn = ... # 定义蒸馏损失函数

# 训练学生模型

optimizer = torch.optim.Adam(student_model.parameters())

for epoch in range(num_epochs):

for batch in train_dataset:

# 前向传播

teacher_logits = teacher_model(batch["input_ids"], batch["attention_mask"])

student_logits = student_model(batch["input_ids"], batch["attention_mask"])

# 计算损失

classification_loss = loss_fn(student_logits, batch["labels"])

distillation_loss = distill_loss_fn(student_logits, teacher_logits)

loss = classification_loss + distillation_loss

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

# 评估学生模型

tes

```

0

0