e1071包在R语言中的分类算法应用:决策树与随机森林,轻松掌握

发布时间: 2024-11-02 08:10:58 阅读量: 34 订阅数: 26

# 1. R语言与e1071包基础介绍

## 简述R语言及其在数据分析中的地位

R语言作为一种开源的统计编程语言,在数据分析领域占有重要地位。凭借其强大的图形表示能力、统计分析功能以及丰富的第三方包支持,R语言成为了数据科学领域工作者的宠儿。它特别适用于统计计算、数据可视化和机器学习任务,让科研人员和分析师能够快速地进行数据处理和模型构建。

## e1071包的作用及其在R语言中的重要性

e1071包是一个强大的R语言扩展包,它提供了许多用于数据挖掘和机器学习的算法,其中最为人熟知的是支持向量机(SVM)。该包不仅支持各种类型的SVM模型,还提供了诸如随机森林和k最近邻等其他机器学习模型。通过e1071包,R语言的用户能够轻松实现复杂的算法,并对数据进行深入分析。

## R语言与e1071包的安装和基本使用

要在R语言中安装和使用e1071包,用户需要在R控制台输入如下命令:

```r

install.packages("e1071")

library(e1071)

```

完成安装后,即可通过调用包中的函数,如`svm()`来训练支持向量机模型。在使用任何函数之前,建议先阅读该函数的R文档,可通过`?svm`命令查看。

以上是第一章的内容,为读者介绍了R语言及其扩展包e1071的基础知识,为后续更深入的机器学习算法讲解打下了基础。在后续章节中,我们将详细探讨决策树和随机森林等算法,并展示如何在R语言中通过e1071包实现这些算法。

# 2. 决策树分类算法详解

## 2.1 决策树的基本概念和原理

### 2.1.1 决策树的构建和选择标准

决策树是一种常见的分类与回归方法,它通过一系列的规则将数据集划分成不同的类别。树的每个内部节点表示一个属性上的判断,每个分支代表一个判断结果的输出,而每个叶节点代表一种分类结果。构建决策树的过程是一个将特征空间不断分割的过程,目标是使得分割后的子集尽可能属于同一个类别。

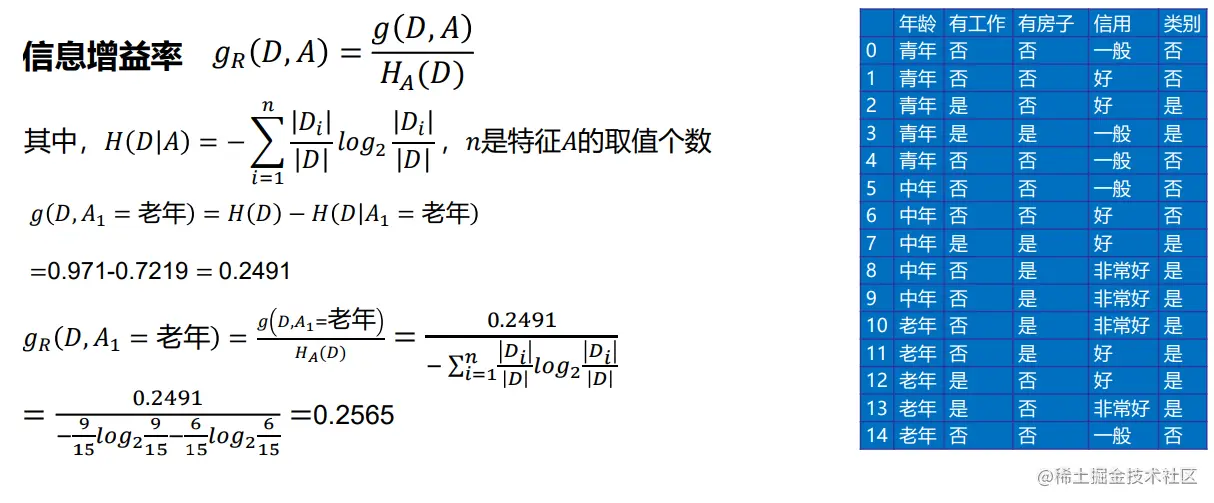

选择标准有多种,常用的包括信息增益、增益率和基尼指数。信息增益是基于熵的概念,它衡量了特征带来的信息量的多少;增益率是信息增益除以特征自身的熵,用来减少对具有太多取值的特征的偏好;基尼指数是衡量数据不纯度的一个指标,其值越小,数据集的纯度越高。

### 2.1.2 决策树的剪枝策略和优化

决策树容易过拟合,即在训练数据上表现很好,但在未见数据上表现较差。剪枝是一种常用的优化决策树的方法,包括预剪枝和后剪枝。预剪枝是在构建决策树的过程中,通过设置停止条件(如最大深度、最小样本数)来提前终止树的增长;后剪枝是在树构建完成后,通过分析树的验证集错误率来删除那些对结果贡献小的子树。

## 2.2 在R语言中应用决策树

### 2.2.1 e1071包中的决策树函数使用

在R语言中,`e1071`包提供了`svm()`函数,可以用来构建决策树。以下是一个简单的示例代码:

```R

# 加载e1071包

library(e1071)

# 假设已有数据集data和目标向量y

data <- read.csv('data.csv')

y <- data$target

# 使用svm函数构建决策树,选择C类支持向量机和线性核函数

model <- svm(y ~ ., data = data, kernel = "linear", cost = 10)

# 输出模型的详细信息

summary(model)

```

### 2.2.2 实例分析:决策树模型的创建与评估

在实际应用中,我们需要对决策树模型进行创建和评估。以下是具体的步骤和代码示例:

```R

# 加载数据集,这里以鸢尾花数据集为例

data(iris)

# 划分数据集为训练集和测试集

set.seed(123)

index <- sample(1:150, 100)

train_data <- iris[index, ]

test_data <- iris[-index, ]

# 构建决策树模型

model <- svm(Species ~ ., data = train_data, kernel = "linear")

# 使用测试集进行预测

predictions <- predict(model, test_data)

# 评估模型性能,这里使用混淆矩阵

table(predictions, test_data$Species)

```

### 2.3 决策树算法的优化与调参

#### 2.3.1 参数调整的策略和方法

在构建决策树模型时,参数的调整是提高模型性能的关键步骤。对于`svm()`函数,重要的参数包括`cost`(惩罚参数C)和`gamma`(核函数参数)。`cost`的大小影响模型的复杂度和过拟合程度,较小的`cost`会导致较大的误差,而较大的`cost`可能会导致过拟合。`gamma`定义了在使用径向基函数时,样本之间的影响力大小,较小的`gamma`意味着样本的影响范围较大。

#### 2.3.2 过拟合与欠拟合的处理

处理过拟合的方法通常包括:增加数据集规模、简化模型复杂度、使用交叉验证和调整参数。而处理欠拟合的方法包括:增加特征数量、减少模型复杂度的限制或选择更复杂的模型。在R中可以使用`tune()`函数来尝试不同的参数组合,并通过交叉验证来找到最优模型。

```R

# 使用tune函数来寻找最优的cost和gamma参数

tuned_model <- tune(svm, Species ~ ., data = iris, kernel = "linear", ranges = list(cost = c(0.1, 1, 10, 100), gamma = c(0.5, 1, 2, 3)))

# 输出tune函数找到的最优参数和交叉验证结果

summary(tuned_model)

```

通过调整和优化参数,我们可以构建一个既不过拟合也不欠拟合的决策树模型,从而在未知数据集上得到更好的泛化能力。

# 3. 随机森林分类算法探索

在机器学习领域,随机森林算法作为一种流行的集成学习方法,通过构建多个决策树并进行投票或者平均的方式来提高模型的准确性和稳定性。本章节将深入探讨随机森林的工作机制、优势以及如何在R语言中实现和优化随机森林模型。

## 3.1 随机森林的工作机制与优势

### 3.1.1 集成学习与袋外误差估计

随机森林是集成学习方法的一种,它通过构建多个决策树来达到增强模型性能的目的。集成学习是一种通过组合多个学习器来完成学习任务的方法,其核心思想是利用

0

0