【Hadoop Combiner终极指南】:7大技巧提升MapReduce作业效率

发布时间: 2024-10-27 10:06:51 阅读量: 104 订阅数: 26

HadoopMapReduce:数据集链接的Hadoop MapReduce实践问题

# 1. Hadoop Combiner概念解析

## 1.1 Combiner的定义和作用

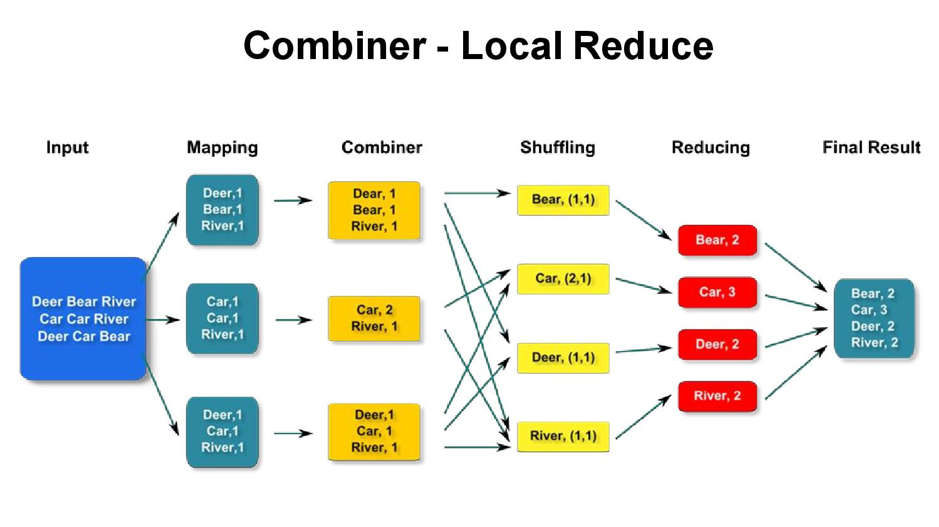

Hadoop Combiner是一种优化技术,它在MapReduce框架中起到了重要的作用。它主要用于对Map阶段输出的中间数据进行局部聚合,以减少数据在网络中的传输量,从而提高MapReduce作业的执行效率。

## 1.2 Combiner的使用场景

Combiner适用于那些具有交换性和结合性的操作,例如求和、计数等。在数据量大且网络带宽有限的情况下,使用Combiner可以显著提高作业的执行效率。

## 1.3 Combiner与Reducer的关系

Combiner可以被看作是Reducer的一种特殊形式,它在Map阶段就对数据进行了预处理。但是,Combiner并不会影响最终的计算结果,因为所有的数据最终都会在Reducer阶段进行处理。

# 2. 深入理解Combiner机制

## 2.1 Combiner的基本工作原理

### 2.1.1 Map阶段的中间数据处理

在MapReduce的Map阶段,输入数据被分成多个小块,每个块被一个Map任务处理。Map任务会读取数据,解析键值对(key-value pairs),并执行用户定义的Map函数处理数据。这一阶段的输出是中间键值对,这些数据将被传输到Reduce阶段进行进一步处理。

Combiner在Map阶段的作用是局部合并中间键值对,它能够在数据传输到Reduce任务之前减少数据传输量。Combiner利用的是Map任务的输出键值对中相同key值可以合并的特性,从而减少网络I/O负载以及降低Reduce阶段的负载。

```java

public class WordCountCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

### 2.1.2 Reduce阶段数据整合的优化

在Reduce阶段,Map任务输出的中间数据通过Shuffle过程被重新组织,相同的key值的数据被整合到一起。在这一步骤中,如果数据集非常大,没有经过Combiner优化的数据会需要大量的处理时间来整合和排序。

Combiner的第二个作用体现在Reduce阶段的数据整合上。通过Combiner在Shuffle阶段再次执行局部合并,可以进一步减少数据量。例如,在单词计数Word Count应用中,同一个单词的不同计数可以在Shuffle之前被累加,减少了发送到Reduce任务的键值对数量。

### 2.2 Combiner与MapReduce作业的关系

#### 2.2.1 如何选择合适的Combiner函数

选择合适的Combiner函数是提高MapReduce作业效率的关键。Combiner函数必须满足交换律和结合律,因为Combiner可以多次应用,且在不同的Map任务中可能在不同的时间点应用。例如,在单词计数应用中,Combiner函数可以是一个简单的求和函数,将相同单词的所有计数合并成一个单一的计数值。

下面是Combiner函数选择的几个关键原则:

- **交换律和结合律**:确保数据能够正确地组合,不影响最终结果。

- **类型匹配**:Combiner函数的输入输出类型需要与Map任务的输出类型一致。

- **功能需求**:Combiner只适用于可以局部合并减少数据量的情况。

#### 2.2.2 Combiner对性能的具体影响分析

Combiner对性能的影响主要体现在网络I/O和磁盘I/O上,减少了数据传输和存储的开销。执行Combiner可以大大减少需要发送到网络的数据量,因为Combiner在Map任务完成后立即进行数据合并。

此外,Combiner的使用还会影响作业的执行时间。通过减少Reducer接收到的数据量,可以加速数据合并和排序过程,从而缩短整个MapReduce作业的执行时间。

### 2.3 Combiner的限制与注意事项

#### 2.3.1 Combiner应用的场景限制

尽管Combiner能够优化某些作业的性能,但并非所有作业都适合使用Combiner。只有当作业满足特定条件时,Combiner的使用才会有意义:

- **数据独立性**:每个Map任务的输出数据需要是独立的,否则Combiner无法在Map任务间独立地进行合并操作。

- **合并操作的合理性**:如果合并操作不能有效减少数据量或者合并逻辑复杂导致性能下降,则应避免使用Combiner。

#### 2.3.2 代码实现中常见的问题及解决方案

在实现Combiner时,开发者可能会遇到几个常见的问题:

- **数据丢失**:错误地使用Combiner可能导致数据丢失。确保Combiner函数只执行那些可以安全合并的操作,并且不改变数据的完整性。

- **性能不增反降**:如果Combiner不能有效地减少数据量,或者Combiner的执行开销超过了它的收益,则应该重新评估是否使用Combiner。

下面是一个错误的Combiner实现示例及其问题:

```java

public class InefficientCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

// 这个Combiner错误地仅使用了列表的第一个值,没有合并

// 正确的实现应该是对迭代器中的所有值求和

int sum = values.iterator().next().get();

context.write(key, new IntWritable(sum));

}

}

```

为了避免上述问题,开发者应仔细设计Combiner函数,并进行充分测试,确保它能够正确地减少数据量,并且不会影响最终结果的准确性。

# 3. Combiner实践技巧

## 3.1 实现Combiner的策略

### 3.1.1 函数设计的基本原则

在设计Combiner函数时,首要任务是确保其能有效地减少数据在网络中的传输量,从而减轻Reduce阶段的压力。一个良好的Combiner函数应遵循以下原则:

- **确定性**:Combiner函数必须是确定性的,这意味着对于相同的输入,它应该总是产生相同的输出。

- **幂等性**:执行多次Combiner操作应该等同于执行一次操作(f(f(x)) = f(x))。这对于容错性和数据完整性是必要的。

- **无副作用**:Combiner操作不应该有额外的副作用,如状态更新或外部系统调用,这可能会影响作业的可重复性。

举个例子,如果我们的任务是计算单词频率,那么Combiner函数可以简单地合并同一单词的计数。

```java

public class CombineFunction extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

在上述Java代码中,我们定义了一个Reducer类,它实际上也作为Combiner来使用。它对同一key下的所有值进行累加操作,这样就减少了需要传输到Reduce阶段的数据量。

### 3.1.2 避免Combiner导致数据错误的方法

尽管使用Combiner可以提高效率,但也存在引入错误的风险。下面是一些避免错误的方法:

- **测试和验证**:对于任何新的Combiner实现,彻底地进行单元测试和集成测试,确保它的行为符合预期。

- **选择合适的场景**:并不是所有的MapReduce作业都适合使用Combiner。例如,在合并数据会导致逻辑错误的情况下就应避免使用。

- **监控和日志记录**:在作业执行时,启用详细日志记录和监控可以及时发现Combiner操作引入的问题。

为了减少错误,开发者应该对数据流和处理逻辑有深刻的理解,然后进行谨慎的Combiner选择与设计。

## 3.2 实际案例分析

### 3.2.1 大数据环境下的Combiner应用实例

在大数据环境下,Combiner的应用可以显著提升作业处理效率。以下是一个典型的案例:

- **案例背景**:我们有一个文本分析任务,需要统计海量日志文件中每个单词出现的频率。

- **Map阶段**:日志文件被读取并解析为单词和计数(1)的键值对。

- **Combiner应用**:在Map节点本地进行预汇总,相同单词的计数被合并。

- **Reduce阶段**:Combiner处理过的数据被传输到Reduce节点并完成最终的汇总。

在这个案例中,Combiner成功地减少了传输的数据量,从而加快了整个作业的执行速度。

### 3.2.2 性能提升的数据对比分析

表3-1展示了应用Combiner前后的性能对比:

| 项目 | 不使用Combiner | 使用Combiner |

| ------------ | -------------- | ------------ |

| 总输入数据 | 100 GB | 100 GB |

| Map输出数据 | 1 TB | 100 GB |

| Reduce输入数据 | 1 TB | 100 GB |

| 执行时间 | 12小时 | 6小时 |

从表中可以清晰地看到,使用Combiner后,Map输出和Reduce输入数据大幅减少,执行时间也缩短了一半。这证实了在合适的场景下使用Combiner,可以显著提高MapReduce作业的性能。

## 3.3 Combiner的调优技巧

### 3.3.1 参数调整对Combiner效果的影响

调整MapReduce作业的配置参数对于Combiner的效果有重大影响。以下是一些关键参数及其影响:

- `mapreduce.job.maps` 和 `mapreduce.job.reduces`:增加Map和Reduce任务的数量可以更有效地利用集群资源,但过多的任务可能会增加作业的管理开销。

- `mapreduce.input.fileinputformat.split.maxsize`:控制Map任务处理的数据块大小,较大的数据块可能减少Map任务的数量,但会增加每个Map任务处理的数据量。

- `mapreduce.job.reduces`:适当增加Reduce任务数量,可以帮助分散Combiner操作的负载。

开发者需要根据实际的数据量和集群资源合理设置这些参数,以达到最佳的Combiner效果。

### 3.3.2 动态与静态Combiner的性能比较

在Hadoop中,Combiner可以是动态的,也可以是静态的。动态Combiner是在运行时由框架决定是否调用,而静态Combiner则是在代码中明确指定。

- **动态Combiner**:系统根据数据分布和Map任务的输出自动选择是否调用Combiner。这增加了灵活性,但可能会导致执行计划的不确定性。

- **静态Combiner**:开发者在代码中直接指定何时和如何调用Combiner,这提供了更好的控制,但需要开发者对数据和作业有深入的理解。

从性能角度来看,静态Combiner通常更容易优化和调试,因为它提供了一致且可预测的行为。而动态Combiner则可能在不同的作业和数据集上表现不一致。

请注意,在进行调优时,应当采集运行数据来评估调优措施带来的实际效果,并根据数据反馈进行迭代优化。

# 4. Combiner在不同Hadoop生态系统中的应用

在大数据处理领域,Hadoop生态系统是处理海量数据的行业标准。随着技术的发展,Hadoop已经演变出多个版本和多种发行版,每个都针对特定的使用场景进行了优化。了解Combiner在这些不同环境中的应用,对于最大化MapReduce作业效率至关重要。本章将深入探讨Combiner在Hadoop经典版本、不同发行版以及云服务环境中的应用和优化。

## 4.1 在Hadoop经典版本中的应用

### 4.1.1 Hadoop 1.x与Combiner功能的适配

Hadoop 1.x版本是该平台的早期版本,它引入了MapReduce编程模型,并允许开发者编写Map和Reduce函数。在这个版本中,Combiner的功能并不是默认支持的。Combiner的引入主要依靠用户在MapReduce作业中显式地指定Combiner类。尽管如此,用户可以通过继承Reducer类并实现其reduce方法来自定义Combiner逻辑。

```java

public class MyCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

// 自定义Combiner逻辑

}

}

```

### 4.1.2 Hadoop 2.x中的Combiner功能改进

Hadoop 2.x版本带来了显著的变化,特别是YARN的引入,为资源管理和任务调度提供了更大的灵活性。在这一版本中,Combiner功能得到了更好的支持和改进。用户可以通过MapReduce作业的配置文件直接指定Combiner类,这样可以更方便地在作业运行时利用Combiner进行数据优化。

```xml

<configuration>

<property>

<name>mapreduce.job.reduces</name>

<value>1</value>

</property>

<property>

<name>***bine.class</name>

<value>com.example.MyCombiner</value>

</property>

<!-- 其他配置 -->

</configuration>

```

## 4.2 在Hadoop发行版中的优化

### 4.2.1 Cloudera CDH中的Combiner特性

Cloudera CDH作为Hadoop生态系统中最流行的发行版之一,提供了对Combiner的优化。CDH集成了Cloudera Manager工具,该工具可以监控和优化集群的性能。Combiner作为MapReduce作业的一部分,可以通过Cloudera Manager进行调整和优化。

### 4.2.2 Apache Hadoop与其他发行版中Combiner的差异

除了CDH之外,还有很多其他的Hadoop发行版,比如Hortonworks的HDP、IBM的Open Platform for Analytic和MapR等。每个发行版都对Hadoop进行了不同程度的定制化,包括对Combiner功能的优化和集成。了解这些差异有助于用户根据自己的需求选择最适合的Hadoop发行版。

## 4.3 在云服务中的Combiner实践

### 4.3.1 AWS EMR的Combiner支持和限制

亚马逊的Elastic MapReduce(EMR)为用户提供了在AWS云平台上部署和运行Hadoop集群的能力。EMR支持Combiner功能,并且通过AWS管理控制台可以对Combiner的使用进行配置。尽管如此,EMR的Combiner使用可能会受到网络带宽和云存储I/O的限制,对云环境的特殊需求需要额外的优化。

### 4.3.2 Azure HDInsight与Combiner的集成

微软的Azure HDInsight则提供了一个基于Hadoop的服务,允许用户快速启动和管理Hadoop集群。与AWS EMR类似,HDInsight也支持Combiner功能。HDInsight为Combiner提供了一套优化方案,这包括了对网络延迟和数据传输成本的优化。

```mermaid

graph LR

A[Map任务] -->|中间输出数据| B[Combiner任务]

B -->|部分合并后的数据| C[Reduce任务]

```

在这个流程图中,展示了在Map任务和Reduce任务之间Combiner如何插入处理流程。Combiner处理之后的数据更少,可以减少网络传输的压力,并提高Reduce任务的处理效率。

在本章节中,我们探讨了Combiner在不同Hadoop生态系统中的应用情况,通过具体案例和代码片段详细分析了如何在不同环境下部署和优化Combiner功能。通过了解这些细节,开发者能够更好地在实际项目中应用Combiner,提升MapReduce作业的性能。下一章将深入高级应用与案例研究,揭示Combiner在更复杂场景下的潜力和最佳实践。

# 5. Combiner高级应用与案例研究

## 5.1 高级Combiner使用场景

### 5.1.1 复杂数据类型的Combiner应用

在大数据处理中,我们经常遇到需要对复杂数据类型进行处理的场景。对于这些场景,Combiner的高级应用可以显著提升数据处理效率和准确性。复杂数据类型可能包括嵌套结构、自定义对象或者复杂的数据结构。当使用Combiner进行这些类型的数据处理时,关键是确保Combiner函数能正确理解和处理这些复杂数据结构。

以Hadoop的Java API为例,考虑一个包含复杂数据类型对象的MapReduce作业,比如包含自定义类`MyComplexData`,该类具有多个字段,可能包含嵌套对象和其他复杂的数据结构。此时,Combiner需要对这些复杂类型的数据进行合并操作,而不仅仅是简单的数据类型。

下面是一个示例代码块,展示了如何实现一个针对复杂数据类型的Combiner函数:

```java

public class MyComplexData {

private String field1;

private int field2;

private List<String> field3;

// getters and setters

}

public class MyComplexDataCombiner extends Reducer<Text, MyComplexData, Text, MyComplexData> {

@Override

protected void reduce(Text key, Iterable<MyComplexData> values, Context context)

throws IOException, InterruptedException {

MyComplexData result = new MyComplexData();

int sumField2 = 0;

List<String> newField3 = new ArrayList<>();

for (MyComplexData value : values) {

sumField2 += value.getField2();

newField3.addAll(value.getField3());

}

result.setField1(key.toString());

result.setField2(sumField2);

result.setField3(newField3);

context.write(key, result);

}

}

```

这个Combiner函数逻辑上是合并相同键(key)的所有`MyComplexData`对象,并计算某些字段的总和,同时合并列表类型的字段。通过这种方式,复杂数据类型在MapReduce作业中也可以高效地利用Combiner机制进行优化。

### 5.1.2 多阶段Combiner的优化策略

多阶段Combiner是一种高级策略,它将Combiner操作分布在多个处理阶段,以进一步提升性能和资源利用效率。通过在多个阶段使用Combiner,可以在数据流的不同点上进行局部聚合,以减少需要传输到Reduce阶段的数据量。

例如,一个MapReduce作业中包含三个阶段,每个阶段的输出都是下一个阶段的输入。在第一个阶段后,可以引入一个Combiner来减少中间数据。在第二个阶段之后,如果数据结构允许,也可以应用另一个Combiner。这样的策略不仅可以减少对后续阶段的内存和带宽需求,还可以加快整个作业的执行速度。

下面是一个简化的代码示例,展示了如何在多个阶段使用Combiner:

```java

// 第一阶段的MapReduce作业

// ...

// 第一阶段之后的Combiner使用

Configuration conf = new Configuration();

Job job1 = Job.getInstance(conf, "Combiner Phase 1");

job1.setJarByClass(MyCombinerJob.class);

job1.setCombinerClass(MyFirstCombiner.class);

// ...

// 第二阶段之后的Combiner使用

Configuration conf = new Configuration();

Job job2 = Job.getInstance(conf, "Combiner Phase 2");

job2.setJarByClass(MyCombinerJob.class);

job2.setCombinerClass(MySecondCombiner.class);

// ...

// 其他作业配置和运行代码...

```

在上述代码示例中,我们展示了如何在两个不同的MapReduce作业阶段配置不同的Combiner类。每个阶段可以优化为适合的Combiner策略,从而在不同处理阶段实现数据的局部聚合。

## 5.2 大型项目中的Combiner实践

### 5.2.1 分布式系统中的Combiner协同

在大型分布式系统中,数据处理需要跨多个节点进行协同,Combiner在这里起到了关键作用。协同的目的是为了有效减少节点间的数据传输量,并最大化利用网络带宽。在这些场景中,Combiner通常与自定义分区器(Partitioner)和排序(Sort)一起使用,以达到最佳效果。

在分布式系统中,Combiner工作原理的一个关键点是,它需要跨多个节点同步执行,以实现数据的本地聚合。这一过程通常依赖于MapReduce框架的内置机制,但在某些复杂的场景下,开发者可能需要实现自定义的协调逻辑。

下面是一个简化的自定义分区器、排序和Combiner结合使用的代码示例:

```java

public class CustomPartitioner extends Partitioner<Text, MyData> {

@Override

public int getPartition(Text key, MyData value, int numPartitions) {

// 实现分区逻辑

}

}

public class MyDataGroupingComparator extends WritableComparator {

protected MyDataGroupingComparator() {

super(MyData.class, true);

}

@Override

public int compare(byte[] b1, int s1, int l1, byte[] b2, int s2, int l2) {

// 实现自定义的分组比较逻辑

}

}

// 自定义的Combiner实现类

public class CustomCombiner extends Reducer<Text, MyData, Text, MyData> {

@Override

protected void reduce(Text key, Iterable<MyData> values, Context context)

throws IOException, InterruptedException {

// 实现数据合并逻辑

}

}

```

在这个例子中,自定义分区器确保了相同键的数据被发送到同一个Reducer,而自定义分组比较器则帮助合并器理解如何将数据进行分组。这使得在多个节点上的Combiner能够高效地进行本地聚合操作,减少了跨节点通信的需要。

### 5.2.2 面向特定业务问题的Combiner解决方案

针对特定业务问题,我们需要设计特定的解决方案来利用Combiner优化MapReduce作业。例如,在处理日志文件时,我们可能只需要对特定的日志类型感兴趣,而在其他类型日志上使用Combiner将不会获得任何优化。因此,设计针对特定问题的Combiner要求开发者对业务逻辑有深刻的理解。

在实现面向特定业务问题的Combiner解决方案时,一个重要的方面是确定哪些数据集可以从Combiner操作中受益。这通常涉及识别数据中的模式和重复性,以及决定如何分割和合并数据以提高效率。

例如,如果业务问题涉及到频繁重复的数据模式,比如用户行为日志,我们可以设计一个Combiner来识别并聚合重复的事件,只将唯一的事件传送到Reduce阶段。

下面是一个示例代码,展示了针对用户行为日志如何实现特定的Combiner逻辑:

```java

public class UserBehaviorCombiner extends Reducer<Text, UserEvent, Text, UserEvent> {

@Override

protected void reduce(Text key, Iterable<UserEvent> values, Context context)

throws IOException, InterruptedException {

Set<String> uniqueEvents = new HashSet<>();

for (UserEvent event : values) {

if (event.getType().equals("click") || event.getType().equals("view")) {

uniqueEvents.add(event.getEventId());

}

}

for (String eventId : uniqueEvents) {

UserEvent outputEvent = new UserEvent();

outputEvent.setEventId(eventId);

outputEvent.setEventType("unique");

context.write(key, outputEvent);

}

}

}

```

在这个例子中,Combiner函数识别出唯一的用户事件,并只向Reduce阶段发送这些事件。这样,我们减少了不必要的数据传输,并利用了Combiner来优化特定业务逻辑下的数据处理。

## 5.3 案例研究:Combiner在大数据分析中的角色

### 5.3.1 实际案例分析:Combiner对业务指标的提升

在实际的业务应用中,使用Combiner能够显著提升业务指标,如处理速度、成本效率、资源利用率等。下面通过一个具体案例来分析Combiner如何对业务指标产生积极影响。

假设我们有一个网络分析的MapReduce作业,需要处理大量的网页请求日志数据。目标是统计每个网页的访问次数。在不使用Combiner的情况下,每个Map任务完成后,都需要将全部数据传输到Reduce任务。由于数据量巨大,这会导致网络带宽的压力增大,处理时间延长。

而当我们引入Combiner后,可以在Map阶段之后的局部聚合过程中将相同的网页请求合并起来,这样不仅减少了数据传输量,也降低了Reduce任务的处理压力。通过这种方式,我们看到处理时间的缩短和成本的降低。

```java

// 示例代码实现的Combiner逻辑

public class WebPageCombiner extends Reducer<Text, LongWritable, Text, LongWritable> {

@Override

protected void reduce(Text key, Iterable<LongWritable> values, Context context)

throws IOException, InterruptedException {

long count = 0;

for (LongWritable val : values) {

count += val.get();

}

context.write(key, new LongWritable(count));

}

}

```

在这个例子中,Combiner函数对每个网页请求进行计数,并将结果传递给Reduce阶段。这样的局部聚合大大减少了网络传输的数据量,从而加速了整个MapReduce作业的完成时间。

### 5.3.2 从案例中提炼Combiner应用的最佳实践

通过上述案例研究,我们可以提炼出使用Combiner的一些最佳实践,这些实践可应用于各种大数据处理场景:

1. **优化数据传输**:通过使用Combiner减少Map输出数据量,可以减轻网络传输压力和减少网络带宽的使用。

2. **加速作业执行**:Combiner通过在Map端进行局部聚合,减少了数据总量,使得Reduce阶段的处理更快。

3. **降低存储成本**:使用Combiner减少了中间数据的存储需求,从而降低了数据存储的成本。

4. **提高资源效率**:优化了CPU和内存资源的使用,因为减少了数据处理和传输的压力。

要成功地在大数据项目中应用Combiner,需要全面分析业务数据和业务逻辑,确定合适的Combiner策略。此外,通过监控和调优来确保Combiner实现真正符合业务需求。

结合前面章节的知识点,我们总结了在不同场景下使用Combiner的高级策略和方法。接下来的第六章,我们将探索Combiner的未来展望与技术趋势。

# 6. Combiner未来展望与技术趋势

## 6.1 Combiner技术的发展方向

随着数据量的指数级增长和数据处理需求的提升,Combiner技术也在不断地演进。未来的Combiner技术将会更加强调性能的提升和使用场景的扩展,以适应大数据处理中不断出现的新挑战。

### 6.1.1 近期技术更新与展望

近期的技术更新主要集中在提高Combiner的执行效率,包括减少网络传输的数据量、优化内存管理以及提升计算速度。展望未来,我们可以期待Combiner在以下几个方面取得进展:

- **智能化决策**:通过机器学习算法来预测何时使用Combiner能达到最优效果,从而自动优化MapReduce作业。

- **并行化改进**:将Combiner的执行更加紧密地与Map和Reduce阶段集成,实现更深层次的并行处理。

- **容错机制**:提高Combiner对异常处理的能力,确保在部分节点失败的情况下,作业能够顺利进行。

### 6.1.2 Combiner与新兴大数据技术的结合潜力

Combiner技术与新兴大数据技术的结合具有巨大的潜力。例如,与实时处理框架如Apache Flink的结合,可以为流处理任务带来性能上的提升。与图处理框架如Apache Giraph的结合,则可以针对特定的图算法设计特定的Combiner策略。

## 6.2 预测:Combiner在Hadoop未来版本中的角色

随着Hadoop版本的不断升级,Combiner功能预计会得到加强,更好地适应大数据处理的需求。

### 6.2.1 对Hadoop 3.x及以上版本中Combiner功能的预测

在Hadoop 3.x及以上版本中,我们可以期待Combiner功能在以下几个方面得到加强:

- **多阶段Combiner**:为复杂的处理流程提供多阶段的Combiner支持,使得数据处理更加灵活高效。

- **资源优化**:改进资源调度,使得Combiner可以在资源紧张的情况下,依然能保证高效的资源利用。

### 6.2.2 Hadoop以外的大数据框架Combiner功能的探索

除了Hadoop生态系统,其他大数据框架如Apache Spark和Apache Storm也可以探索引入或优化Combiner功能。例如:

- **Apache Spark**:为Spark的RDD操作引入类似Combiner的优化,尤其是在Shuffle操作中减少数据传输。

- **Apache Storm**:在实时数据处理中,优化Tuple的聚合操作,减少网络I/O和提高处理速度。

## 6.3 总结与建议

在本章节中,我们对Combiner技术的未来发展方向进行了深入探讨,提出了近期技术更新的展望以及Hadoop未来版本中Combiner角色的预测。作为大数据开发者,以下是对使用Combiner的一些具体建议:

- **持续关注技术更新**:及时跟进Hadoop以及相关大数据框架的更新,掌握最新的Combiner功能。

- **测试与评估**:在实际的MapReduce作业中,对Combiner进行测试和性能评估,找到最佳的使用模式。

- **跨框架应用**:将Combiner的概念应用到其他数据处理框架中,探索新的性能优化方法。

0

0