【Combiner应用全解析】:掌握Hadoop中的数据预处理与聚合技巧

发布时间: 2024-10-27 10:35:11 阅读量: 34 订阅数: 17

# 1. Combiner在Hadoop中的角色

## 1.1 Combiner的核心作用

在大数据处理框架Hadoop中,Combiner组件扮演着重要的角色,它是MapReduce作业优化的关键技术之一。Combiner的主要职责是在Map阶段和Reduce阶段之间,对中间数据进行局部合并,以减少传输到Reducer的数据量。通过这种方式,Combiner可以显著减少网络I/O开销,进而提高整体作业的执行效率。

## 1.2 Combiner与数据处理效率

理解Combiner如何工作,对于设计高性能的MapReduce程序至关重要。在处理大规模数据集时,如果不使用Combiner,可能会导致大量的重复数据在网络中传输,从而降低整个作业的效率。Combiner作为一种优化手段,能够将具有相同key值的数据先进行合并,仅将合并后的结果发送到Reducer端。这样不仅能减少数据传输量,还能加快Reduce阶段的处理速度,提升数据处理的整体效率。

## 1.3 选择合适的Combiner函数

选择合适的Combiner函数是提高MapReduce作业性能的关键。Combiner函数应该能够无损地合并具有相同key值的数据。常用的操作包括求和、计数、取最大值或最小值等。对于特定应用来说,需要设计一个符合业务逻辑的Combiner函数,以便在保证数据准确性的同时,最大限度地减少数据传输。开发者在设计Combiner逻辑时,需要考虑数据的聚合特性以及最终Reduce阶段处理的需要。

# 2. Combiner的理论基础

## 2.1 Hadoop数据流概述

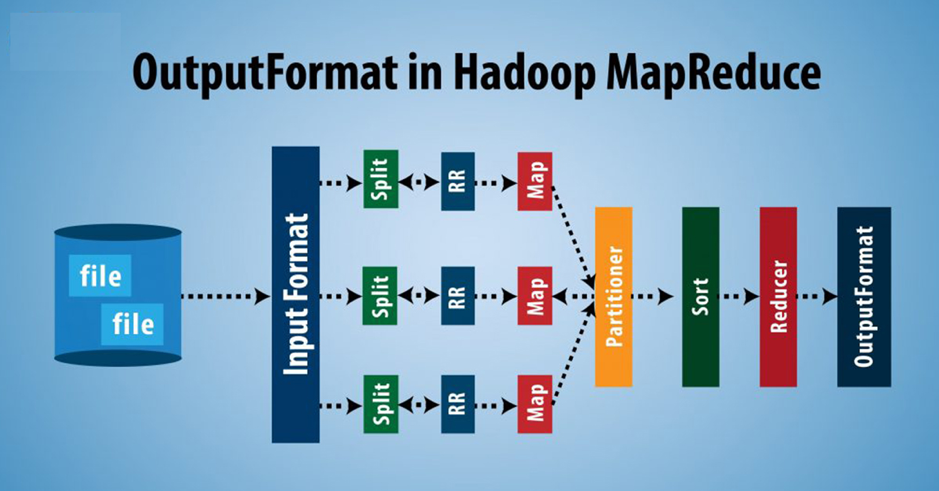

### 2.1.1 MapReduce框架简介

MapReduce是一种编程模型,用于大规模数据集(大数据)的并行运算。它由Google提出,Apache Hadoop实现了该模型的开源版本。核心思想是“分而治之”,将计算任务拆分为两个阶段:Map阶段和Reduce阶段。

在Map阶段,输入数据被分成独立的块,这些块被并行处理。每个块由Map函数处理,它将输入转换为一系列中间键值对(key-value pairs)。然后,这些中间结果被“洗牌”(Shuffle),意味着将具有相同键的所有值聚集在一起。

Reduce阶段则将具有相同键的所有值聚合起来,通过Reduce函数进行合并处理,最终产生用户想要的结果。

### 2.1.2 Map阶段和Reduce阶段的工作原理

Map阶段开始于输入数据的分块,Hadoop将文件分割成固定大小的块(默认为128MB),这些块被分配给不同的节点进行处理。Map任务的数量通常由输入数据的块数量决定。

Map任务读取输入块,解析成键值对,然后根据应用逻辑处理这些键值对,产生中间结果。这些中间结果存储在本地磁盘,并且在写入磁盘前,会进行一次排序和分区操作,确保相同键的数据被分到同一个Reducer上。

在Reduce阶段,数据从Map端被拉取,这个过程叫做Shuffle。Shuffle将数据按照键进行分区,并且将相关联的数据聚集到一起,通过网络传输到Reduce任务。然后,Reduce任务对这些数据进行排序(根据Map阶段输出的key值),并进行合并操作,最终输出结果。

## 2.2 Combiner的工作机制

### 2.2.1 Combiner与Shuffle过程的关系

Combiner组件是MapReduce框架中的一部分,它位于Map和Reduce之间,主要作用是在数据从Map端传输到Reduce端之前,对数据进行局部合并,以减少数据的传输量,从而提高整体的处理效率。

在Shuffle过程中,Combiner可以看作是一个小的Reduce操作。它的输入是Map阶段输出的一系列中间键值对,输出是局部聚合后的键值对。使用Combiner可以显著减少传输到Reduce节点的数据量,因为相同键的值可以在Map节点上进行合并,不需要全部发送到Reduce节点。

### 2.2.2 Combiner的触发时机和条件

Combiner只有在Map任务的输出符合一定条件时才会被触发。首先,Combiner的使用并不是强制的,它是可选的,开发者可以根据作业的特性来决定是否需要Combiner。

如果Map函数输出的中间键值对数量过多,那么在Shuffle过程中,网络传输和磁盘I/O的压力会很大。这时,可以考虑在Map任务后面添加一个Combiner组件来减少数据量。

在Hadoop框架中,Combiner的触发条件是由作业配置决定的。开发者可以指定一个Combiner类,这个类必须实现Reducer接口。当Map任务完成后,Hadoop会检查是否存在Combiner类的实例,并且它满足一定的触发条件,然后才会执行Combiner操作。

通常情况下,Combiner类的作用与Reduce类相同,但是它的作用域仅限于Map任务的输出。只有当多个Map任务输出具有相同键的数据时,Combiner才会起作用。

## 2.3 Combiner的作用与优势

### 2.3.1 减少数据传输量

在分布式计算环境中,数据传输的成本往往是最大的瓶颈。通过在Map阶段后引入Combiner,可以显著减少数据传输量。Combiner将同一Map任务产生的具有相同键的数据进行合并,减少需要发送到网络的数据量。

例如,如果Map任务处理文本数据,它可能输出很多相同的单词键值对,这些键值对的键是单词,值是出现次数。Combiner可以将相同单词的计数合并,只发送一个(单词,总次数)对到Reduce端,而不是很多个(单词,1)对。

### 2.3.2 提升MapReduce作业性能

Combiner的使用可以提升MapReduce作业的整体性能。原因主要有以下几点:

- 减少了Shuffle阶段的数据量,减轻了网络传输的负担。

- 减少了Reduce端的输入数据量,从而减少了合并和排序所需的时间。

- 由于数据量的减少,对磁盘和内存的需求也相应减少,这意味着在资源受限的环境下,可以执行更多的作业或同时运行更多的任务。

- 最终,缩短了作业的运行时间,提高了计算资源的利用率。

需要注意的是,并不是所有MapReduce作业都适合使用Combiner。只有当作业的逻辑允许在Map端进行局部合并时,Combiner才能发挥作用。例如,求和、计数或者取最大最小值等操作适合使用Combiner,而一些需要保持数据完整性的操作则不适合使用Combiner。

# 3. Combiner的实践应用

## 3.1 Combiner的应用场景分析

在大数据处理中,Combiner是一个能够显著提升作业性能的重要组件。了解其应用场景以及如何选择合适的Combiner函数是有效利用Combiner的关键。

### 3.1.1 典型案例分析

在文本处理中,Combiner可用于统计词频(word count)。Map阶段输出键值对,如<word, 1>,然后Combiner可在Map端对相同键的值进行局部合并,例如将<word, 1>合并为<word, count>。这样,通过减少传送到Reduce阶段的数据量,可以加速整个作业的执行。

在文件去重的场景中,Combiner同样发挥作用。Map阶段生成<file, 1>,在Map端使用Combiner对相同文件名的计数进行合并,最终只有一次写入操作,极大地提升了处理效率。

### 3.1.2 如何选择合适的Combiner函数

选择合适的Combiner函数需要考虑其特性与应用场景。对于可交换性和结合性的函数来说,它们是Combiner的理想选择。例如,求和、求平均、计数等操作都天然适合于Combiner优化。

除此之外,实现时需要确保Combiner逻辑与Map和Reduce逻辑的一致性。例如,在Word Count应用中,如果Map阶段输出的是<word, count>,Reduce阶段进行的是累加操作,那么Combiner也应该实现同样的逻辑。

## 3.2 编写自定义Combiner函数

### 3.2.1 编程语言选择与环境配置

Java是Hadoop默认的编程语言,也是编写MapReduce应用的首选。为了编写自定义Combiner函数,你需要配置Java开发环境,并安装Hadoop库。

通过Maven或Gradle等依赖管理工具,可以方便地将Hadoop库添加到项目中。例如,对于Maven项目,你需要在`pom.xml`文件中添加如下依赖:

```xml

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>YOUR_HADOOP_VERSION</version>

</dependency>

<!-- 其他依赖项 -->

</dependencies>

```

### 3.2.2 实现Combiner逻辑的步骤和要点

自定义Combiner通常继承自`Reducer`类并实现其`reduce`方法。但是,为了使用Combiner,你不需要在代码中明确指定它,只需将自定义的Combiner类作为作业配置的一部分即可。

以下是一个简单的自定义Combiner的示例:

```java

public class CustomCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

}

```

在这段代码中,`reduce`方法将同一键对应的多个值累加,这就是Combiner要实现的逻辑。通过将此类注册到MapReduce作业配置中作为Combiner使用,它可以有效地在Map端减少数据量。

## 3.3 Combiner函数的调试与优化

### 3.3.1 调试技巧和常见问题

调试Combiner时,常见的问题包括逻辑错误、不恰当的Combiner使用等。为了调试,可以在代码中添加日志记录,检查输出文件以及使用Hadoop的调试命令,如`hadoop jar`命令附带调试选项。

一个有效的调试技巧是在MapReduce作业的本地模式下运行你的代码。这可以在不完全设置Hadoop集群的情况下,快速进行调试和测试。

### 3.3.2 性能评估与优化策略

性能评估通常涉及对作业运行时间、内存使用和磁盘I/O的监控。使用Hadoop的`-D`参数来设置相关的性能评估标志,比如:

```sh

hadoop jar yourjob.jar -Dmapreduce.job.user.classpath.first=true -Dmap

```

0

0