KNN算法的并行化实现:提升算法效率与扩展性,应对大规模数据挑战

发布时间: 2024-08-20 05:35:39 阅读量: 92 订阅数: 29

KNN分类算法的MapReduce并行化实现1

# 1. KNN算法基础与并行化概述

### 1.1 KNN算法简介

K近邻(KNN)算法是一种非参数机器学习算法,用于分类和回归任务。其基本思想是,给定一个新数据点,通过计算其与训练集中所有数据点的距离,找到距离最近的K个点(称为近邻),并根据这些近邻的类别或值来预测新数据点的类别或值。

### 1.2 KNN算法并行化

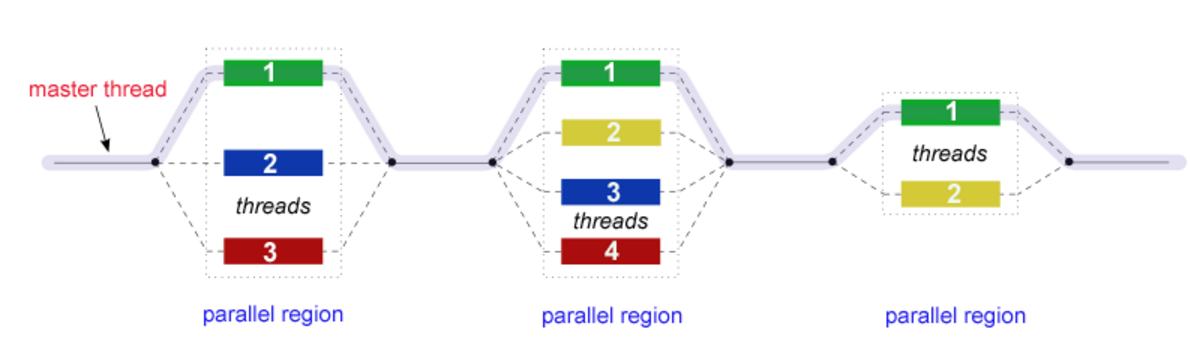

随着数据量的不断增长,KNN算法的计算量也随之增大。为了解决这个问题,可以采用并行化技术来提高KNN算法的效率。KNN算法的并行化主要有两种策略:数据并行化和模型并行化。

* **数据并行化:**将数据分成多个块,并分配给不同的计算节点进行处理。

* **模型并行化:**将KNN模型分成多个子模型,并分配给不同的计算节点进行训练。

# 2. KNN算法并行化策略

### 2.1 数据并行化

数据并行化是一种将数据集划分为多个子集,然后在不同的计算节点上并行处理这些子集的策略。它适用于数据集太大而无法由单个节点处理的情况。

#### 2.1.1 分区并行化

分区并行化将数据集划分为不相交的子集,每个子集由不同的计算节点处理。子集之间的通信开销很低,因为它们不需要交换数据。

```python

# 分区并行化示例

import numpy as np

from mpi4py import MPI

# 初始化MPI环境

comm = MPI.COMM_WORLD

# 获取当前进程的秩

rank = comm.Get_rank()

# 获取进程总数

size = comm.Get_size()

# 创建数据集

data = np.arange(100)

# 将数据集划分为子集

sub_data = np.array_split(data, size)

# 每个进程处理自己的子集

local_result = np.sum(sub_data[rank])

# 汇总所有进程的结果

global_result = comm.allreduce(local_result, op=MPI.SUM)

print("进程{}的局部结果:{}".format(rank, local_result))

print("全局结果:{}".format(global_result))

```

#### 2.1.2 复制并行化

复制并行化将整个数据集复制到每个计算节点。这种方法适用于数据集较小或通信开销较低的情况。

```python

# 复制并行化示例

import numpy as np

from mpi4py import MPI

# 初始化MPI环境

comm = MPI.COMM_WORLD

# 获取当前进程的秩

rank = comm.Get_rank()

# 获取进程总数

size = comm.Get_size()

# 创建数据集

data = np.arange(100)

# 将数据集复制到每个进程

data_copy = data.copy()

# 每个进程处理自己的数据集副本

local_result = np.sum(data_copy)

# 汇总所有进程的结果

global_result = comm.allreduce(local_result, op=MPI.SUM)

print("进程{}的局部结果:{}".format(rank, local_result))

print("全局结果:{}".format(global_result))

```

### 2.2 模型并行化

模型并行化是一种将KNN模型划分为多个子模型,然后在不同的计算节点上并行训练或预测这些子模型的策略。它适用于模型太大而无法由单个节点处理的情况。

#### 2.2.1 水平并行化

水平并行化将模型的层划分为多个子层,每个子层由不同的计算节点处理。子层之间的通信开销较高,因为它们需要交换中间结果。

#### 2.2.2 垂直并行化

垂直并行化将模型的特征划分为多个子特征集,每个子特征集由不同的计算节点处理。子特征集之间的通信开销较低,因为它们不需要交换中间结果。

# 3. KNN算法并行化实践

### 3.1 Hadoop MapReduce实现

#### 3.1.1 MapReduce编程模型

MapReduce是一种分布式计算框架,用于处理大规模数据集。它将计算任务分解为两个阶段:Map和Reduce。

* **Map阶段:**将输入数据集划分为较小的块,并将其分配给不同的计算节点。每个节点上的Map函数对数据块进行处理,并输出键值对。

* **Reduce阶段:**将具有相同键的键值对收集到一起,并应用Reduce函数进行聚合或处理。

#### 3.1.2 KNN算法MapReduce实现

KNN算法的MapReduce实现如下:

* **Map阶段:**

* 输入:训练数据集和查询点

* 输出:键值对,其中键为查询点,值为训练数据点及其距离

* **Reduce阶段:**

* 输入:具有相同键的键值对(查询点)

* 输出:查询点及其最近邻点

**代码块:**

```python

# Map函数

def map_func(key, value):

# key为查询点,value为训练数据点

query_point = key

train_point = value

distance = calculate_distance(query_point, train_point)

return (query_point, (train_point, distance))

# Redu

```

0

0