Java字符串模糊匹配算法:优化策略,提升性能

发布时间: 2024-08-28 05:10:21 阅读量: 48 订阅数: 35

# 1. Java字符串模糊匹配算法概述

在实际应用中,我们经常需要对字符串进行模糊匹配,即在字符串中查找与给定模式相似或包含给定模式的子串。Java中提供了多种字符串模糊匹配算法,每种算法都具有不同的特点和适用场景。

本篇博客将深入探讨Java字符串模糊匹配算法,从基础概念到高级应用,循序渐进地介绍算法原理、优化策略和实践应用,帮助读者全面掌握模糊匹配技术。

# 2. Java字符串模糊匹配算法优化策略

### 2.1 基于编辑距离的优化

编辑距离算法衡量两个字符串之间的相似性,通过计算将一个字符串转换为另一个字符串所需的最小编辑操作数(插入、删除、替换)。

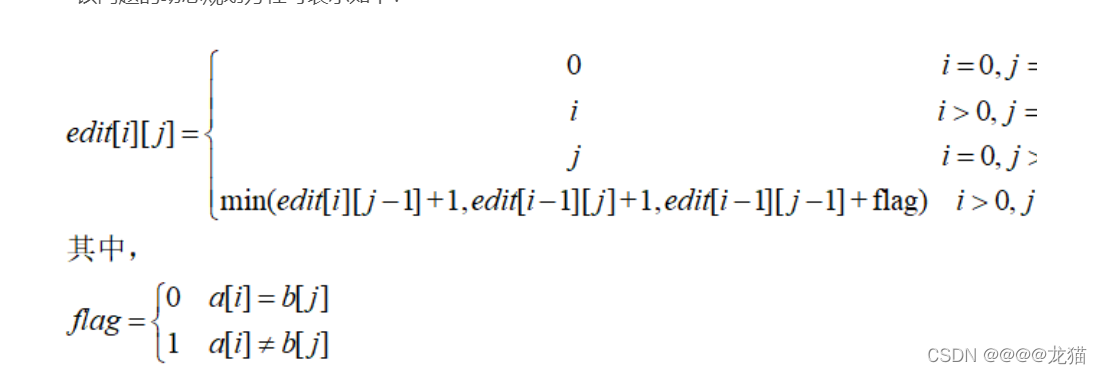

#### 2.1.1 Levenshtein距离算法

**算法原理:**

Levenshtein距离算法使用动态规划方法计算编辑距离。它创建了一个二维表,其中单元格值表示将字符串`s1`的前`i`个字符转换为字符串`s2`的前`j`个字符所需的最小编辑操作数。

**代码块:**

```java

public static int levenshteinDistance(String s1, String s2) {

int m = s1.length();

int n = s2.length();

int[][] dp = new int[m + 1][n + 1];

for (int i = 0; i <= m; i++) {

dp[i][0] = i;

}

for (int j = 0; j <= n; j++) {

dp[0][j] = j;

}

for (int i = 1; i <= m; i++) {

for (int j = 1; j <= n; j++) {

if (s1.charAt(i - 1) == s2.charAt(j - 1)) {

dp[i][j] = dp[i - 1][j - 1];

} else {

dp[i][j] = Math.min(dp[i - 1][j], Math.min(dp[i][j - 1], dp[i - 1][j - 1])) + 1;

}

}

}

return dp[m][n];

}

```

**逻辑分析:**

* 创建二维表`dp`,其中`dp[i][j]`表示将`s1`的前`i`个字符转换为`s2`的前`j`个字符所需的最小编辑操作数。

* 初始化`dp`表的第一行和第一列,分别表示将空字符串转换为`s1`或`s2`所需的编辑操作数。

* 对于`s1`和`s2`的每个字符,计算将该字符插入、删除或替换到`dp`表中其他单元格所需的编辑操作数。

* 选择最小编辑操作数并更新`dp`表。

#### 2.1.2 Damerau-Levenshtein距离算法

Damerau-Levenshtein距离算法是Levenshtein距离算法的扩展,它增加了转置操作(交换相邻字符)。

**算法原理:**

Damerau-Levenshtein距离算法在Levenshtein距离算法的基础上,将转置操作作为一种额外的编辑操作。

**代码块:**

```java

public static int damerauLevenshteinDistance(String s1, String s2) {

int m = s1.length();

int n = s2.length();

int[][] dp = new int[m + 1][n + 1];

for (int i = 0; i <= m; i++) {

dp[i][0] = i;

}

for (int j = 0; j <= n; j++) {

dp[0][j] = j;

}

for (int i = 1; i <= m; i++) {

for (int j = 1; j <= n; j++) {

if (s1.charAt(i - 1) == s2.charAt(j - 1)) {

dp[i][j] = dp[i - 1][j - 1];

} else {

int cost = 1;

if (i > 1 && j > 1 && s1.charAt(i - 1) == s2.charAt(j - 2) && s1.charAt(i - 2) == s2.charAt(j - 1)) {

cost = 0; // 转置操作

}

dp[i][j] = Math.min(dp[i - 1][j], Math.min(dp[i][j - 1], dp[i - 1][j - 1])) + cost;

}

}

}

return dp[m][n];

}

```

**逻辑分析:**

* 与Levenshtein距离算法类似,Damerau-Levenshtein距离算法使用动态规划方法计算编辑距离。

* 在计算编辑操作数时,它考虑了转置操作,并相应地更新`dp`表。

### 2.2 基于哈希表的优化

哈希表优化策略通过将字符串转换为哈希值,从而减少字符串比较的次数。

#### 2.2.1 Rabin-Karp算法

Rabin-Karp算法使用滚动哈希技术计算字符串的哈希值。

**算法原理:**

* 将字符串划分为大小为`m`的子字符串。

* 计算每个子字符串的哈希值。

* 比较哈希值以查找可能的匹配项。

**代码块:**

```java

public static boolean rabinKarp(String s1, String s2) {

int m = s2.length();

int n = s1.length();

long p = 31; // 质数

long s1Hash = 0;

long s2Hash = 0;

long pow = 1;

for (int i = 0; i < m; i++) {

s1Hash = (s1Hash * p + s1.charAt(i)) % (long) Math.pow(2, 32);

s2Hash = (s2Hash * p + s2.charAt(i)) % (long) Math.pow(2, 32);

pow = (pow * p) % (long) Math.pow(2, 32);

}

for (int i = m; i < n; i++) {

s1Hash = (s1Hash * p - s1.charAt(i - m) * pow + s1.charAt(i)) % (long) Math.pow(2, 32);

if (s1Hash == s2Hash) {

if (s1.substring(i - m + 1, i + 1).equals(s2)) {

return true;

}

}

}

return false;

}

```

**逻辑分析:**

* 计算`s1`和`s2`的前`m`个字符的哈希值。

* 对于`s1`的每个后续子字符串,使用滚动哈希技术更新其哈希值。

* 比较`s1`和`s2`的哈希值。如果相等,则进一步比较字符串以确认匹配。

#### 2.2.2 Boyer-Moore算法

Boyer-Moore算法使用模式匹配算法来查找字符串中的模式。

**算法原理:**

* 预处理模式字符串,创建坏字符表和好后缀表。

* 从模式字符串的末尾开始,逐个字符地比较字符串。

* 根据坏字符表和好后缀表,跳过不匹配的字符。

**代码块:**

```java

public static boolean boyerMoore(String s1, String s2) {

int[] badCharTable = buildBadCharTable(s2);

int[] goodSuffixTable = buildGoodSuffixTable(s2);

int m = s2.length();

int n = s1.length();

int i = m - 1;

int j = m - 1;

while (i < n) {

if (s1.charAt(i) == s2.charAt(j)) {

if (j == 0) {

return true;

}

i--;

j--;

} else {

int shift = Math.max(1, j - goodSuffixTable[j]);

if (shift == 1) {

shift = badCharTable[s1.charAt(i)] - j;

}

i += shift;

j = m - 1;

}

}

return false;

}

private static int[] buildBadCharTable(String s) {

int[] table = new int[256];

for (int i = 0; i < 256; i++) {

table[i] = -1;

}

for (int i = 0; i < s.length(); i++) {

table[s.charAt(i)] = i;

}

return table;

}

private static int[] buildGoodSuffixTable(String s) {

int[] table = new int[s.length()];

int i = s.length() - 1;

# 3.1 文本搜索和替换

#### 3.1.1 正则表达式匹配

正则表达式是一种强大的工具,用于在文本中查找和替换模式。它使用一组特殊字符来表示要匹配的模式,并提供灵活的语法来指定匹配条件。

**代码块:**

```java

import java.util.regex.Pattern;

import java.util.regex.Matcher;

public class RegexExample {

public static void main(String[] args) {

String text = "This is a sample text to be searched.";

String pattern = "sample";

// 创建 Pattern 对象

Pattern regexPattern = Pattern.compile(pattern);

// 创建 Matcher 对象

Matcher matcher = regexPattern.matcher(text);

// 查找匹配项

if (matcher.find()) {

// 获取匹配项

String match = matcher.group();

// 替换匹配项

String replacedText = text.replace(match, "replaced");

// 输出替换后的文本

System.out.println(replacedText);

}

}

}

```

**逻辑分析:**

* `Pattern.compile(pattern)` 创建一个 `Pattern` 对象,其中 `pattern` 是要匹配的模式。

* `matcher.find()` 在文本中查找与模式匹配的第一个子字符串,如果找到,则返回 `true`。

* `matcher.group()` 获取匹配的子字符串。

* `text.replace(match, "replaced")` 使用 `replace()` 方法将匹配的子字符串替换为指定的字符串。

#### 3.1.2 模糊匹配算法应用

模糊匹配算法也可以用于文本搜索和替换,特别是在需要处理拼写错误或相似文本时。

**代码块:**

```java

import java.util.List;

import java.util.ArrayList;

public class FuzzyMatchExample {

public static void main(String[] args) {

String text = "This is a sample text to be searched.";

String pattern = "sampe";

// 使用 Levenshtein 距离算法进行模糊匹配

List<String> matches = fuzzyMatch(text, pattern);

// 输出匹配项

for (String match : matches) {

System.out.println(match);

}

}

public static List<String> fuzzyMatch(String text, String pattern) {

int[][] matrix = new int[text.length() + 1][pattern.length() + 1];

// 初始化矩阵

for (int i = 0; i <= text.length(); i++) {

matrix[i][0] = i;

}

for (int j = 0; j <= pattern.length(); j++) {

matrix[0][j] = j;

}

// 计算 Levenshtein 距离矩阵

for (int i = 1; i <= text.length(); i++) {

for (int j = 1; j <= pattern.length(); j++) {

if (text.charAt(i - 1) == pattern.charAt(j - 1)) {

matrix[i][j] = matrix[i - 1][j - 1];

} else {

matrix[i][j] = Math.min(matrix[i - 1][j], Math.min(matrix[i][j - 1], matrix[i - 1][j - 1])) + 1;

}

}

}

// 回溯获取匹配项

List<String> matches = new ArrayList<>();

int i = text.length();

int j = pattern.length();

while (i > 0 && j > 0) {

if (text.charAt(i - 1) == pattern.charAt(j - 1)) {

matches.add(0, text.substring(i - pattern.length(), i));

i--;

j--;

} else {

if (matrix[i - 1][j] < matrix[i][j - 1] && matrix[i - 1][j] < matrix[i - 1][j - 1]) {

i--;

} else if (matrix[i][j - 1] < matrix[i - 1][j] && matrix[i][j - 1] < matrix[i - 1][j - 1]) {

j--;

} else {

i--;

j--;

}

}

}

return matches;

}

}

```

**逻辑分析:**

* `fuzzyMatch(text, pattern)` 方法使用 Levenshtein 距离算法计算文本和模式之间的模糊匹配程度。

* `matrix` 数组存储 Levenshtein 距离矩阵,其中 `matrix[i][j]` 表示文本的前 `i` 个字符和模式的前 `j` 个字符之间的编辑距离。

* 回溯算法从矩阵的右下角开始,根据最小编辑距离回溯获取匹配项。

# 4. Java字符串模糊匹配算法性能提升

### 4.1 算法选择与性能分析

#### 4.1.1 不同算法的优缺点

不同的字符串模糊匹配算法具有不同的优缺点,具体如下表所示:

| 算法 | 优点 | 缺点 |

|---|---|---|

| Levenshtein距离 | 精度高 | 计算复杂度高 |

| Damerau-Levenshtein距离 | 考虑了字符交换,精度更高 | 计算复杂度更高 |

| Rabin-Karp算法 | 适用于大文本搜索,时间复杂度低 | 精度较低,容易产生误匹配 |

| Boyer-Moore算法 | 适用于模式串较短的情况,时间复杂度低 | 精度较低,容易产生误匹配 |

| Aho-Corasick算法 | 适用于模式串较多且较长的情况,时间复杂度低 | 空间复杂度高 |

| Knuth-Morris-Pratt算法 | 适用于模式串较短且重复较多的情况,时间复杂度低 | 空间复杂度高 |

### 4.1.2 性能评估和选择

在选择模糊匹配算法时,需要综合考虑以下因素:

* **文本长度:**文本长度越大,算法的计算复杂度越高。

* **模式串长度:**模式串长度越长,算法的计算复杂度越高。

* **模糊程度:**模糊程度越高,算法的计算复杂度越高。

* **精度要求:**精度要求越高,算法的计算复杂度越高。

根据这些因素,可以对不同算法进行性能评估,选择最合适的算法。

### 4.2 并行化和分布式优化

#### 4.2.1 并行处理技术

并行处理技术可以将模糊匹配任务分解成多个子任务,并行执行,从而提高性能。

```java

// 使用 Fork/Join 框架进行并行处理

ForkJoinPool pool = new ForkJoinPool();

ForkJoinTask<Integer> task = pool.submit(new FuzzyMatchTask(text, pattern));

Integer result = task.get();

```

#### 4.2.2 分布式处理架构

分布式处理架构可以将模糊匹配任务分布到多个节点上执行,从而提高处理能力。

```java

// 使用 Hadoop MapReduce 进行分布式处理

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "Fuzzy Match");

job.setMapperClass(FuzzyMatchMapper.class);

job.setReducerClass(FuzzyMatchReducer.class);

job.waitForCompletion(true);

```

### 4.3 缓存和索引优化

#### 4.3.1 缓存机制的应用

缓存机制可以将频繁访问的数据存储在内存中,从而减少对磁盘或数据库的访问,提高性能。

```java

// 使用 Guava 缓存框架

Cache<String, Integer> cache = CacheBuilder.newBuilder()

.maximumSize(1000)

.expireAfterWrite(10, TimeUnit.MINUTES)

.build();

```

#### 4.3.2 索引技术的利用

索引技术可以对数据进行预处理,从而提高查询效率。

```java

// 使用 Lucene 索引框架

Directory directory = FSDirectory.open(new File("index"));

IndexWriterConfig config = new IndexWriterConfig(new StandardAnalyzer());

IndexWriter writer = new IndexWriter(directory, config);

```

# 5.1 自然语言处理中的应用

### 5.1.1 文本分类和聚类

模糊匹配算法在文本分类和聚类中扮演着至关重要的角色。它可以帮助识别文本之间的相似性,并将其归类到不同的类别或组中。

**文本分类**

文本分类是指将文本文档分配到预定义类别的过程。模糊匹配算法可以用于比较文档内容,并根据其相似性将其分配到适当的类别中。例如,在新闻分类中,模糊匹配算法可以将新闻文章归类为政治、体育、娱乐等类别。

**文本聚类**

文本聚类是指将文本文档分组到具有相似特征的组中的过程。模糊匹配算法可以用于计算文档之间的相似性,并将其聚类到不同的组中。例如,在客户反馈分析中,模糊匹配算法可以将客户反馈聚类到不同的主题组中,以便于分析和处理。

### 5.1.2 机器翻译和信息抽取

模糊匹配算法在机器翻译和信息抽取中也得到了广泛的应用。

**机器翻译**

机器翻译是指将一种语言的文本翻译成另一种语言的过程。模糊匹配算法可以用于识别源语言和目标语言中的相似单词和短语,从而提高翻译的准确性和流畅性。

**信息抽取**

信息抽取是指从文本中提取特定信息的过程。模糊匹配算法可以用于识别文本中与特定实体或事件相关的单词和短语,从而提高信息抽取的效率和准确性。例如,在医学信息抽取中,模糊匹配算法可以用于识别文本中与疾病、症状和治疗相关的单词和短语。

# 6. Java字符串模糊匹配算法发展趋势

随着技术的发展,Java字符串模糊匹配算法也在不断地演进,以下是一些值得关注的发展趋势:

### 6.1 深度学习和人工智能

深度学习和人工智能技术在自然语言处理和计算机视觉等领域取得了显著的进展。这些技术也被应用于字符串模糊匹配算法中,以提高匹配精度和效率。

**神经网络在模糊匹配中的应用**

神经网络是一种深度学习模型,可以学习数据中的复杂模式。在模糊匹配中,神经网络可以用来学习字符串之间的相似性度量,从而提高匹配精度。

**机器学习算法的探索**

机器学习算法,如支持向量机和决策树,也被用于字符串模糊匹配。这些算法可以根据训练数据自动学习匹配规则,从而提高匹配效率和泛化能力。

### 6.2 云计算和边缘计算

云计算和边缘计算技术为字符串模糊匹配算法提供了新的发展机遇。

**云平台上的模糊匹配服务**

云平台提供了强大的计算资源和存储空间,可以用来部署和运行大规模的模糊匹配服务。这些服务可以为各种应用提供按需的模糊匹配功能。

**边缘计算设备上的模糊匹配优化**

边缘计算设备,如智能手机和物联网设备,可以将模糊匹配算法部署到靠近数据源的位置。这可以减少延迟,提高匹配效率,并降低对云平台的依赖性。

随着这些发展趋势的不断深入,Java字符串模糊匹配算法将变得更加强大、高效和智能,为各种应用提供更广泛的可能性。

0

0