MATLAB聚类算法在社交媒体分析中的【先进策略】

发布时间: 2024-08-30 18:42:25 阅读量: 25 订阅数: 24

# 1. MATLAB聚类算法概述

在数据分析和机器学习的领域,聚类算法作为无监督学习的重要分支,扮演着至关重要的角色。聚类的目的是将数据集中相似的数据点组合在一起,从而揭示数据内在的结构和模式。MATLAB作为一种功能强大的数学计算和可视化软件,为聚类算法的研究和实践提供了便利。本章将简要介绍MATLAB聚类算法的基本概念、主要功能及应用场景,为后续章节深入探讨不同类型的聚类算法及其在社交媒体数据分析中的应用打下基础。

# 2. 聚类算法理论基础

在第二章中,我们将深入探讨聚类算法的理论基础,涵盖数学原理、评价指标以及如何在实际中选择和优化聚类算法。为了便于理解,我们将依次讨论聚类算法的数学原理、评价指标和选择优化策略,确保每个主题都得到充分的解释和应用。

## 2.1 聚类算法的数学原理

### 2.1.1 距离度量的定义与重要性

距离度量在聚类算法中扮演着核心角色,它决定了数据点之间的相似性。一个通用的距离度量是欧几里得距离,它度量了数据点在多维空间中的直线距离。除此之外,曼哈顿距离、切比雪夫距离和余弦相似度等都是常见的度量方式,每种都有其适用的场景和优缺点。

例如,曼哈顿距离考虑了数据点在所有维度上的绝对差异之和,适用于网格状的数据布局,而余弦相似度更多用于测量两个非零向量的方向差异,它在文档相似性分析中十分流行。

```mathematica

(*欧几里得距离计算示例*)

euclideanDistance[a_List, b_List] := Norm[a - b]

```

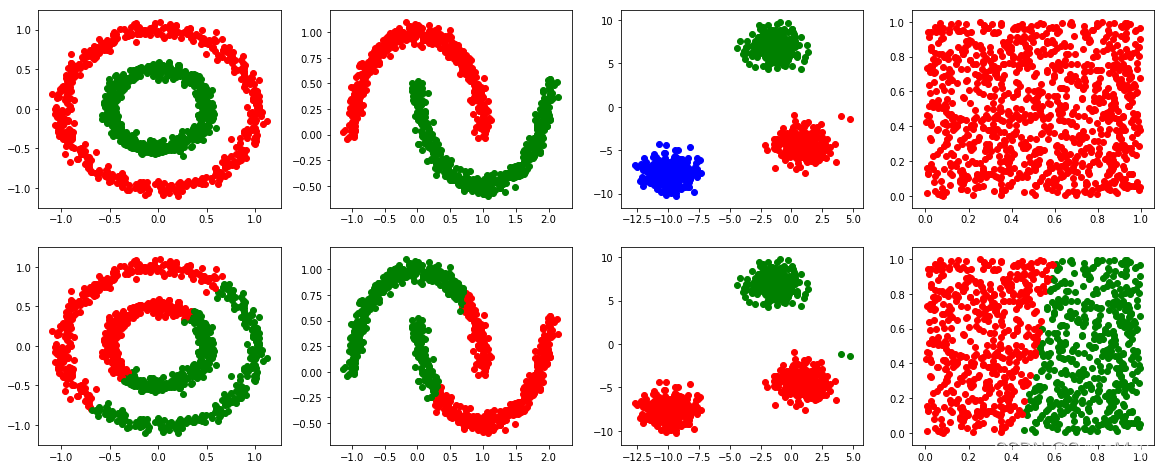

### 2.1.2 聚类算法的分类

聚类算法可大致分为以下几类:

- 划分方法:如K均值算法,它将数据集划分为预定数量的聚类。

- 层次方法:如凝聚层次聚类,通过合并相似的数据点或聚类形成树状的聚类层次。

- 密度方法:如DBSCAN,通过数据点的密度分布来识别聚类。

每种聚类算法都有其特定的假设和应用场景,了解其背后的工作原理对于正确选择和应用聚类算法至关重要。

## 2.2 聚类算法的评价指标

### 2.2.1 外部评价指标

外部评价指标依赖于已知的类别信息,通常用于评估聚类结果与真实标签的一致性。常用的外部评价指标包括兰德指数、Jaccard系数、Fowlkes-Mallows指数等。这些指标衡量了聚类结果与真实分类之间的相似程度,它们的取值范围通常在0和1之间,值越高表示聚类结果越接近真实的分类。

```mermaid

flowchart LR

A[原始分类] -->|比较| B[聚类结果]

B --> C[计算外部评价指标]

C --> D[兰德指数]

C --> E[Jaccard系数]

C --> F[Fowlkes-Mallows指数]

```

### 2.2.2 内部评价指标

内部评价指标不需要外部的类标签,它们通过聚类内部的特性来评估聚类质量。典型的内部评价指标包括轮廓系数、Davies-Bouldin指数和Calinski-Harabasz指数。轮廓系数特别地考虑了聚类的凝聚度和分离度,是衡量单个数据点聚类质量的常用方法。

```mathematica

(*轮廓系数计算示例*)

silhouetteCoefficient[clusters_List, data_List] := Module[{a, b, s},

a = Mean[EuclideanDistance[#, ClusterCenters[clusters, data], data] & /@ data];

b = Min[Mean[EuclideanDistance[#, Select[data, MemberQ[clusters[[j]], #] &]]] & /@ data];

s = (b - a) / Max[a, b];

Mean[s]

]

```

## 2.3 聚类算法的选择与优化

### 2.3.1 算法选择的考量因素

选择合适的聚类算法是至关重要的一步。考量因素包括数据的维度、聚类的数量、形状以及聚类的大小。不同的算法有不同的假设和限制,例如K均值算法假设聚类是凸形和等方的,而DBSCAN则对噪声有很好的鲁棒性。理解数据集的特征和需求,才能选择最合适的聚类算法。

### 2.3.2 算法优化的策略和方法

优化聚类算法通常涉及调整参数以达到最佳聚类效果。例如,在K均值聚类中,初始质心的选择对最终结果有很大影响,可以采用K均值++方法来改善初始质心的选择。参数调整应基于外部或内部评价指标,以指导算法向更优解靠近。

```mathematica

(*K均值++初始质心选择示例*)

kMeansPlusPlus[data_List, k_Integer?Positive] := Module[{centroids, distances, probabilities},

(*随机选择第一个质心*)

centroids = {data[[RandomInteger[{1, Length[data]}]]]};

distances = Table[Norm[data[[i]] - centroids[[1]]]^2, {i, Length[data]}];

probabilities = distances / Total[distances];

(*迭代选择后续质心*)

While[Length[centroids] < k,

AppendTo[centroids, data[[WeightedRandomChoice[probabilities]]]];

distances = Min[distances, Outer[Norm[#1 - #2]^2 &, data, centroids, 1], 2];

probabilities = distances / Total[distances];

];

centroids

]

```

在本章节中,我们深入了解了聚类算法的数学原理、评价指标,以及如何在实际应用中选择和优化聚类算法。这些内容为我们后续章节中用MATLAB实现聚类算法打下了坚实的理论基础,并为后续章节中分析聚类算法在社交媒体数据分析中的应用提供了必要的背景知识。在接下来的章节中,我们将通过具体的MATLAB代码示例,展示如何在实际中应用这些理论知识。

# 3. ```

# 第三章:MATLAB中的聚类算法实践

## 3.1 K均值聚类算法应用

### 3.1.1 K均值算法的MATLAB实现

K均值聚类是机器学习中应用广泛的聚类算法之一。其主要思想是:将n个数据点划分为k个聚类,使得每个点属于离它最近的均值(即簇中心)对应的簇,以使得聚类内部的相似度最大,而聚类间的相似度最小。

在MATLAB中,我们使用`kmeans`函数来实现K均值聚类。下面是一个简单的示例代码:

```matlab

% 生成一些随机数据作为示例

data = [randn(100,2)*0.75+ones(100,2);

randn(100,2)*0.5-ones(100,2)];

% 指定聚类数目

k = 2;

% 调用kmeans函数进行聚类

[idx, C] = kmeans(data, k);

% idx返回每个数据点的聚类索引

% C返回每个聚类的中心点坐标

```

### 3.1.2 参数选择与结果分析

K均值聚类算法的结果受初始中心点的选择影响较大,因此MATLAB提供了多种参数来优化这个过程:

- `Start`: 初始聚类中心的选择策略,比如'cluster', 'sample'或者一个自定义的初始中心矩阵。

- `Replicates`: 设置运行算法的次数,以防止局部最小值。

- `Options`: 设置算法的详细选项,例如最大迭代次数和收敛阈值。

对聚类结果的评估可以使用轮廓系数(Silhouette Coefficient)和平方误差和(Sum of Squared Errors, SSE

```

0

0